Fotolia

Principales tendencias en big data para 2024 y en adelante

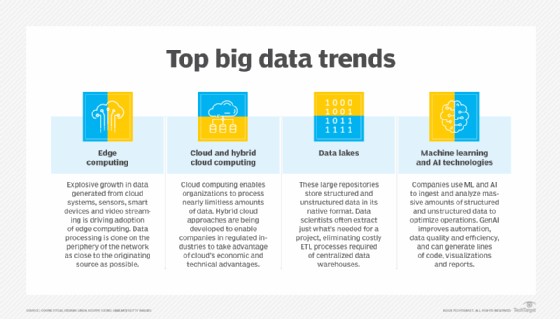

Big data está impulsando cambios en la forma en que las organizaciones procesan, almacenan y analizan datos. Los beneficios están estimulando aún más la innovación. Aquí hay cuatro grandes tendencias.

Big data está demostrando su valor para organizaciones de todos los tipos y tamaños en una amplia gama de industrias. Las empresas que hacen un uso avanzado de esa tecnología obtienen beneficios comerciales tangibles, desde una mayor eficiencia en las operaciones y una mayor visibilidad de los entornos comerciales que cambian rápidamente, hasta la optimización de productos y servicios para los clientes.

El resultado es que, a medida que las organizaciones encuentran usos para estos grandes almacenes de datos, las tecnologías, prácticas y enfoques de big data están evolucionando. Continúan surgiendo nuevos tipos de arquitecturas y técnicas de big data para recopilar, procesar, administrar y analizar la gama de datos en una organización.

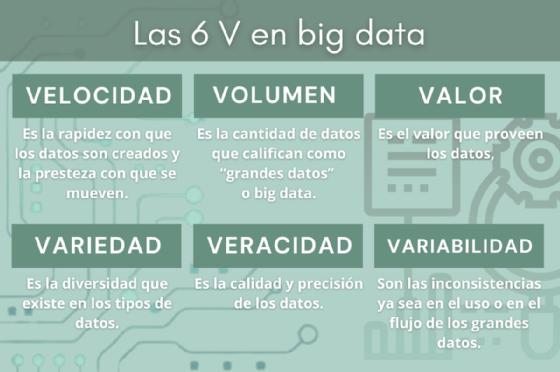

Tratar con big data es algo más que tratar con grandes volúmenes de información almacenada. El volumen es solo una de las muchas V de big data que las organizaciones deben abordar. Por lo general, también hay una variedad significativa de datos, desde información estructurada que se encuentra en bases de datos distribuidas por toda la organización, hasta grandes cantidades de datos no estructurados y semiestructurados que residen en archivos, imágenes, videos, sensores, registros del sistema, texto y documentos, incluidos los de papel en espera de ser digitalizados. Además, esta información a menudo se crea y cambia a gran velocidad (velocidad) y tiene diferentes niveles de calidad de datos (veracidad), lo que genera más desafíos en la gestión, el procesamiento y el análisis de datos.

Cuatro grandes tendencias en big data están ayudando a las organizaciones a enfrentar esos desafíos y obtener los beneficios que buscan. Aquí hay un vistazo a las tendencias y lo que significan para las organizaciones que están invirtiendo en implementaciones de big data.

1. La IA generativa, el análisis avanzado y el aprendizaje automático siguen evolucionando

Con la gran cantidad de datos que se generan, los enfoques analíticos tradicionales se ven desafiados porque no son fáciles de automatizar para el análisis de datos a escala. Las tecnologías de procesamiento distribuido, especialmente aquellas promovidas por plataformas de código abierto como Hadoop y Spark, permiten a las organizaciones procesar petabytes de información a gran velocidad. Luego, las empresas están utilizando tecnologías de análisis de big data para optimizar sus iniciativas de análisis e inteligencia empresarial, pasando de herramientas de generación de informes lentas, que dependen de la tecnología de almacenamiento de datos, a aplicaciones más inteligentes y responsivas que permiten una mayor visibilidad del comportamiento del cliente, los procesos de negocio y las operaciones generales.

Las evoluciones del análisis de big data continúan centrándose en el aprendizaje automático y los sistemas de inteligencia artificial. Organizaciones de todos los tamaños utilizan cada vez más la IA para optimizar y mejorar sus procesos comerciales. En la encuesta de intenciones de gasto de Enterprise Strategy Group, el 63 % de los 193 encuestados familiarizados con las iniciativas de inteligencia artificial y aprendizaje automático en su organización dijeron que esperaban que se gastara más en esas herramientas en 2023.

El aprendizaje automático permite a las organizaciones identificar patrones de datos más fácilmente, detectar anomalías en grandes conjuntos de datos y admitir análisis predictivos y otras capacidades avanzadas de análisis de datos. Algunos ejemplos de eso incluyen los siguientes:

- Sistemas de reconocimiento de datos de imagen, video y texto.

- Clasificación automatizada de datos.

- Capacidades de procesamiento del lenguaje natural (PLN) para chatbots y análisis de voz y texto.

- Automatización autónoma de procesos de negocio.

- Funciones de personalización y recomendación en sitios web y servicios.

- Sistemas de análisis que pueden encontrar soluciones óptimas a problemas empresariales entre un mar de datos.

De hecho, con la ayuda de la inteligencia artificial y el aprendizaje automático, las empresas están utilizando sus entornos de big data para brindar una atención al cliente más profunda a través de chatbots inteligentes e interacciones más personalizadas sin requerir aumentos significativos en el personal de atención al cliente. Estos sistemas habilitados para IA pueden recopilar y analizar grandes cantidades de información sobre clientes y usuarios, especialmente cuando se combinan con una estrategia de lago de datos que puede agregar una amplia gama de información de muchas fuentes.

Las empresas también están viendo innovaciones en el área de la visualización de datos. Las personas comprenden mejor el significado de los datos cuando se representan en una forma visualizada , como cuadros, gráficos y diagramas. Las formas emergentes de visualización de datos están poniendo el poder de los análisis basados en IA en manos incluso de usuarios empresariales ocasionales. Esto ayuda a las organizaciones a detectar conocimientos clave que pueden mejorar la toma de decisiones. Las formas avanzadas de herramientas de visualización y análisis incluso permiten a los usuarios hacer preguntas en lenguaje natural, y el sistema determina automáticamente la consulta correcta y muestra los resultados de manera relevante para el contexto.

La IA generativa y los modelos grandes de lenguaje (LLM) mejoran aún más las operaciones de datos de una organización con beneficios en todo el proceso de datos. La IA generativa puede ayudar a automatizar las funciones de monitoreo de la observabilidad de los datos, mejorar la calidad y la eficiencia con alertas proactivas y correcciones para problemas identificados e incluso escribir líneas de código. Puede escanear grandes conjuntos de datos en busca de errores o inconsistencias o identificar patrones y generar informes o visualizaciones de los detalles más importantes para los equipos de datos. Los LLM brindan nuevas capacidades de democratización de datos a las organizaciones. La catalogación de datos, la integración, la privacidad, la gobernanza y el intercambio están aumentando a medida que la IA generativa se entrelaza con los procesos de gestión de datos.

El poder de la IA generativa y los LLM depende de la calidad de los datos utilizados para entrenar el modelo. La calidad de los datos es más importante que nunca a medida que el interés y el uso de la IA generativa siguen aumentando en todas las industrias. Los equipos de datos deben monitorear cuidadosamente los resultados de todas las operaciones de datos generadas por IA. Los datos incorrectos o equivocados pueden conducir a decisiones equivocadas y resultados costosos.

2. Más datos y una mayor diversidad de datos impulsan los avances en el procesamiento y el auge de la informática de punta

El ritmo de generación de datos continúa acelerándose. Gran parte de estos datos no se generan a partir de las transacciones comerciales que ocurren en las bases de datos; en cambio, provienen de otras fuentes, incluidos sistemas en la nube, aplicaciones web, transmisión de video y dispositivos inteligentes como teléfonos inteligentes y asistentes de voz. Estos datos están en gran medida desestructurados y, en el pasado, las organizaciones los dejaban en su mayoría sin procesar ni utilizar, convirtiéndolos en los llamados datos oscuros.

Esto nos lleva a la mayor tendencia en big data: las fuentes no basadas en bases de datos seguirán siendo los generadores dominantes de datos, lo que a su vez obligará a las organizaciones a reexaminar sus necesidades de procesamiento de datos. Los asistentes de voz y los dispositivos IoT, en particular, están impulsando un rápido aumento de las necesidades de gestión de big data en industrias tan diversas como el comercio minorista, la atención médica, las finanzas, los seguros, la manufactura y la energía, y en una amplia gama de mercados del sector público. Esta explosión en la diversidad de datos está obligando a las organizaciones a pensar más allá del almacén de datos tradicional como medio para procesar toda esta información.

Además, la necesidad de manejar los datos que se generan se está trasladando a los propios dispositivos, ya que los avances de la industria en la potencia de procesamiento han llevado al desarrollo de dispositivos cada vez más avanzados capaces de recopilar y almacenar datos por sí solos sin sobrecargar la red, el almacenamiento y la infraestructura informática. Por ejemplo, las aplicaciones de banca móvil pueden manejar muchas tareas de depósito y procesamiento remoto de cheques sin tener que enviar imágenes de un lado a otro a los sistemas bancarios centrales para su procesamiento.

El uso de dispositivos para el procesamiento distribuido se materializa en el concepto de informática de borde, que traslada la carga de procesamiento a los propios dispositivos antes de que los datos se envíen a los servidores. La computación perimetral optimiza el rendimiento y el almacenamiento al reducir la necesidad de que los datos fluyan a través de las redes. Eso reduce los costos de computación y procesamiento, especialmente el almacenamiento en la nube, el ancho de banda y los gastos de procesamiento. La computación perimetral también ayuda a acelerar el análisis de datos y proporciona respuestas más rápidas al usuario.

3. Las necesidades de almacenamiento de big data estimulan las innovaciones en la nube y las plataformas de nube híbrida, y el crecimiento de los lagos de datos

Para hacer frente al inexorable aumento en la generación de datos, las organizaciones están gastando más recursos almacenando estos datos en una variedad de sistemas de nube híbrida y basados en la nube optimizados para todas las V de big data. En décadas anteriores, las organizaciones manejaban su propia infraestructura de almacenamiento, lo que dio como resultado centros de datos masivos que las empresas tenían que administrar, proteger y operar. El paso a la computación en la nube cambió esa dinámica. Al trasladar la responsabilidad a los proveedores de infraestructura en la nube –como AWS, Google, Microsoft, Oracle e IBM– las organizaciones pueden manejar cantidades casi ilimitadas de nuevos datos, y pagar por el almacenamiento y la capacidad de computación bajo demanda, sin tener que mantener sus propios grandes y centros de datos complejos.

Algunas industrias enfrentan desafíos en el uso de la infraestructura de la nube debido a limitaciones regulatorias o técnicas. Por ejemplo, las industrias fuertemente reguladas –como la atención médica, los servicios financieros y el gobierno– tienen restricciones que impiden el uso de la infraestructura de la nube pública. Como resultado, durante la última década, los proveedores de nube han desarrollado formas de proporcionar una infraestructura más respetuosa con las regulaciones, así como enfoques híbridos que combinan aspectos de sistemas de nube de terceros con computación y almacenamiento locales para satisfacer necesidades críticas de infraestructura. Sin duda, la evolución de las infraestructuras de la nube pública y de la nube híbrida progresará a medida que las organizaciones busquen las ventajas económicas y técnicas de la computación en la nube.

Además de las innovaciones en almacenamiento y procesamiento en la nube, las empresas están adoptando nuevos enfoques de arquitectura de datos que les permitan manejar los desafíos de variedad, veracidad y volumen de big data. En lugar de intentar centralizar el almacenamiento de datos en un almacén de datos que requiere procesos de extracción, transformación y carga complejos y que requieren mucho tiempo, las empresas están evolucionando el concepto de lago de datos. Los lagos de datos almacenan conjuntos de datos estructurados, semiestructurados y no estructurados en su formato nativo. Este enfoque transfiere la responsabilidad de la transformación y preparación de datos a los usuarios finales que tienen diferentes necesidades de datos. El lago de datos también puede proporcionar servicios compartidos para el análisis y procesamiento de datos.

4. DataOps y la administración de datos pasan a primer plano

Muchos aspectos del procesamiento, almacenamiento y gestión de big data experimentarán una evolución continua en los próximos años. Gran parte de esta innovación está impulsada por necesidades tecnológicas, pero también en parte por cambios en la forma en que pensamos y nos relacionamos con los datos.

Un área de innovación es el surgimiento de DataOps, una metodología y práctica que se centra en enfoques ágiles e iterativos para abordar el ciclo de vida completo de los datos a medida que fluyen a través de la organización. En lugar de pensar en los datos de forma fragmentada, con personas separadas que se ocupan de la generación, el almacenamiento, el transporte, el procesamiento y la gestión de los datos, los procesos y marcos de DataOps abordan las necesidades organizacionales a lo largo del ciclo de vida de los datos, desde la generación hasta el archivo.

Del mismo modo, las organizaciones se enfrentan cada vez más a cuestiones de gobernanza de datos, privacidad y seguridad, situación que se ve exacerbada por los entornos de big data. En el pasado, las empresas a menudo eran algo laxas respecto de las preocupaciones sobre la privacidad y la gobernanza de los datos, pero las nuevas regulaciones las hacen mucho más responsables de lo que sucede con la información personal en sus sistemas. La IA generativa añade otra capa de preocupaciones sobre privacidad y ética que las organizaciones deben considerar.

Debido a las violaciones de seguridad generalizadas, la erosión de la confianza de los clientes en las prácticas de intercambio de datos empresariales y los desafíos en la gestión de datos a lo largo de su ciclo de vida, las organizaciones se están centrando cada vez más en la administración de datos y están trabajando más duro para proteger y gestionar adecuadamente los datos, especialmente cuando cruzan fronteras internacionales. Están surgiendo nuevas herramientas para garantizar que los datos permanezcan donde deben permanecer, estén protegidos en reposo y en movimiento, y se realice un seguimiento adecuado a lo largo de su ciclo de vida.

En conjunto, estas tendencias seguirán dando forma al big data en 2024.

Nota del editor: Las tendencias fueron identificadas por expertos e investigaciones de la industria.