Sergey Nivens - Fotolia

Calidad de datos para big data: Por qué es necesaria y cómo mejorarla

A medida que los volúmenes de datos recopilados aumentan exponencialmente, los métodos para mejorar y garantizar la calidad de los grandes datos son fundamentales para tomar decisiones empresariales precisas, eficaces y fiables.

La calidad de los datos puede ser un reto importante en cualquier proyecto de modelado de datos. Los problemas pueden provenir de fuentes como errores tipográficos, diferentes convenciones de nomenclatura y problemas de integración. Pero la calidad de los datos en los proyectos de big data, que implican un volumen, una variedad y una velocidad de datos mucho mayores, adquiere una importancia aún mayor.

Y dado que los problemas de calidad de los grandes datos pueden crear varias preocupaciones contextuales relacionadas con diferentes aplicaciones, tipos de datos, plataformas y casos de uso, Faisal Alam, jefe de tecnologías emergentes de la consultora EY Americas, sugirió añadir una cuarta V de veracidad en los proyectos de gestión de big data.

Por qué es importante la calidad de los datos para el big data

Los problemas de calidad de los grandes datos pueden dar lugar no solo a algoritmos inexactos, sino también a graves accidentes y lesiones como consecuencia de los resultados del sistema en el mundo real. Como mínimo, los usuarios de las empresas estarán menos inclinados a confiar en los datos y en las aplicaciones construidas sobre ellos. Además, las empresas pueden verse sometidas al escrutinio de la normativa gubernamental si la calidad y la exactitud de los datos desempeñan un papel en las decisiones empresariales de primera línea.

Los datos pueden ser un activo estratégico solo si hay suficientes procesos y mecanismos de apoyo para gobernar y gestionar la calidad de los datos, dijo V. «Bala» Balasubramanian, vicepresidente senior de ciencias de la vida en el proveedor de servicios de transformación digital Orion Innovation.

Los datos de mala calidad pueden aumentar los costos como resultado de las frecuentes correcciones, las necesidades de recursos adicionales y los problemas de cumplimiento. También puede conducir a la toma de decisiones y a la previsión de resultados.

En qué se diferencia la calidad de los datos del big data

La calidad de los datos ha sido un problema desde que se recopilan datos. «Pero big data lo cambia todo», afirma Manu Bansal, cofundador y director general del fabricante de plataformas de estabilidad de datos Lightup Data.

Bansal trabaja con equipos de 100 personas que generan y procesan unos cuantos terabytes de datos de clientes cada día. La gestión de esta cantidad de información cambia totalmente el enfoque para garantizar la calidad de los datos para el big data y debe tener en cuenta estos factores clave:

- Problemas de escalado. Ya no es práctico utilizar un diseño de importación e inspección que funcionaba para archivos de datos u hojas de cálculo. Los equipos de gestión de datos deben desarrollar prácticas de calidad de big data que abarquen almacenes, lagos y flujos de datos.

- Formas complejas y dinámicas de los datos. Big data puede constar de múltiples dimensiones entre tipos de eventos, segmentos de usuarios, versiones de aplicaciones y tipos de dispositivos. «Para determinar el problema de la calidad de los datos de forma significativa, es necesario realizar comprobaciones en cada uno de los segmentos de datos, que pueden ser fácilmente cientos o miles», afirma Bansal. La forma de los datos también puede cambiar cuando se añaden nuevos eventos y atributos y se eliminan los antiguos.

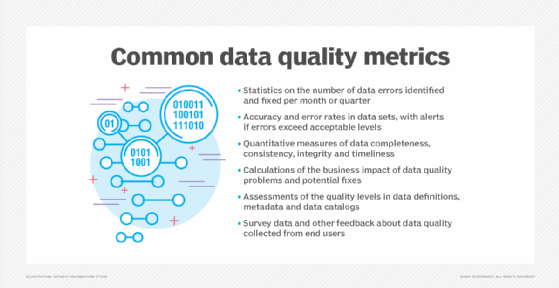

- Gran volumen de datos. Es imposible inspeccionar manualmente los nuevos datos. Garantizar la calidad de los datos para big data requiere desarrollar métricas de calidad que puedan seguirse automáticamente en función de los cambios en las aplicaciones de big data, la infraestructura y los casos de uso.

Retos y problemas de calidad de big data

Fusión de taxonomías de datos dispares. Las empresas fusionadas o las unidades de negocio individuales dentro de una empresa pueden haber creado y perfeccionado sus propias taxonomías de datos y ontologías que reflejan la forma de trabajar de cada una. Las inversiones de capital privado, por ejemplo, pueden acelerar el ritmo de las fusiones y adquisiciones, a menudo combinando varias empresas en una gran organización, señaló Chris Comstock, director de producto del proveedor de plataformas de gobierno de datos Claravine. Cada una de las empresas adquiridas suele tener su propio CRM, automatización de marketing, gestión de contenidos de marketing, base de datos de clientes y datos de metodología de calificación de clientes potenciales. Combinar estos sistemas en una única estructura de datos para orquestar campañas unificadas puede crear un inmenso desafío de calidad de big data.

Mantener la coherencia. La limpieza, la validación y la normalización de los datos también pueden suponer un reto para la calidad de big data. Una compañía telefónica, por ejemplo, construyó modelos que se correlacionaban con los datos de averías de la red, los informes de cortes y las quejas de los clientes para determinar si los problemas podían vincularse a una ubicación geográfica. Pero había una falta de coherencia entre algunas de las direcciones que aparecían como «123 First Street» en un sistema y «123 1ST STREET WEST» en otro sistema.

Encontrar variaciones en la preparación de los datos. A menudo se requiere una variedad de técnicas de preparación de datos para normalizar y limpiar los datos para nuevos casos de uso. Este trabajo de preparación es manual, monótono y tedioso. Los problemas de calidad de los datos pueden surgir cuando los equipos de preparación que trabajan con datos en diferentes silos calculan características de datos que suenan similares de diferentes maneras, dijo Monte Zweben, cofundador y CEO del proveedor de IA y plataforma de datos Splice Machine. Un equipo, por ejemplo, puede calcular los ingresos totales de los clientes restando las devoluciones de las ventas, mientras que otro equipo los calcula según las ventas únicamente. Los resultados son métricas calculadas de forma incoherente en diferentes secuencias de datos.

Recoger demasiados datos. Los equipos de gestión de datos a veces se obsesionan con recopilar más y más datos. «Pero más no es siempre el enfoque correcto», dijo Wilson Pang, CTO en el servicio de datos de entrenamiento de IA Appen. Cuantos más datos se recojan, mayor será el riesgo de que se produzcan errores en ellos. Los datos irrelevantes o defectuosos deben limpiarse antes de entrenar el modelo de datos, pero incluso los métodos de limpieza pueden afectar negativamente a los resultados.

Falta de una estrategia de gobernanza de datos. Un mal gobierno de los datos y las prácticas de comunicación pueden dar lugar a todo tipo de problemas de calidad. Una estrategia de calidad de big data debe estar respaldada por un sólido programa de gobernanza de datos que establezca, gestione y comunique las políticas, definiciones y normas de datos para un uso eficaz de los mismos y fomente la alfabetización de los datos. Una vez que los datos se desvinculan de sus entornos de origen, las normas y los detalles de los datos son conocidos y respetados por la comunidad de datos, dijo Kim Kaluba, director senior de marketing de productos del proveedor de software de gestión de datos SAS Institute.

Encontrar el equilibrio adecuado. Existe una tensión natural entre querer capturar todos los datos y garantizar que todos los datos capturados sean de la máxima calidad, dijo Arthur Lent, vicepresidente senior y director de tecnología de la división de protección de datos de Dell EMC. También es importante comprender la finalidad de la adquisición de determinados datos, los procesos de recogida de los mismos y sus aplicaciones analíticas posteriores previstas por el resto de la organización. Por lo general, se pueden desarrollar prácticas personalizadas que son propensas a errores, frágiles y no repetibles.

Mejores prácticas para gestionar la calidad de big data

Las mejores prácticas que mejoran sistemáticamente la calidad de los datos para big data, según Balasubramanian de Orion, incluyen las siguientes

- Obtener el patrocinio ejecutivo para establecer procesos de gobernanza de datos.

- Crear un equipo de gobernanza de datos interfuncional que incluya a los usuarios de la empresa, los analistas de negocio, los administradores de datos, los arquitectos de datos, los analistas de datos y los desarrolladores de aplicaciones.

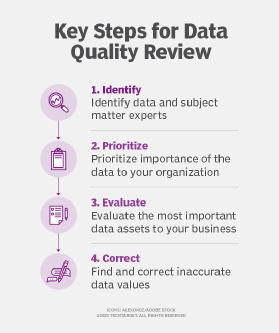

- Establecer estructuras de gobernanza sólidas, que incluyan la administración de datos, la supervisión proactiva y las revisiones periódicas de los datos.

- Definir la validación de datos y las reglas de negocio integradas en los procesos y sistemas existentes.

- Definir administradores de datos para varios dominios de negocio y establecer procesos para la revisión y aprobación de datos y elementos de datos.

- Establecer una sólida gestión de datos maestros para los datos relacionados con los productos, de modo que haya solo una forma inclusiva y común de definir un producto.

- Definir normas de datos de glosario empresarial, nomenclatura y vocabularios controlados.

- Aumentar la adopción de vocabularios controlados establecidos por organizaciones como la Organización Internacional de Normalización, la Organización Mundial de la Salud y el Diccionario Médico para Actividades Reguladoras.

- Eliminar la duplicación de datos integrando los datos siempre que sea posible mediante interfaces con otros sistemas.