ra2 studio - Fotolia

15 riesgos de IA que las empresas deben enfrentar y cómo abordarlos

Estos riesgos asociados con la implementación de sistemas de IA deben ser reconocidos por las organizaciones que desean utilizar la tecnología de manera ética y con la menor responsabilidad posible.

Las empresas siempre han tenido que gestionar los riesgos asociados con las tecnologías que adoptan para construir sus negocios. Deben hacer lo mismo cuando se trata de implementar inteligencia artificial.

Algunos de los riesgos de la IA son los mismos que los de la implementación de cualquier tecnología nueva: una alineación estratégica deficiente con los objetivos comerciales, una falta de habilidades para respaldar las iniciativas y la falta de aceptación en todos los rangos de la organización.

Para tales desafíos, los ejecutivos deben apoyarse en las mejores prácticas que han guiado la adopción efectiva de otras tecnologías. Los consultores de gestión y los expertos en IA dijeron que aconsejan a los CIO y a sus colegas de dirección para identificar áreas en las que la IA puede ayudarlos a cumplir los objetivos de la organización, desarrollar estrategias para garantizar que tengan la experiencia para respaldar los programas de IA y crear políticas sólidas de gestión de cambios para suavizar y acelerar la adopción en la empresa.

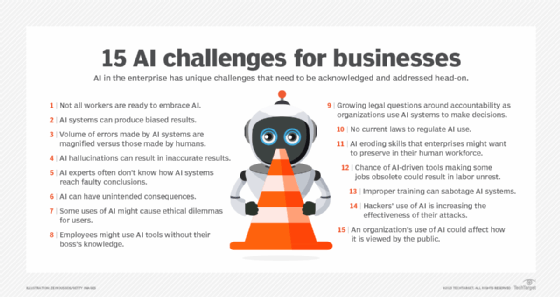

Sin embargo, los ejecutivos están descubriendo que la IA en la empresa también conlleva riesgos únicos que deben reconocerse y abordarse de frente.

Aquí hay 15 áreas de riesgo que pueden surgir a medida que las organizaciones implementan y usan tecnologías de IA en la empresa.

1. La falta de confianza de los empleados puede detener la adopción de IA

No todos los trabajadores están listos para adoptar la IA. La firma de servicios profesionales KPMG, en asociación con la Universidad de Queensland en Australia, descubrió que el 61 % de los encuestados en su informe "Confianza en la inteligencia artificial: perspectivas globales 2023" son ambivalentes o no están dispuestos a confiar en la IA.

Sin esa confianza, una implementación de IA será improductiva, según los expertos. Considere, por ejemplo, qué sucedería si los trabajadores no confían en una solución de IA en una planta de producción que determina que una máquina debe apagarse para realizar el mantenimiento. Incluso si el sistema de IA es casi siempre preciso, si el usuario no confía en la máquina, entonces la IA es un fracaso.

2. La IA puede tener sesgos no intencionales

En su nivel más básico, la IA toma grandes volúmenes de datos y luego, mediante algoritmos, identifica y aprende a actuar a partir de los patrones que identifica en los datos. Pero cuando los datos están sesgados o son problemáticos, la IA produce resultados defectuosos.

Del mismo modo, los algoritmos problemáticos –como los que reflejan los sesgos de los programadores– pueden hacer que los sistemas de IA produzcan resultados sesgados. "Este no es un problema hipotético", según "Las Implicaciones de los Algoritmos para los Derechos Civiles", un informe de marzo de 2023 del Comité Asesor de Connecticut a la Comisión de Derechos Civiles de EE. UU.

El informe explica cómo ciertos datos de capacitación podrían conducir a resultados sesgados, señalando como ejemplo que "en la ciudad de Nueva York, los agentes de policía detuvieron y cachearon a más de cinco millones de personas durante la última década. Durante ese tiempo, las personas negras y latinas eran nueve veces más probable que fueran detenidos que sus contrapartes blancas. Como resultado, los algoritmos policiales predictivos entrenados en datos de esa jurisdicción predecirán la criminalidad en vecindarios con residentes predominantemente negros y latinos".

3. Sesgos y errores muy magnificados por el volumen de transacciones de IA

Los trabajadores humanos, por supuesto, tienen prejuicios y cometen errores, pero las consecuencias de sus errores se limitan al volumen de trabajo que realizan antes de detectar los errores, que a menudo no es mucho. Sin embargo, las consecuencias de los sesgos o errores ocultos en los sistemas operativos de IA pueden ser exponencialmente mayores.

Como explicaron los expertos, los humanos pueden cometer docenas de errores en un día, pero un bot que maneja millones de transacciones al día magnifica por millones cualquier error individual.

4. La IA podría ser delirante

La mayoría de los sistemas de IA son estocásticos o probabilísticos. Esto significa que los algoritmos de aprendizaje automático, el aprendizaje profundo, el análisis predictivo y otras tecnologías trabajan juntas para analizar datos y producir la respuesta más probable en cada escenario. Eso contrasta con los entornos de IA deterministas, en los que el comportamiento de un algoritmo se puede predecir a partir de la entrada.

Pero la mayoría de los entornos de IA del mundo real son estocásticos o probabilísticos, y no son 100% precisos. "Devuelven su mejor suposición a lo que está solicitando", explicó Will Wong, director principal de investigación de Info-Tech Research Group.

De hecho, los resultados inexactos son lo suficientemente comunes –particularmente con más y más personas usando ChatGPT– por lo que existe un término para el problema: alucinaciones de IA. "Entonces, al igual que no puedes creer todo lo que hay en Internet, no puedes creer todo lo que escuchas de un chatbot; tienes que examinarlo", aconsejó Wong.

5. La IA puede crear resultados inexplicables, dañando así la confianza

La explicabilidad, o la capacidad de determinar y articular cómo y por qué un sistema de IA llegó a sus decisiones o predicciones, es otro término que se usa con frecuencia cuando se habla de IA.

Si bien la explicabilidad es fundamental para validar los resultados y generar confianza en la IA en general, no siempre es posible, especialmente cuando se trata de sistemas de IA sofisticados que aprenden continuamente mientras operan.

Por ejemplo, dijo Wong, los expertos en IA a menudo no saben cómo los sistemas de IA llegaron a esas conclusiones defectuosas etiquetadas como alucinaciones. Tales situaciones pueden obstaculizar la adopción de la IA, a pesar de los beneficios que puede brindar a muchas organizaciones.

En un artículo de septiembre de 2022, titulado "Por qué las empresas necesitan una IA explicable, y cómo entregarla", la firma de gestión global McKinsey & Company señaló que "los clientes, los reguladores y el público en general deben sentirse seguros de que los modelos de IA que procesan decisiones trascendentales lo están haciendo de una manera precisa y justa. Del mismo modo, incluso los sistemas de IA más avanzados acumularán polvo si los usuarios previstos no entienden la base de las recomendaciones que se proporcionan".

6. La IA puede tener consecuencias no deseadas

De manera similar, el uso de IA puede tener consecuencias que los líderes empresariales no consideraron o no fueron capaces de contemplar, dijo Wong.

Un reporte de 2022 publicado por la Casa Blanca, titulado "El impacto de la inteligencia artificial en el futuro de la fuerza laboral en la Unión Europea y los Estados Unidos de América", se refirió a este punto y citó los hallazgos de los investigadores de Google que estudiaron "cómo los modelos de lenguaje natural interpretan las discusiones sobre discapacidades y enfermedades mentales y descubrieron que varios modelos de sentimientos penalizaban tales discusiones, creando un sesgo incluso contra frases positivas como 'Lucharé por las personas con enfermedades mentales'".

7. La IA puede comportarse de manera poco ética e ilegal

Algunos usos de la IA pueden generar dilemas éticos para sus usuarios, dijo Jordan Rae Kelly, director general sénior y jefe de seguridad cibernética para las Américas en FTI Consulting.

"Existe un impacto ético potencial en la forma en que usa la IA con el que sus partes interesadas internas o externas podrían tener un problema", dijo. Los trabajadores, por ejemplo, podrían encontrar el uso de un sistema de monitoreo basado en IA tanto como una invasión de la privacidad como una extralimitación corporativa, agregó Kelly.

Otros han planteado preocupaciones similares. El informe de la Casa Blanca de 2022 también destacó cómo los sistemas de inteligencia artificial pueden operar de maneras potencialmente poco éticas, citando un caso en el que "un algoritmo mostró desproporcionadamente anuncios de carrera STEM, que estaban destinados explícitamente a ser neutrales en cuanto al género, a posibles candidatos masculinos porque el costo de la publicidad para las candidatas más jóvenes es mayor y el algoritmo optimizó la rentabilidad".

8. El uso de la IA por parte de los empleados puede evadir o escapar del control empresarial

La "Encuesta de IA generativa de KPMG" de abril de 2023 encuestó a 225 ejecutivos y descubrió que el 68 % de los encuestados no ha designado a una persona o equipo central para organizar una respuesta al surgimiento de la tecnología, y señaló que "por el momento, la función de TI está liderando el esfuerzo".

KPMG también descubrió que el 60 % de los encuestados creen que les falta uno o dos años para implementar su primera solución de IA generativa, el 72 % dijo que la IA generativa desempeña un papel fundamental en la construcción y el mantenimiento de la confianza de las partes interesadas, y el 45 % cree que podría tener un efecto negativo en la confianza de su organización si no se implementan las herramientas correctas de gestión de riesgos.

Pero mientras los ejecutivos consideran soluciones de inteligencia artificial generativa y barandillas para implementar en los próximos años, muchos trabajadores ya están utilizando dichas herramientas. Una encuesta reciente de Fishbowl, una red social para profesionales, encontró que el 43 % de los 11.793 encuestados utiliza herramientas de IA para tareas laborales y casi el 70 % lo hace sin el conocimiento de su jefe.

Wong, de Info-Tech Research Group, dijo que los líderes empresariales están desarrollando una serie de políticas para gobernar el uso empresarial de las herramientas de inteligencia artificial, incluido ChatGPT. Sin embargo, dijo que las empresas que prohibieron su uso están descubriendo que tales restricciones no son populares o incluso factibles de hacer cumplir. Como resultado, algunos están reelaborando sus políticas para permitir el uso de tales herramientas en ciertos casos y con datos no propietarios y no restringidos.

9. Los problemas de responsabilidad no están resueltos ni determinados

Han surgido cuestiones legales en torno a la responsabilidad a medida que las organizaciones utilizan sistemas de IA para tomar decisiones y la integran en los productos y servicios que venden, y la cuestión de quién sería responsable de los malos resultados sigue sin determinarse.

Por ejemplo, Kelly de FTI Consulting dijo que no está claro quién –o qué– sería o debería ser culpado si AI escribe un código de computadora defectuoso que causa problemas. Ese problema deja a los ejecutivos, junto con los abogados, los tribunales y los legisladores, para avanzar con los casos de uso de IA con un alto grado de incertidumbre.

10. El uso empresarial podría entrar en conflicto con las leyes propuestas y las regulaciones esperadas

Los gobiernos de todo el mundo están analizando si deberían establecer leyes para regular el uso de la IA y cuáles deberían ser esas leyes. Los expertos legales y de inteligencia artificial dijeron que esperan que los gobiernos comiencen a aprobar nuevas reglas en los próximos años.

Es posible que las organizaciones deban ajustar sus hojas de ruta de IA, reducir sus implementaciones planificadas o incluso eliminar algunos de sus usos de IA si entran en conflicto con cualquier legislación próxima, dijo Kelly.

Los ejecutivos podrían encontrar eso desafiante, agregó, ya que la IA a menudo está integrada en las tecnologías y los servicios que compran a los proveedores. Esto significa que los líderes empresariales tendrán que revisar sus iniciativas de IA desarrolladas internamente y la IA en los productos y servicios comprados a otros para asegurarse de que no están infringiendo ninguna ley.

11. Las habilidades clave podrían estar en riesgo de ser erosionadas por la IA

Después de dos accidentes aéreos que involucraron aviones Boeing 737 Max, uno a fines de 2018 y otro a principios de 2019, algunos expertos expresaron su preocupación de que los pilotos estuvieran perdiendo habilidades básicas de vuelo a medida que dependían cada vez más de la creciente cantidad de automatización en la cabina.

Aunque esos incidentes son casos extremos, los expertos dijeron que la IA erosionará otras habilidades clave que las empresas podrían querer preservar en su fuerza laboral humana. "Vamos a dejar ir a las personas que saben cómo hacer las cosas sin tecnología", dijo Yossi Sheffi, experto en cadenas de suministro global, director del Centro de Transporte y Logística del MIT y autor de The Magic Conveyer Belt: Supply Chains, IA y el futuro del trabajo .

12. La IA podría provocar disturbios sociales

Una encuesta de mayo de 2023, titulada "IA, automatización y el futuro de los lugares de trabajo", del fabricante de software para el lugar de trabajo Robin, encontró que el 61 % de los encuestados cree que las herramientas impulsadas por la IA harán que algunos trabajos queden obsoletos.

Y muchos empleados que no pierden sus trabajos verán cambios en la forma en que trabajan y en el tipo de trabajo que realizan, agregaron los expertos.

Sheffi dijo que tales cambios impulsados por la tecnología en el mercado laboral en el pasado han provocado disturbios laborales y posiblemente podrían volver a hacerlo.

Incluso si tal escenario no ocurre con la IA, Sheffi y otros dijeron que las organizaciones deberán ajustar las responsabilidades laborales, así como ayudar a los empleados a aprender a usar las herramientas de IA y aceptar nuevas formas de trabajo.

13. Datos de entrenamiento deficientes y falta de monitoreo puede sabotear los sistemas de IA

En 2016, Microsoft lanzó un chatbot llamado Tay en Twitter. Los ingenieros habían diseñado el bot para participar en interacciones en línea y luego aprender patrones de lenguaje para que ella –sí, Tay fue diseñada para imitar el habla de una adolescente– sonara normal en internet.

En cambio, los trolls le enseñaron a Tay un lenguaje racista, misógino y antisemita, y su lenguaje se volvió tan hostil y ofensivo en cuestión de horas que Microsoft suspendió la cuenta.

La experiencia de Microsoft destaca otro gran riesgo con la construcción y el uso de IA: se le debe enseñar bien para que funcione correctamente.

14. Los hackers pueden usar la IA para crear ataques más sofisticados

Los malos actores están utilizando la IA para aumentar la sofisticación de sus ataques, hacer que sus ataques sean más efectivos y mejorar la probabilidad de que sus ataques penetren con éxito en las defensas de sus víctimas.

"La IA puede acelerar la efectividad de los malos", dijo Kelly. Los hackers experimentados no son los únicos que aprovechan la IA. Wong dijo que la IA –y la IA generativa en particular– permite a los posibles hackers sin experiencia desarrollar códigos maliciosos con relativa facilidad y velocidad.

"Puedes tener un diálogo con ChatGPT para descubrir cómo ser un hacker", dijo Wong. "Puede pedirle a ChatGPT que escriba el código por usted. Solo tiene que saber cómo hacer las preguntas correctas".

15. Las malas decisiones sobre el uso de la IA podrían dañar reputaciones

Después del tiroteo de febrero de 2023 en una escuela privada de Nashville, la Oficina de Equidad, Diversidad e Inclusión de Peabody de la Universidad de Vanderbilt respondió al trágico evento con un correo electrónico que incluía, al final, una nota que decía que el mensaje había sido escrito usando ChatGPT. Los estudiantes y otros rápidamente criticaron el uso de la tecnología en tales circunstancias, lo que llevó a la universidad a disculparse por su "falta de juicio".

El incidente destaca el riesgo que enfrentan las organizaciones al usar IA: la forma en que optan por usar la tecnología podría afectar la forma en que sus empleados, clientes, socios y el público los ven.

Las organizaciones que usan IA de formas que algunos creen que son sesgadas, invasivas, manipuladoras o poco éticas podrían enfrentar una reacción violenta y daños a su reputación. "Podría cambiar la percepción de su marca de una manera que no quiere", agregó Kelly.

Cómo gestionar los riesgos

Los riesgos derivados o asociados con el uso de la IA no se pueden eliminar, pero se pueden gestionar. Las organizaciones primero deben reconocer y comprender estos riesgos, según múltiples expertos en inteligencia artificial y liderazgo ejecutivo. A partir de ahí, deben implementar políticas para ayudar a minimizar la probabilidad de que dichos riesgos afecten negativamente a sus organizaciones. Esas políticas deben garantizar el uso de datos de alta calidad para la capacitación y requieren pruebas y validación para eliminar sesgos no deseados.

Las políticas también deben exigir un monitoreo continuo para evitar que los sesgos se infiltren en los sistemas, que aprenden a medida que funcionan, y para identificar cualquier consecuencia inesperada que surja a través del uso.

Y aunque es posible que los líderes organizacionales no puedan prever todas las consideraciones éticas, los expertos dijeron que las empresas deben tener marcos para garantizar que sus sistemas de inteligencia artificial contengan las políticas y los límites para crear resultados éticos, transparentes, justos e imparciales, con empleados humanos que monitorean estos sistemas para confirmar los resultados cumplen con los estándares establecidos por la organización.

Las organizaciones que buscan tener éxito en dicho trabajo deben involucrar a la junta y a la dirección. Como dijo Wong, "Esto no es solo un problema de TI, por lo que todos los ejecutivos deben involucrarse en esto".