horizon - stock.adobe.com

Wie Sie die optimale Kühlung für hyperkonvergente IT berechnen

Durch hyperkonvergente IT wird die Verwaltung der Infrastruktur erleichtert, aber gleichzeitig steigt die Wärmebelastung. Die Formeln helfen bei der Berechnung für die ideale Kühlung.

Hyperkonvergente IT-Lösungen (HCI, Hyper-Converged Infrastructure) bieten Vorteile, wie beispielsweise einfaches IT-Management, aber sie stellen Admins auch vor neue Herausforderungen. So wird die Kühlung des Data Centers zu einem Problem.

Wenn mehrere hyperkonvergente Appliances in einem Server-Rack montiert werden, entstehen in dicht gepackten Umgebungen sehr hohe Wärmelasten. Natürlich ist es wichtig, die Kühlluftwege nicht zu blockieren, aber es ist sehr schwierig, genügend Kühlluft mit der richtigen Temperatur zu den Appliances zu bringen, um die Abwärme effizient abzuführen.

Natürlich gelten auch hier die gleichen Prinzipien der Rechenzentrumskühlung wie bei anderer IT-Hardware. Die kompakte Bauweise der hyperkonvergenten IT und die Einfachheit, mit der eine große Anzahl entsprechender Appliances in ein Rack eingebaut werden kann, stellt die Kühlung jedoch vor besondere Herausforderungen. Viele Rechenzentren sind auf diese hohe IT-Last hyperkonvergenter Infrastrukturen und die damit verbundenen Anforderungen an die Kühlsysteme nicht vorbereitet. Mit dem richtigen Ansatz können bestehende Kühlsysteme jedoch an die erhöhte Wärmelast angepasst werden.

Die Leistungsaufnahme hyperkonvergenter Appliances liegt häufig bei über 1.000 Watt, was zu einer entsprechend hohen Abwärme führt. Ein ganzes Server-Rack voller 2U-Appliances könnte so leicht auf 25-30 kW kommen, während typische 1U-Server eher bei 350 bis 500 Watt pro Server liegen. Selbst wenn man alle üblichen Maßnahmen zur Trennung des Kühlluftstroms von der warmen Abluft ergreift, wird man trotz Kaltgang-/Warmgangaufbau, Einhausungen und Einbau von Blenden in nicht vollständig gefüllten Racks immer noch eine zu geringe Kühlleistung erreichen. Auch wenn theoretisch genügend Kühlleistung zur Verfügung steht.

Was ist die optimale Kühlung für hyperkonvergente Infrastruktur?

Für eine möglichst effiziente Kühlung sollte ein Rechenzentrum nahe an den ASHRAE-Richtlinien betrieben werden, die eine Zulufttemperatur von 27 Grad Celsius (80,6 Grad Fahrenheit) empfehlen, was nicht nur zu Kosteneinsparungen führt, sondern gleichzeitig auch die Kühlkapazität erhöht. Eine höhere Zulufttemperatur führt natürlich auch zu einer entsprechend höheren Temperatur der zu kühlenden Abluft.

Ein typisches 20-Tonnen-Kühlsystem (Computer Room Air Conditioning, CRAC) mit einer Kühlleistung von 84 kW bei einer Rücklufttemperatur von circa 24 Grad Celsius kann bei einer Erhöhung der Rücklufttemperatur auf circa 32 Grad Celsius ganze 137 kW Kühlleistung zur Verfügung stellen. Es ist also durchaus möglich, eine enorme zusätzliche Kühlleistung zu erzielen. Allerdings ist damit noch lange nicht sichergestellt, dass die Kühlleistung auch dort ankommt, wo sie benötigt wird.

Eine effektive Rechenzentrumskühlung für hyperkonvergente IT muss daher sowohl die Kapazität als auch die Luftführung berücksichtigen. Wenn nicht genügend Kühlluft zur Verfügung steht, saugen die Serverlüfter Luft an, wo immer sie sie bekommen können, also auch durch nicht abgedeckte Lücken im Server-Rack, aus benachbarten Server-Racks oder aus Lücken zwischen Serverschränken und Fußboden.

Daraus ergeben sich zwei Probleme: Erstens drehen die Lüfter am Server schneller und verbrauchen dadurch mehr Energie. Zweitens ist die Luft, die auf diese Weise an anderer Stelle angesaugt wird, natürlich wärmer als die Kühlluft, die die Rechenzentrumskühlung bereitstellt.

Wenn aber im Rechenzentrum bereits mit höheren Zulufttemperaturen gearbeitet wird, laufen die teuren HCI-Appliances wahrscheinlich deutlich heißer als geplant. Das kann zumindest zu Datenfehlern führen, dürfte aber auch die Lebensdauer der Hardware verkürzen.

Notwendige Kühlluft für HCI-Systeme

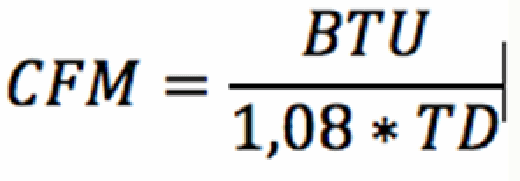

Mit dieser Formel lässt sich leicht herausfinden, ob es überhaupt möglich ist, die nötige Menge an Kühlluft bereitzustellen:

CFM steht für Cubic Feet per Minute, also Kubikfuß pro Minute. BTU steht für die Wärmebelastung in British Thermal Units, wobei 1 BTU 3,414 Watt entspricht. 1,08 ist wiederum eine Konstante unter dem Nullpunkt. In höher gelegenen Gebieten muss diese Konstante daher angepasst werden. TD ist die Abkürzung für Temperatur-Differential, oft auch als Delta T oder Δ T ausgedrückt.

Ein kurzes Rechenbeispiel: Angenommen, die Energieaufnahme eines IT-Gerätes entspricht der IT-Last der Hardware bei voller Auslastung. Ein Gerät mit 1.600 Watt würde dann etwa 5.460 BTU entsprechen. Nimmt man nun ein Delta T von 25 Grad Fahrenheit an, so werden 202 CFM Luft benötigt, um die IT-Hardware zu kühlen. Für sich genommen ist das kein großes Problem.

Wenn Sie jedoch ein ganzes Rack mit hyperkonvergenten Geräten bestücken, können Sie leicht auf mehr als 4.000 CFM Kühlluft kommen. Ein herkömmliches Kühlgerät liefert circa 12.000 CFM Kühlluft, womit nur drei Server-Racks vernünftig gekühlt werden können. Selbst wenn man nur von einer Auslastung der IT-Systeme von 75 Prozent ausgeht, benötigt man immer noch mehr als 3.000 CFM pro Serverschrank.

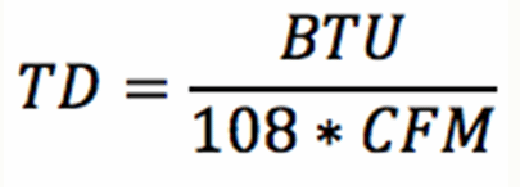

Was aber, wenn man diese Menge an Kühlluft nicht zur Verfügung stellen kann? Die obige Formel lässt sich natürlich auch nach Delta T auflösen:

Vier Serverschränke mit 75 Prozent Auslastung würden 12.000 CFM Kühlluft benötigen. Wenn aber weitere Schränke in dieser Rack-Reihe zusammen auf weitere 6.000 Watt kämen, ergäbe das zusammen das Äquivalent von sechs reinen HCI-Schränken mit einem Kühlluftbedarf von mindestens 18.000 CFM.

Die Rechenzentrumskühlung kann aber nur 12.000 CFM liefern. Selbst wenn die Serverlüfter auf Hochtouren laufen, können sie keine zusätzliche Kühlluft mehr ansaugen, so dass das Delta T auf knapp 12 Grad Celsius (53 Grad Fahrenheit) ansteigt. Die IT-Hardware kann mit einem solchen Temperaturanstieg jedoch nicht umgehen und wird sich entweder zum Selbstschutz abschalten oder ganz ausfallen.

Was sind weitere Faktoren der HCI-Kühlung?

Sind mehrere Kühlgeräte vorhanden, kann die Kühlluft auch von mehreren zu einer bestimmten Rack-Reihe geführt werden. Wird die Kühlluft jedoch über einen Unterboden geführt, so können selbst über großzügig ausgesparte Doppelbodenplatten mit mehr als 50 Prozent Luftdurchlass je nach Luftdruck im Unterboden nur circa 900 bis 1.600 CFM geliefert werden. Selbst unter idealen Bedingungen wird damit eine Kühlleistung von maximal fünf bis neun kW erreicht.

Als Reaktion darauf werden oft zu viele luftdurchlässige Kacheln oder sogar ventilatorunterstützte Kacheln eingebaut. Damit riskiert man aber nur, dass der Luftdruck im Unterboden zu stark absinkt, was die Kühlung anderer Serverschränke und Rack-Reihen beeinträchtigt. Wird die Kühlluft stattdessen über die Racks geführt, begrenzt wiederum der Rohrdurchmesser die Luftzufuhr. Selbst wenn also die Gesamtkühlleistung rechnerisch ausreichend ist, stellt sich immer noch die Frage, ob überhaupt genügend Kühlluft zu den IT-Geräten gebracht werden kann.

Bei einer geplanten Leistungsaufnahme von mehr als 7.500 bis 10.000 Watt pro Serverschrank wird man um zusätzliche Kühlsysteme im Rechenzentrum nicht herumkommen. Für solche hochverdichteten Serverlandschaften gibt es spezielle Kühlmöglichkeiten wie In-Row-Kühlgeräte, Rear-Door-Wärmetauscher oder auch Flüssigkühlungssystemen. Auch die direkte Flüssigkühlung wird zunehmend interessant.