Getty Images/iStockphoto

Wie und warum Unternehmen ChatGPT-Richtlinien entwickeln

ChatGPT-ähnliche Tools haben Potenzial für Unternehmen, bergen aber auch Risiken wie Datenlecks und kostspielige Fehler. Firmen sollten daher ChatGPT-Richtlinien definieren.

ChatGPT von OpenAI und andere große Sprachmodelle sind vielversprechend, wenn es darum geht, die Arbeitsabläufe in Unternehmen zu automatisieren oder zu erweitern. Sie können komplexe Dokumente zusammenfassen, verborgene Erkenntnisse aufdecken und Inhalte für verschiedene Zielgruppen übersetzen.

ChatGPT birgt jedoch auch neue Risiken, wie zum Beispiel die Generierung grammatikalisch korrekter, aber sachlich ungenauer Prosa – ein Phänomen, das oft als Halluzination bezeichnet wird. Eine Anwaltskanzlei wurde kürzlich gerügt und mit einer Geldstrafe belegt, weil sie einen Schriftsatz eingereicht hatte, in dem nichtexistierende Gerichtsfälle zitiert wurden.

Viele ChatGPT-ähnliche Dienste sammeln auch die Fragen der Nutzer als Teil des Modelltrainings. Samsung hat kürzlich seinen Mitarbeitern die Nutzung von ChatGPT untersagt, nachdem entdeckt wurde, dass Techniker geschützte Informationen mit dem Dienst austauschen.

Angesichts dieser Risiken müssen Unternehmen eher früher als später Richtlinien für die akzeptable Nutzung entwickeln, die einen verantwortungsvollen Umgang mit ChatGPT festlegen und gleichzeitig die Produktivität und das Kundenerlebnis verbessern. Es ist auch wichtig zu klären, wie sich die Richtlinien auf die interne Nutzung und die externen Dienste auswirken können.

Terminologie klären

Während ChatGPT die Aufmerksamkeit auf die Leistungsfähigkeit der generativen KI gelenkt hat, werden Large Language Models (LLM), die dem Dienst zugrunde liegen, auch in viele Unternehmensanwendungen eingeflochten. Viele verwenden den Begriff GPT, der für Generative Pre-trained Transformer steht, und das Modell hinter ChatGPT ist. Microsoft und GitHub bezeichnen diese als Copiloten, während die Rechtsbranche beginnt, sie als Co-Anwälte (Co-Counsel) zu bezeichnen. Unabhängig von den Begriffen müssen alle diese Tools in Ihren Policies und Richtlinien enthalten sein.

Barry Janay, Inhaber und Präsident der Anwaltskanzlei Barry E. Janay, P.C., sagt, dass seine Kanzlei ChatGPT, Casetext CoCounsel und GitHub Copilot vollständig übernommen hat. Aber er mag diese Begriffe nicht, da sie die Notwendigkeit der Aufsicht beschönigen.

„Ich mag die Bezeichnungen Copilot oder Co-Counsel nicht besonders, denn obwohl sie eine unglaubliche Effizienz mit 100- oder sogar 1.000-facher Produktivität schaffen, müssen sie immer noch überwacht werden“, sagt Janay. „Ich sehe die Entwicklung positiv, auch wenn ich mir durchaus bewusst bin, dass es ernsthafte potenzielle Probleme gibt.“

Klare Leitlinien definieren

„Unternehmen sollten klare Richtlinien dafür aufstellen, was Mitarbeiter tun dürfen und was nicht, um Leitlinien für ein verantwortungsvolles Experimentieren mit KI zu schaffen“, sagt Steve Mills, Managing Director, Partner und Chief AI Ethics Officer bei der Boston Consulting Group (BCG).

Dadurch erhalten die Mitarbeiter einen klaren Handlungsspielraum, der es ihnen erlaubt, mit generativer KI zu experimentieren, zum Beispiel bei der Entwicklung von Marketingtexten oder bei der Durchführung grundlegender Recherchen zur Identifizierung relevanter Inhalte für weitere Analysen. Mills sagt, die BCG-Forschung habe ergeben, dass Unternehmen mit klaren Richtlinien innovativer sind, da die Mitarbeiter zwar schnell vorankommen, aber auch wissen, wann sie eine Pause für eine tiefergehende Diskussion einlegen müssen.

Sobald die Richtlinien festgelegt sind, sollten die Führungskräfte sie im gesamten Unternehmen bekannt machen. Dies trägt dazu bei, dass die Mitarbeiter verstehen, wie sie die Technologie sicher, gesetzeskonform und verantwortungsbewusst nutzen können.

Mills rät Unternehmen außerdem, besondere Vorsichtsmaßnahmen zu ergreifen, wenn sie mit sensiblen oder geschützten Informationen umgehen, seien es ihre eigenen oder die ihrer Kunden. „Die Führungsebene sollte ausdrücklich kommunizieren, welche Informationen dem KI-Modell zur Verfügung gestellt werden sollen und welche nicht“, erläutert er.

Je nach ihren spezifischen Bedürfnissen können Unternehmen ihre eigenen Modelle entwickeln oder Dienstleistungen von Anbietern kaufen. Klären Sie bei der Bewertung der Anbieteroptionen, wie die Trainingsdaten und Eingabeaufforderungen in die Modelle zurückfließen. Die Schaffung eines gemeinsamen Verständnisses darüber, worauf bei neuen Tools zu achten ist, kann Mitarbeiter auf allen Unternehmensebenen unterstützen, sich auf eine akzeptable Nutzung einzustellen.

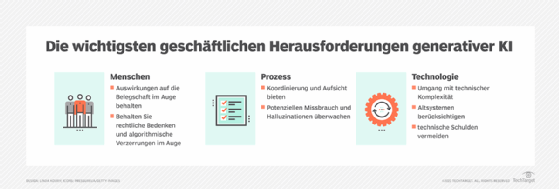

Verantwortungsvolle KI-Programme schaffen

Ein Eckpfeiler jeder effektiven ChatGPT-Richtlinie ist die Verpflichtung zur verantwortungsvollen Nutzung von KI auf Führungsebene. „Der Erfolg hängt in vielen Fällen weitgehend davon ab, ob die CEOs die Bedeutung dieser Initiativen verstehen“, so Mills.

BCG hat festgestellt, dass Unternehmen, in denen sich der CEO stark engagiert, deutlich mehr Geschäftsvorteile verzeichnen. „Damit KI wirklich einen geschäftlichen Nutzen bringen kann, ohne dass Risiken zu Krisen werden, sind engagierte Ressourcen und ein verantwortungsvolles Handeln erforderlich“, sagt Mills.

Investieren Sie die Zeit und die Ressourcen, um neue Risiken zu verstehen, die für jedes Unternehmen unterschiedlich sein können. Wenn die Führungskräfte erst einmal bedacht und geplant haben, was schief gehen kann, kann dieses Bewusstsein bei der Gestaltung und Umsetzung von KI-Richtlinien im gesamten Unternehmen helfen.

Wie Instantprint eine KI-Richtlinie entwickelt hat

Dan Robinson, Leiter für Marketing und E-Commerce bei der britischen Online-Druckerei Instantprint, hat die Entwicklung der KI-Richtlinien des Unternehmens überwacht. Er empfiehlt, ein vertrauensvolles Umfeld zu schaffen und den Teams die Regeln und Vorschriften an die Hand zu geben, die sie benötigen, um diese Tools effektiv und sicher zu nutzen.

Instantprint gliedert seinen KI-Verhaltenskodex in spezifische Dos und Don'ts für jedes Tool. „Wenn wir uns gemeinsam um Richtlinien bemühen, ist es wahrscheinlicher, dass wir Regeln haben, die für unser Team funktionieren und von unserem Team entwickelt wurden, mit Ausnahme von rechtlichen und ethischen Rahmenbedingungen als Standard“, sagt Robinson.

Transparenz ist für diesen Ansatz von grundlegender Bedeutung. Robinson hat festgestellt, dass diejenigen, die die Tools täglich nutzen, den größten Einblick haben. Die offene Weitergabe dieser Informationen erleichtert das Verständnis, fördert die Verantwortlichkeit und ermöglicht es dem Unternehmen, schneller auf Probleme zu reagieren.

Instantprint begann mit einer Bestandsaufnahme und Analyse aller KI-Tools, die im Unternehmen eingesetzt werden. Dann führte das Unternehmen eine interne Umfrage durch, um die Ansichten der Mitarbeiter über KI und ihre Auswirkungen auf ihre Arbeit zu erkunden. In der Umfrage wurden mehr als 1.000 Büroangestellte befragt, um Bedenken, Ausgabenmuster und Beispiele für den Einsatz von KI an ihrem Arbeitsplatz aufzudecken.

Das Unternehmen erstellte auch ein Arbeitsdokument mit Datumsstempeln, um eine sich entwickelnde Richtlinie zu entwickeln und gleichzeitig alle Mitarbeiter auf dem neuesten Stand zu halten. „Die KI-Richtlinien werden kontinuierlich geschrieben, während wir noch lernen“, sagt Robinson.

Bewährte Verfahren für die Erstellung einer ChatGPT-Richtlinie

Wenn Sie eine ChatGPT-Richtlinie für Ihr Unternehmen erstellen, sollten Sie folgende Punkte beachten.

| Do ... | Don't ... |

| Machen Sie den verantwortungsvollen Einsatz von KI zu einer Priorität auf Führungsebene. | Warten Sie mit der Entwicklung einer KI-Nutzungsrichtlinie. |

| Klären Sie die verschiedenen Begriffe und Bezeichnungen, die in ChatGPT-ähnlichen Diensten verwendet werden. | Teilen Sie sensible Daten mit öffentlichen KI-Diensten. |

| Klären Sie die verschiedenen Wörter und Bezeichnungen, die in ChatGPT-ähnlichen Diensten verwendet werden. | Automatisieren Sie Prozesse mit KI ohne menschliche Aufsicht. |

| Erfassen Sie die bestehende Nutzung von KI-Tools und bewerten Sie die Risiken jedes Tools. | Behaupten Sie, dass KI-generierte Inhalte von Menschen erstellt wurden. |

| Entwickeln Sie einen Prozess, um die Qualität der KI-Ergebnisse sicherzustellen. | Vertrauen Sie KI-Ergebnissen, ohne ihre Quellen, Zitate und Behauptungen zu überprüfen. |

| Entwickeln Sie einen Prozess, um neue Probleme zu melden. | Vertrauen Sie KI-Modellen, ohne sie auf Verzerrungen zu prüfen. |