Vasyl - stock.adobe.com

Welche verschiedenen Arten des IT-Monitoring gibt es?

IT-Monitoring ist ein wichtiger Bestandteil des IT-Betriebs, damit Probleme frühzeitig erkannt werden. Dieser Beitrag geht auf verschiedene Arten des Monitoring ein.

Mangelnder Einblick in die IT-Organisationen ist seit den Anfängen der Computertechnik ein Problem, das zu Ineffizienz und Kapitalverschwendung, lästigen Leistungsproblemen und verwirrenden Verfügbarkeitsproblemen führt, deren Behebung kostspielig und zeitaufwändig sein kann. Aus diesem Grund ist die IT-Überwachung seit langem ein wesentlicher Bestandteil jeder IT-Strategie eines Unternehmens.

Das IT-Monitoring ist notwendig, um das Rechenzentrum und die darin enthaltenen Anwendungen und Dienste zu überwachen und zu steuern. IT-Administratoren und Unternehmensleiter verfolgen die Metriken im Laufe der Zeit, um sicherzustellen, dass die IT-Organisation das erforderliche Leistungs-, Sicherheits- und Verfügbarkeitsniveau aufrechterhält, und nutzen Trends, um Infrastruktur-Updates und -Änderungen zu validieren, lange bevor Anwendungen und Dienste betroffen sind. Gleichzeitig können Administratoren dank Echtzeitwarnungen auf unmittelbare Probleme reagieren, die dem Unternehmen schaden könnten.

Die Überwachung der Unternehmens-IT nutzt softwarebasierte Instrumente wie APIs und Software-Agenten, um Betriebsinformationen über Hardware und Software in der gesamten Unternehmensinfrastruktur zu sammeln. Diese Informationen können grundlegende Geräte- oder Anwendungs- und Gerätezustandsprüfungen sowie weitaus detailliertere Metriken umfassen, die die Ressourcenverfügbarkeit und -nutzung, System- und Netzwerkreaktionszeiten sowie Fehlerraten und Alarme verfolgen.

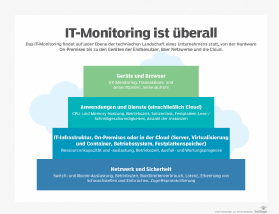

Bei der IT-Überwachung kommen die folgenden drei grundlegenden Schichten zum Einsatz:

1. Die Foundation-Schicht sammelt Daten aus der IT-Umgebung, wobei häufig Kombinationen von Agenten, Protokollen, APIs oder anderen standardisierten Kommunikationsprotokollen für den Zugriff auf Daten aus Hardware und Software verwendet werden.

2. Die Softwareschicht verarbeitet und analysiert dann die Rohdaten. Daraus ermitteln die Überwachungs-Tools Trends und generieren Alarme.

3. Die Interface-Schicht zeigt die analysierten Daten in Diagrammen oder Tabellen über ein GUI-Dashboard an.

Arten des IT-Monitorings

Obwohl der Bedarf an IT-Monitoring allgegenwärtig ist, haben sich die Überwachungsansätze im Laufe der Jahre vermehrt und diversifiziert. Das hat zu einer Reihe von Strategien und Tools geführt, die sich auf bestimmte Aspekte des Monitorings konzentrieren: IT-Infrastruktur, Public Cloud, Netzwerk, Sicherheit, Anwendungen und UX.

Monitoring der IT-Infrastruktur

Die traditionelle Grundlage der Computing-Infrastruktur liegt in der lokalen Rechenzentrumsumgebung eines Unternehmens: Flotten von physischen und virtuellen Servern sowie Storage-Ressourcen wie lokalen Festplatten und Festplatten-Arrays. Das Server-Monitoring erkennt und klassifiziert die vorhandenen Ressourcen, einschließlich Hardware, Betriebssysteme und Treiber, und sammelt und verarbeitet dann eine Reihe von Metriken.

Die Metriken können die Verfügbarkeit physischer und virtueller Server – die Betriebszeit – und die Leistung verfolgen und die Ressourcenkapazität messen, zum Beispiel die Verfügbarkeit von Prozessorkernen und die Taktnutzung, die Memory-Kapazität und -Nutzung, das Disk Storage und das zugehörige Storage-Netzwerk.

Die Überwachung kann auch Systemkonfigurationen überprüfen und durchsetzen, um Einheitlichkeit und Sicherheit zu gewährleisten. Durch die Überwachung von Kapazitätsmetriken kann ein Unternehmen nicht verfügbare, ungenutzte oder nicht ausgelastete Ressourcen aufspüren und fundierte Vorhersagen darüber treffen, wann und in welchem Umfang ein Upgrade erforderlich ist.

Mithilfe von Metriken können Administratoren auch Benchmarks überwachen: Das heißt es wird die tatsächliche Rechenleistung gemessen. So erkennen Sie Infrastrukturausfälle sofort und können sie korrigieren. Änderungen der Leistungstrends im Laufe der Zeit können auch auf potenzielle künftige Rechenprobleme hinweisen, zum Beispiel auf überlastete Server.

Monitoring der Public-Cloud-Infrastruktur

In dem Maße, in dem Unternehmen ihre Rechenumgebungen außerhalb des eigenen Hauses ausbauen, hat sich die Infrastrukturüberwachung auch auf Remote- und Cloud-Infrastrukturen ausgedehnt. Obwohl das Cloud-Monitoring einige Einschränkungen aufweist, ermöglichen IaaS-Anbieter häufig einen Einblick in die Infrastruktur bis hinunter auf die Server- und Betriebssystemebene, einschließlich Prozessoren, Memory und Storage. Mit einigen nativen Tools können IT-Manager die Details der Protokolldaten einsehen. Dennoch sind Public-Cloud-Infrastrukturen von einer Virtualisierungsschicht umhüllt, die die zugrunde liegenden physischen Ressourcen des Anbieters verbirgt. Cloud-Anbieter bieten native Monitoring Tools an, und für Multi-Cloud-Umgebungen gibt es Tools von Drittanbietern.

Netzwerk-Monitoring

Server und Storage sind ohne ein LAN und WAN, mit denen sie verbunden sind, nur von geringem Wert, weshalb sich die Netzwerküberwachung zu einem wichtigen IT-Monitoring-Typ entwickelt hat. Einzelne Geräte und Dienste im Netzwerk, darunter Switches, Router, Firewalls und Gateways, stützen sich auf APIs und gemeinsame Kommunikationsprotokolle, um Details zur Konfiguration zu liefern, zum Beispiel Routing- und Weiterleitungstabellen. Monitoring Tools liefern Metriken zur Netzwerkleistung – wie Betriebszeit, Fehler, Bandbreitenverbrauch und Latenz – für alle Subnetze eines komplexen LAN. Es ist eine Herausforderung, ein einziges Netzwerk-Monitoring-Tool zu finden, das alle Netzwerkgeräte abdeckt und die Netzwerkmetriken zu aussagekräftigen Informationen verarbeitet.

Ein weiterer Grund, warum das Netzwerk-Monitoring ein separater Zweig des IT-Monitorings ist, ist die Sicherheit. Ein Netzwerk ist das Straßensystem, das die Daten in einem Unternehmen und zu den Benutzern transportiert. Es ist auch der Hauptangriffspunkt auf die Server und Storage des Unternehmens. Daher ist eine Reihe von Netzwerksicherheits-Tools zur Erkennung und Verhinderung von Eindringlingen, zum Monitoring von Schwachstellen und zur Protokollierung des Zugriffs unerlässlich. Das Konzept der kontinuierlichen Sicherheitsüberwachung beruht auf Automatisierung. Sie verspricht eine End-to-End-Überwachung der Sicherheitsumgebung in Echtzeit und alarmiert die Sicherheitsteams bei potenziellen Sicherheitsverletzungen.

Monitoring der Sicherheit

Neben Leistung und Verfügbarkeit ist die Sicherheit zu einem Hauptziel für IT-Monitoring-Strategien geworden. Sicherheit ist entscheidend für den Schutz von Geschäftsdaten und für die Stärkung der Compliance- und Governance-Position des Unternehmens. Sicherheit hat viele Aspekte, wie zum Beispiel die folgenden:

- Authentifizierung und Autorisierung, um sicherzustellen, dass nur die richtigen Benutzer Zugriff auf die richtigen Ressourcen und Dienste haben.

- Intrusionserkennung und Alarmierung zur Überwachung von ungewöhnlichem Netzwerk-, Anwendungs- und Storage-Verkehr.

- Überprüfung und Abwehr von Malware wie Viren, Spyware und Ransomware.

- Festlegung und Durchsetzung einer vorgeschriebenen Konfigurationsumgebung, um sicherzustellen, dass Systeme und Anwendungen innerhalb einer bekannten, genau definierten Infrastruktur für Sicherheit und Compliance arbeiten – in der Regel als Teil eines umfassenderen Änderungsmanagementprozesses.

Für das Security Monitoring können verschiedene Tools erforderlich sein, um jeden Aspekt abzudecken. So kann beispielsweise ein Tool für die Erkennung und Verhinderung von Eindringlingen eingesetzt werden, während ein anderes Tool für das Monitoring der Authentifizierung und Autorisierung zuständig ist.

Monitoring von Anwendungen und Benutzerfreundlichkeit

Selbst eine perfekt funktionierende Infrastruktur und ein perfekt funktionierendes Netzwerk können anspruchsvolle Anwendungen unzureichend unterstützen, so dass die Benutzer frustriert und unzufrieden sind. Das kann zu vergeudeten Investitionen und Geschäftseinbußen führen. Letztendlich sind für die Benutzer die Verfügbarkeit und die Leistung der Workloads – und nicht die Infrastruktur – ausschlaggebend. Das hat zu zwei relativ neuen Ausprägungen des IT-Monitorings geführt: Application Performance Monitoring (APM) und UX Monitoring.

APM verwendet in der Regel herkömmliche Infrastruktur- und Netzwerk-Monitoring-Tools, um das zugrundeliegende Verhalten der Anwendungsumgebung zu bewerten, sammelt aber auch Metriken, die sich speziell auf die Anwendungsleistung beziehen. Dazu gehören durchschnittliche Latenzzeiten, Latenzzeiten bei Spitzenlast und Engpassdaten wie Verzögerungen beim Zugriff auf eine wichtige Datenbank oder die Zeit, die für die Bearbeitung einer Benutzeranfrage benötigt wird.

Ein Unternehmen, das nachweisen kann, dass die Leistung einer Anwendung innerhalb akzeptabler Parameter liegt und wie erwartet funktioniert, kann seine Governance-Position stärken. Wenn die Leistung einer Anwendung von den akzeptablen Parametern abweicht, können die Verantwortlichen Probleme schnell beheben – oft ohne dass die Benutzer jemals von einem Problem erfahren.

APM hat sich in lokalen Rechenzentren etabliert, aber Public-Cloud-Anbieter offerieren Monitoring Tools – wie Amazon CloudWatch und Azure Monitor – für die anwendungsbezogene Cloud-Überwachung. Unternehmen mit einem starken Public-Cloud-Portfolio benötigen eine Reihe von Cloud Monitoring Tools, die nicht nur die Anwendungsleistung verfolgen, sondern auch die Sicherheit gewährleisten und berechnen, wie effizient die Ressourcen genutzt werden. Zu den gängigen Metriken für Cloud-Anwendungen gehören Ressourcenverfügbarkeit, Antwortzeit, Anwendungsfehler und Netzwerkverkehr.

Eine neuere Version von APM bezieht sich auf Anwendungen, die auf einer Microservices-Architektur basieren, die APIs zur Integration und Kommunikation zwischen einzelnen Diensten nutzt. Solche Architekturen sind besonders schwierig zu überwachen, da Microservices-Container kurzlebig sind und der Schwerpunkt auf LAN-Konnektivität und Leistung liegt. Daher verlassen sich Microservices-Anwendungen oft auf das so genannte semantische Monitoring, um regelmäßige, simulierte Tests innerhalb der Produktionssysteme durchzuführen und dabei Metriken zur Leistung, Verfügbarkeit, Funktionalität und Reaktionszeit der Anwendung zu sammeln.

Das UX-Monitoring ist eng mit APM verwandt, aber die Metriken werden aus der Perspektive der Benutzer erfasst. Eine Metrik für die Reaktionszeit einer Anwendung kann sich beispielsweise auf die Zeit beziehen, die eine Anwendung benötigt, um eine angeforderte Webseite fertigzustellen. Wenn diese Kennzahl niedrig ist, bedeutet das, dass die Anforderung schnell abgeschlossen wurde und der Benutzer mit dem Ergebnis zufrieden war. Je länger die Anfrage dauert, desto unzufriedener ist der Benutzer.

Unabhängig von der Art des Monitorings besteht das Zahl darin, vier wesentliche Fragen zu beantworten:

1. Was ist vorhanden?

2. Funktioniert es?

3. Wie gut funktioniert es?

4. Wie viele Ressourcen werden verbraucht?

IT-Monitoring und DevOps

Mit der Umwandlung von IT-Aktivitäten in einen Geschäftsdienst hat sich die Rolle des IT-Monitoring von einem Infrastrukturschwerpunkt auf IT-Prozesse ausgeweitet, um sicherzustellen, dass Arbeitsabläufe schnell, effizient und erfolgreich ablaufen. Gleichzeitig hat sich die Softwareentwicklung zu einem der wichtigsten IT-Prozesse entwickelt. Agile und kontinuierliche Entwicklungsparadigmen, wie zum Beispiel DevOps, setzen auf schnelle Iterations- und Testzyklen, um die Entwicklung von Softwareprodukten voranzutreiben.

Schnelle zyklische Arbeitsabläufe können mit Engpässen und Verzögerungen behaftet sein, die durch menschliches Versagen, schlecht geplante Prozesse und unzureichende oder ungeeignete Tools verursacht werden. Das Monitoring des DevOps-Workflows ermöglicht es einem Unternehmen, Metriken zur Bereitstellungshäufigkeit, Vorlaufzeit, zum Änderungsvolumen, zu fehlgeschlagenen Bereitstellungen, zum Defekt-/Bug-Volumen, zur durchschnittlichen Zeit bis zur Erkennung/Wiederherstellung, zur Einhaltung von Service Level Agreements (SLA) und zu anderen Schritten und Fehler zu sammeln. Diese Metriken können die DevOps-Effizienz bewahren und gleichzeitig potenzielle Verbesserungsbereiche aufzeigen.

IT-Monitoring-Tools, die in DevOps-Umgebungen eingesetzt werden, konzentrieren sich häufig auf End-to-End-Aspekte der Anwendungsleistung und UX Monitoring. Anstatt einfach nur die Gesamt- oder Nettoleistung zu beobachten, sollen Entwickler und Projektmanager in die vielen Zusammenhänge und Abhängigkeiten rund um die Anwendungsleistung eintauchen können. Das hilft ihnen, die Ursache von Leistungsproblemen zu ermitteln und die Fehlerbehebung zu verbessern.

Es ist zum Beispiel nützlich zu wissen, dass es im Durchschnitt 12 Sekunden dauert, bis eine Benutzeranfrage beantwortet wird. Diese Kennzahl sagt jedoch nichts darüber aus, warum die Aktion so lange dauert. Tools, die die zugrunde liegende Infrastruktur überwachen, könnten aufdecken, dass der Webserver Nummer 18 7,4 Sekunden braucht, um eine Antwort vom Datenbankserver zu erhalten und dass das letztendlich für die inakzeptable Verzögerung verantwortlich ist. Mit einem solchen Einblick können Entwickler und Administratoren die zugrunde liegenden Probleme angehen, um die Anwendungsleistung zu verbessern und zu erhalten.

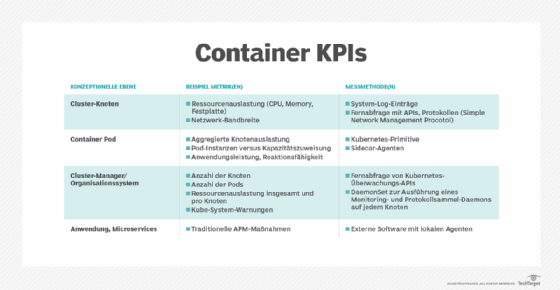

IT-Monitoring und Container

Das IT-Monitoring hat sich auch auf virtualisierte Container ausgeweitet, da viele neue Anwendungen für den Einsatz in Containern konzipiert und entwickelt werden. Das Aufkommen von Containern stellt die IT-Organisationen vor eine Reihe von Herausforderungen bei der Container-Überwachung. Container sind notorisch kurzlebig – sie werden in der Umgebung erzeugt und bleiben nur so lange wie nötig, manchmal nur Sekunden. Container verbrauchen im Vergleich zu VMs relativ wenige Ressourcen, sind aber viel zahlreicher.

Außerdem umfasst eine funktionierende Container-Umgebung eine Reihe von unterstützenden Elementen:

- Container-Hosts

- Container-Engines, wie zum Beispiel Docker oder CRI-O

- Cluster-Orchestrierungs- und Verwaltungssysteme wie Kubernetes

- Service-Routing und Mesh-Dienste

- Paradigmen für die Anwendungsbereitstellung, zum Beispiel Microservices

Zusammengenommen vervielfachen Container die Anzahl der Objekte, die DevOps- und IT-Teams überwachen müssen, wodurch herkömmliche Überwachungs-Setups und Konfigurationsaktivitäten unzureichend werden.

Das Monitoring von Containern umfasst vertraute Metriken wie Ressourcen- und Netzwerkauslastung, aber es gibt noch weitere Metriken, mit denen man sich auseinandersetzen muss, einschließlich Knotenauslastung, Pods im Vergleich zur Kapazität und Kube-Systemwarnungen. Auch die Container-Protokollierung muss überprüft und aktualisiert werden, um sicherzustellen, dass aussagekräftige Protokolldaten von der Anwendung, dem Volume und der Container-Engine zur Analyse gesammelt werden.

Erweiterte IT-Monitoring-Konzepte

Zu den weiteren Fortschritten beim Monitoring der Unternehmens-IT gehören die zunehmende Echtzeitüberwachung und die Trend-/Prädiktivüberwachung. Bei der Echtzeitüberwachung geht es nicht nur darum, dass Agenten gesammelte Daten weiterleiten und Warnmeldungen an IT-Administratoren senden. Das Ziel besteht vielmehr darin, kontinuierliche Echtzeitdaten zu sammeln, zu analysieren und zu nutzen, um fundierte Entscheidungen über unmittelbare Ereignisse zu treffen und Trends im Zeitverlauf zu bewerten. Die Daten werden von der Infrastruktur gesammelt, aber mit zunehmend stabilen und verteilten modernen Infrastrukturen können die von den Anwendungen gesammelten Daten für die IT-Mitarbeiter wertvoller sein.

Bei einer solchen Überwachung wird ein analytischer Ansatz für Warnungen und Schwellenwerte verwendet, wobei Techniken wie die Klassifizierungsanalyse und die Regressionsanalyse eingesetzt werden, um intelligente Entscheidungen über normales und anormales System- und Anwendungsverhalten zu treffen. Bei der Klassifizierungsanalyse werden Datenpunkte in Gruppen oder Clustern organisiert, so dass Ereignisse, die nicht in die Klassifizierung fallen, leicht identifiziert und genauer untersucht werden können. Die Regressionsanalyse trifft im Allgemeinen Entscheidungen oder Vorhersagen auf der Grundlage vergangener Ereignisse oder Verhaltensweisen. Normalverteilungen stellen Ereignisse auf der Grundlage von Wahrscheinlichkeiten dar, um den Mittelwert – den Durchschnitt – und die Abweichungen – die Standardabweichungen – zu bestimmen, so dass auch ungewöhnliche Ereignisse schnell und effektiv gefunden werden können.

Klassifizierungs- und Regressionsanalysen sind auch eng mit dem maschinellen Lernen (ML) und der KI verbunden. Beide Technologien halten Einzug in das IT-Monitoring. ML verwendet gesammelte Daten, um ein Verhaltensmodell zu erstellen, und erweitert und verfeinert das Modell dann im Laufe der Zeit, um genaue Vorhersagen über das Verhalten eines Objekts zu treffen. ML-Technologien haben sich bei IT-Aufgaben wie der Ausfallvorhersage und der vorausschauenden Wartung bewährt. KI und AIOps bauen auf ML auf, um dem ML-Modell Autonomie zu verleihen und die Software in die Lage zu versetzen, auf der Grundlage dynamischer Bedingungen fundierte Entscheidungen zu treffen – und darauf zu reagieren.

Das Netzwerk-Monitoring stellt eine weitere Herausforderung dar. Die häufige Verwendung der herkömmlichen SNMP-Kommunikation (Simple Network Management Protocol) kann in modernen, stark ausgelasteten Netzwerken störend sein. Daher wird eine Art der Echtzeitüberwachung, die so genannte Streaming-Telemetrie, eingesetzt, bei der die Betriebsdaten des Netzwerks an Datensammelpunkte weitergeleitet werden. Das bietet eine bessere Echtzeitüberwachung als SNMP, ohne die Netzwerkgeräte zu stören.

Lesen Sie mehr über IT-Monitoring in unserem Text Wie Sie eine IT-Monitoring-Strategie aufbauen.