aregfly - stock.adobe.com

Verschiedene hyperkonvergente Architekturen im Überblick

Hyper-converged Architekturen lassen sich in zwei Gruppen aufteilen: traditionelle und verteilte Systeme. Erfahren Sie, welche Arten hyperkonvergenter Architekturen verfügbar sind.

Was als eine grundsätzliche Ansammlung von Servern und Speichersystemen begann, hat sich mittlerweile in eine Bandbreite von Optionen aufgespalten. Es geht um die hyper-converged Infrastruktur, die als relativ einfache Zusammenstellung von Elementen auftrat, sich aber mit der Zeit von einer sehr allgemeinen One-Size-Fits-All-Lösung in eine Reihe von Angeboten verwandelte, die auch für Unternehmen von Interesse sind.

Dieser Artikel bietet einen Überblick über diese Entwicklung der hyperkonvergenten Architekturen. Er definiert die verschiedenen verfügbaren Arten von Hyper-converged Infrastructure (HCI), betrachtet alle genauer und stellt die Vor- und Nachteile jeder Variante dar.

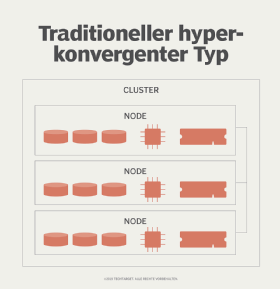

Die ursprüngliche HCI-Architektur hebt die Trennung von Servern und Storage auf, indem alleinstehende Storage-Arrays durch Server – sogenannte Nodes – ersetzt werden, die mit vielen Festplatten bestückt sind. In diesen Konglomeraten entwickelte sich der Storage-Layer von einer unabhängigen Ressource mit getrennten Management-Tools zu einer Instanz, die von einem Hypervisor oder einem anderen softwaredefiniertem Mechanismus abhängig ist.

Die Abbildung 1 zeigt einen traditionellen hyperkonvergenten Cluster mit drei Nodes. Man beachte, dass die Systeme für Storage, Compute und RAM nebeneinander in dem gleichen Server-Node existieren.

Die beiden großen Entscheidungen, die die Käufer dieser frühen HCI-Systeme machen mussten, drehten sich um Folgendes:

- Wie sollte der Speicher verwaltet werden? Wird die hyper-converged Plattform eine Controller Virtual Machine irgendeiner Art benutzen oder würde ein im Kernel integriertes Speicher-Managementsystem zum Einsatz kommen? Im ersten Fall gäbe es eine größere Flexibilität bei der Wahl des Hypervisors, während sich im zweiten Fall zur Zeit etwas mehr an Performance ergeben hätte.

- Hardware oder Software? In diesem Punkt besteht die Wahl darin, entweder ein HCI-System mit einem besonderen Appliance-Formfaktor zu nehmen oder sich nur für ein Stück Software zu entscheiden, das auf bestehenden Servern installiert wird.

Natürlich ist die Frage Hardware oder Software bei Hyperkonvergenz bestehen geblieben, egal um welche Ära es sich bei dieser Technologie handelt und ob sich HCI selbst weiterentwickelt hat. Und natürlich hat sich diese Technologie weiterentwickelt.

Die evolutionäre Aufspaltung bei HCI

Die Entwicklung der Menschen und der Ideen ist nicht immer linear vorangegangen, und in ähnlicher Weise trifft das auch auf die ursprüngliche hyper-converged Architektur zu, die sich weiter von ihrer früheren Art weg entwickelt hat. Obwohl man weiter mit der anfänglichen HCI-Form als wesentlichem Faktor rechnen muss, liefern neuere Varianten interessante Möglichkeiten für die Unternehmen.

Traditionelle HCI-Systeme bestanden noch immer aus miteinander verbundenen Servern und Storage-Arrays, die das Rechenzentrum beherrschten, aber die IT-Hersteller haben viel mehr zu dieser hyperkonvergenten Gleichung hinzugefügt, als was zu Beginn verfügbar war.

Zum Beispiel verfügt Scale Computing mit seiner Scribe-Storage-Verwaltungsschicht über einen besonderen Ansatz bei Hyperkonvergenz. Scribe stellt viele der gleichen Vorteile wie andere HCI-Systeme zur Verfügung, aber nur mit einem Bruchteil des üblichen Ressourcen-Overheads.

Nutanix hat mittlerweile seinen AHV-Hypervisor an die Spitze des Marktes gebracht. Der HCI-Anbieter ermöglicht es Kunden, AHV und vSphere miteinander zu verbinden, um seinen Clustern Storage-Kapazität zur Verfügung zu stellen, ohne dass Lizenzgebühren von Seiten VMwares anfallen.

VMWare ist es gelungen, sich mit seinem vSAN-Angebot schnell ganz vorne bei der Storage-Technologie zu positionieren, indem man zum Beispiel Software-defined Storage (SDS) für verschiedene Typen von HCI-Clustern einschließlich ausgedehnten Clustern zur Verfügung stellt.

Pivot3, einer der HCI-Player mit einem besonderen Ansatz, bietet einen umfassenden NVMe-Datenpfad an, der die Speicher-Performance verbessert. Und Hewlett Packard Enterprise (HPE) liefert Kunden mit SimpliVity eine gemeinsame Lösung für HCI und Data Protection, die besondere Formen von Datenreduktion einschließt.

Und das sind nur ein paar der traditionellen Ansätze von hyper-converged Architekturen.

Neue Entwicklungslinien bei Hyperkonvergenz

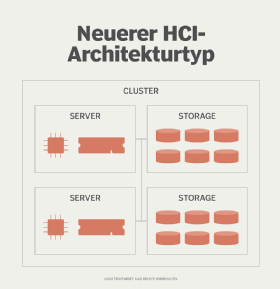

Heute sieht man das Aufkommen einer neuen Klasse von Hyperkonvergenzsystemen, die von manchen als verteilte HCI-Systeme bezeichnet werden. Andere bevorzugen den Titel „Tier 1 hyper-convergence“ für diese neue Gruppe. Wie auch immer man sie nennen will, diese neueren hyper-converged Architekturen sehen unterschiedlich aus.

In diesen HCI-Plattformen sind Server und Storage erneut physisch getrennte Einheiten. Sie sind mit einem Software-Layer miteinander verbunden, der sie als ein einziges Element erscheinen lässt – was zumindest theoretisch betrachtet so stimmt.

Die Hersteller, die diesen neuen Weg einer hyperkonvergenten Architektur gewählt haben – Datrium, NetApp und seit neuestem HPE mit seiner auf Nimble basierenden dHCI-Plattform –, wollen die Kunden damit wieder in den Stand versetzen, Compute und Storage unabhängig voneinander skalieren zu können. Mit dieser Praxis negieren diese Unternehmen, was eine gängige Klage über HCI bei einigen Anwendern war, aber in den Augen anderer Anwender als ein wesentlicher Vorteil der linearen Skalierbarkeit von HCI galt.

Die ursprüngliche HCI-Technologie skalierte alle Ressourcen im gleichermaßen. Wenn man zum Beispiel Speicher hinzufügte, fügte man auch RAM- und Compute-Komponenten hinzu, ob man sie nun brauchte oder nicht. Diese auf den neuen Entwicklung der HCI-Architektur beruhende HCI-Systeme sehen eher wie traditionelle Infrastrukturansätze aus als ihre direkten Verwandten.

Die passende hyperkonvergente Architektur auswählen

Welche HCI-Variante ist nun die richtige für das eigene Unternehmen? Das hängt von den jeweiligen Anforderungen ab. Wer eine besondere Einfachheit sucht, der findet sie in der ursprünglichen hyper-converged Architektur im Überfluss. Wer mehr Flexibilität bei den Ressourcen braucht, der findet bei den neueren Architekturvarianten eher das Richtige für ihn.

Man sollte seine Workloads und die vorhandenen Ressourcen überprüfen und sich Proofs of Concept und Testinstallationen von seinen HCI-Lieferanten besorgen. Dann wird es nicht schwer fallen, die richtigen Entscheidungen für die eigenen Workloads und das eigene Unternehmen zu treffen.