Getty Images

Sieben Anwendungen für die Optimierung der Datenqualität

Tools für das Datenqualitätsmanagement unterstützen bei der Automatisierung und Schließung von Lücken in den Datenprozessen. Hier sind sieben der besten Tools auf dem Markt.

Mit Tools für das Datenqualitätsmanagement lassen sich viele der Prozesse automatisieren, die erforderlich sind, um sicherzustellen, dass die Daten in den Bereichen Analyse, Datenwissenschaft und maschinelles Lernen für den jeweiligen Zweck geeignet sind. Unternehmen müssen das Tool finden, das am besten geeignet ist, um bestehende Datenpipelines zu bewerten, Qualitätsengpässe zu identifizieren und verschiedene Abhilfeschritte zu automatisieren.

Zu den Prozessen, die mit der Sicherstellung der Datenqualität verbunden sind, gehören Data Profiling, die Verfolgung der Datenherkunft und Datenbereinigung. Insgesamt kann es sinnvoll sein, ein Tool oder eine Reihe von Tools zu identifizieren, das/die mit den bestehenden Datenpipeline-Workflows des Unternehmens übereinstimmt/übereinstimmen. Kurzfristig ist es manchmal hilfreich, spezifische Lücken oder Herausforderungen im Datenqualitätsprozess zu identifizieren.

„Es ist am besten, sich zunächst darauf zu konzentrieren, welche Tools und Systeme ersetzt werden müssen“, sagt Jeff Brown, Teamleiter für BI-Projekte bei Syntax, einem Anbieter von Managed Services.

Zunächst wird gemeinsam mit den Teams ermittelt, was sich am stärksten auf die Verbesserung der datengesteuerten Kultur auswirken wird.

„Zu den wichtigsten Überlegungen gehören die Gesamtkosten, die Auditierbarkeit, die einfache Einrichtung von Richtlinien und Standards, der Schulungsaufwand für die Nutzung des Tools, die Skalierbarkeit des Tools, um mit den zunehmenden und sich weiterentwickelnden Datenquellen Schritt zu halten, und die Benutzerfreundlichkeit“, sagt Terri Sage, CTO von 1010data, einem Anbieter von analytischer Intelligenz für den Finanz-, Einzelhandels- und Verbrauchermarkt.

Gemeinsamkeiten und Unterschiede der Tools

Jedes Datenqualitäts-Tool hat seine eigenen Funktionen und Arbeitsabläufe. Die meisten Tools verfügen über Funktionen für Data Profiling, Bereinigung und Standardisierung von Daten.

Die Funktionen zur Profilerstellung, Messung und Visualisierung von Daten helfen den Teams, das Format und die Werte des erfassten Datensatzes zu verstehen. Diese Tools weisen auf Ausreißer und Mischformate hin. Data Profiling dient als Filter zur Qualitätsverbesserung in der Datenanalyse-Pipeline.

„Mit den richtigen Profiling-Tools können Sie viel über die Qualität Ihrer Daten erfahren“, sagt Christophe Antoine, Vice President of Global Solutions Engineering bei Talend, einer Open-Source-Datenintegrationsplattform.

Datenstandardisierungsfunktionen helfen dabei, inkonsistente Datenformate, Werte, Namen und Ausreißer in den aktuellen Datensätzen zu identifizieren. Dann können sie eine Standardisierung, wie zum Beispiel einen Adressvalidator, eine Musterprüfung, einen Formatierer oder eine Datenbank mit Synonymen, auf die Datenpipeline anwenden, um immer einen standardisierten Wert zurückzugeben. Dies ist hilfreich, wenn die gleichen Daten auf unterschiedliche Weise eingegeben werden.

Datenbereinigungsfunktionen unterstützen dabei, strukturelle Probleme zu beheben, Ausreißer zu entfernen, fehlende Datenfelder aufzufüllen und sicherzustellen, dass Pflichtfelder korrekt ausgefüllt werden. Die Datenbereinigung kann teuer sein, da sie zusätzliche Stunden und Werkzeuge erfordert. „Suchen Sie nach Tools, die Lücken in den bestehenden Arbeitsabläufen schließen können“, sagt Sage.

Parsing-Funktionen helfen dabei, Daten in ihre Bestandteile zu zerlegen. Dies unterstützt dabei, die Ursache von Datenqualitätsproblemen zu ermitteln und nachgelagerte Datensätze zu kennzeichnen, wenn in einer Datenpipeline Probleme auftreten.

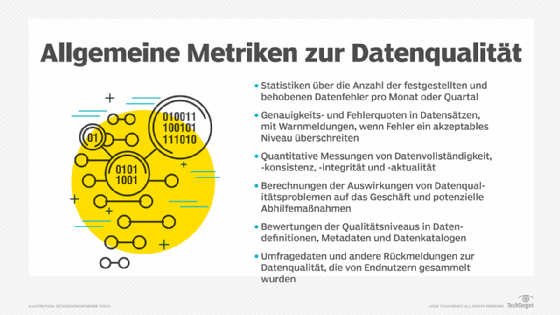

Überwachungsfunktionen verfolgen Datenqualitätsmetriken. Wenn Probleme entdeckt werden, können sie das Datenmanagementteam darauf aufmerksam machen, dass diese Probleme früher untersucht werden müssen, da sie dann leichter zu beheben sind.

Hier sind sieben der besten Tools für das Datenqualitätsmanagement:

Ataccama One Data Quality Suite

Ataccama wurde 2007 gegründet, um die von Adastra, einer Datenanalyse- und KI-Plattform, selbst entwickelten Datenaufbereitungstools zu vermarkten. Ataccama hat sich darauf spezialisiert, Rohdaten in wiederverwendbare Datenprodukte umzuwandeln, die verschiedene KI-, Analyse- und Betriebsaufgaben in einem Unternehmen unterstützen. Ein wichtiger Aspekt dabei ist die Sicherstellung der Datenqualität für große Datenpipelines durch selbststeuernde Funktionen für automatische Datenklassifizierung, automatische Datenqualität und Dokumentation der Zugriffsrichtlinien.

Zu den Freemium-Datenqualitäts-Tools gehören Ataccama Data Quality Analyzer und Ataccama One Profiler. Das Unternehmen hat außerdem ein umfangreiches Set von KI-Tools für die Erkennung von Datenanomalien, die Erstellung neuer Datenqualitätsregeln und die Automatisierung verschiedener Datenqualitätsprozesse entwickelt. Obwohl diese Tools viele Aspekte der Datenqualität rationalisieren können, kann dies für Unternehmen, die Prozesse verwenden, die außerhalb bestehender Workflows ablaufen, zusätzlichen Aufwand bedeuten.

IBM InfoSphere Information Server for Data Quality

Im Laufe der Jahre hat IBM umfangreiche Datenqualitätsanwendungen entwickelt, um seine verschiedenen Angebote für Unternehmensdatenbanken zu ergänzen. Zu den aktuellen Tools gehören IBM InfoSphere Information Server for Data Quality für die Datenqualität, IBM InfoSphere QualityStage für Datenbereinigung und -standardisierung und IBM Watson Knowledge Catalog für KI-Metadatenmanagement. Die InfoSphere-Tools gehören zu den älteren Angeboten von IBM.

Watson Knowledge Catalog ist ein neueres Angebot, das verspricht, die Qualitätsaspekte von KI- und Machine-Learning-Workflows innerhalb einer einzigen Plattform zu rationalisieren. Dieser Ansatz verspricht, Workflows zu harmonisieren, die sich traditionell über mehrere Data-Science-, ModelOps- und Datenmanagement-Tools erstreckten.

Informatica Data Quality

Informatica kann auf eine lange Geschichte der Datentransformation und Datenqualität zurückblicken. Die aktuelle Produktpalette umfasst eine Reihe von Datenqualitäts-Tools, darunter Informatica Data Quality, Informatica Cloud Data Quality, Informatica Axon Data Governance, Informatica Data Engineering Quality und Informatica Data as a Service.

Jedes Tool konzentriert sich auf unterschiedliche Aspekte der Datenqualität. Dank dieser breiten Angebotspalette kann das Tool-Ensemble verschiedene Anwendungsfälle unterstützen. Die umfangreichen Cloud-Funktionen bieten Unternehmen außerdem die Möglichkeit, die Datenqualität bei der Migration zu hybriden oder Cloud-nativen Datenmanagementlösungen sicherzustellen. Allerdings haben die Cloud-Tools im Vergleich zu den On-Premises-Versionen noch Nachholbedarf bei den verfügbaren Funktionen.

Darüber hinaus vereinfacht Informatica die Datenqualität als Teil moderner KI- und Machine-Learning-Workflows. Das Unternehmen unterstützt auch ein umfangreiches Angebot an Metadatenmanagement-, Datenkatalogisierungs- und Data-Governance-Funktionen, die mit seinen Datenqualitätsfunktionen abgestimmt sind.

Precisely Trillium Quality

Precisely ist der moderne Name für einen Anbieter von Datentransformations-Tools, den es seit den späten 1960er Jahren gibt. Das Unternehmen wurde als Whitlow Computer Systems gegründet und konzentrierte sich auf Datentransformation. In den 1980er Jahren wurde es in Syncsort umbenannt und 2020 in Precisely. Jeder neue Markenname steht für eine Verlagerung der aktuellen Anforderungen der Branche und neue Technologien.

Kürzlich wurde Infogix mit seinen Datenqualitäts-, Governance- und Metadatenfunktionen übernommen. Zu den aktuellen Datenqualitätsangeboten gehören Precisely Trillium Quality, Precisely Spectrum Quality und Precisely Data360. Eine große Stärke ist ein umfangreicher Satz von Geokodierungs- und Geodatenstandardisierungs- sowie Anreicherungsfunktionen. Es ist erwähnenswert, dass die Tools zusammen mit ihren Anbietern separat erworben wurden. Daher müssen Unternehmen möglicherweise zusätzliche Integrationskosten für Workflows einplanen, die diese verschiedenen Tools umfassen.

SAP Data Intelligence

SAP ist der etablierte Marktführer im Bereich ERP-Software, einer datenintensiven Anwendung. Das Unternehmen hat eine Vielzahl von Datenqualitätsfunktionen erworben oder entwickelt, um seine Kernplattform zu verbessern. Zu den aktuellen Datenqualitätsangeboten gehören SAP Information Steward, SAP Data Services und SAP Data Intelligence Cloud.

Mit der Entwicklung der intelligenten ERP-Plattform S/4HANA hat das Unternehmen viele bedeutende Plattformveränderungen für seine Kernangebote vorgenommen. Mit SAP Data Intelligence Cloud vollzieht es nun einen ähnlichen Wandel hin zu Datenqualitätsfunktionen der nächsten Generation. Dieses neuere Angebot zentralisiert den Zugang zu Datenqualitätsfunktionen in lokalen und Cloud-Umgebungen. Es unterstützt Datenintegration, Governance, Metadatenmanagement und Datenpipelines.

Mehrere Anwendungen von Drittanbietern erweitern ebenfalls die zentralen Datenqualitätsangebote von SAP. Teams sollten diese Tools von Drittanbietern in Betracht ziehen, um die Datenqualität zu verbessern, insbesondere wenn sie mit Daten außerhalb der SAP-Plattform arbeiten.

SAS Data Quality

SAS ist seit langem einer der führenden Anbieter von Analyse-Tools. Mitte der 1960er Jahre brachte das Unternehmen seine ersten Analysewerkzeuge auf den Markt, die sich ständig weiterentwickeln, da es seine Kernwerkzeuge erweitert hat, um fast jeden Aspekt der Datenaufbereitungspipeline, einschließlich der Datenqualität, zu verwalten.

Das Kernangebot für Datenqualität ist SAS Data Quality. Es arbeitet mit einer ganzen Reihe ergänzender Werkzeuge zusammen, wie SAS Data Management, SAS Data Loader for Hadoop, SAS Data Governance und SAS Data Preparation. Die Datenqualitätswerkzeuge sind ohne zusätzliche Kosten in SAS Viya, eine Plattform für KI, Analytik und Datenmanagement in der Cloud, integriert. Dies unterstützt dabei, die Datenqualitätsaspekte verschiedener Data-Science-Workflows zu optimieren.

Das Unternehmen bietet auch die SAS Quality Knowledge Base an, die verschiedene Datenqualitätsfunktionen wie Extraktion, Musteranalyse und Standardisierung bereitstellt. Die im SAS Event Stream Processing Serviceenthaltenen Echtzeit-Qualitätsverbesserungen können verschiedene Datenbereinigungsaufgaben für Datenströme von IoT-Geräten, -Operationen oder -Drittquellen durchführen.

Talend Data Fabric

Talend wurde 2006 als Open-Source-Anbieter für Datenintegration gegründet. Das Unternehmen entwickelte eine umfangreiche Bibliothek von Tools für Datenintegration, Datenaufbereitung, Anwendungsintegration und Stammdatenmanagement. Zu den aktuellen Freemium-Angeboten für Datenqualität gehören Talend Open Studio for Data Quality und Talend Data Preparation Free Desktop. Weitere Angebote sind Talend Data Catalog und Talend Data Fabric.

Talend Data Catalog unterstützt dabei, verschiedene Aspekte der Dateninventarisierung und des Metadatenmanagements zu automatisieren. Talend Data Fabric rationalisiert Datenqualitätsprozesse als Teil automatisierter Datenpipelines mit Unterstützung für Datenaufbereitung, Datenanreicherung und Datenqualitätsüberwachung. Diese Tools werden häufig in Verbindung mit anderen Datenanalyse- und Data-Science-Tools eingesetzt.