cookiecutter - Fotolia

Sicherheit und Systemaufbau definieren den idealen Server

Bei der Wahl der passenden Server sollten Unternehmen Faktoren wie Sicherheitsfunktionen, den Systemaufbau und die genutzten Workloads berücksichtigen.

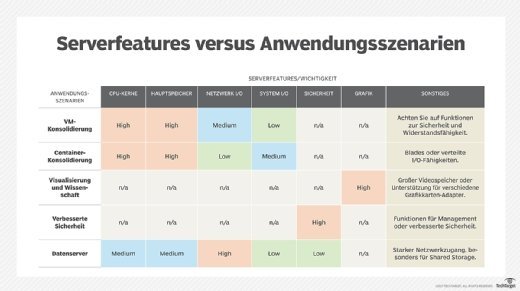

Bei der Auswahl eines Server-Systems gilt es mehrere Faktoren zu berücksichtigen. Dazu zählt beispielsweise, ob in einem Rechenzentrum die Konsolidierung von Virtual Machines (VM) und Containern ansteht oder ob der Server im Bereich Virtualisierung oder für wissenschaftliche Berechnungen eingesetzt werden soll.

Bei der Anschaffung von Servern spielt nicht alleine der Faktor Sicherheit eine Rolle. Dennoch sollten in den meisten Fällen entsprechende Funktionen berücksichtigt werden. Sie betreffen den Schutz von Servern, das Erkennen von IT-Sicherheitsrisiken sowie die Wiederherstellung (Recovery) der Systemumgebung. Moderne Sicherheitsfunktionen gehen weit über das hinaus, was herkömmliche Trusted Platform Modules (TPM) bieten.

So stellen besonders sichere Serversysteme eine hardwarebasierte „Root of Trust“ bereit. Sie nutzt eine Validierung der Hardware. Diese erfolgt über eine Server-Management-Plattform, etwa einen integrierten Remote Access Controller von Dell (iDRAC), sowie eine Server-Firmware beim Booten des Systems. Diese Validierung schließt typischerweise den Einsatz kryptografischer Signaturen mit ein. Dies stellt sicher, dass nur freigegebene Firmware-Versionen und Treiber auf dem Serversystem laufen.

Auch Updates von Treibern und Firmware werden im Normalfall signiert, um die Authentizität der Quelle sicherzustellen. Solche Validierungen lassen sich in regelmäßigen Abständen durchführen, auch dann, wenn ein Server monatelang nicht neu gebootet wurde. Um Daten zu schützen, die übermittelt werden („in flight“) oder auf dem System gespeichert sind („Data at Rest“), unterstützen immer mehr Server-CPUs zudem eine Verschlüsselung auf der Prozessor-Ebene.

„Lockdown“ schützt Firmware und Konfiguration

Immer mehr Server sind in der Lage, nicht autorisierte oder unerwartete Änderungen an Firmware-Images und den entsprechenden Konfigurationseinstellungen festzustellen. Ist das der Fall, können die Systeme einen Sperr-Mechanismus („Lockdown“) aktivieren. Er verhindert, dass unerwünschte Änderungen vorgenommen werden. Außerdem kann eine Warnmeldung an die zuständigen Administratoren ausgegeben werden, wenn eine Manipulation der Firmware erfolgt.

Hinzu kommt ein weiterer Sicherheitsmechanismus bei Serversystemen: Eine durchgängige Protokollierung von Ereignissen. Ein solches Event Logging erfasst und dokumentiert alle Aktivitäten und speichert die entsprechenden Informationen so ab, dass sie nicht gelöscht oder nachträglich verändert werden können.

Server können zudem auf diverse Recovery-Funktionen zurückgreifen. Ein Beispiel ist die automatische Wiederherstellung von BIOS- und Firmware-Versionen. Sie wird dann aktiv, wenn das Serversystem feststellt, dass der Firmware-Programmcode Fehler enthält oder kompromittiert wurde. In diesem Fall spielt der Server die letzte Firmware-Version ein, die als funktionsfähig und sicher gilt. Einige Systeme sind außerdem in der Lage, das Betriebssystem zurückzusetzen, etwa dann, wenn bösartige Aktivitäten entdeckt wurden.

Eine weitere Sicherheitsfunktion von Servern ist das Löschen von Daten, speziell aller Hardware-Konfigurationsinformationen. Dazu zählen BIOS- und Diagnose-Daten, Informationen über die Management-Konfigurationen sowie Daten in nichtflüchtigen Cache-Speichern und auf internen SD-Karten. Ein solches Löschen ist vor allem dann wichtig, wenn ein Serversystem für andere Aufgaben eingesetzt werden soll oder ausgemustert wird.

Bei Datenservern die Netzwerk-I/O-Prozesse im Auge behalten

File- oder Datenserver sind in vielen unterschiedlichen Ausführungen und Größen im Einsatz, je nach den Anforderungen des jeweiligen Anwenders. Ein solcher Server verfügt meist nur über eine relativ geringe Rechenleistung. Der Grund ist, dass File-Server nur selten in großem Maßstab Daten verarbeiten oder komplexe Berechnungen durchführen, die eine hohe Prozessorleistung und viel Arbeitsspeicher erfordern.

Webserver dagegen können über größere Ressourcen verfügen. Etwa dann, wenn auf dem System Code oder Backend-Anwendungen wie Datenbanken ausgeführt werden. Anders ist die Lage, wenn mehrere Datenserver mithilfe von Virtualisierung auf einem einzelnen physischen System zusammengefasst werden sollen. Dann ist eine detailliertere Analyse der Anforderungen an Prozessor und Arbeitsspeicher erforderlich.

Allerdings ist bei Datenservern eine andere Eigenschaft wichtiger: die Netzwerk-I/O-Leistung. Sie spielt beim Zugriff auf zentrale oder gemeinsam genutzte Storage-Ressourcen eine wichtige Rolle. Dasselbe ist bei Webinhalten der Fall, auf die gleichzeitig viele User zugreifen. In solchen Szenarien sind Netzwerkengpässe an der Tagesordnung.

Mehr Wahlfreiheit durch viele Ausstattungsvarianten

Bei einem Server mit internen Massenspeichern (Festplatten, SSDs) können die Art und Kapazität der Disks einen erheblichen Einfluss auf die Performance beim Zugriff auf die Speicherressourcen sowie die Widerstandfähigkeit gegen Fehlfunktionen („Resilience“) haben. Datenserver lassen sich beispielsweise mit einem 10-Gigabit-Ethernet-Port oder mit mehreren 1-Gigabit-Schnittstellen ausrüsten. Ist der Server mit 1-Gigabit-Ports ausgestattet, kann ein Netzwerkverwalter mehrere dieser Anschlüsse bündeln, um die Datenrate zu erhöhen und eine bessere Resilience zu erzielen.

Wie viele Ausstattungsvarianten vorhanden sein können, zeigt folgendes Beispiel: Ein Rack-Server der Reihe Dell EMC PowerEdge R430 verfügt in der Standardversion über zwei Prozessorsockel, 16 Gigabyte RAM und vier 1-Gigabit-Ethernet-Ports. Hinzu kommt eine SATA-III-Festplatte (Serial Advance Technology Attachment) mit einer 6-GBit/s-Schnittstelle, 1 Terabyte Speicherkapazität, und einer Drehzahl von 7.200 U/min.

Allerdings lässt sich das R430-Chassis mit unterschiedlichen Festplatten bestücken, etwa mit bis zu zehn „Hot-Pluggable“-SCSCI-, SATA- und Nearline-SAS-Platten (Serial-Attached SCSI). Eine weitere Option sind Solid-State Drive (SSDs). Auch der Netzwerkdurchsatz kann erhöht werden – mit diversen PCIe-Netzwerkadaptern (Peripheral Component Interconnect Express) und Storage-Hostbus-Adaptern (HBA).

Viele Server oder ein Highend-System mit mehreren CPUs

Viele Rechenzentren schrumpfen, weil dank Virtualisierung, schnelleren Netzwerktechniken und anderen Technologien Serversysteme mehr Workloads verkraften. Steht die Anschaffung von Servern an, führt das zu folgendem Dilemma: Serversysteme versus Prozessoren. Das heißt, IT-Fachleute stehen vor der Frage, ob es besser ist, mehr Server zu haben oder aber weniger Systeme, die dafür mit mehr Prozessoren ausgestattet sind.

Weniger Systeme mit höherer Leistung und besserer Ausstattung können die Kapitalkosten reduzieren. Zudem wird weniger Platz im Rechenzentrum benötigt; auch der Aufwand für die Kühlung sinkt.

Mehr Workloads auf wenigen Systemen können jedoch ein höheres Risiko mit sich bringen. Denn fällt ein Server aus oder muss er gewartet werden, tangiert dies auch eine größere Zahl von Workloads. Der Einsatz von Clustern oder das Erstellen von Snapshots für eine schnelle Wiederherstellung helfen dabei, die Folgen solcher Ausfallzeiten zu minimieren. Dennoch sollte ein Unternehmen die richtige Balance finden, zwischen der passenden Zahl von Servern sowie der Ausstattung und Leistung dieser Systeme. Dies gilt unabhängig davon, für welchen Zweck die Server eingesetzt werden.

Folgen Sie SearchDataCenter.de auch auf Twitter, Google+, Xing und Facebook!