llhedgehogll - stock.adobe.com

Phishing mit Deepfakes: Unternehmen müssen sich vorbereiten

Ob der Vorgesetzte am Telefon Wünsche äußert, oder der Kunde per Video um Änderungen bittet. Phishing-Angriffe mit Deepfakes haben für Unternehmen ein hohes Gefahrenpotenzial.

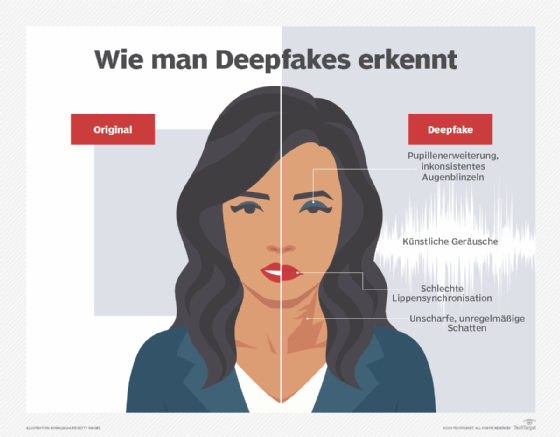

Cyberkriminalität im Zusammenhang mit Deepfakes nimmt zu, da Kriminelle KI nutzen, um ahnungslose Opfer, darunter auch Anwender in Unternehmen, zu täuschen und zu betrügen. Deepfakes verwenden Deep Learning, eine Kategorie der KI, die auf neuronalen Netzen basiert, um synthetische Bild-, Video- und Audioinhalte zu generieren.

Deepfakes können zwar auch für harmlose Zwecke verwendet werden, doch Cyberkriminelle erstellen sie in erster Linie, um ihre Opfer dazu zu verleiten, ihnen Zugang zu digitalen und finanziellen Vermögenswerten zu gewähren. Laut einer Umfrage des Ponemon Institute gaben 41 Prozent der Sicherheitsexperten im Jahr 2025 an, dass Deepfake-Kampagnen kürzlich Führungskräfte in ihren Unternehmen ins Visier genommen hatten. Das Center for Financial Services von Deloitte warnte kürzlich ebenfalls, dass die finanziellen Verluste durch generative KI bis 2027 40 Milliarden US-Dollar erreichen könnten, gegenüber 12,3 Milliarden US-Dollar im Jahr 2023.

Da Deepfake-Technologie immer überzeugender und leichter zugänglich wird, müssen CISOs proaktive Maßnahmen ergreifen, um ihre Unternehmen und Anwender vor Betrug zu schützen.

Wie sich Unternehmen gegen Deepfake-Angriffe verteidigen können

Während Angreifer zeitnah damit begonnen haben, die Deepfake-Technologie zu ihrem Vorteil zu nutzen, zeigen Untersuchungen, dass die Abwehrfähigkeiten von Unternehmen hinterherhinken. Nur 12 Prozent verfügen beispielsweise über Schutzmaßnahmen zur Erkennung und Abwehr von Deepfake-Voice-Phishing, und nur 17 Prozent haben laut einer Umfrage von Verizon (PDF) aus dem Jahr 2025 Schutzmaßnahmen gegen KI-gesteuerte Angriffe implementiert.

Es ist von entscheidender Bedeutung, dass CISOs die folgenden wichtigen Schritte unternehmen, um synthetische KI-Angriffe zu identifizieren und abzuwehren.

1. Gute organisatorische Cyberhygiene praktizieren

Wie so oft tragen grundlegende Maßnahmen zur Cyberhygiene wesentlich zum Schutz vor neuen und sich weiterentwickelnden Bedrohungen bei, darunter auch Deepfake-Phishing-Angriffe.

- Authentifizierung. Bewerten Sie die Wirksamkeit bestehender Authentifizierungssysteme und das Risiko, das synthetische KI für biometrische Sicherheitskontrollen darstellt.

- Identitäts- und Zugriffsmanagement. Verwalten Sie die Identitäten der Endbenutzer sorgfältig. Deaktivieren Sie beispielsweise umgehend die Identitäten ehemaliger Mitarbeiter und beschränken Sie deren Zugriffsrechte auf die Ressourcen, die sie für ihre Arbeit benötigen.

- Verhinderung von Datenverlusten und Verschlüsselung. Stellen Sie sicher, dass geeignete Richtlinien, Verfahren und Kontrollen zum Schutz sensibler und wertvoller Daten vorhanden sind.

2. Defensive KI-Tools in Betracht ziehen

Obwohl die defensive KI-Technologie noch in den Kinderschuhen steckt, integrieren einige Anbieter bereits Deepfake-Erkennungsfunktionen auf Basis von maschinellem Lernen in ihre Tools und Dienste. Security-Verantwortliche sollten die verfügbaren Angebote im Auge behalten, da sie in den kommenden Monaten und Jahren wahrscheinlich schnell wachsen und sich verbessern werden.

Alternativ können Unternehmen mit ausreichenden Ressourcen interne KI-Modelle entwickeln und trainieren, um synthetische Inhalte anhand von technischen und verhaltensbezogenen Basiswerten, Mustern und Anomalien zu bewerten und zu erkennen.

3. Schulungen zum Sicherheitsbewusstsein intensivieren

Auch wenn sich die Technologie weiterentwickelt, bleibt der erste und wichtigste Schritt zur Phishing-Prävention derselbe: Sensibilisierung. Die synthetische KI hat sich jedoch so rasant verbessert, dass viele Endnutzer sich der folgenden Punkte noch immer nicht bewusst sind:

- Wie überzeugend Deepfake-Inhalte mittlerweile sind. In einem viel beachteten Deepfake-Phishing-Fall nahm ein Mitarbeiter an einem Videoanruf teil, an dem angeblich der CFO des Unternehmens sowie mehrere andere Mitarbeiter teilnahmen. Alle waren Deepfake-Imitationen, und die Betrüger konnten den Mitarbeiter erfolgreich dazu verleiten, 25 Millionen US-Dollar auf ihre Konten zu überweisen.

- Wie Cyberkriminelle Deepfakes einsetzen, um Einzelpersonen und Organisationen zu bedrohen und deren Ruf zu schädigen. Böswillige Hacker können schädliche Deepfake-Inhalte erstellen, die Unternehmensmitarbeiter bei strafbaren Handlungen zeigen. Anschließend könnten sie versuchen, Mitarbeiter zu erpressen, um Zugang zu Unternehmensressourcen zu erhalten, die Organisation zur Zahlung eines Lösegelds zu erpressen oder die gefälschten Inhalte zu verbreiten, um den Ruf und den Aktienwert des Unternehmens zu untergraben.

- Wie Kriminelle gestohlene Daten und Deepfakes kombinieren. Kriminelle kombinieren häufig gestohlene Identitätsdaten wie Benutzernamen und Passwörter mit KI-generierten Bildern und geklonten Stimmen, um sich als echte Benutzer auszugeben und die Multifaktor-Authentifizierung (MFA) zu umgehen. Anschließend greifen auf bestehende Geschäfts- und Privatkonten zu, eröffnen neue Konten und vieles mehr.

Da sich Social-Engineering- und Phishing-Bedrohungen mit der Geschwindigkeit der KI weiterentwickeln, verändert sich die Bedrohungslage mittlerweile jedes Jahr so stark, dass man sich nicht mehr ausschließlich auf jährliche Schulungen zum Thema Cybersicherheit verlassen kann. Vor diesem Hintergrund sollten CISOs regelmäßig Informationen über neue Taktiken verbreiten, mit denen Kriminelle ahnungslose Opfer manipulieren, und ihren Mitarbeitern Anleitungen für den Fall solcher Angriffe an die Hand geben.