pressmaster - stock.adobe.com

Inline-Deduplizierung passt gut zu hyper-converged IT

Inline-Deduplizierung ist bei hyper-converged Appliances verbreitet. Sie funktioniert besser als Post-Process-Deduplizierung und eignet sich besonders für Flash-basierte Systeme.

Inline-Deduplizierung wird schnell zu einem Standard-Feature von hyper-converged Appliances.

Die Daten-Deduplizierung hilft einem hyper-konvergenten System dabei, seinen internen Speicher effizienter auszunutzen. Inline-Deduplizierung hilft auch, Verschleiß- und Performance-Probleme zu vermeiden, die im Allgemeinen mit Post-Process-Deduplizierung verbunden werden.

Eine hyper-converged Infrastructure (HCI) unterscheidet sich vor allem darin von anderen Computerplattformen, dass sie über voll integrierte Systeme verfügt. In der Regel enthält eine hyper-converged Appliance ihre eigenen Ressourcen für Compute, Storage und Hypervisor-Software.

Wenn eine Appliance über ihren eigenen Speicher verfügt, bringt das zwar beträchtliche Vorteile, aber auch mindestens einen Nachteil. Weil es eine physikalische Obergrenze für die Anzahl von Platten in einer hyper-converged Appliance gibt, wird es immer nur einen bestimmten Speicherplatz für Workloads in diesem System geben.

Die Storage-Ressourcen müssen deshalb effizient genutzt werden, um eine volle Auslastung zu vermeiden. Eine der besten Möglichkeiten, Plattenplatz einzusparen, besteht darin, redundante Daten durch den Einsatz von Deduplizierung zu löschen.

Optionen für Deduplizierung

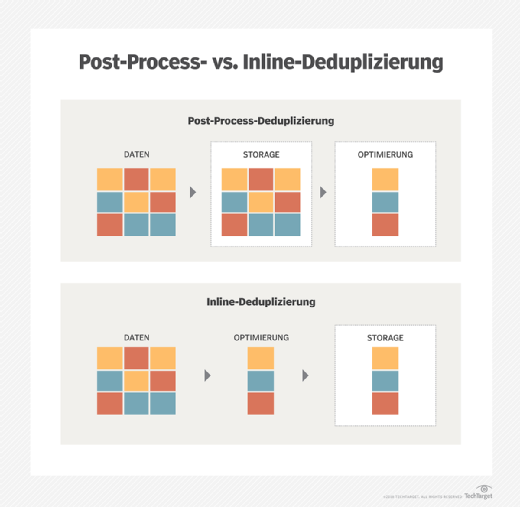

Deduplizierung wird gewöhnlich entweder als Inline oder als Post-Process eingestuft, obwohl es hybride Dedup-Methoden gibt, die beide Arten miteinander vermischen. Inline-Deduplizierung löscht redundante Daten in Echtzeit, bevor diese auf eine Platte geschrieben werden können.

Die typischste Methode bei Inline-Deduplizierung benützt Hash-Kennungen, die vor der Speicherung an die Daten angeheftet werden. Die Deduplizierungs-Software vergleicht die Daten, die gespeichert werden sollen, mit den bereits vorhandenen Hash-Werten: Alle Daten, die mit diesen Hashes übereinstimmen, werden nicht an den Speicher gesandt.

Umgekehrt werden bei der Post-Process-Deduplizierung alle Daten auf die Platte geschrieben, wobei sie alle überprüft und redundante Daten zu einem späteren Zeitpunkt entfernt werden. Im Prinzip wird der gleiche auf Hash-Kennungen gestützte Prozess durchgeführt, aber erst nachdem alle Daten gespeichert worden sind. Alle neuen Daten mit übereinstimmenden Hash-Werten werden gelöscht.

Warum Post-Process wohl nicht das Richtige für HCI ist

Sowohl Inline- als auch Post-Process-Deduplizierung sind in der Lage, redundante Daten zu löschen und dadurch die Storage-Auslastung zu verbessern. Aber wenn es sich um hyper-converged Appliances handelt, dann ist Inline-Deduplizierung wahrscheinlich die bessere Option.

Es sind vor allem zwei Gründe, warum Post-Process-Deduplizierung wohl nicht die beste Wahl für HCI-Appliances ist. Erstens, Post-Process-Deduplizierung geht über die Bühne, nachdem die redundanten Daten bereits auf den Speicher der Appliance geschrieben sind. Das bedeutet, dass die Vorteile von Deduplizierung nicht unmittelbar wirksam werden, weil die Appliance die Daten erst in ihrem nicht-deduplizierten, also größeren Zustand ablegen muss – und dafür genügend Kapazität vorhalten muss, die ansonsten gar nicht gebraucht wird.

Zweitens geht es um die Art und Weise, in der viele Appliances die Daten speichern. Hyper-converged Appliances benutzen im Allgemeinen zwei Speicherebenen. Ein Highspeed Tier besteht aus Flash Storage, und ein High Capacity Tier beruht auf konventionellen Festplatten.

Der Tier für Highspeed Storage hat hauptsächlich zwei Funktionen zu erfüllen: Dieser Tier dient erstens als Read Cache. Hot Data – Daten, die vor kurzem benutzt worden sind – werden automatisch in dem Highspeed Tier abgelegt, so dass sie schneller gelesen werden können, als wenn sie sich auf dem High Capacity Tier befinden würden. Zweitens dient der Highspeed Storage Tier manchmal auch als ein Write-Zwischenspeicher. Neu erzeugte Daten werden auf den Highspeed Tier geschrieben und dann später auf den High Capacity Tier verschoben. Dieser Ansatz verhindert, dass Schreiboperationen einen I/O-Flaschenhals verursachen.

Werden Flash-Medien als Write Cache benutzt, bedeutet das, dass jeder Schreibvorgang zu einem Programm-Lösch-Zyklus führt. Wird Deduplizierung als Post-Process durchgeführt, dann könnte das bedeuten, dass redundante Daten auf Flash Storage geschrieben werden, falls Flash für die Landing Zone benutzt wird, nur um dann später wieder gelöscht zu werden. Ein solcher Prozess verkürzt die Lebensdauer der Flash-Medien in der Appliance. Wird dagegen Inline-Deduplizierung eingesetzt, werden die Daten bereits dedupliziert, bevor sie überhaupt auf den Gerätespeicher geschrieben werden.

Außerdem ist Post-Process-Deduplizierung ein I/O-intensiver Vorgang. Abhängig von der Auslastung des Servers und zu welchem Zeitpunkt der Deduplizierungs-Prozess eingeplant ist, kann die Post-Process-Deduplizierung die Performance der Appliance negativ beeinflussen. Bei der Inline-Deduplizierung ist dies unproblematisch.

Folgen Sie SearchStorage.de auch auf Twitter, Google+, Xing und Facebook!