arthead - stock.adobe.com

Generative KI-Sicherheitsrisiken in Unternehmen vorbeugen

Trotz ihrer Vorteile stellt generative KI Unternehmen vor zahlreiche Sicherheitsprobleme. Prüfen Sie diese möglichen Bedrohungen und bewährte Verfahren zur Risikominderung.

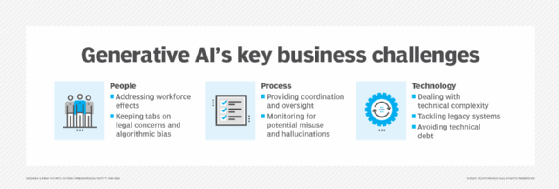

Die rasche Übernahme generativer KI-Modelle nach der Einführung von ChatGPT verändert die Art und Weise, wie Unternehmen Geschäfte machen und mit Kunden und Lieferanten interagieren.

Generative KI kann eine breite Palette von Geschäftsanforderungen unterstützen, zum Beispiel das Schreiben von Marketinginhalten, die Verbesserung des Kundendienstes, die Generierung von Quellcode für Softwareanwendungen und die Erstellung von Geschäftsberichten. Die zahlreichen Vorteile generativer KI-Tools – insbesondere die Kostenreduzierung und die Verbesserung der Arbeitsgeschwindigkeit und -qualität – haben Unternehmen und Einzelanwender gleichermaßen dazu ermutigt, die Fähigkeiten solcher Tools bei ihrer Arbeit zu testen.

Wie bei jeder aufkommenden Technologie kann eine schnelle Implementierung jedoch riskant sein und Bedrohungsakteuren die Tür öffnen, um die Schwachstellen von Unternehmen auszunutzen. In der komplexen IT-Bedrohungslandschaft von heute kann der unbedachte Einsatz von generativen KI-Tools katastrophale Folgen für Unternehmen haben.

Sicherheitsrisiken bei der Verwendung generativer KI in Unternehmensumgebungen

Das Verständnis der potenziellen Risiken beim Einsatz generativer KI im Unternehmenskontext ist entscheidend, um von dieser Technologie zu profitieren und gleichzeitig die Einhaltung gesetzlicher Vorschriften zu gewährleisten und Sicherheitsverletzungen zu vermeiden. Beachten Sie folgende Risiken, wenn Sie den Einsatz generativer KI planen.

1. Mitarbeiter, die sensible Arbeitsinformationen preisgeben

In Unternehmensumgebungen sollten Benutzer mit allen Daten, die sie mit anderen teilen, vorsichtig sein – auch mit ChatGPT und anderen KI-gesteuerten Chatbots.

Ein bemerkenswerter aktueller Vorfall ist das Datenleck, das von Samsung-Mitarbeitern verursacht wurde, die sensible Daten mit ChatGPT geteilt haben. Ingenieure bei Samsung luden vertraulichen Quellcode auf das ChatGPT-Modell hoch und nutzten den Dienst außerdem, um Besprechungsnotizen zu erstellen und Geschäftsberichte mit sensiblen arbeitsbezogenen Informationen zusammenzufassen.

Der Fall Samsung ist nur Beispiel für die Weitergabe vertraulicher Informationen an KI-gestützte Chatbots. Viele andere Unternehmen und Mitarbeiter, die generative KI-Tools verwenden, können ähnliche Fehler machen und sensible Arbeitsinformationen wie internen Code, urheberrechtlich geschützte Inhalte, Geschäftsgeheimnisse, persönlich identifizierbare Informationen (PII) und vertrauliche Geschäftsinformationen preisgeben.

Die Standardrichtlinie von OpenAI für ChatGPT sieht vor, die Aufzeichnungen der Benutzer 30 Tage lang aufzubewahren, um sie auf möglichen Missbrauch zu überwachen, selbst wenn ein Benutzer den Chatverlauf deaktiviert hat. Für Unternehmen, die ChatGPT in ihre Geschäftsprozesse integrieren, bedeutet dies, dass die ChatGPT-Konten der Mitarbeiter sensible Informationen enthalten können. Ein Bedrohungsakteur, der erfolgreich die ChatGPT-Konten von Mitarbeitern kompromittiert, kann also potenziell auf alle sensiblen Daten zugreifen, die in den Anfragen dieser Benutzer und den Antworten der KI enthalten sind.

2. Sicherheitsschwachstellen in KI-Tools

Wie jede andere Software können auch generative KI-Tools Schwachstellen aufweisen, die Unternehmen Cyberbedrohungen aussetzen.

Im März nahm OpenAI beispielsweise ChatGPT offline, um einen Fehler in der Open-Source-Bibliothek des Chatbots zu beheben, der es einigen Nutzern ermöglicht hatte, Chat-Titel aus dem Chat-Verlauf eines anderen aktiven Nutzers zu sehen. Es war auch möglich, die erste Nachricht einer neu erstellten Unterhaltung im Chatverlauf eines anderen Benutzers zu sehen, wenn beide Benutzer etwa zur gleichen Zeit aktiv waren.

Darüber hinaus enthüllte derselbe Fehler die Zahlungsinformationen von 1,2 Prozent der ChatGPT Plus-Abonnenten, die während eines bestimmten Zeitraums aktiv waren, einschließlich des Vor- und Nachnamens, der E-Mail-Adresse und der letzten vier Ziffern der Kreditkartennummer. Bei einem anderen Vorfall fand das Cybersicherheitsunternehmen Group-IB vor kurzem mehr als 100.000 kompromittierte ChatGPT-Konten, die auf Darknet-Marktplätzen zum Verkauf angeboten wurden.

3. Datenvergiftung und Datendiebstahl

Generative KI-Tools müssen mit riesigen Datenmengen gefüttert werden, damit sie richtig funktionieren. Diese Trainingsdaten stammen aus verschiedenen Quellen, von denen viele im Internet öffentlich zugänglich sind – und in einigen Fällen können sie auch frühere Interaktionen eines Unternehmens mit Kunden enthalten.

Bei einem Data-Poisoning-Angriff könnten Bedrohungsakteure die Pre-Trainingsphase der Entwicklung des KI-Modells manipulieren. Indem sie bösartige Informationen in den Trainingsdatensatz einschleusen, können die Angreifer das Vorhersageverhalten des Modells im weiteren Verlauf beeinflussen, was zu falschen oder anderweitig schädlichen Reaktionen führt.

Ein weiteres datenbezogenes Risiko besteht darin, dass Bedrohungsakteure den Datensatz stehlen, der zum Trainieren eines generativen KI-Modells verwendet wird. Ohne ausreichende Verschlüsselung und Kontrolle des Datenzugriffs können alle sensiblen Informationen, die in den Trainingsdaten eines Modells enthalten sind, für Angreifer sichtbar werden, die sich den Datensatz beschaffen.

4. Verstöße gegen Compliance-Verpflichtungen

Beim Einsatz von KI-gesteuerten Chatbots in Unternehmensumgebungen sollten IT-Verantwortliche folgende Risiken im Zusammenhang mit der Verletzung einschlägiger Vorschriften bewerten:

- Falsche Antworten. KI-Tools geben manchmal falsche oder oberflächliche Antworten. Wenn Kunden irreführende Informationen erhalten, können sie rechtlich haftbar gemacht werden und der Ruf des Unternehmens wird negativ beeinflusst.

- Datenlecks. Mitarbeiter können während der Konversation mit einem KI-Chatbot sensible Arbeitsinformationen weitergeben, einschließlich personenbezogener Daten oder geschützter Gesundheitsinformationen (PHI) von Kunden. Dies wiederum kann gegen regulatorische Standards wie EU-DSGVO, PCI DSS und HIPAA verstoßen, wodurch Geldstrafen und rechtliche Schritte riskiert werden.

- Voreingenommenheit. Die Antworten von KI-Modellen zeigen manchmal Voreingenommenheit aufgrund von Rasse, Geschlecht oder anderen geschützten Merkmalen.

- Verstoß gegen Gesetze zum Schutz des geistigen Eigentums und des Urheberrechts. KI-gestützte Tools werden anhand riesiger Datenmengen trainiert und sind in der Regel nicht in der Lage, spezifische Quellen für ihre Antworten anzugeben. Einige dieser Trainingsdaten können urheberrechtlich geschütztes Material wie Bücher, Zeitschriften und akademische Journale enthalten. Die Verwendung von KI-Ergebnissen, die auf urheberrechtlich geschützten Werken basieren, ohne diese zu zitieren, kann für Unternehmen zu Geldstrafen führen.

- Gesetze zur Nutzung von Chatbots. Viele Unternehmen haben damit begonnen, ChatGPT und andere generative KI-Tools in ihre Anwendungen zu integrieren. Einige nutzen KI-gesteuerte Chatbots, um Kundenanfragen sofort zu beantworten. Wenn Sie dies jedoch tun, ohne Ihre Kunden im Voraus zu informieren, riskieren Sie Strafen aufgrund lokaler gesetzlicher Vorschriften.

- Datenschutz. Einige Unternehmen möchten unter Umständen eigene generative KI-Modelle entwickeln, ein Prozess, der wahrscheinlich das Sammeln großer Mengen von Trainingsdaten erfordert. Wenn Bedrohungsakteure erfolgreich in die IT-Infrastruktur des Unternehmens eindringen und sich unbefugt Zugang zu den Trainingsdaten verschaffen, kann die daraus resultierende Offenlegung sensibler Informationen, die in den kompromittierten Datensätzen enthalten sind, gegen Datenschutzgesetze verstoßen.

Best Practices beim Einsatz generativer KI-Tools im Unternehmen

Um den zahlreichen Sicherheitsrisiken zu begegnen, die mit generativer KI verbunden sind, sollten Unternehmen bei der Implementierung generativer KI-Tools folgende Strategien beachten.

1. Klassifizieren, anonymisieren und verschlüsseln Sie Daten, bevor Sie generative KI erstellen oder integrieren

Unternehmen sollten ihre Daten klassifizieren, bevor sie sie an Chatbots weitergeben oder zum Trainieren generativer KI-Modelle verwenden. Legen Sie fest, welche Daten für diese Anwendungsfälle akzeptabel sind, und geben Sie keine weiteren Informationen an KI-Systeme weiter.

Anonymisieren Sie auch sensible Daten in Trainingsdatensätzen, um die Preisgabe sensibler Informationen zu vermeiden. Verschlüsseln Sie Datensätze für KI-Modelle und alle Verbindungen zu ihnen und schützen Sie die sensibelsten Daten des Unternehmens mit robusten Sicherheitsrichtlinien und -kontrollen.

2. Schulen Sie Ihre Mitarbeiter zu den Sicherheitsrisiken generativer KI und erstellen Sie interne Nutzungsrichtlinien.

Die Schulung der Mitarbeiter ist die wichtigste Schutzmaßnahme, um das Risiko generativer KI-bezogener Cyberangriffe zu mindern. Um generative KI verantwortungsvoll einzusetzen, müssen Unternehmen ihre Mitarbeiter über die mit der Nutzung dieser Technologie verbundenen Risiken aufklären.

Unternehmen können Richtlinien für den Einsatz generativer KI am Arbeitsplatz aufstellen, indem sie eine Richtlinie für Sicherheit und akzeptable Nutzung entwickeln. Auch wenn die Einzelheiten von Unternehmen zu Unternehmen variieren, ist es eine allgemeine bewährte Praxis, menschliche Aufsicht zu verlangen. Vertrauen Sie nicht automatisch auf von KI generierte Inhalte. Menschen sollten alles, was KI-Tools erstellen, überprüfen und bearbeiten.

In den KI-Nutzungs- und Sicherheitsrichtlinien sollte auch ausdrücklich erwähnt werden, welche Daten in die Anfragen an Chatbots aufgenommen werden können und welche nicht erlaubt sind. So sollten Entwickler beispielsweise niemals geistiges Eigentum, urheberrechtlich geschütztes Material, personenbezogene Daten oder vertrauliche Informationen in KI-Tools einspeisen.

3. Prüfen Sie generative KI-Tools auf ihre Sicherheit

Führen Sie Sicherheits-Audits und regelmäßige Penetrationstests mit generativen KI-Tools durch, um Sicherheitsschwachstellen zu identifizieren, bevor Sie sie in der Produktion einsetzen.

Sicherheitsteams können KI-Tools auch darin trainieren, Angriffsversuche zu erkennen und abzuwehren, indem sie sie mit Beispielen von Cyberangriffen füttern. Dadurch verringert sich die Wahrscheinlichkeit, dass ein Hacker die KI-Systeme des Unternehmens erfolgreich ausnutzt.

4. Regeln Sie den Zugang Ihrer Mitarbeiter zu sensiblen Arbeitsdaten

Wenden Sie in Unternehmensumgebungen das Prinzip der minimalen Rechtevergabe an und ermöglichen Sie nur autorisierten Mitarbeitern den Zugriff auf KI-Trainingsdatensätze und die zugrunde liegende IT-Infrastruktur.

Der Einsatz eines Identitäts- und Zugriffsmanagementsystems kann dabei unterstützen, die Zugangsdaten und -rechte der Mitarbeiter zu zentralisieren und zu kontrollieren. Ebenso kann die Implementierung einer Multifaktor-Authentifizierung dazu beitragen, KI-Systeme und den Datenzugriff zu schützen.

5. Stellen Sie sicher, dass die zugrunde liegenden Netzwerke und die Infrastruktur sicher sind

Setzen Sie KI-Systeme in einem eigenen Netzwerksegment ein. Die Verwendung eines separaten Netzwerksegments mit eingeschränktem Zugriff zum Hosten von KI-Tools erhöht sowohl die Sicherheit als auch die Verfügbarkeit.

Unternehmen, die KI-Tools in der Cloud hosten, sollten einen seriösen Cloud-Anbieter auswählen, der strenge Sicherheitskontrollen durchführt und über gültige Compliance-Zertifizierungen verfügt. Stellen Sie sicher, dass alle Verbindungen zur und von der Cloud-Infrastruktur verschlüsselt sind.

6. Behalten Sie die Compliance-Anforderungen im Auge, einschließlich regelmäßiger Audits bei den Anbietern

Compliance-Vorschriften entwickeln sich ständig weiter, und mit der zunehmenden Einführung von KI in Unternehmen werden Unternehmen wahrscheinlich mehr Compliance-Anforderungen im Zusammenhang mit generativer KI-Technologie sehen.

Unternehmen sollten die für ihre Branche geltenden Compliance-Vorschriften genau auf Änderungen in Bezug auf den Einsatz von KI-Systemen überwachen. Wenn Sie KI-Tools eines Drittanbieters verwenden, sollten Sie in diesem Zusammenhang regelmäßig die Sicherheitskontrollen und Schwachstellenbewertungen des Anbieters überprüfen. So können Sie sicherstellen, dass Sicherheitslücken in den Systemen des Anbieters nicht in die IT-Umgebung des Unternehmens gelangen.