metamorworks - stock.adobe.com

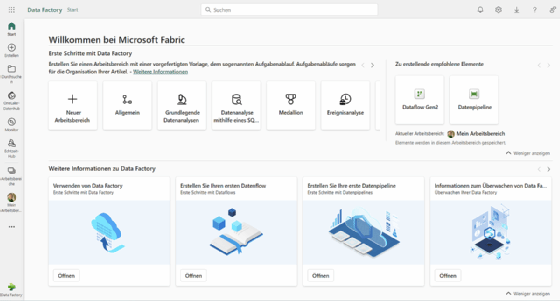

Einheitliches Datenmanagement mit Microsoft Fabric und OneLake

Microsoft Fabric vereint Datenverarbeitung, Analyse und Speicherung in einer Plattform. Mit OneLake werden Silos eliminiert und der Zugriff auf Unternehmensdaten zentralisiert.

Microsoft Fabric vereint verschiedene bisher getrennte Tools wie Power BI, Data Factory und andere Data Science-Anwendungen in einer gemeinsamen Plattform. Dies ermöglicht Unternehmen, eine ganzheitliche Lösung für ihre Datenprojekte zu nutzen, die sowohl Datenverarbeitung, -analyse als auch -visualisierung in einer Umgebung vereint. Alle Komponenten von Fabric greifen dabei auf OneLake zu, einem zentralen Speicher für strukturierte und unstrukturierte Daten.

In vielen Unternehmen besteht das Problem, dass verschiedene Abteilungen mit unterschiedlichen Analyse-Tools arbeiten, sei es Apache Spark, Datenbanken oder spezifische Analyse-Engines. Jede Abteilung erstellt eigene Datenkopien oder führt Transformationen durch, um Daten für die eigenen Tools in ein geeignetes Format zu bringen. Das führt nicht nur zu unnötigen Datenreplikationen, sondern auch zu veralteten Datenkopien, die über verschiedene Systeme verteilt sind. Das Management dieser isolierten Datenbestände ist aufwendig und anfällig für Fehler. Daten bleiben oft in veralteten Zuständen, und es gibt keine zentrale Übersicht oder Governance, die sicherstellt, dass alle Abteilungen auf dieselben, aktuellen Informationen zugreifen.

Die Stärke von Microsoft Fabric liegt in der Integration und Vereinfachung komplexer Datenprozesse. Statt Daten zwischen verschiedenen Systemen zu kopieren und zu synchronisieren, wird alles zentral in OneLake gespeichert und verwaltet. Dies erleichtert nicht nur die Zusammenarbeit zwischen verschiedenen Abteilungen, sondern minimiert auch die Risiken von Datenverlusten oder -duplikaten. Gleichzeitig ermöglicht Fabric durch die Nutzung offener Standards den flexiblen Zugriff auf Daten durch verschiedene Analyse-Tools und sorgt so für Interoperabilität.

Microsoft Fabric wurde entwickelt, um die Herausforderungen der fragmentierten Datenlandschaften in großen Organisationen zu bewältigen. Traditionell speichern Unternehmen ihre Daten in verschiedenen Silos, die von unterschiedlichen Abteilungen mit unterschiedlichen Tools und Formaten verwaltet werden. Diese Silos führen zu mehrfachen Datenkopien, veralteten Informationen und aufwendigen Prozessen zur Transformation und Konsolidierung der Daten. Microsoft Fabric soll diese Probleme eliminieren, indem es alle Datenverarbeitungs- und Analyseanforderungen eines Unternehmens abdeckt, von der Speicherung in einem Data Lake und Data Warehouse bis hin zu Echtzeitanalysen und Business Intelligence (BI).

Microsoft Fabric und OneLake führen Datenanalyse auf neue Ebene

Microsoft Fabric bietet mit der Einführung von OneLake eine zentrale Lösung für diese Herausforderungen. OneLake dient als zentrales Daten-Repository für das gesamte Unternehmen.

Das Besondere an OneLake ist seine Fähigkeit, nicht nur strukturierte Daten, wie sie in klassischen Data Warehouses gespeichert sind, zu verwalten, sondern auch unstrukturierte Daten wie Bilder oder Dokumente. Durch die Nutzung von offenen Standards wie dem Delta-Format können diese Daten flexibel über verschiedene Anwendungen hinweg genutzt werden. Diese Interoperabilität zwischen SQL, Spark und anderen Analysewerkzeugen ermöglicht eine nahtlose Integration von OneLake in bestehende Arbeitsprozesse. Da alle Daten in OneLake gespeichert werden, entfällt die Notwendigkeit, unterschiedliche Speicherkonten oder Datenkopien für verschiedene Engines zu erstellen.

Jeder Tenant, also jede Organisation, erhält automatisch ein OneLake, sobald Microsoft Fabric verwendet wird. Alle innerhalb von Microsoft Fabric erstellten Objekte, seien es Data Warehouses, Lakehouses oder Echtzeit-Analysen, werden automatisch in OneLake integriert. Dadurch wird sichergestellt, dass sämtliche Unternehmensdaten zentral in einem Namespace zusammengeführt werden und so Governance- und Sicherheitsrichtlinien einfacher angewendet werden können.

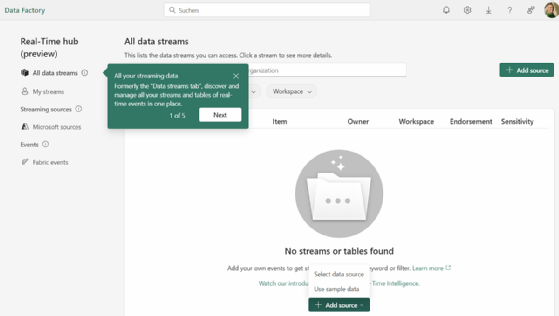

Echtzeit-Intelligenz in Microsoft Fabric

Microsoft Fabric bietet die Möglichkeit, Echtzeit-Daten effizient zu verarbeiten und für Analysen bereitzustellen. Kern dieser Funktionalität ist der Real-Time Hub, der als zentrale Stelle dient, um Echtzeit-Datenströme zu verwalten, zu sichern und zu katalogisieren. Dies erleichtert nicht nur die Entdeckung von Datenströmen innerhalb eines Unternehmens, sondern auch die Integration und Analyse von IoT- sowie Bestands- und Auftragsdaten in Echtzeit.

Ein wesentlicher Vorteil dieser Architektur liegt in der Möglichkeit, automatisierte Aktionen basierend auf Echtzeit-Daten zu initiieren. Unternehmen können auf Echtzeit-Signale reagieren, indem sie automatische Warnmeldungen oder Workflows auslösen, sobald bestimmte Schwellenwerte erreicht werden. Diese Automatisierung, kombiniert mit der Fähigkeit, Datenströme aus verschiedenen Quellen wie IoT-Sensoren oder Datenbanken zu integrieren, erlaubt es, datengetriebene Entscheidungen schneller und präziser zu treffen. Microsoft Fabric verbindet zudem bestehende Systeme mit Echtzeit-Datenquellen und gestaltet damit Prozesse dynamischer und reaktionsfähiger.

Mit dem Event House als Ziel für Datenströme können große Datenmengen in Echtzeit effizient verarbeitet und mit KQL-Datenbanken analysiert werden. Die neuen Funktionen, wie Eventstream-Verbinder für Quellen wie Apache Kafka und Azure SQL MI CDC, ermöglichen eine nahtlose Integration von Datenströmen. Zudem wurden im September 2024 das Dashboard-Design sowie die Anomalieerkennung und Multi-Variant-Analyse in Echtzeit verbessert.

Datenformate und Interoperabilität in Microsoft Fabric

Ein entscheidender Vorteil von Microsoft Fabric ist die standardisierte Nutzung des Delta-Parquet-Formats zur Speicherung von Daten. Delta-Parquet kombiniert die Vorteile von effizienten Parquet-Dateien mit einer Delta-Log-Schicht, die eine vollständige Versionierung und Transaktionssicherheit (AKID/ACID) gewährleistet.

Parquet-Dateien bieten ein spaltenbasiertes Speicherformat, das für effiziente Datenkompression und schnelle Abfragen optimiert ist. In Microsoft Fabric werden diese Dateien durch eine Delta-Log-Schicht erweitert, die sämtliche Änderungen und Metadaten erfasst. Diese Kombination aus Parquet-Dateien und Delta-Log erlaubt nicht nur die Speicherung großer Datenmengen, sondern auch eine vollständige Versionierung und ACID-Compliance. Durch die Delta-Log-Schicht können Nutzer auf ältere Datenversionen zugreifen, ohne redundante Kopien erstellen zu müssen, was die Verwaltung und Analyse von Daten vereinfacht.

Diese Standardisierung bedeutet, dass alle Engines in Microsoft Fabric, darunter SQL, Spark, KQL (Kusto Query Language) und Power BI, das gleiche Datenformat lesen und schreiben können, ohne dass Daten zwischen verschiedenen Formaten transformiert werden müssen. Dies beseitigt die Notwendigkeit von Kopien oder aufwendigen ETL-Prozessen (Extract, Transform, Load), die typischerweise erforderlich sind, wenn unterschiedliche Tools auf denselben Datenbestand zugreifen.

Ein wichtiger Aspekt ist die Möglichkeit der Zeitreise durch die Daten. Da Delta-Log sämtliche Änderungen an den gespeicherten Daten aufzeichnet, kann man zu einem früheren Zustand der Daten zurückkehren, ohne dass separate Datenkopien oder Snapshots erforderlich sind. Dies ist nützlich, wenn Audits notwendig sind oder historische Daten abgefragt werden müssen.

VertiPaq Engine und V-Ordering

Zusätzlich zum Delta-Parquet-Formats hat Microsoft Fabric eine entscheidende Optimierung in Form der VertiPaq Engine und V-Ordering integriert. Die VertiPaq Engine und V-Ordering in Microsoft Fabric bieten Leistungssteigerungen für datenintensive Workloads.

VertiPaq, ursprünglich aus Power BI bekannt, optimiert die Abfragegeschwindigkeit durch spaltenbasierte Kompression und effizientes In-Memory-Management. V-Ordering ergänzt dieses Konzept, indem es die Daten bereits beim Schreiben in Parquet-Dateien so anordnet, dass spätere Abfragen optimal unterstützt werden. Diese Kombination sorgt dafür, dass besonders lese-intensive Workloads, wie Abfragen in SQL oder Power BI, in Echtzeit ausgeführt werden können. Die Kombination dieser Technologien ermöglicht es, Daten effizient zu speichern und gleichzeitig die Lese-Performance zu steigern, was für große Datenmengen in Unternehmensumgebungen von entscheidender Bedeutung ist.

Medallion-Architektur in Microsoft Fabric

Die Medallion-Architektur in Microsoft Fabric bietet eine stufenweise Verbesserung der Datenverwaltung, indem sie in drei logische Schichten unterteilt wird: Bronze, Silber und Gold. Diese Architektur, auch als Multihop-Architektur bekannt, dient der schrittweisen Verbesserung der Datenqualität und Struktur.

In der Bronze-Schicht werden Rohdaten nahezu unverändert und in ihrer ursprünglichen Form gespeichert. Dies gestattet die Speicherung großer, unstrukturierter Datenmengen direkt aus verschiedenen Quellen, ohne sofortige Transformationsschritte vornehmen zu müssen. Diese Schicht agiert als zuverlässige Quelle für spätere Verarbeitungsschritte und garantiert, dass keine wichtigen Informationen verloren gehen.

Die Silber-Schicht steht für die Datenbereinigung und -transformation. Hier werden die Rohdaten so aufbereitet, dass sie konsistenter und für analytische Zwecke besser nutzbar sind. Transformationen wie Datentypkonvertierungen, das Entfernen von Duplikaten oder das Hinzufügen von fehlenden Werten finden in dieser Phase statt. Diese Schicht reduziert die Datenkomplexität und bereitet sie für tiefergehende Analysen oder Modelle vor. Zudem wird die Datenkonsistenz in der gesamten Organisation durch standardisierte Prozesse gesichert.

Die Gold-Schicht ist die finale Schicht und enthält die hochgradig optimierten Daten, die für spezifische Geschäftsanalysen oder Berichte verwendet werden. Diese Schicht ist für die Endanwender gedacht, wie etwa Datenanalysten oder Entscheidungsträger, die auf präzise und performante Daten für Berichte oder Dashboards angewiesen sind. Hier sind die Daten maximal aggregiert, bereinigt und für spezifische Geschäftsanforderungen maßgeschneidert, wodurch schnelle und aussagekräftige Einblicke möglich sind.

Durch die Kombination der Medallion-Architektur mit den in Microsoft Fabric integrierten Technologien wie Spark und Delta Lake wird die Verarbeitung großer Datenmengen und die Datenqualität über alle Stufen hinweg optimiert. Die Medallion-Architektur erlaubt es Unternehmen, komplexe Datenpipelines zu automatisieren und ihre Datenbestände schrittweise zu verfeinern, um so immer präzisere und wertvollere Erkenntnisse zu gewinnen.

Fabric Capacities: Flexible Skalierung

Ein weiterer zentraler Bestandteil von Microsoft Fabric sind die Fabric Capacities. Diese Kapazitäten stellen die Rechenleistung und den Speicher bereit, die für verschiedene Workloads benötigt werden. Eine Fabric Capacity wird in der Regel innerhalb eines Azure-Abonnements erstellt und kann flexibel skaliert werden. Besonders interessant ist die Möglichkeit des Burstings, bei dem kurzfristig mehr Rechenleistung zur Verfügung gestellt werden kann, als ursprünglich bereitgestellt wurde. Dies ist besonders nützlich, wenn in Spitzenzeiten mehr Kapazität benötigt wird, ohne dass dauerhaft hohe Kapazitäten eingekauft werden müssen. Sobald die Last wieder sinkt, wird die zusätzliche Kapazität ausgeglichen, was die Gesamtkosten für die Datennutzung optimiert.

Die Flexibilität der Fabric Capacities zeigt sich auch darin, dass Unternehmen verschiedene Kapazitäten für unterschiedliche Teams oder Projekte einrichten können. Diese Kapazitäten können nach Bedarf pausiert und wieder aufgenommen werden, was ebenfalls dazu beiträgt, die Kosten zu kontrollieren. Die Nutzung der Kapazitäten wird minutengenau abgerechnet, sodass Unternehmen verfolgen können, welche Workloads welche Ressourcen in Anspruch nehmen.

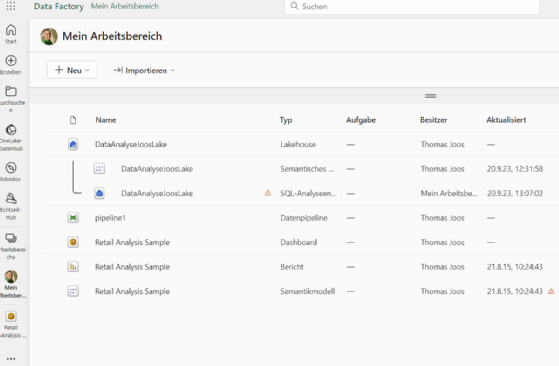

Workspaces und Governance

In Microsoft Fabric erfolgt die Organisation der Daten und Workloads über Workspaces. Ein Workspace ist ein Container, der verschiedene Datenobjekte wie Lakehouses, Data Warehouses oder Notebooks enthält. Diese Workspaces sind direkt mit einer Fabric Capacity verknüpft und bieten eine granulare Steuerung der Zugriffsrechte und Sicherheitsrichtlinien. So kann sichergestellt werden, dass unterschiedliche Teams innerhalb eines Unternehmens nur auf die Daten zugreifen können, die für sie relevant sind, während dennoch alle Daten innerhalb desselben OneLake gespeichert werden.

Ein Workspace bietet somit nicht nur eine organisatorische Trennung, sondern erlaubt auch eine gezielte Verwaltung von Berechtigungen und Governance-Richtlinien. Innerhalb eines Workspaces können Administratoren festlegen, welche Benutzer auf welche Datenobjekte zugreifen dürfen, und sicherstellen, dass die Einhaltung von Compliance-Anforderungen, wie etwa der EU-Datenschutz-Grundverordnung (EU-DESGVO), zentral überwacht wird.

Datenintegration und Shortcuts

Microsoft Fabric erleichtert die Integration externer Datenquellen. Mit Shortcuts können Daten aus externen Speichern wie AWS S3, Google Cloud Storage oder anderen Azure-Data-Lake-Konten eingebunden werden, ohne dass die Daten physisch in OneLake kopiert werden müssen. Diese symbolischen Links ermöglichen es, Daten in Fabric zu verwenden, ohne die bestehenden Datenpipelines in anderen Systemen zu beeinträchtigen. Das bedeutet, dass Unternehmen flexibel bleiben und ihre bereits etablierten Datenstrukturen beibehalten können, während sie dennoch die Vorteile von Microsoft Fabric nutzen.

Eine weitere Option zur Integration von Daten aus externen Systemen ist das Mirroring. Dabei werden Daten aus Systemen wie Azure SQL Database, Snowflake oder Cosmos DB in Echtzeit in Fabric repliziert und in das Delta-Parquet-Format umgewandelt. Dadurch können auch Daten, die in proprietären Formaten vorliegen, innerhalb von Microsoft Fabric genutzt werden, ohne dass aufwendige Transformationen erforderlich sind. Diese Mirroring-Funktion ist praktisch, um Daten aus bestehenden Legacy-Systemen in die neue Plattform zu überführen, ohne dass diese vollständig migriert werden müssen.

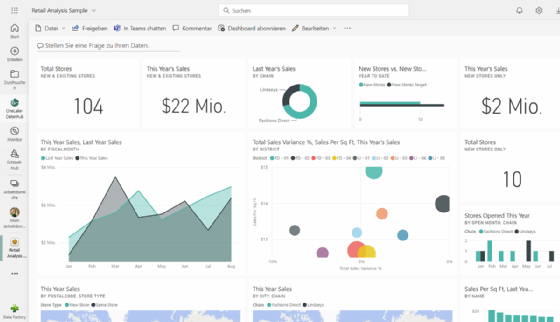

Power BI und DirectLake

Eine der größten Verbesserungen in Microsoft Fabric ist die Integration von Power BI in die Plattform. Traditionell mussten Power BI-Datenmodelle entweder in den Arbeitsspeicher importiert oder über DirectQuery abgefragt werden, was zu Performance-Problemen führen konnte. Mit der Einführung des DirectLake-Modells entfällt die Notwendigkeit von Datenimporten. Power BI kann nun direkt auf die im Delta-Parquet-Format gespeicherten Daten in OneLake zugreifen, ohne dass eine Zwischenschicht zur Übersetzung von Abfragen benötigt wird. Dies führt zu einer Verbesserung der Abfragegeschwindigkeit und ermöglicht es, auch sehr große Datenmengen in nahezu Echtzeit zu analysieren.

Ein weiterer Vorteil von DirectLake ist die Option, Datenmodelle dynamisch zu aktualisieren, ohne dass die gesamte Struktur neu geladen werden muss. Dies ermöglicht es Unternehmen, auf Änderungen in den zugrunde liegenden Datenquellen schnell zu reagieren und Berichte in Echtzeit zu aktualisieren.

Künftige Erweiterungen und Roadmap

Zukünftige Funktionen wie die Unterstützung für Private Link auf Workspace-Ebene, zusätzliche Metadatenformate wie Iceberg oder erweiterte KI-Funktionen sind bereits in der Planung. Insbesondere die Unterstützung von Private Link soll Unternehmen künftig ermöglichen, ihre Microsoft Fabric-Workloads sicherer in ihre bestehenden Netzwerkarchitekturen zu integrieren.