Siarhei - stock.adobe.com

DPUs und SmartNICs: Unterschiede und Nutzen erklärt

Geht es um Big Data, passen die herkömmlichen Speicherumgebungen oft nicht mehr. Neuere Technik nutzt SmartNICs und Hyperscale-DPUs. Doch welche Technik ist wann die richtige Wahl?

Umgebungen nach Schema F sind für viele Unternehmen nicht mehr angemessen, insbesondere für solche, die große Datenmengen verarbeiten. SmartNICs sind für einige Unternehmen die richtige Wahl, andere hingegen benötigen möglicherweise Hyperscale-DPUs.

Netzwerkschnittstellenkarten (NIC, Network Interface Card; im Deutschen oft verkürzt nur Netzwerkkarte) haben sich über die Jahre weiterentwickelt, um mit den gestiegenen Netzwerkanforderungen Schritt halten zu können. Es gibt inzwischen viele verschiedene Typen. Die meisten Netzwerk- und Serveradministratoren sind mit Basis-NIC oder Foundational-NIC vertraut.

Das ist in der Regel im Lieferumfang des Servers enthalten und unterstützt 1 Gbit/s, 10 Gbit/s, 25 Gbit/s und manchmal sogar 50 Gbit/s. Für die meisten Standardanwendungen – ob virtualisiert oder nicht – sind diese NICs völlig ausreichend. Sie sind preiswert und meist mehr als hinreichend.

Sie werden umgangssprachlich als dumme NICs bezeichnet, weil sie die Verarbeitung von Netzwerkpaketen passiv an die Server-CPU weitergeben. Da die Netzwerkgeschwindigkeiten jedoch gestiegen sind, hat sich auch die Belastung der Server-CPU durch die Verarbeitung von Netzwerkpaketen erhöht.

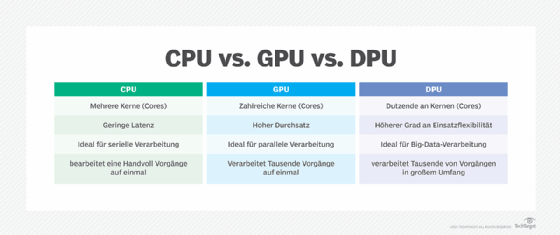

Die zunehmende Beliebtheit von Netzwerken mit noch höheren Geschwindigkeiten von100 Gbit/s, 200 Gbit/s und sogar 400 Gbit/s hat das Ökosystem verändert, insbesondere für Speichernetzwerke. Diese viel höheren Geschwindigkeiten haben die Server-CPUs mit einer Verarbeitungslast von oft mehr als 30 Prozent belastet. Server-CPU-Zyklen für die Paketverarbeitung können nicht für die Anwendungsverarbeitung genutzt werden, was zu Offload-NICs führte.

Offload-NICs als Retter in der Not

Offload-NICs sind in der Vergangenheit schon mehrmals auf den Markt gekommen, aber dieses Mal ist es anders. In der Vergangenheit wurden Offload-NICs zu einer teuren und unnötigen Option, da CPUs nach dem Mooreschen Gesetz immer mehr Transistoren aufwiesen. Das Mooresche Gesetz hat sich jedoch in den letzten Jahren verlangsamt. Dadurch sind Offload-NICs nützlich geworden. Funktionen des Netzwerkverkehrs werden dabei ausgelagert, wie etwa die Paketverarbeitung im TCP/IP-Stack: Die Server-CPU wird entlastet und Taktzyklen werden wieder für die Anwendungen frei.

Offload-NICs sind nützlich, wenn diese Standard-NICs die Server verlangsamen. Wenn NICs den Server ausbremsen, verringert sich die Anzahl der VMs oder Container, die effektiv ausgeführt werden können, was bedeutet, dass Unternehmen eine Offload-Lösung benötigen - oder mehr physische Server. Der höhere Preis für Offload-NICs lässt sich leicht rechtfertigen, wenn sie die Anzahl der erforderlichen physischen Server reduzieren.

SmartNICs bringen Offload einen Schritt weiter

Viele Unternehmen bemerkten, dass Offload-NICs nicht ausreichten. Das führte zur Entstehung von SmartNICs, die mehr tun als nur den TCP/IP-Stack zu entlasten. Sie sind etwas flexibler als Offload-NICs und haben eine besser programmierbare Pipeline. SmartNICs entlasten die Server-CPU von mehr Netzwerkverarbeitung. Sie verfügen sogar über eine eigene CPU, ein eigenes Memory und ein eigenes Betriebssystem. Was sie auslagern, ist je nach Anbieter unterschiedlich, aber SmartNICs können Aufgaben wie Netzwerkkomprimierung und -dekomprimierung, Ver- und Entschlüsselung und sogar Sicherheit auslagern.

SmartNICs kosten in der Regel mehr als Offload-NICs. Aber wenn die Server durch die Verarbeitung von Komprimierung und Dekomprimierung oder Ver- und Entschlüsselung wieder einmal überlastet werden, sind SmartNICs eine naheliegende Wahl, anstatt weitere Server hinzuzufügen.

Mit der Verbreitung höherer Netzwerkgeschwindigkeiten in allen IT-Ökosystemen - insbesondere im Bereich der Speichernetzwerke - sind IT-Administratoren jedoch auf der Suche nach mehr. Der nächste Dreh an der Schraube war die Data Processing Unit (DPU).

Was sind DPUs?

DPUs (Data Processing Units) sind die Weiterentwicklung von SmartNIC. Die DPU umfasst den Offload, die flexibel programmierbare Pipeline, die Verarbeitung und die CPU der SmartNICs. Aber die DPU ist der Endpunkt der Netzwerkinfrastruktur, nicht der Server, in dem sie sich befindet. DPUs umfassen kundenspezifische Chips und in einigen Fällen kundenspezifische feldprogrammierbare Gate-Arrays (FPGA) oder kundenspezifische anwendungsspezifische integrierte Schaltungen.

Eine DPU kann viel mehr als eine SmartNIC unterstützen, einschließlich Netzwerken auf der Grundlage von P4 programmierbaren Pipelines, zustandsabhängigen Layer-4-Firewalls, L2/L3-Netzwerken, L4-Lastausgleich, Speicher-Routing, Speicheranalysen und VPNs. Die DPU-Funktionalität variiert je nach Anbieter. Einige der wichtigsten Anbieter auf dem Markt im Jahr 2022 waren Fungible, AMD Pensando und Marvell.

DPUs helfen bei der Unterstützung von Hochleistungsspeichern. Sie verringern die Probleme bei gemeinsam genutzten Speichernetzwerken und bieten Speicherlatenzen, die den NVMe-Speichermedien in Servern entsprechen. Das ist eine bedeutende Errungenschaft, reicht aber für Hochleistungsspeichernetzwerke möglicherweise noch nicht aus. Das Problem ist dieses Mal das Switching-Netzwerk.

Switches unterstützen ihrerseits kein massives Skalieren oder Hyperscaling, die es erst mit dem Aufkommen von Hyperscalern wie Meta und Anbietern von Public-Cloud-Diensten gab, also zum Beispiel AWS, Azure, Google Cloud Platform, Oracle, IBM und Alibaba. Diese Unzulänglichkeit von Switches hat sich in dem Maße bemerkbar gemacht, in dem Unternehmen den Wert ihrer Daten entdeckt haben, die sie mit Analysedatenbanken, maschinellem Lernen und KI analysieren und auswerten.

Die zu analysierenden Datenmengen reichen von Petabytes bis hin zu Exabytes – Mengen, die noch vor wenigen Jahren undenkbar gewesen wären. Bei diesen Datenanalyseprozessen spielt die Latenzzeit eine große Rolle. Die Leaf-Architektur von Switches führt auf Hyperscale-Ebene letztlich zu viel Latenz hinzu, insbesondere Tail-Latenzen. Die unvorhersehbaren Latenzen sind sogar noch schlimmer. Dies führte zur Entwicklung von Hyperscale-DPUs.

DPUs sind somit optimal für Speichernetzwerke geeignet. Sie kosten zwar mehr als andere NICs, aber sie leisten viel mehr und können Speichersysteme mit geringeren Latenzen effizienter machen. Dadurch kann die Anzahl der für eine bestimmte Hochleistungsanwendung erforderlichen Speicher-Controller reduziert werden.

Hyperscale-DPUs gehen noch einen Schritt weiter

Hyperscale-DPUs sind programmierbar und eliminieren das Ost-West-Switching. Sie eliminieren jedoch nicht die Nord-Süd-Umschaltung. Sie werden in der Regel in einem Torus-Mesh und möglicherweise in einer Libelle oder sogar in einer schlanken Fliege eingesetzt. Rockport Networks ist ein Anbieter von Hyperscale-DPUs.

Hyperscale-DPUs leisten alles, was DPUs leisten, und noch mehr. Sie reduzieren die Latenzzeiten am Ende des Netzwerks und die vorhersehbaren Latenzen, kosten aber nicht unbedingt mehr als DPUs. Und sie eliminieren eine Menge Kosten, indem sie die Switch-Infrastruktur erheblich reduzieren.