Getty Images

Mit Amazon SageMaker Autopilot ML-Modelle erstellen

Die Erstellung von Modellen für maschinelles Lernen kann kompliziert sein. Erfahren Sie, wie Amazon SageMaker Autopilot unterstützen kann und wie Sie ein Testversuch starten.

Die Auswahl des richtigen Modells für maschinelles Lernen (ML) erfordert mehrere Iterationen und komplexe Aufgaben in Bereichen wie der Auswahl von Machine-Learning-Algorithmen und -Modellen, der Auswahl von Datensätzen, der Verfeinerung der Eingabedaten, der Modellschulung und -bereitstellung sowie der metrischen Evaluierungsaufgaben für jede Iteration. Um den Prozess zu vereinfachen, setzen Entwickler automatisierte ML-Tools wie Amazon SageMaker Autopilot ein, um jeden Schritt des ML-Workflows zu automatisieren.

Erfahren Sie in dieser Schritt-für-Schritt-Anleitung mehr über Amazon SageMaker Autopilot und wie Sie ein Autopilot-Experiment erstellen.

Wie funktioniert Amazon SageMaker Autopilot?

Amazon SageMaker Autopilot ist ein automatisiertes ML-Tool (AutoML), das den Prozess der Erstellung und des Einsatzes von ML-Modellen für Anwendungsbesitzer vereinfacht und automatisiert.

Amazon SageMaker Autopilot führt diese Schlüsselaufgaben auf Autopilot oder auf Wunsch mit verschiedenen Stufen menschlicher Intervention durch:

- Datenanalyse und Vorverarbeitung

- Modellauswahl

- Optimierung der Hyperparameter

- Modelltraining und -bewertung

- Bereitstellung des Modells

Entwickler stellen einen tabellarischen Datensatz zum Trainieren des Modells bereit und geben eine Zieldatenspalte für die Vorhersage an. Anschließend führt Autopilot mehrere ML-Algorithmen anhand des bereitgestellten Datensatzes aus und wertet sie aus, wobei die Entwickler die Testergebnisse anhand von Metriken und Visualisierungen bewerten. Letztendlich bietet diese Funktion eine Möglichkeit, das ausgewählte Modell in einer Live-Umgebung einzusetzen. Darüber hinaus wird eine Rangliste mit Empfehlungen für alle Modelle einschließlich ihrer Metriken erstellt, um das leistungsstärkste Modell zu ermitteln.

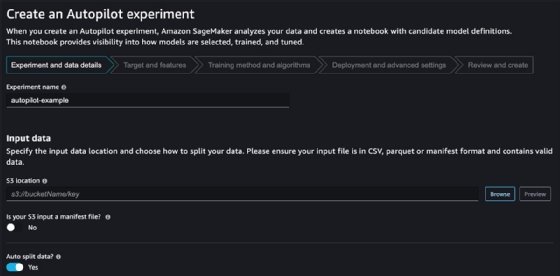

Wie man ein Autopilot-Experiment erstellt

Bevor Sie ein Autopilot-Experiment starten, stellen Sie sicher, dass Sie eine SageMaker-Domäne konfigurieren. Diese Konfiguration ist auch eine Voraussetzung für andere Funktionen, wie SageMaker Studio, Canvas und JumpStart. Die Domänenkonfiguration umfasst Benutzerprofile, Berechtigungen für das Identitäts- und Zugriffsmanagement, das gemeinsame Speichersystem Elastic File System und VPC-Details. Sobald Sie eine Domäne konfiguriert haben, sind Sie bereit, ein Autopilot-Experiment zu erstellen.

Schritt 1

Navigieren Sie von der SageMaker-Konsole zur Studio-Seite und öffnen Sie die Studio-Landingpage.

Schritt 2

Klicken Sie in der linken Navigationsleiste auf AutoML, um die Autopilot-Seite zu starten.

Schritt 3

Klicken Sie auf Autopilot-Experiment erstellen, um ein neues Autopilot-Experiment zu starten

Schritt 4

Wählen Sie den Namen des Experiments.

Schritt 5

Geben Sie den Speicherort der Daten in Amazon Simple Storage Service (S3) ein. Diese Daten müssen im CVS- oder Parquet-Format vorliegen.

Schritt 6

Geben Sie die Konfiguration der geteilten Daten ein. Standardmäßig wird für Training und Validierung ein Verhältnis von 80 Prozent für Training und 20 Prozent für Validierung verwendet.

Schritt 7

Definieren Sie eine S3-Manifestdatei, die Metadaten wie den S3-Speicherort der Datensatzdatei enthält.

Schritt 8

Wählen Sie den S3-Speicherort für die Ausgabedaten.

SageMaker Autopilot gibt je nach Qualität und Relevanz des bereitgestellten Datensatzes Ausgaben und Empfehlungen aus. Stellen Sie sicher, dass der Datensatz genau die Art der Daten widerspiegelt, die in einer Live-Umgebung vorhergesagt werden sollen.

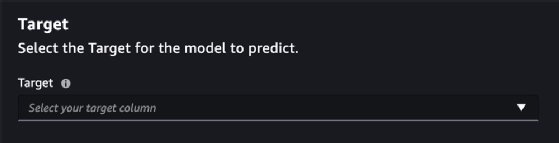

Auf der nächsten Seite wird die Konfiguration von Ziel und Merkmalen angezeigt. Ziel ist die Spalte im Eingabedatensatz, die die generierten SageMaker-Modelle vorhersagen.

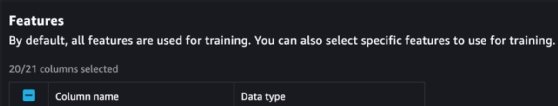

Der Abschnitt Features ermöglicht es dem Benutzer, die Spalten im Datensatz auszuwählen, der für das ML-Modelltraining verwendet wird. Es werden automatisch alle Spalten mit Ausnahme der Spalte, die als Ziel ausgewählt wurde, ausgewählt, die die Modelle vorhersagen.

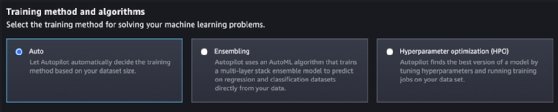

Schritt 9

Wählen Sie die Trainingsmethode aus drei Optionen aus: Auto, Ensembling und Hyperparameter-Optimierung. Ensembling eignet sich besser für Datensätze, die kleiner als 100 MB sind, aber wenn es keine speziellen Anforderungen gibt, die den Entwicklern bekannt sind, wird empfohlen, die Trainingsmethode automatisch von SageMaker auswählen zu lassen.

Schritt 10

Stellen Sie die Modelle automatisch bereit. Das wird empfohlen, wenn eine erste Analyse eines bestimmten Datensatzes und mehrere ML-Modelle durchgeführt wird.

Das Menü Erweiterte Einstellungen bietet eine Reihe zusätzlicher Konfigurationen, die bei einem ersten Experiment mit den Standardwerten konfiguriert werden können. Eine wichtige Einstellung für potenziell langlaufende und umfangreiche Experimente ist der Abschnitt Laufzeit. In diesem Abschnitt können die Entwickler die maximale Anzahl von Stunden oder Minuten für Versuche und Jobläufe auswählen. Das könnte das Risiko unerwarteter AWS-Kosten verringern, da ML-Aufträge oft über einen langen Zeitraum eine hohe Rechenkapazität erfordern.

Schritt 11

Aktualisieren Sie die Übersichtsseite oder starten Sie die entsprechenden Aufgaben, indem Sie auf Experiment erstellen klicken.

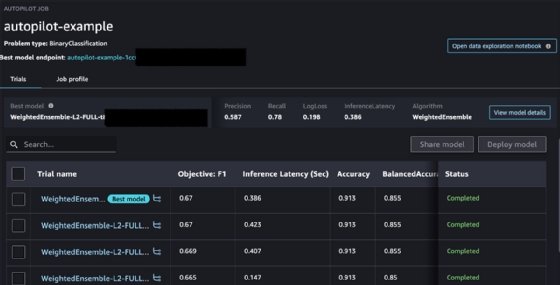

Der Abschluss des Experiments kann einige Minuten oder sogar Stunden dauern, je nach Datensatz, gewählter Trainingsmethode und Anzahl der bewerteten Modelle. Sobald das Experiment abgeschlossen ist, zeigt Autopilot eine Zusammenfassung aller bewerteten Modelle und eine Reihe von Metriken an, die mit jedem Modell verbunden sind. Außerdem wird das Modell markiert, das Autopilot auf der Grundlage dieser Metriken als das beste Modell ansieht.

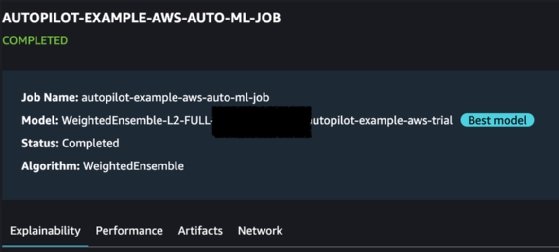

Wenn Sie auf jedes Versuchsmodell klicken, wird eine detailliertere Seite mit Metriken angezeigt.

Hier werden vier Arten von Metriken aufgeführt:

1. Erklärbarkeit: Der Bericht Erklärbarkeit enthält eine Zusammenfassung der bewerteten Spalten im Datensatz und ihre entsprechende Relevanz bei der Vorhersage des Wertes für die Zielspalte.

2. Leistung: Der Bericht Leistung enthält eine Reihe von SageMaker-generierten Metriken, die sich darauf beziehen, wie genau und zuverlässig die Modellvorhersagen sind, basierend auf den im Eingabedatensatz bereitgestellten Werten der Zielspalte.

3. Artefakte: Der Abschnitt Artefakte enthält Details zum Speicherort der SageMaker-Artefakte, die an dem S3-Speicherort abgelegt werden, der beim Start des Experiments konfiguriert wurde.

4. Netzwerk: Der Abschnitt Netzwerk fasst zusätzliche Netzwerk- und Verschlüsselungskonfigurationen zusammen.

Benutzer können Berichte in den Abschnitten Erklärbarkeit und Leistung herunterladen und jedes Modell außerhalb der SageMaker-Konsole im Detail bewerten.

Entwickler haben die Möglichkeit, jedes Modell mit einem einzigen Klick einzusetzen und bestimmte Konfigurationen festzulegen.

Es besteht die Möglichkeit, ein Notebook zu starten und Quellcode gegen das eingesetzte Modell auszuführen. Das ist in den meisten Situationen erforderlich, wenn ein bestimmtes Modell anhand bestimmter Anwendungsszenarien evaluiert werden soll.