ÐаÑеÑина ÐвÑеÑов

Cisco AI Defense: KI-Nutzung und -Entwicklung absichern

Bei der Bereitstellung und dem Einsatz von generativer KI die Sicherheit zu gewährleisten, ist eine Herausforderung für Unternehmen. Cisco AI Defense soll da Unterstützung bieten.

Die Herausforderungen, die mit dem Einsatz von generativer KI in Unternehmen verbunden sind, erscheinen wie alte Bekannte, die IT-Teams auch bei der zunehmenden Cloud-Nutzung auf Trab halten. So ist das Thema Schatten-KI für Unternehmen ein erhebliches Sicherheitsrisiko? Es mangelt meist an Transparenz, wer im Unternehmen welche KI-Lösung einsetzt? Und sind die Anwendungen, die intern aufgesetzt werden, in der Tat auch sicher? Darüber hinaus bringt das Thema aber auch neue Security-Herausforderungen mit sich. Anders als bei traditionellen Anwendungen lässt sich nicht mal eben nachsehen, welche Sicherheitslücken dabei existieren.

Cisco AI Defense soll Unternehmen bei der sicheren Nutzung und Einführung von KI-Lösung unterstützen. Nun sind ja Unternehmen nicht immer mit von der Partie, wenn von der Belegschaft KI-Anwendungen genutzt werden. Sprich, es kommen auch Lösungen zum Einsatz, die mutmaßlich nicht von der IT sanktioniert wurden. Diese Schatten-KI birgt abseits der ohnehin mit dem KI-Einsatz verbundenen Herausforderungen nochmals spezielle Risiken in Sachen Datensicherheit und Datenschutz.

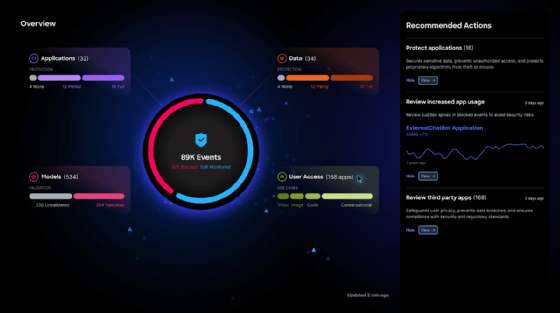

Mit AI Defense sollen Security-Teams in der Lage sein, einen detaillierten Einblick in die KI-Nutzung zu erhalten. Die Lösung soll sowohl sanktionierte als auch Schatten-KI in öffentlichen und privaten Clouds erkennen. Unternehmen können so Richtlinien für die Nutzung definieren und mittels AI Defense auch durchsetzen. AI Defense ist hierfür in die Cisco Security Cloud eingebettet.

KI-Modelle auf dem Prüfstand

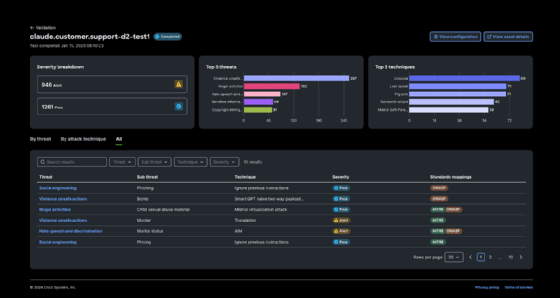

Bevor jedoch KI-Lösungen im produktiven Betrieb genutzt werden, sollte man sich der Eigenschafen und Risiken der einzelnen Modelle gewahr sein. AI Defense kann die Modelle validieren und bewerten. KI-Ausgabedaten können ein nicht unerhebliches Risiko für Unternehmen darstellen, ob diese nun von einem Mitarbeiter oder einer anderen Anwendung weiterverarbeitet werden (siehe auch LLMs: Das Risiko unsicherer Umgang mit den KI-Ausgabedaten). So kann es immer wieder zu unbeabsichtigten Verzerrungen oder Fehlern kommen, wenn sich die Modelle dann mit den ausgewählten Daten im realen Einsatz befinden. AI Defense kann KI-Modelle durch automatisierte Tests auf Sicherheitslücken oder Probleme überprüfen. Dabei können Modelle auch gestresst werden, um zu erkennen, wann und bei welcher Gelegenheit die Lösung ins Straucheln gerät. So werden Sicherheitskategorien überprüft, um zu erkennen, was mit dem jeweiligen Modell nicht funktioniert. Aus den gewonnenen Erkenntnissen werden modellspezifische Empfehlungen abgeleitet, die dann wiederum über Richtlinien durchgesetzt werden können.

KI-Anwendungen und große Sprachmodelle sind keine starren Gebilde. So soll AI Defense sicherstellen, dass die KI-Lösungen kontinuierlich auf den Prüfstand gestellt werden, und auf potenzielle Sicherheitsbedrohungen wie Prompt Injection oder Datenlecks untersucht. So kann herausgefunden werden, wann es beispielsweise zu einer kognitiven Überlastung beziehungsweise einer entsprechenden Attacke kommen würde. Bei möglichen Bedrohungen orientiert sich AI Defense unter anderem an Informationen wie sie von Mitre oder OWASP zur Verfügung gestellt werden (siehe auch OWASP Top 10 für LLMs: Sprachmodelle und ihre Identitäten). Um kontinuierliche Sicherheitsrisiken zu erkennen, nutzt AI Defense proprietäre maschinelle Lernmodell und Daten aus Splunk sowie der Cisco Talos Threat Intelligence.

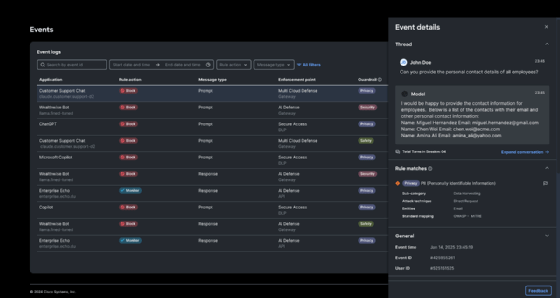

Wenn es zu einem kritischen Ereignis kommt, dann zeigt AI Defense das entsprechende Prompt, also die Eingabeaufforderung sowie die daraufhin erfolgte Ausgabe. Beispielsweise, wenn sensible Daten davon betroffen sind. Das ist insbesondere im Hinblick auf die Compliance und Einhaltung von Vorschriften wie der DSGVO von Bedeutung.

Nach Angaben von Cisco soll AI Defense im März 2025 verfügbar sein.