DrHitch - Fotolia

NVMe over Fabrics lässt PCIe-basierte Lösungen hinter sich

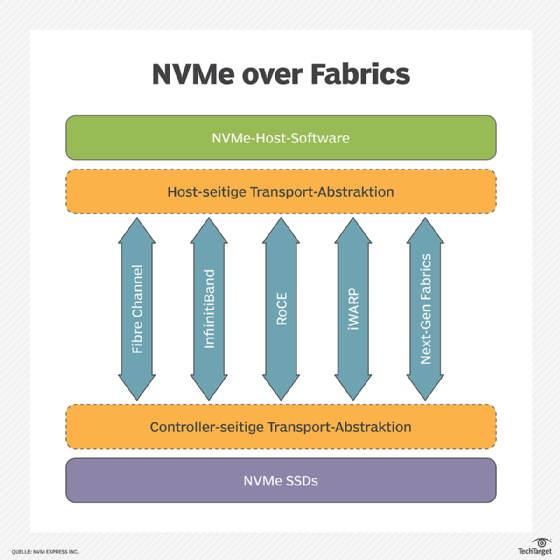

NVMe over Fabrics, heißt über Netzwerke wie Ethernet, FC oder InfiniBand, scheint sich aufgrund seiner Vorteile als verteilter Flash-Speicher in den Rechenzentren durchzusetzen.

Noch vor wenigen Jahren, vor der Entstehung der NVMe-oF-Spezifikation, basierte das zukünftige Rechenzentrum meiner Meinung nach auf einer switched PCIe-Fabric mit Rack-Skalierung. Ich dachte mir, dass OCuLink einen praktischen Standard für die notwendigen Kabel und Anschlüsse bieten würde, während handelsübliche PCIe-Chips von Broadcom oder IDT Dell, Hewlett Packard Enterprise oder eine Reihe von Start-ups ein Rack-Scale-System bauen lassen würden, ohne ein programmierbares Gate-Array zu programmieren, geschweige denn ein ASIC zu entwickeln.

NextIO und VirtenSys hatten vor einem Jahrzehnt erfolglos versucht, PCIe zu externalisieren, um es einem Rack voller Server zu ermöglichen, ein paar teure 10-Gbps-Ethernet-Karten, Fibre Channel (FC) Host-Bus-Adapter (HBAs) oder RAID-Controller gemeinsam zu nutzen. Die gemeinsame Nutzung teurer Peripheriegeräte wie Festplattenspeicher und Laserdrucker war schließlich eine der ursprünglichen Gründe für Netzwerke von LANs bis SANs.

Das Problem mit diesem Ansatz war meiner Meinung nach, dass die Produkte von NextIO und VirtenSys fast so viel kosten, als ob sie nur eine Netzwerkkarte (NIC) und HBA in jeden Server einbauen würden. In der Zwischenzeit reduzierte die gemeinsame Nutzung dieser I/O-Karten ihren Wert mit jedem Host und erhielt nur die Hälfte oder ein Viertel der Bandbreite.

Dann kam DSSD an den Markt, mit Andy Bechtolsheim, Jeff Bonwick und Bill Moore, den EMC 2014 erwarb. Ihr Ansatz war es, einen Block von Flash über die Hosts in einem Rack zu teilen, was nach einer viel besseren Idee aussah. Fusion-IO-Karten und die anderen Peripheral Component Interconnect Express (PCIe)-SSDs waren damals viel teurer als NICs und HBAs, aber der eigentliche Unterschied besteht darin, dass Shared Storage viel wertvoller ist als die isolierten Storage-Pools mit extrem niedriger Latenz, die PCIe-SSDs bereitstellten.

DSSD war nicht nur eine Möglichkeit, SSDs gemeinsam zu nutzen; es war ein gemeinsames Speichersystem, das 100 Mikrosekunden (µs) Latenzzeit liefern konnte, als alle Anbieter von Flash-Arrays mit einer Latenz von 1 Millisekunde prahlten. Für 100 µs Latenz dachte ich, dass Benutzer es sich gefallen lassen würden, einen Kerneltreiber laden zu müssen.

Aber während EMC DSSD als das Beste seit System/360 ankündigte, zeigte eine Gruppe von bahnbrechenden Start-ups, zu denen Apeiron Data Systems, E8 Storage, Excelero und Mangstor gehören, Non-Volatile Memory Express (NVMe) über Netzwerke. Diese Systeme fügten der 75 oder 80 µs Latenzzeit von NVMe SSDs nur 5 bis 20 µs hinzu, was der magischen 100 µs Latenz von DSSD über Ethernet entspricht.

Im Jahr 2017, als NVMe over Fabrics (NVMe-oF) in Sichtweite kam, entschied sich Dell EMC klugerweise für die Abkündigung der DSSD-Plattform. Nur wenige Kunden wollten für so teure Custom-Hardware und PCIe bezahlen, wenn sie die gleiche Latenzzeit zu einem Fünftel der Kosten erhalten konnten.

Heute verkaufen die meisten dieser Start-ups zusammen mit Branchengrößen wie Dell EMC, NetApp, Pure Storage und Western Digital Speichersysteme, die das NVMe-oF-Protokoll unterstützen. Diese Systeme erzeugen eine Latenzzeit von 100 µs gegenüber den Standard-Ethernet- und FC-Netzwerk-Geräten, die Kunden bereits verwenden. Viele von ihnen verwenden NVMe-oF als Frontend-Speicherzugriffsprotokoll zwischen Hosts und Speichersystemen, wie iSCSI und FC, sowie als Ersatz für SAS als Backend-Verbindung zwischen Speichersystemen und externen Medien-Shelfs.

Wenn NVMe-oF sich zum Standard-Speicherprotokoll für Host-to-Array- und Array-to-Shelf-Kommunikation entwickelt, gibt es dann einen Platz für PCIe im Rack? Oder war PCIe im Rack eine Technologie wie die Luftschiff-, Autogyro- und Digitaluhr, die von futuristisch zu malerisch wurde, ohne einen echten Halt in der Moderne?

Der Anbieter von Composable Infrastruktur Liqid und das Gen-Z-Konsortium sprechen über eine Rack-Infrastruktur, die nicht nur Speicher- oder I/O-Karten, sondern auch GPUs und Speicher gemeinsam nutzt. Das ist eine Geschichte für einen anderen Tag.

Folgen Sie SearchStorage.de auch auf Twitter, Google+, Xing und Facebook!