turbomotion046 - stock.adobe.com

Flash für Energieeffizienz in Rechenzentren nutzen

Flash ist als Speichermedium an sich bereits deutlich energieeffizienter als Festplatten. mit der jüngsten Technologie lässt sich das Einsparpotenzial nochmals deutlich steigern.

Flash-Medien, auch als SSDs (Solid State Drives) bezeichnet, sind die technologische Grundlage für effiziente Speicherumgebungen. Sie bieten eine höhere Flächendichte, ein besseres Elektronikmanagement, geringere Latenzzeitenund einen deutlich niedrigeren Stromverbrauch als Festplattenlaufwerke (Hard Disk Drives, HDDs). Letztere bildeten neben den noch älteren Bandspeichern jedoch jahrzehntelang die Grundlage von Datenspeicherinfrastrukturen.

Veraltete HDD-basierte Architekturen verbrauchen schlicht zu viel Platz und Strom. Es geht aber nicht nur um Effizienz. Die Leistungsanforderungen der heutigen, immer datenintensiveren Anwendungen zwingen Unternehmen ebenfalls dazu, ihre Datenverarbeitung und -speicherung neu zu bewerten. Der Abschied von der klassischen Festplatte ist längst eingeläutet, wenn auch in Raten. So ist derzeit in vielen Rechenzentren – als eine Art Brückentechnologie – eine Mischung aus Flash- und HDD-Systemen zum Einsatz. Diese hybride Speicherinfrastruktur gilt jedoch seit längerem nicht mehr als State of the Art, seitdem rein Flash-basierte Storage-Lösungen ihre Vorzüge in Sachen Performance und Effizienz ausspielen.

Der einzige Grund, warum Rechenzentren seit der breiten Verfügbarkeit von Flash-Speicher nicht vollständig damit aufgebaut wurden, war der Kostenunterschied zwischen HDD und SSD – zugunsten von HDD. Diese Lücke schließt sich nun, seitdem neue Flash-Technologien noch überzeugender in den Disziplinen Speichereffizienz, Platzbedarf, Kühlungsbedarf, Ausfallsicherheit und Skalierbarkeit punkten können. Ein wesentlicher Aspekt ist hierbei der deutlich niedrigere Stromverbrauch. Flash wird somit sowohl wirtschaftlich als auch ökologisch zunehmend zum prädestinierten Speicherziel im Rechenzentrum. SSDs der neuesten Generation bieten zudem einen nochmals enormen Anstieg der IOPS-Leistung (Input/Output Operations Per Second) gegenüber HDDs. Vollständig Flash-basierte Storage-Lösungen stellen daher ihr Leistungs- und Effizienzpotenzial in immer mehr Rechenzentren unter Beweis.

Warum es an der Zeit war, neue Wege zu gehen

Ein Blick zurück in der Storage-Historie zeigt auf, warum es auch zuletzt – vor wenigen Jahren – an der Zeit war, neue Wege zu gehen. Vor mehr als drei Jahrzehnten riet Gartner den Unternehmen, ältere und weniger wertvolle Daten auf kostengünstigere – und langsamere – Speicherebenen zu verlagern. Viele Unternehmen müssen heute daher sowohl verschiedene Speicherklassen (zum Beispiel All-Flash, Hybrid, All-HDD, Tape) als Protokollklassen (Block, Datei, Objekt) verwalten. Der Ansatz, dass Daten je nach ihrem aktuellen Wert auf einer bestimmten Speicherebene liegen sollten, führt jedoch zu mehreren Herausforderungen. Die entstandenen Speichersilos zwangen die Benutzer dazu, Daten zwischen Primär- und Sekundärspeicher hin und her zu verschieben und/oder zu kopieren. Trotz Automatisierungs-Frameworks und Datenmanagementsystemen machten all diese Datenbewegungen die Sache komplex – und beeinträchtigten die Gesamteffizienz der Infrastruktur.

Neue, anspruchsvolle Anwendungen wie KI, maschinelles Lernen, Big-Data-Analyse und Deep Learning benötigen heute einen möglichst schnellen Zugriff auf riesige Datenmengen. Erforderlich wurde damit ein skalierbares Datei- und Objektspeichermodell, das schnell genug ist, um die Anforderungen moderner Anwendungen zu erfüllen, und bis auf Exabytes skalierbar ist, um viele Anwendungen parallel zu bedienen. Ebenso sollte es kostengünstig sein. Der Zugriff sollte über Standard-, Datei- und Objektprotokolle erfolgen, die einen einfachen Datenzugriff für alle Anwendungen ermöglichen. Heute sind Flash-basierte Speicherplattformen verfügbar, die diese Anforderungen erfüllen und zugleich den wirtschaftlichen Nutzen und die Effizienz von herkömmlichem Storage-Tiering oder Archivierungssilos immer mehr in Frage stellen.

Neuer Ansatz sorgt für nochmals deutlichen Effizienzschub

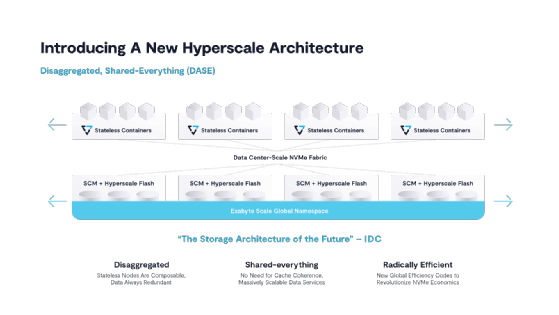

Gerade die letzten fünf Jahre haben entscheidende Innovationen hervorgebracht, die gezeigt haben, dass das Effizienzpotenzial von Flash noch längst nicht ausgereizt ist. Der Weg weist heute in Richtung einer Kombination aus Hyperscale-Flash, lokal dekodierbaren Lösch-Codes, globaler Datenreduzierung und besonders hoher Rechenleistung. Hierbei hat sich unter anderem der Disaggregated & Shared Everything (DASE)-Ansatz hervorgetan. Ein darauf basierendes System kombiniert kostengünstigen Hyperscale-Flash-Speicher und Storage Class Memory (SCM), also besonders ausfallsicheren Hochleistungsspeicher, mit zustandslosen, containerisierten Speicherdiensten, verbunden über NVMe over Fabrics (NVMe-oF) mit niedriger Latenz. Diese skalierbare Scale-Out-Speicherarchitektur zielt darauf ab, viele der Beschränkungen herkömmlicher Ansätze zu beseitigen.

Bei DASE kommen Speichermedien, SCM und QLC-Flash-SSDs in Hochverfügbarkeitsgehäusen, getrennt von den Storage-Servern, Stateless-Software-Controllern, die in Containern auf x86-Servern und -Appliances laufen, zum Einsatz. Der disaggregierte Speicher, einschließlich aller Systemmetadaten, wird von allen Storage-Servern in einem Clustergemeinsam genutzt. Somit lässt sich die Kapazität eines Storage-Clusters unabhängig von den Rechenressourcen des Clusters skalieren, indem sich Gehäuse für die Kapazität und Server für die Leistung hinzufügen lassen.

Durch die Kombination neuer Algorithmen für effiziente Datenspeicherung mit modernen Flash-Technologien gelang das, was lange Zeit undenkbar war: Flash-Speicher nicht nur für spezielle, anspruchsvolle Anwendungsfälle wirtschaftlich vertretbar zu machen, sondern für alle Unternehmensdaten. Neben der Kosteneffizienz punktet dieser Ansatz mit einer gegenüber herkömmlichen Flash-Storage-Systemen nochmals deutlich verbesserten Energieeffizienz. Dieser Aspekt wurde zuletzt durch die steigenden Energiekosten und Forderungen nach Energieeinsparungen im Rechenzentrum umso wichtiger.

All-Flash in Kombination mit der DASE-Architektur mit ihrem globalen Ansatz eröffnet auch die Möglichkeit für neue Datenreduktionstechnologien auf globaler Ebene. Für viele Unternehmen ermöglicht dies Datenreduktionsfaktoren von 2:1 und manchmal sogar weit darüber hinaus. Effiziente Datenreduktion bedeutet, dass Unternehmen weniger Geld für die Stromversorgung ausgeben müssen, da weniger Hardware erforderlich ist, um eine bestimmte Menge an Kapazität zu speichern.

Drei neue Technologien als Basis für Speichereffizienz

Entscheidend für den Effizienzschub des beschriebenen Flash-basierten Ansatzes sind drei Basistechnologien, die erst vor etwa fünf Jahren kommerziell nutzbar wurden, zuvor aber nicht zur Verfügung standen: Hyperscale-Flash, Storage Class Memory und Stateless-Container.

Hyperscale-Flash-SSDs machen Flash besonders kostengünstig. Sie liefern aus ihrer hohen Speicherdichte die Kapazität direkt an Speicheranwendungen, ohne die Überbereitstellung (Overprovisioning), Dual-Port-Controller, DRAM-Caches und Stromversorgungsschutzschaltungen von herkömmlichen Enterprise-SSDs. Der Hintergrund: Mit jeder neuen Generation von Flash-Chips und mehr Bits in einer Zelle ging bislang eine geringere Lebensdauer einher, infolge der Abnutzung nach wenigen Schreib-/Löschzyklen. Das Löschen von Daten auf Flash-Speicher erfordert eine hohe Spannung, die die Isolierschicht der Flash-Zelle auf physischer Ebene beschädigt. Nach mehreren Zyklen haben sich so viele Schäden angesammelt, dass einige Elektronen durch die Isolierschicht des Siliziums entweichen können. Dieser Verschleiß der Isolierschicht ist die Ursache für die geringere Lebensdauer von Flash-Speicherzellen mit hoher Bitdichte. Mittlerweile ist es jedoch möglich, den Flash-Verschleiß zu minimieren mittels innovativer neuer Datenstrukturen, die sich an die interne Geometrie von kostengünstigen Hyperscale-SSDs anpassen.

Storage Class Memory steht erst seit etwa fünf Jahren als neuer Medientyp bereit. SCM umfasst mehrere neue persistente Speichertechnologien, die langlebig sind und eine deutlich geringere Latenzzeit aufweisen im Vergleich zu NAND-Flash-Speicher, der in den meisten SSDs zum Einsatz kommt. In einer modernen Speicherarchitektur dient SCM als hochleistungsfähiger Puffer, um Schreibvorgänge zu absorbieren und so den Flash-Verschleiß zu minimieren. SCM macht somit den Einsatz von kostengünstigem Hyperscale-Flash sowohl für den Datenspeicher als auch als globaler Metadatenspeicher möglich. Vor allem punktet SCM mit seiner niedrigen Schreiblatenz und langen Lebensdauer.

Die Logik eines modernen Storage-Clusters läuft in Stateless-Containern. Mittels NVMe-oF, NVMe-Flash und SCM kann jeder Container die Leistung eines direkt angeschlossenen Speichers beanspruchen, ohne dass ein direkt angeschlossener Stateful-Speicher erforderlich ist. Container vereinfachen die Bereitstellung und Skalierung von Storage-Ressourcen als softwaredefinierter Microservice. Stateless-Container bilden gleichzeitig die Grundlage für eine wesentlich stabilere Architektur, in der Containerausfälle den Systembetrieb nicht beeinträchtigen.

Die Grundprinzipien von Shared Nothing sind überholt

In der Speicherbranche galt seit vielen Jahren die Überzeugung, dass eine Shared-Nothing-Speicherarchitektur der beste Ansatz ist, um Speichergröße und Kosteneinsparungen zu erzielen. Seitdem die Google-File-System-Architektur im Jahr 2003 publik wurde, wurden Speicherarchitekturen fast aller Art auf der Grundlage eines Shared-Nothing-Modells entwickelt. Diese reichen von hyperkonvergenten Speichern über Scale-Out-Dateispeicher und Objektspeicher bis hin zu Data-Warehouse-Systemen.

Die Grundprinzipien, auf denen Shared-Nothing-Systeme basierten, sind jedoch ins Wanken geraten. Mit dem Aufkommen von NVMe-oF ist es heute möglich, CPUs von Speichergeräten zu trennen, ohne die Leistung zu beeinträchtigen. Shared-Nothing-Systeme zwangen Unternehmen zudem, Rechenleistung und Kapazität gemeinsam zu skalieren, was zu einem unflexiblen Infrastrukturmodell führte. Ebenso schränkten sie die Effizienz der Datenreduzierung ein. Da sich mittlerweile Container zur Bereitstellung von Anwendungen etabliert haben, profitieren Microservices vom zustandslosen Ansatz, den Container bieten. Dies ermöglicht die einfache Bereitstellung und Skalierung von Datendiensten auf einer zusammensetzbaren (Composable) Infrastruktur, wenn die Datenlokalisierung keine Rolle mehr spielt.

Die besondere Rolle von NVMe-oF

NVMe (Non-Volatile Memory Express) ist die Softwareschnittstelle, die den SCSI-Befehlssatz für den Zugriff auf PCIe-SSDs ersetzt hat. Durch die größere Parallelität und den geringeren Overhead der Befehlswarteschlange sind NVMe-SSDs deutlich schneller als ihre SAS- oder SATA-Pendants. NVMe over Fabrics (NVMe-oF) erweitert das NVMe-APIüber handelsübliche Ethernet- und Infiniband-Netzwerke, um PCI-Leistungsniveaus für den Fernspeicherzugriff im Rechenzentrumsmaßstab bereitzustellen. NVMe-oF ist dabei wesentlich effizienter bei der Speicherung und macht die gesamte Architektur paralleler. Dadurch lassen sich Engpässe in modernen Anwendungen vermeiden und die Speicherinfrastruktur eines Rechenzentrums gewinnt an Flexibilität und Effizienz.

„Durch die Kombination neuer Algorithmen für effiziente Datenspeicherung mit Flash-Technologien gelang das, was lange Zeit undenkbar war: Flash-Speicher nicht nur für spezielle, anspruchsvolle Anwendungsfälle wirtschaftlich vertretbar zu machen, sondern für alle Unternehmensdaten.“

Sven Breuner, VAST Data

Die DASE-Architektur disaggregiert dabei CPUs und verbindet sie mit einem global zugänglichen Pool von Storage Class Memory und Hyperscale-Flash-SSDs. Auf diese Weise steht eine Systemarchitektur bereit, die Controller unabhängig von der Speicherung skaliert und die Grundlage für die Ausführung einer neuen Klasse globaler Speicheralgorithmen bietet. Mittels NVMe-oF können Stateless-Container auf einen globalen Pool von SCM- und Flash-Speichern direkt zugreifen, was zur Gesamteffizienz des DASE-Ansatzes maßgeblich beiträgt.

Das energieeffiziente Rechenzentrum ist machbar

Flash steht für die Zukunft im Rechenzentrum, das energieeffiziente Rechenzentrum ist aber heute bereits machbar – mit der jüngsten Storage-Technologie, die noch mehr aus einem wegweisenden Speichermedium herausholt. Durch die Verringerung des Stromverbrauchs für die Verwaltung großer Datenmengen ist eine lineare Skalierung der Energieeinsparungen möglich. Der Nebeneffekt der Energieeffizienz ist, dass Unternehmen eingespartes Kapital wieder in ihr Geschäft investieren können, ganz getreu der heute angestrebten Symbiose von Ökologie und Ökonomie.

Über den Autor: Sven Breuner ist seit März 2021 Field CTO International at VAST Data. Er leitete mehrere Jahre lang das Fraunhofer BeeGFS-Entwicklungsteam und kümmerte sich um dessen Einführung in HPC-Zentren auf der ganzen Welt. Breuner wurde Mitbegründer und CEO von ThinkParQ und leitete den gesamten Prozess des Aufbaus von Partnerkanälen rund um den Globus. Zu den Kunden von ThinkParQ gehören Unternehmen und Forschungszentren aus fast allen Branchen rund um den Globus, darunter einige der größten Rechenzentren unserer Zeit.

Die Autoren sind für den Inhalt und die Richtigkeit ihrer Beiträge selbst verantwortlich. Die dargelegten Meinungen geben die Ansichten der Autoren wieder.