vchalup - stock.adobe.com

Der KI-Boom erfordert Effizienzsteigerungen im Rechenzentrum

Die Nachfrage nach KI-Lösungen steigt an, weshalb sich Rechenzentrumskapazitäten vergrößern. Um Kosten zu sparen und die Effizienz zu steigern, eignet sich die Flüssigkühlung besonders.

Angesichts einer beispiellosen Nachfrage nach KI-Lösungen müssen Rechenzentren um zusätzliche Kapazitäten erweitert werden. Da erwartet wird, dass die Nutzung von KI 10-15 Prozent der gesamten Infrastruktur von Rechenzentren ausmachen wird, müssen Unternehmen ihre Rechenzentrumsinfrastruktur für die zunehmenden KI-Workloads optimieren und gleichzeitig den Anstieg der Betriebskosten sowie die Auswirkungen auf die Umwelt minimieren.

KI- und ML-Anwendungen erfordern hochleistungsfähige Systeme, die neben einem hohen Stromverbrauch auch einen hohen Kühlungsbedarf haben. Die überschüssige Wärme, die von KI-Systemen erzeugt wird, ist mit herkömmlichen Luftkühlungstechniken nur schwer zu reduzieren. Obwohl sich die Flüssigkühlung als Lösung herauskristallisiert hat und Berichten zufolge die Energiekosten für Daten jährlich um 10 Prozent senken kann, bleiben der erhöhte Energieverbrauch und seine ökologischen Folgen bestehen, was zeigt, dass noch mehr getan werden muss.

Anpassung an KI-Workloads

Dabei ist es entscheidend, die spezifischen Workload-Anforderungen zu verstehen. Jeder Workload kann eine andere Rechenleistung erfordern, was zu unterschiedlichem Energieverbrauch und Wärmeentwicklung führt.

Durch ein tieferes Verständnis ihrer Workloads können Unternehmen eine Reihe von Technologien und Lösungen nutzen, um die Leistung zu optimieren und die negativen Auswirkungen auf die Umwelt zu mindern. Bei der Einrichtung eines Servers gibt es zahlreiche Möglichkeiten für Komponenten und Konfigurationen, und jede Anwendung erfordert ein System, das der jeweilige Workload am besten unterstützt. Für KI-Anwendungen ist beispielsweise ein anderer Server erforderlich als für 5G-Lösungen.

Ein optimiertes System, das auf bestimmte Workloads zugeschnitten ist, bietet erweiterte Optionen für Komponenten und Konfigurationen, die den Leistungsanforderungen einer bestimmten Gruppe von Workloads gerecht werden. Durch diese Optimierungen werden unnötige Funktionen eliminiert, was zu Kosteneinsparungen, geringerem Stromverbrauch und minimierter Wärmeentwicklung führt.

Im Falle von KI kann die Leistung durch Plattformen mit spezieller Hardware verbessert werden, die Verbesserungen für maschinelles Lernen bieten. Bestimmte CPUs offerieren beispielsweise spezielle KI-Beschleunigungsfunktionen und -Hardware, um KI-Workloads zu unterstützen, oder enthalten High Bandwidth Memory (HBM), das Daten viel schneller als andere Speicher zur und von der CPU liefern kann. Es ist zwar wichtig, Hardware-Optionen in Betracht zu ziehen, die zur Beschleunigung der beabsichtigten Anwendung beitragen, doch können diese auch Kompromisse mit sich bringen. Einige dieser Optionen, einschließlich HBM, führen zu neuen thermischen Einschränkungen, die durch zusätzliche Kühlungsüberlegungen berücksichtigt werden müssen.

Maximierung der Effizienz von Rechenzentren

Wenn man bedenkt, dass das Gesamtsystem auf Hunderte, Tausende oder sogar Zehntausende von Einheiten skaliert wird, summieren sich selbst kleine Effizienzgewinne durch die Wahl der Komponenten über die gesamte Bereitstellung erheblich. In ähnlicher Weise kann die Energieeffizienz eines Servers im Laufe der Zeit zu massiven Kosteneinsparungen führen. Aber auch nach der Anpassung der Systeme zur Erzielung der besten Leistung und Effizienz für die angestrebten Workloads gibt es Schritte und Technologien, die zur weiteren Optimierung der Leistung und des Energieverbrauchs eingesetzt werden können.

„Die Branche verfügt heute über eine Vielzahl von Optionen, die großen und kleinen Unternehmen ein Gleichgewicht zwischen höherer Leistung, geringeren Kosten und geringerer Umweltbelastung bieten.“

Michael McNerney, Supermicro

In ihrem Streben nach größerer Effizienz und Nachhaltigkeit und um die steigende Nachfrage nach künstlicher Intelligenz zu befriedigen, hat die IT-Branche mit neuen Technologien, die zur Verringerung der Umweltbelastung und zur Optimierung der Ressourcennutzung beitragen, große Fortschritte gemacht. Von dichteren und effizienteren Rack-Scale-Implementierungsansätzen über neuartige Kühlungskonzepte für Rechenzentren bis hin zur Disaggregation von Hardwareressourcen für mehr Flexibilität. Die Branche verfügt heute über eine Vielzahl von Optionen, die großen und kleinen Unternehmen ein Gleichgewicht zwischen höherer Leistung, geringeren Kosten und geringerer Umweltbelastung bieten.

Auf Flüssigkühlung setzen

Es gibt einige grundlegende Schritte, mit denen ein Unternehmen diese Ziele der Leistungssteigerung bei gleichzeitiger Verringerung der Kosten und der Umweltbelastung erreichen können. Die Erhöhung der Rack-Dichte ist eine der effektivsten Investitionen für Unternehmen, die diese Ziele erreichen wollen, da sie eine effektivere Nutzung der bereits installierten Kühlinfrastruktur ermöglicht. Ebenso ist der Betrieb von Warm-/Kaltgängen durch die Konsolidierung der Kühlluft in einem kleineren Bereich leichter zu handhaben – und ermöglicht eine schnellere Entlüftung und Kühlung für ein effizienteres und effektiveres HVAC-System.

Die häufigste und wirkungsvollste Lösung für den Übergang zu einem leistungsfähigeren und umweltfreundlicheren Rechenzentrum ist jedoch die Einführung von Flüssigkühltechnologien. Vor allem, da die Leistungsanforderungen im Zeitalter der KI erheblich gestiegen sind, ist die Einführung von Flüssigkühlung ein entscheidender Schritt bei der Vorbereitung eines Rechenzentrums auf die Nutzung der Vorteile, die sie bietet – die fast erforderlichen überlegenen Wärmeableitungsfähigkeiten.

Der entscheidende Faktor dabei ist die Wahl der am besten geeigneten Flüssigkühlungsmethode, die auf das jeweilige Rechenzentrum zugeschnitten ist. Es gibt viele Möglichkeiten, Flüssigkühlungstechnologien zu implementieren, aber es gibt zwei, die am weitesten verbreitet sind: Direct-to-Chip (D2C) und Immersionskühlung.

Die D2C-Kühlung ist die gängigste Option, da sie sich wesentlich einfacher in herkömmliche luftgekühlte Lösungen und die bereits in einem Rechenzentrum vorhandene Infrastruktur integrieren lässt. Bei D2C-Kühlung fließt eine kalte Flüssigkeit über die wärmeerzeugende Elektronik, so dass die Flüssigkeit die Wärme von den Chips ableiten kann. Die Flüssigkeit wird dann in einen anderen Bereich geleitet, wo sie mit Lüftern gekühlt werden kann, so dass die Wärme aus dem System entweichen kann.

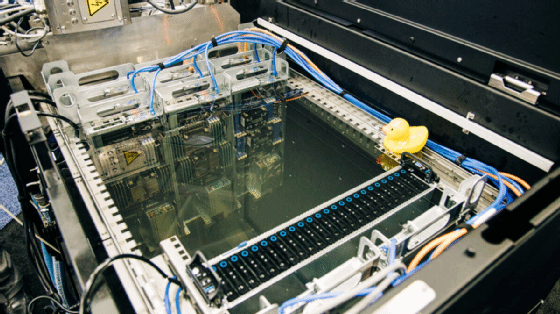

Wenn ein Server jedoch vollständig in einen mit einer nicht leitenden Flüssigkeit gefüllten Tank eingetaucht wird, spricht man von Immersionskühlung. Bei dieser Art des Einsatzes werden die Systeme tatsächlich in eine Kühlflüssigkeit (oft eine Art mineralisches, synthetisches oder biologisches Öl) getaucht. Diese Flüssigkeit kann entweder in einer Schleife abgeleitet und die Wärme abgeführt werden, ähnlich wie bei der D2C-Kühlung, oder das Tauchbad ist ein geschlossener Kreislauf, bei dem die Flüssigkeit die Wärme durch Sieden in Gas umwandelt, das durch einen Wärmetauscher zurückgewonnen und kondensiert (gekühlt) wird, bevor es in das Bad zurückgeführt wird.

Die Flüssigkühlung ist nicht nur kosteneffizient und reduziert den Stromverbrauch, sondern bietet auch Leistungssteigerungen. Bei verbesserter Kühlung ist es weniger wahrscheinlich, dass die elektrischen Komponenten an ihre thermischen Grenzen stoßen – das heißt, sie können länger mit maximaler Leistung laufen, ohne gedrosselt zu werden. Das ist besonders wichtig für Unternehmen, die sich auf hochmoderne KI-Anwendungen konzentrieren, die immer höhere Leistungsniveaus benötigen.

Aber für Unternehmen, die drastische Schritte in Richtung eines besseren, grüneren Rechenzentrums unternehmen wollen, gehört die Erforschung neuerer Methoden und Technologien dazu – wie CXL.

Einsatz von CXL für Nachhaltigkeit und Kosteneffizienz

Die Compute-Express-Link-Technologie (CXL) wird das Design von Rechenzentren revolutionieren, denn es ermöglicht eine bessere Ressourcenzuweisung und ist nicht so sehr auf sofortige lokale Rechenressourcen in jedem Server angewiesen. In der Vergangenheit war der Arbeitsspeicher ein wesentlicher Kostenfaktor für Cloud-Kunden, die neueste KI- und ML-Anwendungen einsetzen – er wird jedoch nicht immer vollständig benötigt oder genutzt. CXL-Technologien bieten eine Menge Verbesserungen, Flexibilität und Effizienz für die Speicherressourcen in einem Rechenzentrum. Dazu gehört, dass einzelne Systeme zu jedem Zeitpunkt genau so viel Speicher nutzen können, wie sie benötigen – auch wenn das mehr oder weniger Speicher ist, als das System selbst hat.

Es gibt eine Reihe von Funktionen von CXL, die für Rechenzentren und Server bemerkenswerte Veränderungen mit sich bringen dürften. Zum Beispiel wird es eine nahtlose Speicherintegration zwischen der CPU und angeschlossenen Geräten wie Beschleunigern, GPUs und Speichergeräten ermöglichen. Dadurch können sowohl die CPU als auch die Geräte direkt auf den Speicher zugreifen, ohne dass ein Softwareeingriff oder eine Synchronisierung erforderlich ist. Darüber hinaus erweitert CXL die Speicherkapazitäten, indem es der CPU ermöglicht, auf größere Speicherpools auf angeschlossenen Geräten zuzugreifen, was für eine außergewöhnliche Geschwindigkeit und Bandbreite sorgt. Dieser Fortschritt führt zu einer erhöhten Speicherkapazität und verbesserten Leistung, insbesondere für KI/ML-Anwendungen.

All das bedeutet, dass Rechenzentren als Ganzes stärker disaggregierte Architekturen entwickeln können, die weniger darauf angewiesen sind, dass jeder einzelne Server über die besten verfügbaren Speicher- und Rechenressourcen verfügt. Es schafft auch die Möglichkeit für spezialisierte Serverdesigns mit verschiedenen Komponenten, was die Art und Weise, wie Server gebaut und verkauft werden, verändert, da der traditionelle Serveraufbau mit Rechenleistung, Arbeitsspeicher, Speicher und Netzwerk, die alle in einer Einheit verpackt sind, möglicherweise nicht mehr optimal oder notwendig ist.

Für eine grünere KI

Die Ausrüstung von Rechenzentren für eine grünere KI umfasst die Optimierung der Systemarchitektur, die Einführung innovativer Kühllösungen wie Flüssigkühlung und die Nutzung neuer Technologien wie CXL. KI ist ein integraler Bestandteil der Zukunft und erfordert nachhaltige Ansätze für den Betrieb von Rechenzentren. Durch die Berücksichtigung langfristiger Faktoren und den Austausch wesentlicher Komponenten können Rechenzentrumsbetreiber eine höhere Leistung, geringere Kosten und einen kleineren, ökologischen Fußabdruck erzielen.

Über den Autor:

Michael McNerney ist Senior Vice President für Marketing und Network Security bei Supermicro und kann auf eine langjährige Erfolgsgeschichte von rekordbrechenden und preisgekrönten Produkten, Programmen und Kampagnen zurückblicken. Michael McNerney verfügt über mehr als zwei Jahrzehnte Erfahrung in der Hardware-Industrie für Unternehmen. Bevor er zu Supermicro kam, war er in führenden Positionen bei Sun Microsystems und Hewlett-Packard tätig.

Die Autoren sind für den Inhalt und die Richtigkeit ihrer Beiträge selbst verantwortlich. Die dargelegten Meinungen geben die Ansichten der Autoren wieder.