Getty Images/iStockphoto

Wie weit ist Artificial General Intelligence entwickelt?

Entwickler und Forscher diskutieren aktuell darüber, inwieweit künstliche Intelligenz (KI) das menschliche Gehirn nachahmen muss. Zwei Denkschulen sind hier federführend.

Wie weit sind wir von Artificial General Intelligence (AGI) entfernt? Und wenn wir jemals echte AGI sehen, wird sie ähnlich wie das menschliche Gehirn funktionieren? Oder gibt es einen besseren Weg, intelligente Maschinen zu entwickeln?

Seit den Anfängen der künstlichen Intelligenz (KI) – und der Informatik im Allgemeinen – gehen Wissenschaftler davon aus, dass intelligente Maschinen ähnlich denken sollten wie Menschen. Schließlich kennen wir keine größere kognitive Leistung als das menschliche Gehirn. In vielerlei Hinsicht ist es sinnvoll, zu versuchen, es zu replizieren, wenn das Ziel darin besteht, ein hohes Maß an kognitiver Verarbeitung zu erreichen.

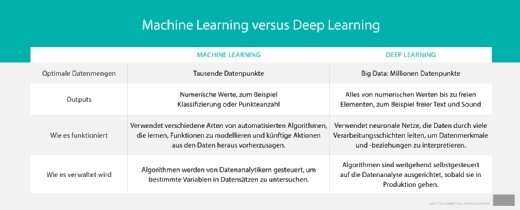

Allerdings gibt es heute eine Debatte über den besten Weg zu einer echten Artificial General Intelligence (AGI). Insbesondere die Fortschritte beim Deep Learning – das selbst vom menschlichen Gehirn inspiriert ist, obwohl es in einigen wichtigen Punkten von ihm abweicht – haben Entwicklern aufgezeigt, dass es noch andere Wege gibt.

Was ist Artificial General Intelligence?

Für viele Entwickler ist Artificial General Intelligence das ultimative Ziel der Entwicklung künstlicher Intelligenz. Seit den Anfängen der künstlichen Intelligenz in den 1950er Jahren haben sich die Ingenieure intelligente Roboter vorgestellt, die alle Arten von Aufgaben erledigen – wobei sie einfach von einem Job zum nächsten wechseln können. Danach wäre AGI in der Lage, zu lernen, zu argumentieren, zu planen, die natürliche menschliche Sprache zu verstehen und gesunden Menschenverstand zu zeigen.

Kurz gesagt, AGI ist eine Maschine, die in der Lage ist, ähnlich wie ein Mensch zu denken und zu lernen. Sie würde situationsbedingte Zusammenhänge verstehen und in der Lage sein, Dinge, die sie über die Erledigung einer Aufgabe gelernt hat, auf andere Aufgaben anzuwenden.

Wie ist der aktuelle Stand bei Artificial General Intelligence?

Die Realisierung von AGI ist in weiter Ferne. Die intelligentesten Maschinen von heute versagen vollständig, wenn sie neue Aufgaben ausführen sollen, auf die sie nicht trainiert sind. Sogar kleine Kinder sind leicht in der Lage, Dinge, die sie in einer Umgebung lernen, auf eine Weise auf neue Aufgaben anzuwenden, wie es die komplexesten KI-gesteuerten Maschinen nicht können.

Forscher arbeiten an diesem Problem. Es gibt eine Vielzahl von Ansätzen, die sich hauptsächlich auf Deep Learning konzentrieren und darauf abzielen, ein Element der Intelligenz zu reproduzieren. Neuronale Netzwerke gelten allgemein als Stand der Technik, wenn es um Lernkorrelationen in Trainingsdatensätzen geht.

Bestärkendes Lernen (Reinforcement Learning) ist ein leistungsfähiges Instrument, mit dem Maschinen beigebracht werden kann, selbstständig herauszufinden, wie eine Aufgabe mit klar vorgegebenen Regeln zu erledigen ist. Generative Adversarial Networks (GAN) ermöglichen es Computern, kreativere Ansätze zur Problemlösung zu verfolgen.

Es gibt jedoch nur wenige Ansätze, die einige oder alle diese Techniken kombinieren. Das bedeutet, dass die heutigen KI-Anwendungen nur begrenzte Aufgaben lösen können. Das Ziel von Artificial General Intelligence ist somit noch weit entfernt.

Wie ein menschenähnlicher Ansatz in Artificial General Intelligence aussieht

Gary Marcus, Gründer und CEO von Robust.ai, einem Unternehmen, das versucht, eine kognitive Plattform für eine Reihe von Bots aufzubauen, befürwortet AGI, die menschliche Intelligenz nachahmt. Auf der virtuellen Konferenz EmTech Digital des MIT Technology Review sagte er, dass die heutigen Deep-Learning-Algorithmen nicht in der Lage sind, Informationen zu kontextualisieren und zu verallgemeinern, was der größte Vorteil des menschlichen Denkens ist.

Marcus sagte allerdings auch, er glaube nicht, dass Maschinen das menschliche Gehirn replizieren müssen – Neuron für Neuron. Es gibt jedoch einige Aspekte des menschlichen Denkens, wie die symbolische Darstellung von Informationen zur Extrapolation von Wissen auf ein breiteres Spektrum von Problemen, die dazu beitragen, eine allgemeinere Intelligenz zu erreichen.

„[Deep Learning] funktioniert nicht für das logische Denken oder das Sprachverständnis, das wir im Moment dringend brauchen“, ist Marcus überzeugt. „Wir können eine Reihe von Algorithmen mit entsprechenden Daten trainieren, aber was wir brauchen, ist ein tieferes Verständnis.“

Der Grund dafür, dass Deep Learning Probleme hat, Informationen zu begründen oder zu verallgemeinern, ist, dass Algorithmen nur wissen, was ihnen gezeigt wurde. Man braucht Tausende oder sogar Millionen von gekennzeichneten Bildern, um ein Bilderkennungsmodell zu trainieren. Und selbst nach all dem ist das Modell nicht in der Lage, verschiedene Aufgaben wie das Verstehen natürlicher Sprache zu erfüllen.

Trotz dieser Einschränkungen plädiert Marcus nicht dafür, vom Deep-Learning-Ansatz abzurücken. Stattdessen, sagte er, sollten Entwickler nach Möglichkeiten suchen, Deep Learning mit klassischen Ansätzen der KI zu kombinieren.

Dazu gehören eher symbolische Interpretationen von Informationen wie Wissensgraphen (Knowledge Graph). Wissensgraphen kontextualisieren Daten – sie verbinden Informationen, die semantisch verwandt sind – und verwenden gleichzeitig Modelle für Deep Learning, um zu verstehen, wie Menschen mit Informationen interagieren und im Laufe der Zeit Verbesserungen vornehmen.

„Wir müssen aufhören, KI für Werbe- und Nachrichten-Feeds aufzubauen, und damit beginnen, KI zu entwickeln, die wirklich etwas bewirkt“, erläutert Marcus. „Um dorthin zu gelangen, muss man Systeme erschaffen, die ein tiefes Verständnis haben, nicht nur Deep Learning.“

Deep Learning ein Schritt zu Artificial General Intelligence?

Allerdings sind nicht alle mit dieser Aussage einverstanden. In seiner Rede auf der Konferenz sagte Danny Lange, Vice President of AI and Machine Learning bei Unity Technologies, einer Softwareentwicklungsfirma für Videospiele, dass Bemühungen, menschenähnliches Denken zu replizieren, unbeabsichtigt die Lernfähigkeit von Maschinen einschränken können.

Machine-Learning-Modelle arbeiten auf grundlegend anderen Bahnen als das menschliche Gehirn, und bei genügend Daten und Rechenleistung ist nicht abzusehen, wie weit sie gehen können. Wir sind zwar noch weit von Artificial General Intelligence entfernt, aber Deep Learning kann uns laut Lange möglicherweise dorthin bringen.

„Was ich an Deep Learning schätze, ist, dass es, wenn man es mit genügend Daten füttert, in der Lage ist, Abstraktionen zu lernen, die wir als Menschen nicht interpretieren können“, erklärte er.

Insbesondere ein Deep-Learning-Bereich, das Reinforcement Learning, kann ein vielversprechender Ansatz zu Artificial General Intelligence sein. Lange ist überzeugt, dass die hierfür entwickelten Algorithmen ähnlich wie natürliche Gedanken funktionieren, wenn es darum geht, neue Aufgaben zu lernen. Und es gibt Beispiele in synthetischen Umgebungen, die eine gewisse Fähigkeit zur Verallgemeinerung des Lernens von einer Aufgabe zur anderen gezeigt haben.

Er glaubt auch, dass die Entwickler das Modelltraining für Deep Learning beschleunigen können, was derzeit eine der größten Hürden darstellt. Er wünscht sich Bemühungen zur Optimierung der Datensätze, mit denen die Modelle trainiert werden, so dass die Algorithmen nicht Millionen von Beispielen von etwas sehen müssen, um zu lernen, was es ist. Diese Idee befindet sich noch in der Entwicklung, aber Lange geht davon aus, dass Deep Learning noch weiter gehen kann, als es derzeit möglich ist. „Wir haben heute nur begrenzte Daten und Rechenleistung“, sagte er. „Doch wir sind mit Deep Learning leider noch nicht weit gekommen.“