jamdesign - stock.adobe.com

Warum All-Flash-Arrays (AFA) einen Preisverfall erleben

Technologie-Fortschritt und sich verändernde Marktkräfte haben die Dynamik im All-Flash-Array-Markt gesteigert – und ihn für neue Herausforderer geöffnet.

Der Markt für All-Flash-Arrays (AFA) hat in den letzten Jahren einen starken Preisverfall erlebt. Die Kosten für All-Flash-Arrays, die noch vor wenigen Jahren bei 15 oder 16 US-Dollar pro Gigabyte Rohkapazität lagen, sind inzwischen auf einen US-Dollar oder weniger gefallen. Der Markt wird zudem umkämpfter: Häufig werden Rabatte von 80 Prozent oder mehr angeboten. Wenn Storage-Käufer glauben, dass sie einen guten Preis von einem namhaften Anbieter bekommen haben, dann kommt oft ein anderer Anbieter daher und bietet einen noch besseren Preis.

Der Preiskampf der AFA-Systeme dürfte für die meisten überraschend sein, vor allem, wenn man bedenkt, wie stark aufgrund des NAND-Chip-Mangels von 2017 und Anfang 2018 die SSD-Kosten in diesem Zeitraum angestiegen sind. Es stellt sich daher Frage: Was ist die Ursache für die schnelle Kommodifizierung und den rasanten Preisverfall von AFAs? Eine Klärung dieser Frage und ein Verständnis des Phänomens erfordern einen gewissen Kontext.

Die Sahne abschöpfen

Hochwertige Produkte und Dienstleistungen unterliegen seit jeher der Kommodifizierung. Kommodifizierung bedeutet, dass ein vormaliges Premium-Produkt zur gewöhnlichen (commodity) und preiswerten Ware für viele wird.

Die ersten Produkte, die in einer Kategorie auf den Markt kommen, werden in der Regel zu einem Premium-Preis verkauft – im Englischen als Cream Skimming (Sahne abschöpfen) bezeichnet. Für eine gewisse Zeit lässt sich damit ein hoher Gewinn abschöpfen. Mit zunehmendem Wettbewerb sinkt der Preis aber. Neue Produkte und Dienstleistungen versuchen diese Entwicklung zu stoppen und höhere Preise aufrecht zu erhalten, indem sie Funktions- und Markendifferenzierung einsetzen. Aber schließlich sinken die Preise allgemein, da diese zusätzlichen Eigenschaften und Funktionen auch bei preisgünstigeren Konkurrenten auftauchen.

Eine Kommodifizierung erfolgt dann, wenn sich die Produkte nicht mehr von ihren Mitbewerbern unterscheiden. Sobald Produkte und Dienstleistungen zu solcher Commodity werden, ist der Preis das entscheidende Unterscheidungsmerkmal. Anspruchsvollere IT-Einkäufer können nach TCO und nicht nach Preis differenzieren, obwohl auch das die Ausnahme und nicht die Regel ist.

Storage ist von der Kommodifizierung nicht ausgenommen. Die wichtigste Vergleichsmetrik für die Kosten ist in der Regel der Preis pro Gigabyte Rohkapazität. Obwohl diese Metrik alles andere als perfekt ist, ist sie immer noch das Hauptwerkzeug zur Bewertung von Speichersystemen (siehe Metriken für den Storage-Vergleich).

Positiv an dieser Kennzahl ist, dass sie im Laufe der Jahre branchenweit stetig zurückgegangen ist – vor allem aufgrund der kontinuierlichen Kapazitätssteigerungen sowohl bei Festplatten- als auch bei Solid-State Drives (SSDs). Zwar hat sich in den letzten Jahren der Anstieg der Festplattenkapazität verlangsamt, jedoch haben sich die SSD-Zuwächse beschleunigt, da die NAND-Fertigung auf 3D umgestellt wurde. Der stetige Rückgang der Metrik Preis pro Gigabyte Rohkapazität erklärt aber nicht, warum AFAs so schnell kommodifiziert wurden.

Wie oben gezeigt, resultiert die Kommodifizierung aus einem verstärkten Wettbewerb und der Unfähigkeit, Konkurrenzprodukte im Detail zu unterscheiden. Genau das passiert auf dem AFA-Markt gerade. Aber es gibt noch mehr. Weitere drei Markttrends haben die beispiellose Kommodifizierung von AFA-Storage vorangetrieben:

- Eine Schrumpfung des gesamten verfügbaren Zielmarkts;

- ein spürbar erhöhter direkter Wettbewerb; und

- zunehmend indirekter Wettbewerb.

Schrumpfung des gesamten verfügbaren Zielmarktes

Public Clouds gibt es nun schon seit einem Jahrzehnt. Sie haben sich am stärksten auf kleine und mittelständische Unternehmen ausgewirkt. Neue Unternehmen haben heute nur selten ein eigenes Rechenzentrum. Der Grund: Die IT ist in der Public Cloud einfacher einzurichten und kostengünstiger zu betreiben. Unternehmen können damit preiswerte, vorkonfigurierte Software-as-a-Service-Anwendungen wie Microsoft Office 365, Google G Suite, Salesforce, Oracle und Magento sowie Infrastructure as a Service, Platform as a Service und andere as-a-Service-Angebote nutzen.

Wenn Unternehmen ihre IT in der Cloud betreiben, benötigen sie weder Inhouse-Storage noch AFA. Zwar kostet der Betrieb der IT in der Cloud langfristig mehr, er wandelt aber Investitionskosten in Betriebskosten um und macht den Betrieb eines oder mehrerer Rechenzentren komplett überflüssig. Auf den Mittelstand hat dies eine große Anziehungskraft – mit der Folge, dass viele Unternehmen viele Anwendungen in die Public Cloud verschoben haben. Das Ergebnis ist ein schrumpfender Storage-Gesamtmarkt.

Erhöhter direkter Wettbewerb

Warum gibt es einen deutlich direkteren Wettbewerb bei All-Flash-Array-Storage, als es ihn bisher bei anderen Speichersystemen gegeben hat? Vieles davon ist das Ergebnis substanzieller Innovationen bei den zugrunde liegenden Technologien.

Die traditionelle Lücke zwischen Highend-Storage-Systemen – typischerweise als Enterprise oder Midtier klassifiziert – und Massenmarkt- oder Lowend-Speichersystemen war früher in jeder Hinsicht groß. Lowend-Systeme konnten in Bezug auf Leistung, Zuverlässigkeit, Skalierbarkeit, Funktionalität und Datensicherheit nicht mit Highend-Systemen mithalten.

Um die im Enterprise-Segment notwendigen starken Leistungen zu bieten, verfügten Highend-Systeme häufig über eigene ASICs und hochentwickelte, komplexe Caching-Hardware-Systeme. In den Shared-Storage-Umgebungen war typischerweise eine hohe Performance gefragt. Infolgedessen gab es auch ein großes Kosten- und Preisgefälle, das die Kommerzialisierung von Highend-Systemen verhinderte. Auch die hohen Kapazitäten waren exklusiv Highend-Systemen vorbehalten.

Metriken für den Storage-Vergleich

Der Preis pro Gigabyte Rohkapazität ist die Hauptmetrik, die von Einkäufern zur Bewertung von Storage-Systemen verwendet werden. Es bewertet den Storage-Kauf auf folgende Arten:

- Die Rohkapazität ist die Summe der Kapazität aller Laufwerke.

- Die nutzbare Kapazität ist die verbleibende Kapazität, nachdem die Rohkapazität formatiert, das Dateisystem festgelegt und das RAID eingerichtet wurde.

- Die effektiv nutzbare Kapazität ist die Menge der verfügbaren Kapazität, die nach Thin Provisioning, Deduplizierung, Komprimierung, Snapshots und Klonen auf den Speicherträger geschrieben werden kann.

Aus mehreren Gründen ist dies eine mangelhafte Metrik. So berücksichtigt die Metrik nicht:

- den Wert der Performance;

- Kapazitätsanpassungen, zum Beispiel Storage-Software-Effizienz, Thin Provisioning, Deduplizierung, Komprimierung und Zero Capacity Snapshots;

- Leistungs- und Kapazitätsskalierbarkeit;

- Datensicherungsfunktionen, zum Beispiel Snapshots, Replikation, Spiegelung, kontinuierliche Datensicherung und Hochverfügbarkeit;

- Management-Software und Analytics-Software.

Der Preis pro Gigabyte Rohdaten berücksichtigt auch nicht die TCO, einschließlich der Kosten für die zu unterstützende Infrastruktur, Wartung, Betrieb, Upgrades, Personal für den Betrieb und technische Aktualisierung der Datenmigration. Sie geht fälschlicherweise davon aus, dass alle diese Werte und Kosten gleich sind.

Zuverlässigere Kennzahlen sind TCO pro effektiv nutzbarem Gigabyte an Kapazität kombiniert mit TCO pro zufälligem IOPS und TCO pro nachhaltigem Durchsatz. Diese Metriken beinhalten die tatsächlichen Kosten, die sich von denen anderer AFA-Produkte unterscheiden. Dazu gehört auch die Effektivität der Hardwareminimierung, die wiederum je nach Herstellerprodukt variiert.

Ein Bereich, der bei der Beurteilung von Herstellern zu beachten ist: Sie variieren in Bezug darauf, wie viel Minimierung der Storage-Hardware sie garantieren, da die Deduplizierung und Komprimierung der Daten je nach Datentyp variiert. Es ist ratsam, die Garantie jedes Herstellers schriftlich einzuholen.

Erhebliche technologische Fortschritte haben das alte Paradigma verändert, indem Leistungs- und Kapazitätslücken verkleinert und sogar beseitigt wurden. Der erste Schritt zur Transformation des Storages war der zunehmend funktionale Intel x86-Mikroprozessor. Moores Gesetz mag sich verlangsamt haben, aber es gilt weiterhin.

Die x86-CPU wird immer leistungsfähiger und bietet immer mehr Transistoren, Kerne, Leistungsreduzierung und Speichermöglichkeiten. Die neuesten Versionen beinhalten mehrere Speicherfunktionen, wie zum Beispiel XOR. Diese CPU-Verbesserungen machen ASICs weniger attraktiv. Sie bieten einfach zu wenig Vorteile, wenn man die Kosten berücksichtigt. Das führt dazu, dass die meisten Storage-Systeme heute auf x86-Storage-Controller-Architekturen standardisiert sind.

Ein weiterer Punkt: Die x86-Architektur enthält eine Vielzahl von Standard-Werkzeugen, die die Softwareentwicklung schneller und kostengünstiger machen. Sie ermöglicht auch die Entkopplung von Storage-Software-Stacks von der Storage-System-Hardware – ein Paradigmenwechsel. Diese Entkopplung hat die Entwicklung von Storage-Software getrennt von der Hardware ermöglicht, wodurch eine neue Klasse von Konkurrenten unter dem Banner Software-defined Storage, kurz SDS, möglich wurde. SDS ermöglicht den Betrieb des Storage-Software-Stacks auf Commercial Off-the-Shelf (COTS) Standard-Servern – auch bekannt als White-Box-Hardware.

Commodity-Hardware bedeutet eine riesige Marktverschiebung. COTS-Server-Hardware sprengt die bei Storage-Systemen vorherrschenden Hardware-Premium-Preise. Festplatten und Solid-State Drives hatten oft Listenpreise, die in einem Enterprise-Storage-System zehnmal höher waren als entsprechende Laufwerke in einem normalen Server. Midtier-Storage konnte sechsmal mehr kosten als das Server-Äquivalent. Selbst nach Abzug aller Rabatte kostet das Laufwerk in einem Server selten mehr als ein Drittel des Preises des gleichen Laufwerks in AFA-Systemen. Auch die Wartungskosten dieser Laufwerke nach der Garantie basieren auf dem höheren empfohlenen Verkaufspreis oder Listenpreis des Herstellers, nicht auf dem rabattierten Preis.

SDS auf COTS-Server-Hardware bedeutet deutlich geringere Speicherkosten. Die Serverhersteller sind sich dieser technologischen Veränderungen bewusst und haben eine Reihe von Servern entwickelt, die für viele Laufwerke optimiert sind, darunter auch All-Flash-Designs.

Der Open-Source-Vorteil

Ein weiterer wichtiger Fortschritt war Open-Source-Storage-Software wie CentOS, Ceph, Docker, FreeBSD, Linux, Swift und ZFS. Open Source senkt die Eintrittsbarrieren für neue SDS- oder Storage-Systeme, da Storage-Softwareentwickler nicht bei null anfangen müssen. Open Source bietet bereits entwickelte Storage-Software-Features, die zu minimalen Kosten verfügbar sind. Sogar erweiterte Funktionen sind vorhanden. So ist zum Beispiel Deduplizierung mittlerweile Teil des Red Hat Enterprise-Linux-Kernels. Die Zutrittsschranke ist verschwunden.

Der vielleicht größte technologische Fortschritt und ein wesentliches Element von All-Flash-Array-Storage ist das Flash-Laufwerk selbst. SSDs haben die Speicherleistung enorm verändert und das Spielfeld eingeebnet. Nahezu jedes AFA kann mittlerweile die enormen Mengen an IOPS oder den Durchsatz von Enterprise AFA Storage erreichen – oder gar übertreffen.

Die IOPS-Latenz ist, wie die Performance, für viele transaktionale Anwendungen wichtig. Auch bei der Entwicklung von Non-Volatile-Memory-Express-SSDs und NVMe over Fabrics (NVMe-oF) wurden erhebliche technologische Verbesserungen erzielt.

Non-Volatile Memory Express (NVMe) ist ein offener Standardtreiber, der die Latenzzeit zwischen einem Server oder Controller und den NVMe-Laufwerken erheblich reduziert hat. Dadurch werden proprietäre Treiber-Stack-Lockins vermieden.

NVMe-oF nutzt den NVMe-Treiber und den direkten Remote-Storage-Zugriff, um ähnliche niedrige Latenzen over Fabrics – Fibre Channel, Ethernet und InfiniBand – für NVMe SSDs innerhalb eines Servers oder Speichersystems bereitzustellen. Beide sind veröffentlichte Standards und werden von der Open-Source-Community sowie von Netzwerkadapter- und SDS-Anbietern akzeptiert.

Unter Nutzung dieser Fortschritte und Standards nehmen mehrere neue AFA-Anbieter Führungspositionen ein – vor allem bei der Bereitstellung von niedrigeren Latenzzeiten, extremen IOPS und höherem Durchsatz. Als Neueinsteiger mit wenig Storage-Ballast sind sie wendiger. Sie können Vorteile wie Storage-Class Memory Drives – Intel Optane und Micron QauntX 3D-XPoint-Technologie – nutzen, die schneller sind und eine geringere Latenzzeit als Flash-SSDs haben.

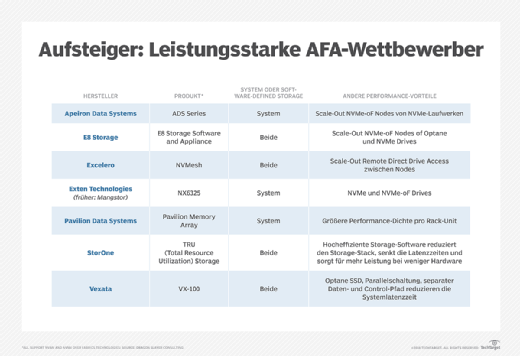

Die schnelle Einführung der neuesten Storage-Technologien hat es neuen Konkurrenten ermöglicht, die schnellsten der etablierten Enterprise-Storage-Systeme zu übertreffen. (Eine Liste der neuen Unternehmen, die die AFA-Leistung zu einem Wettbewerbsvorteil gemacht haben, finden Sie in Abbildung 1.)

Eine weitere Innovation, die den AFA-Wettbewerb antreibt, ist das Tiering, bei dem wenig genutzte „kalte AFA-Daten“ auf kostengünstigere Sekundärsysteme oder Cloud-Storage archiviert werden. Das Verlegen von Cold Data von Hochleistungs-AFAs auf weniger leistungsfähige Systeme reduziert die benötigte Kapazität für Primärdaten um 80 Prozent oder mehr. Das wiederum senkt die Kosten für den Primär-Storage um den gleichen Betrag. Viele traditionelle AFA-Anbieter haben diese Funktion übernommen, erheben jedoch häufig eine Gebühr für die Verwaltung von kalten Daten. Schließlich werden diese nicht mehr auf ihren Arrays gespeichert, so dass sie den Verlust an kostenpflichtiger Kapazität ausgleichen möchten. Neue und Business-nahe Konkurrenten machen das nicht, was ihnen einen Wettbewerbsvorteil verschafft.

Die hier genannten technologischen Innovationen und Trends haben die Eintrittsbarrieren für den AFA-Markt gesenkt und eine Reihe neuer Wettbewerber etabliert. Diese wendigen Wettbewerber haben den Preisdruck auf die großen Marken erhöht und ihre hohen Preise nach unten gedrückt.

Wachsender indirekter Wettbewerb

Das Alter der IT-Spezialisten sinkt. Mit Konvergenz und Hyperkonvergenz hat sich das Pendel des IT-Marktes in Richtung Integration der bisher getrennten Disziplinen Storage, Networking und Compute verschoben.

Konvergente Infrastruktur ist die Integration von Server-, Hypervisor-, Netzwerk- und Storage-Hardware-Systemen in eine einzige SKU- und Management-Infrastruktur. Eine hyperkonvergente Infrastruktur (HCI) geht bei der Integration noch weiter. Dieser Ansatz kombiniert Server, Hypervisor und Speicher innerhalb des Servers auf Softwareebene. Von diesen beiden Arten der Konvergenz wächst HCI aufgrund der geringeren Kosten und des einfacheren Managements schneller. Nutanix ist der führende Anbieter in der HCI-Branche, aber auch die meisten Server- und White-Box-Anbieter verkaufen mittlerweile HCI-Systeme.

HCI braucht keine alleinstehenden AFAs. Eine hyperkonvergente Infrastruktur verfügt über redundanten Speicher, und All-Flash-SSDs kosten viel weniger. HCI ist vergleichbar mit SDS, wobei die Laufwerke zwei Drittel oder weniger kosten als die Laufwerke in AFAs. HCI reduziert also den Bedarf an eigenständigen, gemeinsam genutzten AFAs.

Differenzierungsbedarf

Kommodifizierung tritt auf, wenn es keine Differenzierung in Bezug auf gelöste Probleme, Werte, Funktionalitäten oder Marken gibt. Dies hat mehrere AFA-Anbieter dazu veranlasst, dem entgegenzutreten und ihre Produkte zu differenzieren.

Einige Anbieter, wie IBM, Nimbus Data, Pavilion Data Systems, Pure Storage und Western Digital, produzieren einzigartige SSD-Formfaktoren. Dadurch können sie ihre Storage-Dichte pro Rack erhöhen. Eine andere Gruppe hat versucht, ihren AFA-Storage durch Leistung zu differenzieren. Andere haben spezielle Architekturen entwickelt. Infinidat zum Beispiel ist kein AFA, sondern ein hybrides Array von SSDs und Festplatten, das AFA-Leistung mit bis zu drei TB dynamischem RAM-Caching beansprucht.

Hewlett Packard Enterprise (HPE) setzt nun in erster Linie auf Analytics (Nimble) und weniger auf einen einzigartigen ASIC (3PAR). Der Ansatz von StorOne basiert auf dem vollständigen Neuschreiben des Storage-Stacks und dem Zusammenfassen der Schichten zu einem einzigen Prozess oder Layer. Dies braucht weniger Hardware, um die gleichen IOPS und den gleichen Durchsatz bereitzustellen.

Dell EMC bündelt zusätzliche Software und Services, um sich zu differenzieren. Der Anbieter verkauft auch mehrere Produkte in jeder Kategorie von AFA, SDS, konvergenter Infrastruktur und HCI. NetApp vertreibt ebenfalls Produkte in jeder Kategorie und garantiert die Servicequalität für sein SolidFire-Array und HCI sowie die Skalierbarkeit und die Snapshot-Services seines ONTAP-Betriebssystems.

All diese Differenzierungen helfen den Anbietern, sich von anderen abzuheben, verschiedene Probleme zu lösen und gleichzeitig die Kommodifizierung ihrer Produkte zu verlangsamen, allerdings nur bis zu einem gewissen Grad. Die Differenzierung wird den schrumpfenden Markt und den erhöhten Wettbewerbsdruck nicht überwinden.

Was das bedeutet

Ein schrumpfender Markt aufgrund des rasanten Wachstums von Cloud und HCI sowie die wachsende Zahl von Wettbewerbern wird die Preise für All-Flash-Arrays weiter nach unten und die Kommodifizierung nach oben treiben.

Die Differenzierung wirkt wie eine Geschwindigkeitsschwelle, die den Wettlauf der Preisbildung kaum verlangsamt. Dies ist eine gute Nachricht für Storage-Käufer, aber nicht für Storage-Anbieter. Die Margen werden weiter schrumpfen, Wettbewerber werden verschwinden und neue Anbieter entstehen.

Folgen Sie SearchStorage.de auch auf Twitter, Google+, Xing und Facebook!