Michael Kvakin - Fotolia

Software für das Datenmanagement aus dem Silicon Valley

Das Silicon Valley gilt als Hotspot für Gründungen. Die dreiteilige Artikelserie widmet sich ausgewählten Firmen. Im zweiten Teil geht es um Datenmanagement-Technologien.

Anmerkung der Redaktion: Die dreiteile Artikelserie stellt zehn Unternehmen im Bereich Datenbank- und Datenmanagementsoftware sowie IT-Management vor. Dieser zweite Artikel dreht sich um Organisationen, die im Bereich Datenanalyse und Datenmanagement beheimatet sind: Alation, DataGrail, Fivetran und Promethium.

Im ersten Artikel wurden drei Firmen präsentiert, die aus dem Bereich In-Memory Computing kommen: Hazelcast, Redis Labs und GridGain. Schließlich stehen im dritten Artikel drei Anbieter aus unterschiedlichen IT- und Softwarebereichen im Zentrum: NGINX, Kaseya und Anaplan.

Das Silicon Valley gilt als Hotspot für Unternehmensgründungen. Wer in der IT-Branche erfolgreich sein möchte, sollte in San Francisco und Umgebung präsent sein. In diesem und zwei weiteren Artikeln werfen wir einen Blick auf Unternehmen, die sich im Software-, Datenmanagement- und IT-Management-Segment etabliert haben oder Fuß fassen wollen. Als Teil einer Tour durch das Silicon Valley und San Francisco konnte TechTarget Einblicke in diese Unternehmen gewinnen.

Eine Datenkultur mit dem Alation Data Catalog schaffen

Der Data-Catalog-Anbieter Alation sammelte jüngst mit Unterstützung von Sapphire Ventures, dem Investmentfonds von SAP, und Salesforce Ventures in einer dritten Finanzierungsrunde 50 Millionen Dollar. Insgesamt hat Alation seit seiner Gründung 2012 damit 82 Millionen Dollar Investitionskapital angehäuft.

Doch warum haben Konzerne wie SAP und Salesforce Interesse an einem Anbieter von Data-Catalog-Software? Alation hilft Anwendern, Daten in ihrem entsprechenden Kontext zu finden und zu verstehen, aber auch herauszufinden, woher sie stammen. Dies erspart ihnen das Erstellen manueller Abfragen in verschiedenen Datenbanken oder die Suche nach der richtigen Datenbank, um die relevanten Daten zu finden.

Der Datenkatalog ist ein Metadatenmanagement-Tool, mit dem Benutzer über ein Portal Daten auffinden. Data Stewards und andere Datenprofis katalogisieren die Daten mit passenden Begriffen (Metadaten), welche die Geschäftsanwender verstehen, und sie liefern Kontext, damit diese in Analyseanwendungen eingesetzt werden können.

Diese Art des Metadatenmanagements ist gefragt, da viele Unternehmen sich schwertun, ihre erfassten Daten zu katalogisieren und Datenschutzbestimmungen, wie die Datenschutz-Grundverordnung der Europäischen Union, einzuhalten.

Alation hat für die Datenkatalogisierung Machine-Learning-Funktionen integriert, so dass die Software die Daten entsprechend automatisch einordnet. Die Funktion stellt eine spezielle Gewichtung der abgebildeten Daten zur Verfügung, die einem Ranking gleicht.

Das Unternehmen ist in einem Sektor beheimatet, in dem Geschäftsinvestitionen immer wichtiger werden, insbesondere bei Big-Data- und KI-Projekten. Nach Angaben von Satyen Sangani, CEO von Alation, haben 72 Prozent der Unternehmen allerdings keine Datenkultur. Das ergab eine beauftragte Umfrage, die von New Vantage Partners erhoben wurde. Die Studie zeigt auch, dass 69 Prozent der Unternehmen nicht über eine entsprechende Organisation verfügen, um auf Grundlage von Daten Entscheidungen zu treffen. Mehr als die Hälfte betrachtet Daten nicht als Unternehmensressource, was einen Wettbewerbsnachteil gleichkommt.

Um diese Lücken zu schließen, schlägt Alation einen konzeptionellen Rahmen vor, den das Unternehmen unter dem Akronym MAIDAS zusammenfasst. Dahinter stecken die englischen Begriffe Scientific Mindset, Automated Intelligence, Data Context, Access to Data und Decision Science.

„Aus Ideen müssen Hypothesen werden, die sich zu Theorien und Regeln des Handels entwickeln“, erläutert Sangani das Konzept. „Der Mensch hilft der Maschine, Grundlagen zu verbessern, die es wiederum ermöglichen, Entscheidungen zu treffen. Hierfür wird der Zugang zu den Daten im Unternehmen weitgehend geöffnet und diese Datenkultur wird im gesamten Unternehmen verbreitet – nicht nur für Spezialisten.“

Der Alation Data Catalog umfasst drei Funktionsbereiche, um bei der Umsetzung der Datenkultur zu unterstützen: Recherche, Governance und Collaboration. Governance umfasst Vorschläge und Warnungen, die bei der Etablierung von Best Practices helfen. Ein Glossar bildet Einträge auf Grundlage von Datenobjekten wie Tabellen und Berichte ab.

Die integrierten Such- und Recherchefunktionen erlauben Anwendern schließlich die Suche nach Daten unter Verwendung des Business-Vokabulars. Hierfür können sie mit natürlicher Sprache nach Begriffen recherchieren. Eine Demo in der alle Funktionen präsentiert werden, kann auf der Website von Alation angefragt werden.

Den Datenschutz mit DataGrail im Blick behalten

Der Zugang zu personenbezogenen Daten wird immer stärker reglementiert – nicht zuletzt seit dem Inkrafttreten der EU-Datenschutz-Grundverordnung (EU-DSGVO). Die Fragmentierung der Daten in Unternehmen verhindert jedoch, dass man eine globale Sicht auf sie erhält. Das Start-up DataGrail bietet einen Workflow, um Risiken und Probleme mit Blick auf Datenschutz und personenbezogene Daten zu managen.

Für Daniel Barber, CEO und Mitbegründer von DataGrail, ist die Ära des Datenschutzes angebrochen, nachdem seit den Anfängen des Webs Bedenken und Fragen der Verbraucher bezüglich ihrer Daten immer stärker in den Vordergrund traten. Um das Ausmaß zu verstehen, reicht ein Blick auf die Softwarelandschaft in vielen Unternehmen.

„Die meisten der Fortune 500 verwenden mehr als hundert Marketinganwendungen, die jede einzelne Aktion, die mit den Unternehmen in Verbindung stehen, im Web verfolgen und aufzeichnen“, erläutert Barber. „So werden Ihre E-Mail-Präferenzen, Ihre Erfahrung auf einer Website, die Art und Weise, wie Sie ein Produkt verwenden, von Unternehmen gesammelt und analysiert. Damit möchten die Firmen bessere Dienstleistungen oder Angebote schaffen, die Ihren Bedürfnissen entsprechen.“

In den letzten Jahren sind jedoch Zweifel an dieser Art der Datenanalyse entstanden. Verbraucher erwarten eine bessere Kontrolle und Transparenz über ihre Daten und deren Verwendung. Dazu benötigen sie Zugang zu den erhobenen Daten und die Möglichkeit, deren Löschung zu beantragen.

DataGrail möchte diese Verbindung zwischen Verbraucher- und Geschäftsanforderungen mit einer Plattform für das Management persönlicher Daten über alle vom Unternehmen verwendeten Systeme hinweg herstellen.

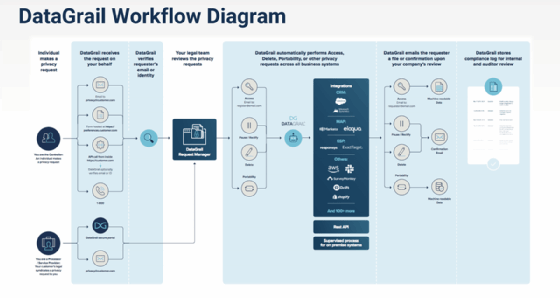

In der Praxis erhält die Plattform von einer Person oder einem Verbraucher eine Anfrage nach privaten Daten, die ein Unternehmen über sie hat. Die Plattform überprüft die Identität und Gültigkeit der E-Mail der Person. Über den Request Manager von Datagrail wird die Anfrage an die zuständige Abteilung (zum Beispiel Rechtsabteilung) des Unternehmens gesendet. Nach Zustimmung der Abteilung wird der Antrag automatisch übermittelt oder die Anfrage bearbeitet.

Wenn der Vorgang abgeschlossen ist, sendet die Datagrail-Plattform eine Benachrichtigung an den Antragsteller, aus der hervorgeht, dass der Antrag abgeschlossen ist. Die Plattform führt Protokolle für die interne Kontrolle des Unternehmens beziehungsweise über Audit-Maßnahmen.

Die Lösung passt sich den unterschiedlichen weltweit geltenden Vorschriften an, sei es für die EU-DSGVO, die CCPA-Datenschutzvorschrift in Kalifornien oder Vorschriften in Brasilien oder Singapur. DataGrail arbeitet aktuell an Systemintegrationen und entwickelt laut Barber alle zwei Tage eine neue Integration, um alle möglichen Systeme abzudecken, die in Kundenunternehmen anzutreffen sind.

„Wir möchten sicherstellen, dass die Anfrage ordnungsgemäß über alle Systeme im Unternehmen verteilt ist.“ Der größte Vorteil von DataGrail ist dabei die Datenbank mit APIs zur Verwaltung all der Plattformen. „Der Aufbau und die Verwaltung der Datenbank ist eine der Hauptaufgaben.“ Damit ist das Unternehmen mittlerweile auch in Europa erfolgreich und konnte bereits erste Kunden für sein System gewinnen.

DataGrail bietet Unternehmen und Anwendern eine Produktdemo an. Diese kann man über die Website des Unternehmens anfragen.

Datenverarbeitung mit der ELT-Lösung von Fivetran

Fivetran wurde im Ende 2012 gegründet und hat sich zum Ziel gesetzt, die Multi-Source-Datenerfassung mit Extract, Transform, Load (ETL) neu zu definieren und die mit der Technologie verbundenen Probleme zu lösen.

Das Unternehmen nahm sich drei Jahre Zeit, um die entsprechende Lösung zu entwickeln und brachte sein erstes Produkt 2015 auf den Markt. Der Erfolg stellte sich jedoch schnell ein: Bis Ende 2018 hat man bereits mehr als 600 Kunden gewonnen. Außerdem sammelte Fivetran im Dezember über 15 Millionen Dollar Investitionskapital ein.

Das Unternehmen hat neben seinem Sitz in Oakland (Kalifornien) mittlerweile auch ein Büro in Dublin (Irland) eröffnet, um die Entwicklung in Europa voranzutreiben. Der Grund: Fivetran verzeichnete für Europa eine achtfache Umsatzsteigerung im Jahr 2018 gegenüber dem Vorjahr.

Die Lösung wird auf Servern in Belgien und Frankfurt gehostet. Aktuell beschäftigt man 110 Mitarbeiter (begleitet von 12 Hunden) und wurde von Glassdoor als „Best Place to Work“ ausgezeichnet. Im Zuge verschiedener Übernahmen ist Fivetran einer der letzten unabhängigen ETL/ELT-Anbieter auf dem Markt.

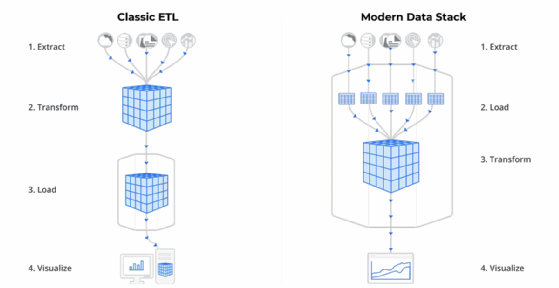

Für George Fraser, CEO und Mitbegründer von FiveTran, liegt das Problem bei der Datenverarbeitung in einem vordefinierten – und begrenzten – Data Stack für alle Aspekte der Analytik. „Aus unserer Sicht ist die Entwicklung des Data Stack bei der Datenverarbeitung in den 1990er Jahren steckengeblieben, während sich Datenspeicherung und -analyse kontinuierlich weiterentwickelt haben“, erläutert Fraser.

Typischerweise speisen verschiedene Datenquellen den ETL-Prozess, der diese transformiert und in ein Data Warehouse speist, mit dem Analysten ihre Arbeit verrichten. „Zwar haben viele Dinge diese Technologien verändert, aber nur wenige Elemente haben den ETL-Prozess erneuert. Das kann gerade für neue Anwendungen eine Bremse sein, so dass sie sich nicht mehr an die aktuellen Anforderungen der Analysten anpassen lassen“, sagt der Fivetran CEO.

Fivetran kehrt den Prozess um und schlägt als Lösung einen ELT-Prozess vor. Der Anwender verbindet die Datenquellen, wählt bei Bedarf das zu synchronisierende Objekt aus und die Tabellen werden mit der Software automatisch in einem Data Warehouse aufgebaut. Der Anbieter entfernt dabei den ETL-Konfigurationsschritt. „Die Lösung ist schneller als herkömmliche ETLs und Datenexperten müssen sich nicht mehr um diesen Schritt kümmern“, ergänzt Fraser.

Die Lösung verfügt bisher über mehr als 100 Konnektoren und ist sowohl konform mit der EU-DSGVO als auch mit verschiedenen anderen Vorschriften, zum Beispiel HIPAA. Aus Sicherheitsgründen ist das Tool verschlüsselt und beinhaltet bei Bedarf eine Zugriffsverwaltung. Die Tabellenspalten lassen sich ebenfalls sperren. Entsprechende Reports ermöglichen es Anwendern, das Ergebnis der Datenverarbeitung zu überprüfen.

Wer Interesse hat, kann Fivetran kostenlos testen. Die Konnektoren zu den verschiedenen Cloud-Datenquellen – von Google Tabellen über Jira bis zu Salesforce – lassen sich 14 Tage kostenlos ausprobieren.

Datenanalysen mit Promethium zum Anwender bringen

Das noch junge Unternehmen Promethium will mit seiner Idee eine Welt umkrempeln, die immer kürzere Reaktionszeiten beim Datenzugriff erfordert. „Unternehmen und Datenspezialisten verbringen die meiste Zeit mit Prozessen, die wenig Wert schaffen, zum Beispiel Datenaufbereitung“, sagt Kaycee Lai, CEO von Promethium.

„Rund 90 Prozent der Kosten für Business Intelligence entfallen auf den Faktor Arbeit. Man ist sich nie sicher, ob die Daten stimmen, bis man zur Abfragephase kommt“, sagt Lai. „In der Zwischenzeit haben Sie mehrere Monate Zeit in die Arbeit von Business-Analysten, IT-Experten, Data Scientists und DBAs investiert. Dort liegt der Engpass: Jemand muss das Chaos aufdecken.“

Sein Start-up möchte das Problem umkehren und den Kontext von Daten darstellen. Hierfür erstellt Promethium Fragen, die Datennutzer haben könnten. Die für die Beantwortung der Fragen relevanten Daten werden automatisch an die Datenquellen angehängt. Die Anfrage wird anschließend gestellt und validiert. Alle manuellen Aufgaben, zum Beispiel Daten einfügen, Quellensuche, Datenarchitektur und Modellerstellung, werden automatisch ausgeführt.

Die Software bietet Benutzern ein Menü mit Fragen, die er stellen muss, verbindet automatisch Daten aus den Quellen - Lai nennt zum Beispiel ein Teradata Data Warehouse, eine Oracle-Datenbank und einen Hadoop Data Lake als typische Quelle – und überlässt dem Benutzer die Ausführung der Abfrage und die Validierung der Ergebnisse.

„Die Analysezeit wird mit dieser Methode deutlich verkürzt. Vor allem aber verstehen Anwender die Struktur des Ergebnisses und können so mit dem Modell spielen, um die gewünschte Antwort zu erhalten“, erklärt er. Wieviel kürzer, verrät Lai auch: „Typischerweise benötigt es 180 Tage Arbeit, um Daten aus allen Quellen zu sammeln, mit Promethium dauert es sechs Tage.“

Anwender erhalten eine Analysemethode, die von ihnen selbst überwacht und ergänzt wird. Die Lösung vermeidet somit den oft genannten Blackbox-Aspekt bei der Erklärung bestimmter Analyseergebnisse.