Gorodenkoff - stock.adobe.com

In wenigen Schritten zur optimalen Backup-Strategie

Backup-Strategien müssen Data Protection, schnelle Wiederherstellung und Schutz vor Cyberangriffen gewährleisten. Dieser Leitfaden zeigt Best Practices, mit denen dies gelingt.

In heutigen Rechenzentren ist Storage immer zuverlässiger geworden. Dennoch ist es wichtiger denn je, regelmäßige, unabhängige Kopien der Produktionsdaten anzulegen und zu pflegen. Besonders in Zeiten von Cloud-Backups erwarten Nutzer und Anwendungsbetreiber heute keinerlei Datenverlust – selbst bei Ausfällen von Systemen oder Standorten – und Recovery-Zeiten, die in Minuten statt in Stunden gemessen werden. Dies setzt IT- und Storage-Administratoren unter enormen Druck, eine effektive Backup-Strategie zu entwickeln.

Die folgenden Best Practices helfen, diese Herausforderung erfolgreich zu meistern.

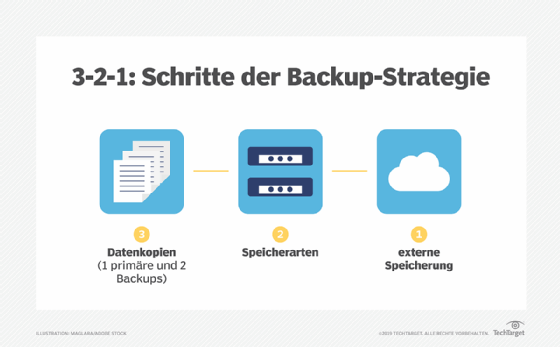

1. Die 3-2-1-Regel konsequent befolgen

Die klassische 3-2-1-Regel besagt: Drei vollständige Kopien der Daten, davon zwei lokal auf unterschiedlichen Medientypen, und mindestens eine Kopie außerhalb des eigenen Standorts. In effizienten Rechenzentren kann eine Reihe von Snapshots auf dem ersten Speicherort als eine der drei Kopien gewertet werden, solange ihre Abhängigkeit von diesem Storage bedacht wird.

Die Anforderung, zwei unterschiedliche Medientypen zu nutzen, bleibt eine Herausforderung. Die reinste Form bedeutet eine Kopie auf Festplatte und eine auf Tape oder andere Wechselmedien. Alternativ kann eine unveränderliche Cloud-Kopie als zweites Medium gewertet werden, insbesondere wenn diese nur nach Ablauf einer Aufbewahrungsfrist gelöscht werden kann.

Erweitert wird die Regel durch das 3-2-1-1-0-Prinzip: eine zusätzliche Offline-Kopie erhöht den Schutz gegen Ransomware, während das 0 sicherstellt, dass die Backups fehlerfrei sind.

2. Die Backup-Frequenz erhöhen

Ein Backup pro Nacht ist in vielen Umgebungen nicht mehr ausreichend. Alle Daten sollten mehrfach täglich gesichert werden. Technologien wie blockbasierte inkrementelle Backups (Block-Level Incremental, BLI) ermöglichen schnelle Sicherungen nur der geänderten Blöcke, wodurch selbst große Datenmengen innerhalb weniger Minuten gesichert werden können.

Ein enger Begleiter der BLI-Backups ist das In-Place- oder Streaming-Recovery. Es erlaubt es, Anwendungen innerhalb von Minuten wieder online zu bringen, ohne dass Daten vollständig über das Netzwerk zurückkopiert werden müssen. Beide Methoden haben ihre Vorteile: In-Place-Recovery nutzt Backup-Speicher temporär, während Streaming-Recovery direkt auf den Produktionsspeicher schreibt und so die Leistungsanforderungen an den Backup-Speicher reduziert.

Kombiniert ermöglichen diese Verfahren Recovery-Zeiten von 15 bis 30 Minuten für die meisten Anwendungen. Nur die kritischsten Anwendungen benötigen zusätzliche Technologien wie Replikation. Für den Großteil der Daten ist die Kombination aus häufigen BLI-Backups und schneller Wiederherstellung ausreichend und deutlich kosteneffizienter.

Grundlagen der Datensicherung (Backup)

Bei der Entwicklung einer modernen Datensicherungsstrategie kann es hilfreich sein, sich die Grundlagen noch einmal vor Augen zu führen.

Vollständige, inkrementelle und differenzielle Backups. Vollständige und inkrementelle Backups wurden erstmals in frühen Unternehmensrechenzentren eingesetzt. Bei einem vollständigen Backup wird der gesamte Datensatz gesichert, unabhängig davon, wann die Daten zuletzt geändert wurden. Bei einem inkrementellen Backup werden nur die Daten gesichert, die seit dem letzten Backup geändert wurden. Als das Rechenzentrum von einem einzelnen Mainframe auf eine offene Systemumgebung umgestellt wurde, wurden differenzielle Backups eingeführt. Bei differentiellen Backups werden alle Daten seit dem letzten vollständigen Backup gesichert.

Image-basierte Backups. Bei einem imagebasierten Backup werden geänderte Datenblöcke statt geänderter Dateien gesichert. Dies ist eine viel feinere Granularität als bei den meisten Arten von inkrementellen oder differentiellen Backups.

Cloud-Backup. Public-Cloud-Anbieter haben sich als Alternative zur lokalen diskbasierten Backup-Technologie etabliert. Mithilfe von Cloud-Speicher können Unternehmen automatisch eine externe Kopie ihrer Daten erstellen und die Nutzung lokaler Backup-Speichersysteme einschränken.

3. Backup-Strategie an Service-Level-Anforderungen ausrichten

Eine seit langem bewährte Vorgehensweise in Rechenzentren besteht darin, Prioritäten für jede Anwendung in der Umgebung festzulegen. Diese Vorgehensweise war sinnvoll, als ein Unternehmen vielleicht zwei oder drei kritische Anwendungen und vielleicht vier bis fünf wichtige Anwendungen hatte. Heute verfügen jedoch selbst kleine Unternehmen über mehr als ein Dutzend Anwendungen, und größere Unternehmen können mehr als 50 Anwendungen haben. Die Zeit, die erforderlich ist, um diese Anwendungen zu prüfen und Backup-Prioritäten festzulegen, ist einfach nicht vorhanden. Außerdem besteht die Realität darin, dass die meisten Anwendungsbesitzer auf möglichst schnellen Wiederherstellungszeiten bestehen. Chargeback- und Showback-Techniken können Anwendungsbesitzern dabei helfen, praktischere Wiederherstellungszeiten in Betracht zu ziehen.

Die Funktionen von Rapid Recovery und BLI-Backup entlasten die IT-Abteilung bei der Priorisierung von Daten und Anwendungen. Sie können buchstäblich alle Daten und Anwendungen in ein Zeitfenster von 30 bis 60 Minuten einordnen und dann bestimmte Anwendungen basierend auf der Reaktion und Nachfrage der Benutzer priorisieren. Die Festlegung eines standardmäßigen, aber aggressiven Wiederherstellungsfensters für alle Anwendungen ist dank moderner Technologie erschwinglich und praktischer als eine detaillierte Prüfung der Umgebung. Dies gilt insbesondere für Rechenzentren, in denen die Anzahl der Anwendungen, die Datenschutz erfordern, ebenso schnell wächst wie die Daten selbst.

Der Wiederherstellungs-Service-Level bedeutet, dass das Unternehmen Daten so häufig sichern muss, wie es der Service-Level erfordert. Wenn das Servicelevel 15 Minuten beträgt, müssen Backups mindestens alle 15 Minuten durchgeführt werden. Auch für BLI-Backups ist ein Zeitfenster von 15 Minuten angemessen. Der einzige Nachteil einer hohen Anzahl von BLI-Backups besteht darin, dass es in den meisten Softwareanwendungen eine Begrenzung gibt, wie viele BLI-Backups vorhanden sein können, bevor sie die Backup- und Wiederherstellungsleistung beeinträchtigen. Das Unternehmen muss möglicherweise zweimal täglich Konsolidierungsaufträge ausführen, um die Anzahl der inkrementellen Aufträge zu verringern. Da die Konsolidierungsaufträge außerhalb der Produktion stattfinden, haben sie keinen Einfluss auf die Produktionsleistung.

Die Kosten für BLI-Backups und In-Place-Wiederherstellung liegen heute für die meisten IT-Budgets durchaus im Rahmen. Viele Anbieter bieten kostenlose oder Community-Versionen an, die sich gut für sehr kleine Unternehmen eignen. Die Kombination aus BLI und schneller Wiederherstellung, die in der Regel im Grundpreis der Backup-Anwendung enthalten sind, ist weitaus kostengünstiger als ein typisches Hochverfügbarkeitssystem und bietet dabei fast ebenso gute Wiederherstellungszeiten.

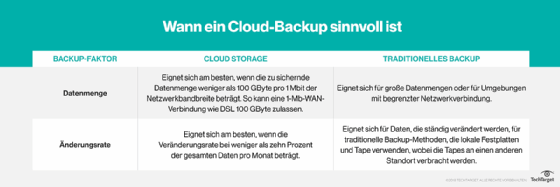

4. Cloud-Backup intelligent nutzen

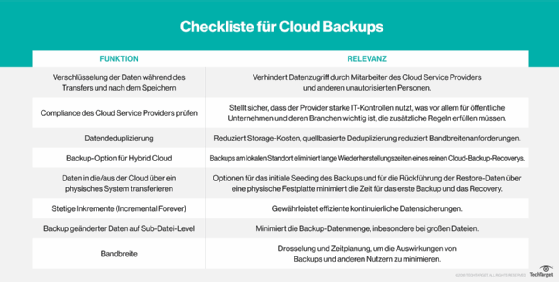

IT-Fachleute sollten weiterhin Vorsicht walten lassen, wenn sie Daten in die Cloud verschieben. Dies gilt besonders für Backup-Daten, da das Unternehmen im Grunde genommen ungenutzten Speicherplatz mietet. Obwohl Cloud-Backups zunächst einen attraktiven Preis bieten, können sich die langfristigen Cloud-Kosten summieren. Die wiederholte Bezahlung für dieselben 100 TB Daten wird letztendlich teurer als der Kauf von 100 TB Speicherplatz. Darüber hinaus erheben die meisten Cloud-Anbieter eine Ausgangsgebühr (Egress) für Daten, die aus ihrer Cloud zurück in die lokale Umgebung übertragen werden, was bei jeder Wiederherstellung der Fall ist. Dies sind nur einige Gründe, warum ein strategischer Ansatz bei der Auswahl eines Cloud-Backup-Anbieters so wichtig ist.

Angesichts der Nachteile ist ein strategischer Ansatz für die Cloud wichtig. Kleinere Unternehmen haben selten einen Kapazitätsbedarf, der den Besitz von lokalem Speicher kostengünstiger machen würde als Cloud-Backups. Die Speicherung aller Daten in der Cloud ist wahrscheinlich die beste Vorgehensweise. Mittlere bis größere Unternehmen könnten feststellen, dass der Besitz eines eigenen Speichers kostengünstiger ist, aber diese Unternehmen sollten auch die Cloud nutzen, um die neuesten Kopien ihrer Daten zu speichern, und Cloud-Computing-Dienste für Aufgaben wie Disaster Recovery, Berichterstellung sowie Tests und Entwicklung einsetzen.

Cloud-Backups sind auch ein wichtiger Faktor für Unternehmen, die ihre Data-Protection- und Backup-Strategie überarbeiten möchten. IT-Planer sollten nicht davon ausgehen, dass alle Backup-Anbieter die Cloud gleichermaßen unterstützen. Viele ältere lokale Backup-Systeme behandeln die Cloud als Ersatz für Bandlaufwerke und kopieren im Wesentlichen 100 Prozent der lokalen Daten in die Cloud. Die Verwendung der Cloud als Ersatz für Bänder senkt zwar potenziell die Kosten für die lokale Infrastruktur, verdoppelt aber auch effektiv die von der IT verwaltete Speicherkapazität.

Einige Anbieter unterstützen mittlerweile Cloud-Speicher als Ebene, auf der alte Backup-Daten in der Cloud archiviert werden, während neuere Backups lokal gespeichert werden. Durch diese Verwendung der Cloud kann das Unternehmen schnelle Wiederherstellungsanforderungen erfüllen und die Kosten für die lokale Infrastruktur senken.

Anbieter nutzen die Cloud auch, um Disaster-Recovery-Funktionen bereitzustellen, die oft als Disaster Recovery as a Service (DRaaS) bezeichnet werden. Diese Technik nutzt nicht nur Cloud-Speicher, sondern auch Cloud-Computing, um virtuelle Images wiederhergestellter Anwendungen zu hosten. DRaaS kann einem Unternehmen im Vergleich zur eigenständigen Verwaltung und Ausstattung eines sekundären Standorts potenziell erhebliche IT-Kosten einsparen. DRaaS erleichtert auch das Testen von Disaster-Recovery-Plänen, was zu häufigeren Tests führen kann.

DRaaS ist jedoch kein Allheilmittel. IT-Planer müssen Anbietern kritische Fragen stellen, zum Beispiel wie viel Zeit genau zwischen der DR-Deklaration und dem Zeitpunkt vergeht, an dem die Anwendung wieder nutzbar ist. Viele Anbieter werben mit Push-Button-DR, aber das bedeutet nicht, dass die DR sofort verfügbar ist. Anbieter, die Backups in ihrem proprietären Format im Cloud-Speicher ablegen, müssen die Daten dennoch aus diesem Format extrahieren. In den meisten Fällen müssen sie auch ihr VM-Image aus dem vom lokalen Hypervisor verwendeten Format in das vom Cloud-Anbieter verwendete Format konvertieren. All diese Schritte sind machbar und können von der IT-Abteilung oder dem Anbieter bis zu einem gewissen Grad automatisiert werden, aber sie nehmen Zeit in Anspruch.

5. Automatisierte Disaster-Recovery-Runbooks

Die häufigsten Wiederherstellungen sind keine Disaster Recoverys, sondern Wiederherstellungen einer einzelnen Datei oder einer einzelnen Anwendung. Die IT muss gelegentlich Daten von einem ausgefallenen Speichersystem wiederherstellen, aber es kommt äußerst selten vor, dass die IT nach einer umfassenden Katastrophe, bei der das gesamte Rechenzentrum verloren gegangen ist, Daten wiederherstellen muss. Natürlich müssen Unternehmen dennoch für die Möglichkeit einer solchen Wiederherstellung planen. Im Katastrophenfall muss die IT-Abteilung Dutzende von Anwendungen wiederherstellen, die möglicherweise von anderen Prozessen abhängig sind, die auf anderen Servern ausgeführt werden. In vielen Fällen müssen die anderen Server in einer ganz bestimmten Reihenfolge verfügbar sein. Der Zeitpunkt, zu dem die einzelnen Wiederherstellungen beginnen können, ist entscheidend für den Erfolg.

Die Kombination aus der Seltenheit einer tatsächlichen Katastrophe und der abhängigen Reihenfolge des Serverstarts bedeutet, dass der Disaster-Recovery-Prozess sorgfältig dokumentiert und ausgeführt werden sollte. Das Problem ist, dass diese Prozesse in den heutigen, überlasteten Rechenzentren selten dokumentiert werden. Noch seltener werden sie aktualisiert. Einige Backup-Anbieter bieten mittlerweile Funktionen zur Automatisierung von Runbooks an. Mit diesen Funktionen kann das Unternehmen die Wiederherstellungsreihenfolge vorab festlegen und den entsprechenden Wiederherstellungsprozess mit einem einzigen Klick ausführen. Jedes Unternehmen mit mehrschichtigen Anwendungen und voneinander abhängigen Servern sollte diese Funktionen ernsthaft in Betracht ziehen, um die Wiederherstellung zu gewährleisten, wenn sie am dringendsten benötigt wird.

Probleme bei der Datensicherung

Die Erwartungen an die Datensicherung sind hoch, und die Faktoren, die den Sicherungsbedarf beeinflussen, haben sich vervielfacht. Hier sind einige Beispiele.

Exponentielles Datenwachstum. Unternehmen erstellen mehr Daten als je zuvor und speichern diese über einen längeren Zeitraum. Das Ergebnis ist eine massive Datenproduktion und eine steigende Nachfrage nach Sicherungsanwendungen, um diese Daten zu verwalten.

Komplexe Umgebungen. Die meisten Unternehmen haben die Anzahl der von ihnen verwendeten Speichersysteme erhöht, und jedes dieser Systeme muss auf unterschiedliche Weise geschützt werden. Die Vielfalt der Speicherumgebungen stellt eine zunehmende Gefahr für die Qualität der Datensicherung dar.

Vorschriften. Der Wert von Daten ist auch Regierungen und Aufsichtsbehörden bewusst. Unternehmen sehen sich einer wachsenden Zahl von Vorschriften gegenüber, die speziell den Schutz und die Aufbewahrung von Daten vorschreiben.

Cyberbedrohungen. Cyberangriffe stellen eine große Gefahr für Daten dar. Die Entwickler von Malware werden immer kreativer und warten wochenlang, bevor sie Angriffe starten, damit sich die Malware an den Datensicherungsdatensatz anhängt. Sobald der Angriff gestartet ist, greift er zuerst die Datensicherungsanwendungen an.

6. Backups dürfen nicht für Langzeitarchivierung zum Einsatz kommen

Die meisten Unternehmen bewahren Daten viel zu lange in ihren Backups auf. Die meisten Wiederherstellungen erfolgen aus dem zuletzt erstellten Backup, nicht aus einem Backup, das sechs Monate – geschweige denn sechs Jahre – alt ist. Je mehr Daten in der Backup-Infrastruktur enthalten sind, desto schwieriger ist die Verwaltung und desto teurer wird sie.

Ein Nachteil der meisten Backup-Anwendungen ist, dass sie geschützte Daten in einem proprietären Format speichern, in der Regel in einem separaten Speichercontainer für jeden durchgeführten Backup-Auftrag. Das Problem dabei ist, dass einzelne Dateien nicht aus diesen Containern gelöscht werden können. Bestimmte Vorschriften, wie beispielsweise die DSGVO, verlangen von Unternehmen, bestimmte Datentypen aufzubewahren und zu trennen. Vorschriften mit Recht auf Vergessenwerden-Richtlinien verlangen von Unternehmen, nur bestimmte Komponenten von Kundendaten zu löschen und andere Kundendaten weiterhin zu speichern. Darüber hinaus müssen diese Löschungen auf Anfrage durchgeführt werden. Da das Löschen von Daten innerhalb eines Backups unmöglich ist, muss das Unternehmen möglicherweise besondere Maßnahmen ergreifen, um sicherzustellen, dass vergessene Daten nicht versehentlich wiederhergestellt werden.

Der einfachste Weg, diese Vorschrift zu erfüllen, besteht darin, Daten nicht langfristig in der Backup-Infrastruktur zu speichern. Durch die Verwendung eines Archivierungsprodukts zur Aufbewahrung von Daten können Unternehmen verschiedene Vorschriften für die Data Protection erfüllen und gleichzeitig die Backup-Architektur vereinfachen. In der Regel werden Archivsysteme verkauft, um die Kosten für Primärspeicher zu senken, und obwohl dies nach wie vor zutrifft, besteht ihr Hauptnutzen darin, Unternehmen bei der Erfüllung von Aufbewahrungspflichten zu unterstützen. Dadurch können Unternehmen einfach aus Backup-Jobs in das Archiv wiederherstellen, was ein Off-Production-Prozess ist und eine granulare Wiederherstellung auf Dateiebene ermöglicht.

7. Endpunkte und SaaS-Anwendungen schützen

Endgeräte – wie Laptops, Desktops, Tablets und Smartphones – enthalten alle wertvolle Daten, die möglicherweise nur auf diesen Geräten gespeichert sind. Es ist sehr wahrscheinlich, dass die auf diesen Geräten erstellten Daten niemals in einem Speichergerät eines Rechenzentrums gespeichert werden, es sei denn, sie werden speziell gesichert, und dass diese Daten verloren gehen, wenn das Endgerät ausfällt, verloren geht oder gestohlen wird. Heutige Endpunkt-Backup-Systeme ermöglichen es Endpunkten, Backups in einem Cloud-Repository zu erstellen, das von der zentralen IT-Abteilung verwaltet wird.

SaaS-Anwendungen wie Microsoft 365, Google Workspace und Salesforce werden von Unternehmen noch häufig übersehen. Eine allgemeine und falsche Annahme ist, dass Daten auf diesen Plattformen automatisch geschützt sind. In Wirklichkeit wird in den Nutzungsbedingungen für alle diese Plattformen ganz klar festgelegt, dass die Data Protection in der Verantwortung des Unternehmens liegt. IT-Planer sollten nach einer entsprechenden Anwendung suchen, die auch die von ihnen genutzten SaaS-Angebote schützen kann. Im Idealfall sind diese Angebote in ihr bestehendes System integriert, aber die IT-Abteilung könnte auch SaaS-spezifische Systeme in Betracht ziehen, wenn diese größere Funktionen oder einen höheren Mehrwert bieten.

Der Backup-Prozess steht mehr denn je unter Druck. Es wird erwartet, dass es zu keinen Ausfallzeiten und keinem Datenverlust kommt. Glücklicherweise kann Backup-Software Funktionen wie BLI-Backups, Recovery in Place, Cloud Tiering, DRaaS und Disaster Recovery Automation bieten. Diese Systeme ermöglichen es dem Unternehmen, eine schnelle Wiederherstellung für eine große Anzahl von Anwendungen anzubieten, ohne das IT-Budget zu sprengen.

8. Backups sicher gestalten

Daten sind das wertvollste Kapital jedes Unternehmens. Oft handelt es sich dabei um sensible Kundeninformationen und Geschäftsdaten, die dem Unternehmen schaden könnten, wenn sie gestohlen oder in irgendeiner Weise kompromittiert würden. Gestohlene Backup-Daten könnten beispielsweise leicht gegen gesetzliche Vorschriften verstoßen, das Unternehmen Rechtsstreitigkeiten aussetzen und seine Wettbewerbsposition gefährden. In Extremfällen, wie beispielsweise bei einer Ransomware-Infektion, könnte das Unternehmen sogar zum Stillstand kommen.

Backups erfordern die gleiche Aufmerksamkeit in Bezug auf die Sicherheit wie Produktionsdaten. Drei wichtige Techniken können die Sicherheit von Backups verbessern: Verschlüsselung, Air Gapping und starke Authentifizierung.

Bei der Verschlüsselung werden die Daten mithilfe eines mathematischen Algorithmus verschlüsselt, während sie vorbereitet und auf das Backup-Medium übertragen werden. Der Algorithmus verwendet einen vom Benutzer ausgewählten Code oder Verschlüsselungsschlüssel, den nur der Benutzer kennt. Wenn das Backup wiederhergestellt wird, kann der Schlüssel verwendet werden, um den mathematischen Prozess umzukehren und die Daten für die Wiederherstellung in ihren ursprünglichen (unverschlüsselten) Zustand zurückzuversetzen. Die Backup-Plattform des Unternehmens sollte über eine aktivierte Verschlüsselung verfügen, und alle Schlüssel sollten in einer Schlüsselverwaltungsanwendung enthalten sein. Selbst wenn das Backup gestohlen wird oder unbefugt auf die Daten zugegriffen wird, müssen die Daten verschlüsselt und unlesbar bleiben.

Air Gapping umfasst Methoden, mit denen das Backup und das Backup-System vom Hauptnetzwerk getrennt werden. Air Gaps können physischer Natur sein und das Backup buchstäblich von jeglicher Verbindung isolieren, beispielsweise durch Entfernen eines Bandes aus einem Bandlaufwerk. Air Gaps können auch logischer Natur sein, wobei zusätzliche Software und eine sorgfältig konzipierte Netzwerkarchitektur eingesetzt werden, um den Zugriff auf das Backup-System und die Medien, einschließlich eines Backup-Servers und seiner Festplatten, zu beschränken.

Eine starke Authentifizierung stellt sicher, dass nur autorisierte Benutzer Backups konfigurieren, aufrufen, darauf zugreifen oder wiederherstellen können. Dieser Ansatz erfordert in der Regel spezielle Anmeldedaten – möglicherweise unter Verwendung einer Multifaktor-Authentifizierung –, um die Identität des Administrators zu überprüfen. Darüber hinaus sollten detaillierte Aktivitätsprotokolle alle Zugriffs- oder Backup-/Wiederherstellungsaktivitäten verfolgen.

Auf einen Blick: Das Wichtigste für die Backup-Strategie

Die Anforderungen an moderne Backup-Strategien sind höher denn je: Unternehmen müssen Daten nicht nur zuverlässig sichern, sondern auch schnell wiederherstellen können – idealerweise innerhalb weniger Minuten. Technologien wie Block-Level-Inkrementalsicherung, In-Place-Recovery, Cloud-Backup oder DRaaS helfen dabei, diese Erwartungen zu erfüllen, ohne das Budget zu sprengen. Entscheidend ist jedoch, dass Backups intelligent geplant, regelmäßig überprüft und sicher geschützt werden. Nur so lassen sich Cyberangriffe, Ausfälle und regulatorische Risiken effektiv abwehren. Wer die hier vorgestellten Best Practices konsequent umsetzt, schafft eine robuste Grundlage für Business Continuity und langfristige Datensicherheit.