ake1150 - stock.adobe.com

Kubernetes-Backup: Multi Cloud und Cyberresillienz essenziell

Kubernetes ist eine besondere Workload, die spezielle Sicherung erfordert. Dafür müssen Admins dem speziellen Charakter gerecht werden und die Multi-Cloud beherrschen können.

Rund 3500 Firmen in Deutschland setzen inzwischen auf Kubernetes, die Container-Orchestrierung ist im Mainstream angekommen. Die Vorteile von Kubernetes für Entwickler sind vielfältig, sie können schnell schlanke und dynamische webfähige Anwendungen ausrollen. Open-Source-Tools für Container-Orchestrierungs wie Kubernetes ermöglichen es, monolithische Anwendungen in kleinere, unterschiedliche Microservices aufzuteilen und diese Software zuverlässig zwischen Computerplattformen auszuführen. Neue Workloads lassen sich in beispiellosem Tempo in die IT-Umgebungen einfügen, auch wenn sich diese in komplexen Multi-Cloud-Szenarien aus lokalen und privaten und öffentlichen Cloud-Ressourcen zusammensetzen.

Wer die Kubernetes-Workloads in diesem dynamischen Gebilde absichern will, muss die Multi-Cloud beherrschen. Die KI-getriebene Cohesity Data-Security- und Management-Plattform Data Cloud ist von Beginn an für solch komplexe hochskalierbare Multi-Cloud-Umgebungen entwickelt worden.

Keine Silos mehr

Per Definition sind die Daten in einer Multi Cloud auf eine Vielzahl von Speicherorten verteilt und Kubernetes ist per Definition für diese Szenarien entwickelt worden. IT-Teams müssen viel Zeit und Ressourcen investieren, um dieses bunte Puzzle aus proprietären, isolierten Dateninseln richtig zu verwalten. Das verzerrte Bild verursacht eine Reihe eklatanter Probleme, die mit der Datenmenge und der Anzahl der juristischen Vorschriften wie der DGSVO oder NIS2zunehmen. Auf diese Weise ist es fast unmöglich zu erkennen, ob Daten redundant sind, ob kritische persönliche Daten an riskanten Orten gespeichert sind oder ob sie im Backup-Plan übersehen wurden.

Ein Unternehmen kann versuchen, diese Dateninseln mit Prozessen und Punktproduktlösungen in den Griff zu bekommen, muss sich aber möglicherweise mit hohen Infrastruktur- und Betriebskosten, mangelnder Integration zwischen Produkten und zunehmend komplexen Architekturen auseinandersetzen. Und es ist fraglich, ob alle Daten in einer derart fragmentierten Umgebung vor Ransomware geschützt sind und ob wichtige Aufgaben wie eine schnelle Wiederherstellung in der erforderlichen Zeit und Qualität umgesetzt werden können, um den Geschäftsbetrieb aufrechtzuerhalten.

Die Cohesity Data Cloud Plattform adressiert diese Probleme, indem sie die verteilten Workloads auf einer hyperkonvergenten Plattform zusammenführt, die leicht skalierbar ist und dem Zero-Trust-Sicherheitsmodell streng folgt. Die lokal gehaltenen Daten werden auf Immutable Storage abgelegt und sind per se stark verschlüsselt, auch während des Transports. Zugriff bekommt nur, wer sich per Multifaktor authentifiziert und vorher per Rollen basierter Authentifizierung autorisiert wurde. IT-Verantwortliche greifen auch nur über eine einheitliche Konsole auf alle Workloads zu. Auch die Kubernetes-Elemente sind entsprechend eingepflegt. Die Rollen und Regeln steuern übrigens, welche Ressourcen die IT-Verantwortlichen in ihrer Konsole überhaupt sehen. Wichtige Konfigurationsänderungen oder Löschprozesse sind zusätzlich per Quorum-Prozess geschützt. Wenn beispielsweise ein IT-Verantwortlicher kritische Einstellungen modifizieren möchte, werden im Hintergrund weitere Zuständige angetriggert und automatisiert gefragt, ob sie den Vorgang genehmigen. So sollen hochsensible Bereiche vor Manipulation geschützt bleiben.

Integrität schützen, Datenwerte verstehen

Die Plattform geht noch einen Schritt weiter, um die Integrität der Daten zu sichern. Bei einem Angriff wollen HackerDaten stehlen, verschlüsseln oder löschen. Unternehmen müssen daher genau wissen, über welche Daten sie verfügen und welchen Wert diese haben. Das gilt für alle Workloads, unabhängig davon, ob es sich um Kubernetes-Workloads oder andere ältere handelt. Denn nur dann können sie Fragen der Governance und Compliance beantworten und beispielsweise kontrollieren, dass einige Datentypen bestimmte Speicherorte nicht verlassen dürfen. Und sie werden schneller verstehen, welche Daten im Detail betroffen sind, wenn Hacker erfolgreich eingedrungen sind. Dies beschleunigt das Reporting für NIS-2 und DORA und macht die Ergebnisse viel präziser. Im Alltag ist diese Aufgabe gigantisch und die meisten Unternehmen haben Berge von Informationen angehäuft, über die sie wenig oder nichts wissen. In diesem Bereich versprechen die in der Plattform integrierten KI-Lösungen wie Cohesity Gaia zu helfen und eines der komplexesten Probleme zu entschärfen, indem sie die Daten von Unternehmen automatisch klassifizieren. So können Geschäftsinhaber beispielsweise direkte Fragen zu bestimmten Daten stellen und Gaia liefert automatisch eine Antwort mit einer Liste aller betroffenen Dokumente.

Die Lösung untersucht außerdem jeden Snapshot automatisch auf Anomalien. Dazu greift die Plattform auf eine Reihe von KI- und ML-Algorithmen zurück, die ungewöhnliches Verhalten bei den Snapshots melden. Das können ungewöhnlich lange Backups, eigenartige Zugriffsmuster oder anderes abnormales Verhalten sein. Alle diese Indikatoren können dazu beitragen, mögliche interne und externe Angriffe wie etwa Ransomware frühzeitig zu erkennen, sodass rasch Gegenmaßnahmen ergriffen werden können.

Cohesity hat zudem im Rahmen seiner Data Security Alliance mit dutzenden IT-Security-Anbietern wie Palo Alto Networks oder Cisco enge Kooperationen geschlossen. Ziel ist es, das Zusammenspiel mit der eigenen Plattform und übergelagerten Security-Tools zu verbessern. So können die SOAR-Plattformen (Security Orchestration, Automation and Response) von Cisco und Palo Alto die Warnmeldungen der Anomalie-Detection von Cohesity einspeisen. Diese Integration bietet detaillierte automatische Warnmeldungen, wenn die KI-gestützte Helios-Plattform Anomalien in den Sicherungsdaten erkennt, die auf einen bevorstehenden Angriff hinweisen könnten. Sobald die SOAR-Plattformen von Cohesity gewarnt werden, initiieren sie ein automatisiertes Playbook, um die Auswirkungen eines potenziellen Cyberangriffs einzuschätzen und abzumildern.

Diese Funktionen greifen für alle Workloads und somit auch für die angekoppelte Kubernetes-Umgebung.

Auf erfolgreiche Angriffe reagieren

Selbst die beste Abwehrstrategie kann versagen. Bei einem erfolgreichen Ransomware- oder Wiper-Angriff wird das Licht in der Firma ausgeknipst, im sprichwörtlichen Sinn. Im Ernstfall funktioniert nichts mehr. Kein Telefon, keine E-Mail, keine Tür, geschweige denn die Webseite. Die IT-Teams der CIOs und CISOs werden auf diese Attacke nicht einmal reagieren können, da alle Sicherheits-Tools offline, Beweise in Logs und auf den Systemen verschlüsselt sind. Niemand wird sein Team zusammentelefonieren können, da VoIP nicht arbeitet.

Auf Basis der beschriebenen Data Cloud Platform dagegen können die Infrastruktur-und Seucrity-Teams gemeinsam einen isolierten Cleanroom etablieren, in dem ein Notfallset an Tools und System- und Produktionsdaten liegt, darunter dann auch die Kubernetes-Backups. In diesem Reinraum können die IT-Teams einen Notbetrieb der Gesamt-IT schaffen. Darin liegen alle wichtigen Tools für die Security-Teams, damit diese mit dem essenziellen Incident-Response-Prozess beginnen können. Dieser Prozess ist zudem wichtig, um richtige und aussagekräftige Berichte für NIS-2, DORA und DSGVO-Verstöße zu generieren. Vom Reinraum aus kann die Produktionsumgebung inklusive Kubernetes schrittweise und in enger Abstimmung mit den Infrastrukturteams mit gehärteten, sauberen Systemen wiederhergestellt werden.

Dem Charakter von Kubernetes gerecht werden

Firmen können ihre Container-Umgebung mit der Data Cloud Plattform absichern, da die Plattform für Kubernetes-basierte Workloads das gleiche Maß an Ausfallsicherheit und Flexibilität wie für alle anderen geschäftskritischen Workloads in der Multi-Cloud bietet.

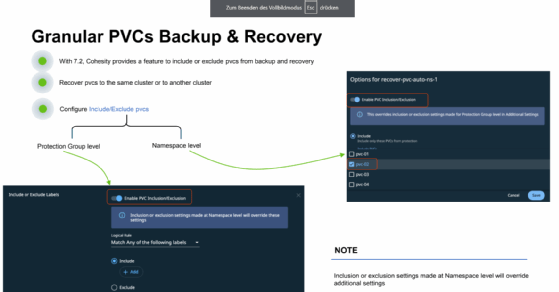

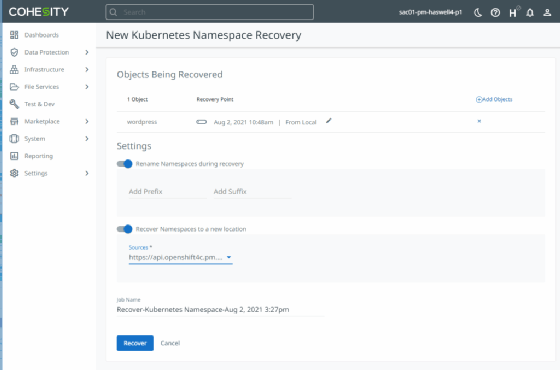

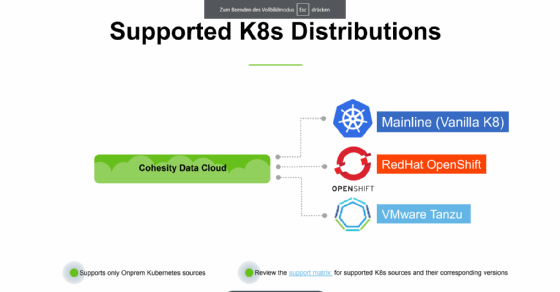

Die Lösung bietet Backup und Wiederherstellung unter Nutzung von CSI-Snapshots (Container Storage Integration). Cohesity PODs (ein Bereitstellungsobjekt in Kubernetes, das einen oder mehrere Container enthält) werden für eine bessere Leistung auf jedem Worker-Knoten des Kubernetes-Clusters bereitgestellt. Es soll leistungsstarken, richtliniengesteuerten automatischen Schutz, Deduplizierung, Replikation und Archivierung von Daten für Backup- und Disaster-Recovery-Zwecke bieten. Darüber hinaus werden eine Reihe von Distributionen unterstützt, darunter Openshiftund VMware Tanzu für Backup und Wiederherstellung.

Zudem berücksichtigt die Plattform weitere wichtige Merkmale wie:

- Anwendungszentrierung: Man muss nicht nur Daten, sondern auch alle zugehörigen Metadaten sichern, damit die Anwendung bei der Wiederherstellung ohne zusätzliche Schritte hochfährt. Ein Container enthält Geschäftslogik und Bereitstellungslogik; die Backup-Software muss beides kennen.

- Unternehmensbereitschaft: Die Standardanforderungen eines Unternehmens gelten auch weiterhin für Kubernetes-Backups und -Wiederherstellung, einschließlich der Möglichkeiten zur Durchführung von Auto-Discovery, Auto-Protection und vollfunktionaler Wiederherstellung. Die Leistung ist weiterhin wichtig, damit Backup-Fenster eingehalten werden können und zeitnahe Wiederherstellungen für große persistente Datenmengen möglich sind.

- Schnelle, zuverlässige Wiederherstellung: Die Geschwindigkeit der Wiederherstellung ist entscheidend für größere Unternehmensanwendungen und Datenbanken, die mehrere Terabyte groß sein können. Das Erstellen von Snapshots und das effiziente Verschieben der Daten ist entscheidend. Es ist auch wichtig, die RPO- und RTO-Anforderungen von Anwendungen erfüllen zu können.

- Unterstützung für führende Distributionen: Obwohl die meisten Distributionen Kubernetes verwenden und den Standards entsprechen, ist es wichtig sicherzustellen, dass die Lösung in einer Hybridumgebung reibungslos funktioniert. Die am häufigsten verwendeten Distributionen sind OpenShift, VMware, Tanzu, Rancher oder PKS. Neben diesen Distributionen werden auch Kubernetes-Dienste in Public Clouds wie AWS EKS, Azure AKS und Google GKE verwendet. Es ist wichtig sicherzustellen, dass die Backup- und Wiederherstellungslösung diese verschiedenen Distributionen und Plattformen unterstützen kann.

- Integration in Container-native Tools: Wenn es um Kubernetes-Umgebungen geht, können sich die für Bereitstellung, Überwachung und Verwaltung verwendeten Tools und Mechanismen stark von den vorhandenen IT-Systemen unterscheiden. Helm, Prometheus und Grafana sind Beispiele für solche Tools. Die Integration dieser Tools in die Datenschutzsoftware kann den Benutzern das Leben erleichtern.

Die Menge an Workloads wird weiter zunehmen und die Applikationslandschaft in Firmen ist noch bunter. Daher ist entscheidend, dass die Backups und Wiederherstellung von Daten für alle Workloads auf gleiche Weise über dieselbe Konsole mit denselben Regeln ablaufen können. Damit hier für die Firma lebenswichtige Prozesse bei laufendem Angriff möglichst effizient ablaufen können. Aber das reicht noch nicht. Genauso wichtig ist es, den Infrastruktur- und Security-Teams einen gesicherten Raum zu bieten, wo sie gemeinsam auf den Angriff reagieren und Daten und Systeme in gehärteter Form in die Produktion zurückspielen können. Egal, um welche Workload es sich handelt.