jamesteohart/stock.adobe.com

Hammerspace Hyperscale NAS: Funktionsweise und Anwendungsfälle

Hersteller Hammerspace will mit seinem Hyperscale NAS vor allem KI-Umgebungen bedienen. Die disaggregierte Architektur soll dabei speziell enorme Skalierbarkeit bieten.

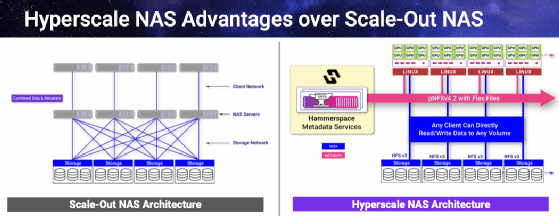

Das Hyperscale NAS von Hammerspace soll beispielhaft für eine neue Generation an NAS-Systemen stehen, die für leistungshungrige Umgebungen konzipiert wurde wie beispielsweise KI- GPU-Computing sowie HPC und Trainingsmodelle für LLMs und generative KI. Das System soll die Nachteile herkömmlicher Scale-Out-NAS- und HPC-File-Systemen überwinden, die entweder nicht die hohe Leistung oder Skalierbarkeit bieten können oder schlicht zu teuer sind.

Dabei nutzt das Hyperscale NAS Standardprotokolle wie NFS, ermöglich parallele Prozesse und erreicht durch die Zertifizierung von NVIDIA eine optimale Nutzung von GPU-Ressourcen.

Parallelität ist essenziel: Die Rolle von NFS

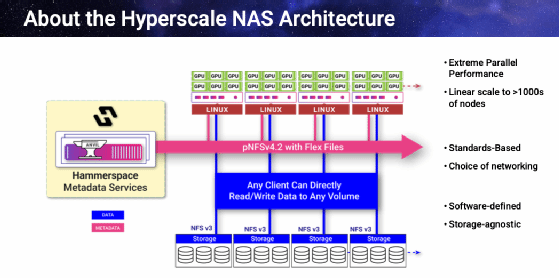

Hammerspace Hyperscale NAS verwendet paralleles NFS (pNFS) auf einem Linux-Client in der Version 4.2 und in der Storage-Ressource in Version 3. Darüber hinaus kommt der Modus Flex Files zum Einsatz. Dadurch lässt sich eine hohe Performance erreichen, da simultane Prozesse verarbeitet werden. Das File System nutzt die Vorteile der Parallelität. Dazu gehören:

- Getrennte Metadatenserver: Bei Scale-up- und Scale-out-NAS wurden die Metadaten vom selben System und über denselben Pfad wie die Dateidaten bereitgestellt. Das parallele Dateisystem verlagert die Metadatendienste auf separate Server, so dass Metadaten und Dateidaten nicht mehr um denselben Datenpfad konkurrieren mussten.

- Direkter Datenzugriff: In einem NAS mussten die Daten oft viele Schichten (Layers) der Systemarchitektur durchlaufen oder von Knoten zu Knoten springen, bevor sie am Host ankamen, was zusätzlichen Zeit und Overhead bedeutet. Hier bietet das File System einen direkten Pfad für Daten in Speicherservern zur Rechenumgebung, was unnötige Datenübertragungen vermeidet und den Datenzugriff beschleunigt.

- Hohe Skalierbarkeit: Mit direktem Zugriff auf Daten und separaten Metadatenservern kann durch das Hinzufügen von Knoten zu einem Cluster die Bandbreite für den Datenzugriff vervielfacht und die Dateizugriffsleistung erheblich verbessert werden.

Diese Fähigkeiten sind in den letzten Jahren NFS hinzugefügt worden und pNFS unterstützt nun Parallel File System (PFS) über NFS. Das Gremium für den Standard hat verschiedene Modi definiert, darunter Flex Files, das die Verwendung von eigenständigen NFSv4.2-Metadatenservern mit NFSv3-Speicherservern ermöglicht und den direkten Zugriff auf Daten und Dateispeicher unterstützt. Dadurch lässt sich hohe Skalierbarkeit und Performance erreichen, ohne dabei proprietäre Client-Software oder zusätzliche Netzwerke nutzen zu müssen. Unternehmen können jetzt ihre Standard-Linux-Server weiter einsetzen, auf denen die Anwendungen laufen.

Hyperscale NAS kann Exabytes an Speicherkapazität unterstützen, mit Milliarden Dateien, die in multiplen Dateisystemen oder Directories gespeichert sein können. Dabei kann die Lösung hohe Leistung und Durchsätze gewährleisten, was zu schnellem Zugriff auf Metadaten und schnellen Schreib-/Leseprozessen führt.

Die Architektur von Hyperscale NAS

Ein typisches Hyperscale-Cluster besteht aus einem Anvil NFSv4.2 Metadatenserver, Data Service Nodes (DSX) und entweder einem herkömmlichen NAS (Scale-up oder Scale-out) oder Standardhardware als Storage-Server. Flex Files wird wie bereits erwähnt als Teil des NFS-Supports innerhalb eines Linux-Kernels zur Verfügung gestellt.

Nachdem das Hyperscale NAS installiert ist, startet es eine Data-in-Place-Migration, um jeden NAS-Speicher, der für die Nutzung konfiguriert wurde, einzubinden. Dieser Metadaten-Assimilierungsprozess schreibt Dateimetadaten von aktuellen Speichersystemen in Anvil-Servern. Noch bevor die Metadaten-Assimilation abgeschlossen ist, kann die IT-Abteilung File Shares und Mount Points auf Hyperscale NAS verweisen und alle Funktionen von pNFS Flex Files im Rechenzentrum nutzen, wodurch die bestehende NAS-Infrastruktur in ein hochleistungsfähiges paralleles File System umgewandelt wird. Die Konsistenz von Datenänderungen wird dadurch gewährleistet, indem die Metadaten kontinuierlich synchronisiert werden, auch über mehrere Standorte hinweg. Wenn eine Datei aktualisiert wird, müssen nur die Metadaten synchronisiert werden, damit die Benutzer weltweit Zugriff auf die aktuelle Version der Daten haben. Wenn eine Datei aktualisiert wird, müssen nur ihre Metadaten synchronisiert werden, damit die Benutzer global Zugriff auf die aktuelle Version der Daten haben.

Der Hersteller gibt folgende Vorteile an, die den Anwender sofort nach der Implementierung zur Verfügung stehen:

Standortflexibilität für Dateien: Der physische Speicherort der Dateidaten wird von Hyperscale NAS kontrolliert und ist völlig unabhängig von Verzeichnispfaden und Dateisystemkonstrukten.

Hohe Hardwareskalierbarkeit: IOPS, Bandbreite und Kapazität kann durch einfaches Hinzufügen von Storage-Hardware erfolgen.

Optimierte Performance: In den meisten Fällen lässt sich die Zugriffsleistung allein dadurch verbessern, wenn ein herkömmliches NAS mit Hyperscale NAS bereitgestellt wird.

Lineare Performance-Skalierbarkeit: Durch die lineare Skalierung kann jede Performance-Anforderung bedient werden.

Infrastruktureffizienz: Nahezu 100 Prozent der Leistung der zugrunde liegenden Speicher-, Server- und Netzwerkinfrastruktur werden zur Unterstützung des Datenzugriffs für die Compute-Umgebung bereitgestellt.

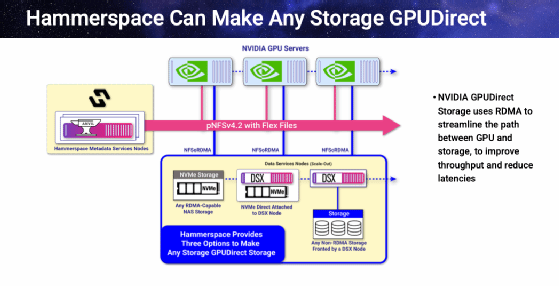

Hyperscale-NAS-Clients können auf jedem Linux-Server betrieben werden, der Linux 5.15 und 6 sowie RHEL 7.7 und höher unterstützt. Darüber hinaus hat Hammerspace sein Hyperscale NAS für die Unterstützung von NVIDIA GPUDirect Storage zertifiziert. Damit können GPUs über den PCI-Bus des Servers direkt auf Daten zugreifen, ohne dabei das CPU-Memory passieren zu müssen. Ebenso verfügt Hyperscale NAS über das Container Storage Interface (CSI), was gemeinsame Lese-/Schreibzugriff für alle Benutzer und Anwendungen in K8S-Clustern ermöglicht. Für die Netzwerkanbindung bietet Hyperscale NAS sowohl Ethernet als auch InfiniBand, einschließlich des RDMA-Protokolls.

Die Anvil-Metadatenserver und die DSX-Server können auf Bare-Metal-Servern, virtuellen Maschinen, in Containern oder jeder Cloud ausgeführt werden, beispielsweise in AWS, Google Cloud, Azure oder in einem beliebigen Cloud-NFS-Speicher. Beide Server laufen zudem unter VMware und Hyper-V und unterstützen fast jedes verfügbare NAS-System, inklusive Windows File Server.

Die Anvil-Metadatenserver werden in der Regel in Hochverfügbarkeits-Paaren eingesetzt, die alle Metadaten zwischen sich spiegeln. Anvil-Metadatenserver können auch an entfernten Standorten bereitgestellt und gespiegelt werden.

Global Data Environment: Ein globaler Namensraum für Daten

Global Data Environment (GDE) basiert auf Hyperscale NAS und baut auf einem globalen Dateisystem auf, das Daten aus beliebigen Speichersilos in einem einzigen Dateisystem vereint und alle Daten unter einem einzigen globalen Namensraum präsentiert. Der erwähnte Linux-Client greift mittels pNFS über SMB, NFS oder S3 auf Daten zu und kann die Vorteile eines parallelen File Systems bieten. Dies ist beispielsweise nützlich für das Training von GenAI-Modellen, bei der Zusammenarbeit bei der Videobearbeitung und beim Rendering oder bei HPC-Analysen. GDE ermöglicht es Unternehmensanwendungen, auf Daten zuzugreifen, die sich an mehreren Standorten befinden, und dies von multiplen Lokationen aus.

Ein GDE kann auf 16 verschiedene Standorte entweder lokal oder in der Cloud verteilt werden, die jeweils aus einem Hyperscale-NAS-Cluster mit einem Paar Anvil-Metadatenservern und DSX-Servern bestehen und vorhandene Speicherknoten nutzen. Jeder Hyperscale NAS-Cluster kann von einigen wenigen Speicherservern bis hin zu Tausenden von Servern pro Standort reichen.

GDE ermöglicht allen Standorten, beispielsweise im Rechenzentrum, in Clouds, Colocation-Zentren oder Edge-Clustern, gemeinsamen Zugriff dieselben Dateidaten. Entsprechend den definierten Zugriffsrechten kann von jedem Standort auf die gleichen File Shares, Directories und Dateien zugegriffen werden. Müssen zum Beispiel Daten lokal an ein Compute-Cluster transferiert werden, verschieben Orchestrierungsrichtlinien nur die benötigten Daten auf Dateiebene dorthin, wo sie verarbeitet werden müssen. Diese Daten können weiterhin aktiv sein und von Benutzern und Anwendungen verwendet werden, auch wenn sie zwischen Standorten verschoben werden. Dateidaten können sogar für verschiedene Standorte bereitgestellt und an andere Standorte verschoben werden, sobald die lokale Verarbeitung abgeschlossen ist. Dabei handelt es sich nicht um Dateikopien, sondern um Instanziierungen derselben Datei mit denselben Dateimetadaten.

Unternehmen, die über ein SMB-Storage im eigenen Rechenzentrum oder in der Cloud (S3 Object Storage) verfügen, können DSX-Server vor diesen Speicher schalten und diese Daten mit den Daten in einem Hyperscale NAS zu einer globalen Datenumgebung (GDE) zusammenfassen.

Objective Policy Management

Teil der GDE ist das Objective Policy Management, das Datenmanagement, Governance und Orchestration bereitstellt. Damit lassen sich Dateiveränderungen und -versionierungen nachverfolgen und Dateien näher an die Server bringen. Darüber hinaus kann der Administrator Snapshots planen, verschlüsselte und komprimierte WORM-Kopien anlegen, Daten-Workflows automatisieren und Antivirus-Scans durchführen. Dadurch lassen sich Compliance, Governance und Richtlinien einhalten. Die Data Protection für Storage-Server lässt sich ebenso erhöhen, indem Datenspiegelung oder RAID-ähnliches Erasure Coding zum Einsatz kommen. Damit sind die Daten auch dann verfügbar, wenn mehrere Storage-Server ausfallen.

Anwendungsmöglichkeiten

Aufgrund der einfachen Skalierbarkeit und der guten Performance sowie der GPU-Unterstützung ergeben sich zahlreiche Anwendungsoptionen, zum Beispiel in Bereichen, in denen bislang HPC- und Scale-Out-NAS-Systeme zum Einsatz kamen.

KI-Trainingsmodelle

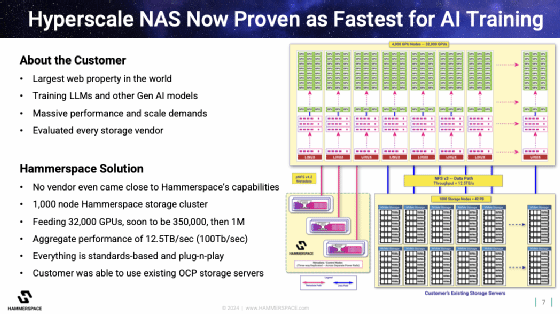

Der Hersteller sieht unter anderem Potenzial für seine Lösung im KI/ML-Trainingsbereich und führt hier als Beispiel einen seiner Kunden an, der Hyperscale NAS als Unterstützung für das Training ihres GenAI Large Language Model benutzt.

Im Rechenzentrum des Kunden fungieren Linux-Rechner als Speicherknoten, auf denen NFS-Software mit NVMe-SSDs betrieben wird. Das Rechenzentrum des Kunden ist in drei separate Stromversorgungs- und Netzwerkzonen aufgeteilt, und Hyperscale NAS Anvil-Metadatenserverpaare werden in drei Richtungen über diese Zonen hinweg repliziert. Alle Hosts haben mehrere GPUs angeschlossen. Die GPUs sind die größten Infrastrukturkosten des Unternehmens, und der Kunde wollte alle GPUs beim Training großer KI-Modelle voll ausnutzen.

Andere Speichersysteme konnten die Zugriffsleistung nicht gewährleisten, die benötigt wurde, um die GPU-Farm auszulasten und gleichzeitig in den vordefinierten standardbasierten Architekturansatz zu passen. Für das Training von GenAI LLM werden die neuronalen Netzwerke auf mehrere GPUs und mehrere Hosts verteilt. In den meisten GenAI-Trainingsumgebungen sind an die Host-Systeme in der Regel sechs oder mehr GPUs angeschlossen. Daher lesen viele GPUs und die Server, auf denen sie laufen, wiederholt die gleichen Trainingsdaten. Das Unternehmen nutzt Hyperscale NAS, um Trainingsdaten auf mehrere Speicherserver zu duplizieren, von denen jeder in der Lage ist, mehreren Host-Servern gleichzeitig direkten Datenzugriff zu bieten. Durch den Einsatz von Hyperscale NAS war die Firma in der Lage, den LLM GenAI-Trainingsdurchsatz über 32.000 GPUs zu erreichen. Dafür wurden etwa 1.000 Speicherserver auf standardmäßig geroutetem Ethernet mit TCP/IP-Konnektivität eingesetzt, um einen anhaltenden Durchsatz von 12 TB/s zu erreichen.

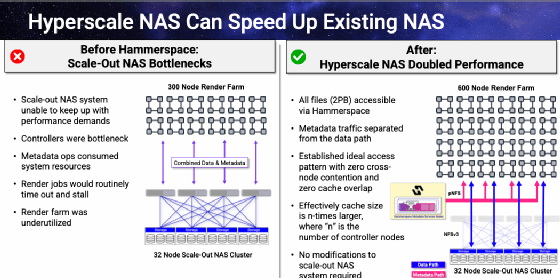

Große Rendering-Farmen (NAS-Optimierung)

Andere leistungshungrige Branchen sind unter anderem die Film- und Unterhaltungsindustrie, Videospezialisten oder bildbearbeitende Firmen wie beispielsweise Unternehmen mit Rendering-Farmen.

Hammerspace konnte hier einer Produktionsfirma für visuelle Effekte mit der NAS-Leistung helfen und diese mit Hyperscale optimieren. Der Kunde hat eine Scale-Out-NAS-Lösung mit 32 Knoten, 2PB-500M-Dateien, an ihre Rendering-Farm mit 300 Servern angeschlossen.

Da Rendering-Aufträge aufgrund mangelnder I/O-Leistung des vorhandenen NAS-Speichers zeitlich verzögert abliefen, musste die Anzahl der Knoten in der Rendering-Farm reduziert werden, was zu einem Rückgang des Rendering-Durchsatzes unter die für das Rechenzentrum festgelegten Spezifikationen führte. Das Studio hatte die Entscheidung zwischen mehr Scale-out-NAS-Knoten, einer neuen NAS-Lösung oder Hyperscale NAS.

Mit Hyperscale kann das Unternehmen weiterhin seine vorhandene Speicherhardware in Kombination mit einem Paar Anvil-Knoten und zwei DSX-Server einsetzen. Nach der Assimilierungsphase für die Metadaten verbesserte sich die Zugriffsleistung und das Studio konnte ohne I/O-Ausfälle wieder auf 300 Knoten skalieren. Die Daten liegen weiterhin auf dem bereits vorhandenen NAS-System, jedoch transformiert Hyperscale NAS die bestehenden NAS-Knoten zu separaten Speicherservern (unter einem globalen Namensraum), der den Hosts Datenzugriff ermöglicht. Das Studio plant bereits eine Verdoppelung seiner Nodes für die Rendering-Farm.

Mit einer ähnlichen Installation lässt sich zudem aus jedem Storage GPUDirect-fähig machen. Das wird durch RDMA erreicht, um den Pfad zwischen GPU und Storage zu optimieren. Das wiederum führt zu verringerten Latenzzeiten und höherem Durchsatz.

Hammerspace will mit seinem Hyperscale NAS eine Alternative zu herkömmlichen NAS-Systemen bieten und leistungsfähige Lösungen für HPC-Umgebungen und andere leistungshungrige File-Server-Architekturen bieten. Damit stellt das Produkt Konkurrenz zu den traditionellen NAS-Anbietern wie NetApp, HPE oder Dell und zu traditionellen HPC-Lösungen wie Panasas und WekaIO dar.