fredmantel - Fotolia

Emotion AI: Wie das Erkennen von Gefühlen Firmen antreibt

Künstliche Intelligenz war gestern. Emotion AI, die Erkennung von Gefühlen mit KI, gehört laut Gartner die Zukunft. Doch was steckt hinter dem Trend?

Jeder weiß, was Emotionen sind. Möchte man den Begriff aber definieren, herrscht Uneinigkeit. Einige Forscher sehen in Emotionen körperliche Reaktionen, die sich in der menschlichen Evolution entwickelt haben, um das Überleben zu sichern. Andere betrachten sie als mentale Zustände, die einsetzen, wenn das Gehirn körperliche Reaktionen repräsentiert. Für manche sind sie bewusste Bewertungen, andere sehen in ihnen unbewusste Impulse.

Eine abschließende, allgemeingültige Definition ist in diesem Diskurs praktisch unmöglich. Emotionen stellen ein komplexes Gebilde von bewussten oder unbewussten Reaktionen des Menschen dar. Genauso komplex wie ihre Beschreibung ist das Ziel einer jungen Forschungsdisziplin im Bereich der künstlichen Intelligenz (KI): Affective Computing.

KI-Technologie wird erwachsen

KI-Technologie galt für viele Marktbeobachter und IT-Experten schon als Kind, das nie erwachsen wird. Seit einigen Monaten erlebt KI allerdings einen Boom, der durch Entwicklungen bei neuronalen Netzwerk- und Machine-Learning-Technologien angetrieben wird. Einige Analysten sehen darin den Schritt, der KI reifen und erwachsen werden lässt.

Wie der Begriff neuronales Netz vermuten lässt, wird in der Computational Neuroscience und Informatik versucht, vereinfachte Modelle der biologischen Vernetzung neuronaler Zellen zu imitieren. Da die Strukturen und Netzwerke künstlich nachgebildet werden, spricht man von künstlicher Intelligenz.

Allerdings fehlt in diesem Puzzlespiel noch ein entscheidendes Teil: der Aspekt der menschlichen beziehungsweise emotionalen Intelligenz. Ein erster Schritt in dieser Entwicklung ist, Maschinen und Geräte so zu entwickeln, dass sie menschliche Gefühle erkennen und darauf reagieren können.

„Strategische Technologieplaner der Gerätehersteller müssen in die Entwicklung von KI-Systemen investieren, die es den Geräten ermöglichen, menschliche Gefühlszustände zu erkennen und darauf zu reagieren“, schreibt Annette Zimmermann, Research VP bei Gartner in einem Gartner-Bericht. Darüber hinaus sollten die Unternehmen „in die neuen Geschäftsmöglichkeiten und Anforderungen [investieren], die sich daraus ergeben.“

In dem Bericht analysieren Zimmermann und ihr Kollege Anshul Gupta, wie künstliche Intelligenz und Affective Computing mehr personalisierte Interaktionen mit Geräten ermöglichen. Diese persönliche Interaktion mit dem Gerät und die KI-Algorithmen, die eine "menschlichere" Zusammenarbeit mit der Maschine erlauben, fassen die Gartner-Analysten unter dem Begriff Emotion AI zusammen.

KI wird zum Game Changer

Die Marktchancen und Anwendungsmöglichkeiten dieser Technologien sind laut Zimmermann gewaltig, wobei die Analystin künstliche Intelligenz als „Game Changer für Personal Devices“ bezeichnet. „Bis 2022 wird Ihr persönliches Gerät mehr über Ihren emotionalen Zustand wissen als Ihre eigene Familie“, lautet ihre Prognose.

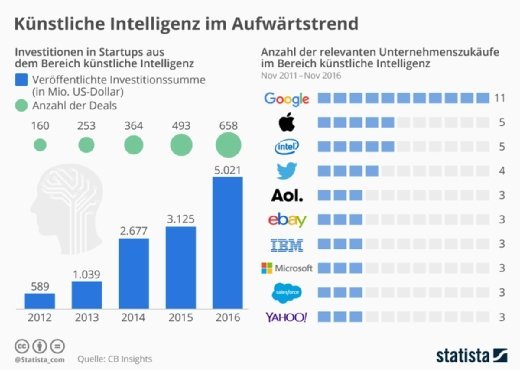

Auch wenn diese Aussage plakativ erscheint, so sehen sich Zimmermann und ihre Kollegen durch die Liste an Unternehmen bestätigt, die in KI investieren oder sich durch Zukäufe ihr Know-how in diesem Bereich erweitern (siehe Abbildung 1).

Ein Augenmerk dieser Anbieter liegt auf Emotion AI. Neben Apple und Google (Cloud Vision API), die mit ihren KI-Investitionen vor allem auf den Konsumbereich abzielen, sehen die Analysten in IBM Watson einen Kandidaten für den Enterprise-Markt. Vor allem die Speech-to-Text- und Watson-Tone-Analyzer-Fähigkeiten sind nach Angabe der Gartner-Analysten hervorzuheben.

Insgesamt haben eine Reihe großer Player in Technologien investiert, die in der Lage sind, menschliche Gefühle zu erkennen. Neben den genannten Anbietern zählt Annette Zimmermann Facebook (Gesichtserkennung), Intel (RealSense und Real Speech), SoftBank Robotics (Pepper) und Samsung als Beispiel für große Firmen auf, die Fähigkeiten zur Erkennung von Emotionen entwickeln oder zukaufen.

Praktisch all diese Organisationen haben in den letzten 24 Monaten Start-ups übernommen, die Ressourcen mit einem Schwerpunk künstliche Intelligenz und Emotion AI aufgebaut haben. Häufig sind es diese Start-ups, die eigene Nischen mit ihren KI-Entwicklungen besetzen möchten und die Erforschung in Affective Computing antreiben.

Emotion AI soll Benutzererfahrung verbessern

„Prototypen und kommerzielle Produkte existieren bereits, und das Hinzufügen von emotionalem Kontext durch die Analyse von Datenpunkten aus Mimik, Sprachmelodie und Verhaltensmustern wird die Benutzererfahrung signifikant verbessern“, erklärt Roberta Cozza, Research Director bei Gartner. „Über Smartphones und angeschlossene Endgeräte hinaus erfassen, analysieren und verarbeiten Wearables und verbundene Fahrzeuge die emotionalen Daten der Nutzer über Computer Vision, Audio oder Sensoren, die Verhaltensdaten erfassen, um sie an die Wünsche und Bedürfnisse der Nutzer anzupassen oder darauf zu reagieren.“

Emotion AI wird nach Ansicht von Cozza und Zimmermann vor allem durch die Entwicklung neuer Smart Devices angekurbelt. Allerdings müssen die entwickelnden Unternehmen noch einige Anstrengungen unternehmen, um auf diesem Markt überleben zu kennen. Exemplarisch zählen sie drei Bereich auf, die nach Ansicht der Analysten weiterentwickelt werden müssen: virtuelle persönliche Assistenten (VPA), persönliche Assistenzroboter sowie Wearables und Business-Services.

Der wichtigste Bereich umfasst virtuelle persönliche Assistenten, wie zum Beispiel Siri, Cortana oder Google Assistant. Diese reagieren derzeit fast ausschließlich auf Fragen. „Das muss sich ändern, um eine bessere und natürlichere Benutzererfahrung zu erhalten“, erklärt Zimmermann.

Gleichzeitig verweist sie auf die Bekanntgabe von Amazon, künftig auf die Speech Synthesis Markup Language (SSML) für seinen VPA Alexa zu setzen. Diese erlaubt es Entwicklern, Skills zu programmieren, so dass Alexa zum Beispiel mit Phrasen und menschlichen Ausdrücken reagiere kann.

„Wir erwarten, dass Amazon und Google an Technologieverbesserungen arbeiten, die ihren VPA-Lautsprechern ermöglichen, zwischen verschiedenen Nutzern zu unterscheiden, ihren Gefühlszustand zu erkennen und darauf zu reagieren“, erläutert die Analystin.

Persönliche Assistenzroboter, darunter Sanbot oder Pepper von Softbank, werden laut Zimmermann in Zukunft ebenfalls stärker vermenschlicht, so dass sie auf menschliche Emotionen reagieren können. „Wie auf der Cebit 2017 zu sehen war, kann der Roboter [Pepper, Anm. d. Red] auf verschiedene Arten reagieren, abhängig davon, ob der Benutzer freundlich oder unhöflich zu ihm ist, während er eine Frage oder einen Befehl formuliert.“

Im Enterprise-Umfeld beginnen Unternehmen ebenfalls damit, Technologien einzusetzen, die Gefühle erkennen. Denkbare Anwendungsfelder sind die Interaktion mit Kunden, die Entwicklung sichererer Arbeitsbedingungen oder neuer Geschäftsmodelle.

„Das Unternehmen Beyond Verbal Communication hat eine Technologie auf Basis von Sprachanalyse entwickelt, die menschliche Gefühle unterscheiden und in neun Hauptgruppen kategorisieren kann“, erläutert Annette Zimmermann.

Unternehmen können die Lösung im Call Center einsetzen, um herauszufinden, wie sich Emotionen während eines Gesprächs mit einem Kunden verändern. Die Erkenntnisse lassen sich einsetzen, um die Interaktion mit dem Kunden zu verbessern. Interessenten können die Technologie über die kostenlose App Moodies Emotions Analytics testen.

Die Einsatzmöglichkeiten von Technologien mit Emotion AI sind zahlreich. Allerdings müssen die strategischen Planer in den Unternehmen diese verstehen und sich mit den zentralen Anbietern auseinandersetzen.

Gleichzeitig müssen die Anbieter ihr vorhandenes Portfolio weiterentwickeln, um eine natürlichere Interaktion mit den Menschen zu erreichen. Dabei werden die Unternehmen erfolgreich sein, die trotz der Komplexität menschlicher Gefühle, einfache Lösungen für den Anwender bereitstellen.

Anmerkung der Redaktion: Lesen Sie auch das Interview mit Annette Zimmermann Maschinen müssen zwangsläufig emotional intelligent werden.