Elnur - stock.adobe.com

Dezentrales Deep Learning bietet neuen Modelltrainingsansatz

Das Training von Deep-Learning-Modellen stellt eine große Belastung für die Infrastruktur von Unternehmen dar. Ein dezentraler Ansatz kann das Problem lösen.

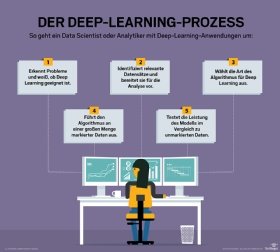

Das Training von Machine-Learning- und Deep-Learning-Modellen erfordert massive Rechenressourcen. Federated Deep Learning, also ein dezentraler Lernansatz, bietet eine Möglichkeit, Modelle für künstliche Intelligenz (KI) über verteilte Clients zu trainieren und dadurch die Belastung der Unternehmensinfrastruktur zu verringern.

Zum Beispiel verwenden die Entwickler bei Google, die an Android arbeiten, Federated Deep Learning, um die Leistung von Spracherkennung und prädiktiven Textanwendungen für Smartphones so zu optimieren, dass Datenschutzbedenken abgebaut, die Modellleistung erhöht und der Kommunikationsaufwand reduziert wird.

„Dezentrales Deep Learning ist die neue Front in der künstlichen Intelligenz (KI), bei dem man die massive Rechenleistung, die in Form von verteilten Geräten zur Verfügung steht, wirksam einsetzt und dadurch ermöglicht, dass Lernen lokal, privat und dennoch relevant ist“, sagt Ramya Ravichandar, Vice President of Product Management bei FogHorn Systems, einem Anbieter von Plattformen für das Internet der Dinge (Internet of Things, IoT).

Traditionelle KI-Ansätze erfordern leistungsstarke Rechenressourcen, bei denen Trainingsdaten aus allen Quellen aggregiert und die Modelle trainiert werden. Beim Federated Deep Learning nutzen die Entwickler die Rechenleistung der einzelnen Geräte, um den Lernprozess zu verteilen. Und da Daten niemals das Gerät verlassen, von dem sie stammen, kann der Ansatz dazu beitragen, den Datenschutz der Benutzer zu erhöhen.

„Dezentrales Lernen kann bei Deep-Learning-Problemen oder eher traditionellen Machine-Learning-Problemen angewendet werden“, sagt Mike Lee Williams, Research Engineer bei Cloudera Fast Forward Labs. „Deep Learning ist cool und kann präziser sein als herkömmliches Machine Learning, doch man braucht einen guten Grund, es einzusetzen, da es eine technische Komplexität mit sich bringt und möglicherweise spezielle Hardware erfordert.“

Ein neues Paradigma

Die meisten vorhandenen KI-Tools trainieren mit Daten in der Cloud und übertragen dann optimierte Algorithmen auf die Geräte. „Mit Federated Deep Learning besteht keine Notwendigkeit, dass Trainingsdaten komplett an einen zentralen Datenspeicher gesendet werden müssen“, sagt Ravichandar.

Die Ansätze können bezogen darauf variieren, welche Edge Subsets in die Trainings-Updates aufgenommen werden sollen, wie diese Aktualisierungen zu erfassen sind, wann ein Training gestartet wird und wann das neue Modell allen Anwendern zur Verfügung gestellt werden soll. All diese Ansätze variieren je nach Use Case und Anwendung.

Ravichandar sieht dezentralen Lernens auf dem Mobilfunkmarkt vor allem dort, wo die Endpunkte Mobilgeräte mit KI-Chips sind. Viele der Techniken, die es gibt, konzentrieren sich auf dieses Segment. Wenn man die Industriesektoren betrachtet, in denen die Endpunkte Netzwerk-Gateways oder speicherprogrammierbare Steuerungselemente sind, die in der Fertigung eingesetzt werden, dann unterscheiden sich die Machine-Learning-Modelle, die dezentrales Lernen verwenden, deutlich.

In industriellen Umgebungen ist die Anzahl der angebundenen Geräte möglicherweise nicht so hoch wie bei Consumer-Anwendungen. Außerdem ist die Einhaltung von Vorschriften und Regelungen rund um Fabriken und Anlagen rigide. Daher ist ein automatisierter Einsatz von Modellen – einer der wichtigsten Reize des Federated Deep Learning – ohne angemessene Prüfung und Zertifizierung nicht möglich.

ByteLake, ein KI-Beratungsunternehmen mit Sitz in Polen, hat vor kurzem in Zusammenarbeit mit Lenovo einen Proof-of-Concept für Predictive Maintenance veröffentlicht. Mit dezentralem Deep Learning können ByteLake und Lenovo das Werk in Echtzeit überwachen und die Ergebnisse im gesamten Werk oder sogar darüber hinaus aggregieren. Sie arbeiten auch an Algorithmen für die Telekommunikation.

„Dezentrales Deep Learning verändert die Art und Weise, wie wir KI-Lösungen gestalten“, sagt Marcin Rojek, Mitbegründer von ByteLake. Sein Team muss erforschen, wo und wie es die Daten sammelt und zunächst verarbeitet, wo das Training stattfinden soll und welche Edge Devices ein gewisses Maß an Intelligenz erhalten sollen.

„Die größte Herausforderung besteht darin, dass wir in vielen Fällen nicht nur versuchen, eine Katze oder einen Hund in einem Bild zu finden, sondern dass wir uns tief in die mathematischen Gleichungen neuronaler Netze einarbeiten müssen, um zu verstehen, wie wir die zugrunde liegenden Algorithmen im Netzwerk mit verschiedenen Geräte einsetzen können“, sagt Rojek.

Verschiedene Ansätze für Federated Deep Learning

Es gibt laut Sai Sri Sathya, CEO des KI-Start-ups S20.ai, Ansätze mit einer Partei oder mehreren Parteien für die Implementierung von dezentralen Deep-Learning-Algorithmen. In einem System mit nur einer Partei ist nur eine einzige Instanz an der Steuerung des verteilten Datenerfassungs- und Datenflusssystems beteiligt. Diese können in verschiedene Formen auftreten, wie zum Beispiel ein Smartphone oder eine IoT-Anwendung, Netzwerkgeräte, verteilte Data Warehouses oder Maschinen, die von den Mitarbeitern benutzt werden.

Die Modelle werden dezentral auf Daten trainiert, die auf allen Client-Geräten die gleiche Struktur haben, und in den meisten Fällen ist jeder Datenpunkt für das Gerät oder den Benutzer einzigartig. Beispielsweise kann eine Musikempfehlungsanwendung, die Musik für eine bestimmte App empfiehlt, auf diese Weise dezentralisiert werden.

In einem System mit mehreren Parteien bilden zwei oder mehr Organisationen einen Verbund, um durch dezentrales Lernen ein gemeinsames Modell auf ihre individuellen Datensätzen zu trainieren.

„Die Geheimhaltung von Daten ist hier der größte Mehrwert des dezentralen Lernens für jede der beteiligten Einheiten, um ein gemeinsames Ziel zu erreichen“, sagt Sathya. Das liegt daran, dass die Daten niemals ihren ursprünglichen Speicherort verlassen oder mit Daten der anderen Entität kombiniert werden.

Eine neutrale Drittpartei kann hierfür in die Bereitstellung der Infrastruktur einbezogen werden, um die Modellgewichte zu aggregieren und Vertrauen zwischen den Kunden aufzubauen. Beispielsweise können mehrere Banken ein gemeinsames Betrugserkennungsmodell trainieren, ohne ihre sensiblen Kundendaten durch dezentrales Deep Learning miteinander zu teilen.

Herausforderungen für Federated Deep Learning

„Da der Erfolg des dezentralen Deep Learning von der Menge der teilnehmenden Geräte abhängt, ist die größte Hürde die Orchestrierung aller Akteure“, sagt Ravichandar von FogHorn.

KI-Entwickler müssen auch die Art und Weise und die Häufigkeit berücksichtigen, mit der Modelle ausgetauscht werden, so Williams von Cloudera. Dazu gehört es, die relative Bedeutung von Dingen wie der Privatsphäre und der begrenzten Rechenressourcen auf Edge Devices abzuwägen.

Auch die Toolsets sind neu. „Wenn man gesetzlich verpflichtet ist, die Privatsphäre zu wahren, dann müssen Sie vorsichtig vorgehen und sicherstellen, dass Sie die Garantien und Risiken verstehen“, erklärt Williams.

„Eine weitere große Herausforderung besteht darin, dass verteilte Systeme in der realen Welt kompliziert und empfindlich sind“, sagt er. KI-Entwickler müssen ein System aufbauen, das mit den unvermeidlichen Problemen in diesem Zusammenhang umgehen kann, wie zum Beispiel Edge Devices, die nur langsam reagieren (einige Leute haben langsame Smartphones) oder ganz ausfallen (einige Leute schalten ihr Telefon nachts aus).

Williams ist überzeugt, dass die Frameworks es den Machine-Learning-Ingenieuren schließlich ermöglichen werden, einige dieser Herausforderungen zu verbergen und sich auf die Daten zu konzentrieren, so wie es ein Tool wie Spark im Rechenzentrum macht. „Aber so weit sind wir noch nicht“, sagt Williams.

Eine dezentrale Datenpipeline

Eine weitere Herausforderung besteht darin, dass für die Ausbildung von überwachten Modellen vor Ort klassifizierte Daten benötigt werden, die in vielen Fällen nicht verfügbar oder schwer zu erstellen sind.

„Eine gute Möglichkeit, dieser Herausforderung zu begegnen, besteht darin, das Problem zu definieren und [eine] Datenpipeline so zu gestalten, dass die Klassen implizit erfasst werden“, sagt Sathya. Beispielsweise können die Interaktionsdaten eines Benutzers aus durchgeführten Aktionen oder ausgelösten Ereignissen als Feedback für die Modellleistung verwendet werden.

Letztlich müssen die Entwickler darauf achten, den richtigen Anwendungsfall für dezentrales Deep Learning zu finden. Da die Konvergenzzeit für das Modell in einem dezentralen Setup im Vergleich zum traditionellen zentralen Trainingsansatz höher ist, können Zuverlässigkeitsprobleme aufgrund von Konnektivitätsproblemen, Variationen in den Nutzungsmustern und unregelmäßigen oder verpassten Aktualisierungen auftreten.

Laut Sathya sollte Federated Deep Learning nur dann in Betracht gezogen werden, wenn der Umfang der Daten und die Kosten für die Aggregation aus verteilten Quellen besonders hoch sind. Er sagt, dass die Denkweise, Daten zentral zu aggregieren, um Wettbewerbsvorteile zu erzielen, die sich im Big-Data-Zeitalter entwickelt hat, eine große Hürde ist, die die weit verbreitete Einführung von dezentralem Deep Learning bremst.

„Wirksame Datenschutzrichtlinien und geeignete Anreize und Geschäftsmodelle rund um die Dezentralisierung von Daten können diese Probleme angehen und das dezentrale KI-Ökosystem entwickeln“, erklärt der S20.ai CEO.