Maksym Yemelyanov - Fotolia

Block-, File- und Objekt-Storage per Schnittstelle integrieren

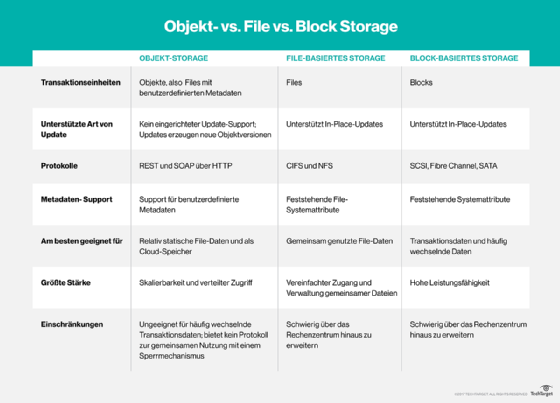

Block-, File- und Objektdaten sind häufig keine getrennten Welten mehr, sondern werden seit dem Aufkommen objektbasierter Cloud-Storage-Services zusammengeführt.

Lange kaufte die IT-Abteilung SANs für Block Storage, NAS für File Storage und Cloud Gateways für Objekt-Storage. Nun gibt es auf dem Markt Software-definierte Storage-Produkte, die alle drei Formate unterstützen. Im Folgenden werden einige dieser Produkte, ihre Arbeitsweise, ihre Stärken und ihre Schwächen durchleuchtet.

Block Storage hat die längste Tradition. Ursprünglich wurde dieser Storage-Typ verwendet, um auf die Festplatten in einem lokalen Server über hardwarebasierte Blocks, Sektoren und Spuren zuzugreifen. Später nutzten Block-basierte Storage-Systeme Software, wenn die Festplatten an physische Grenzen stießen, die durch das BIOS (Basic Input/Output System) und das Betriebssystem vorgegeben waren.

Als Anfang der siebziger Jahre des vergangenen Jahrhunderts die ersten File-Server entwickelt wurden, machten diese Block Storage als File Storage verfügbar, und zwar mit Hilfe von Storage-Protokollen wie Network File System (NFS) und Common Internet File System (CIFS). Beide präsentieren eine Dateihierarchie aus Verzeichnissen und einzelnen Dateien. Mit der Entwicklung serverbasierter Rechenzentren etablierten sich SANs als Block-basiertes Storage, das von mehreren Servern als Alternative zu interner oder direkt angebundenem Storage verwendet werden konnte. Dann machten NAS-Storage-Systeme diese Mittlerfunktion überflüssig und präsentierten File-Storage direkt den Anwendern, so dass keine separaten File-Server mehr nötig waren.

Objektbasiertes Storage ist ein relativ neues Konzept in der Entwicklung von Storage. Es behandelt jede Datei als separates Objekt, das die Datei selbst enthält und dazu Metadaten und eine einmalige Kennung. Die Metadaten enthalten Informationen wie Dateityp, Erstellungsdatum und Eigentümer.

Objekt-Storage

Der Vorteil eines objektbasierten Systems liegt darin, dass jede Datei auf vielfältigen Systemen, entweder im Rechenzentrum oder in der Cloud, liegen kann. Mittels der einmaligen Kennung kann Objekt-Storage die Files jederzeit lokalisieren, so dass Anwender auf die Objekte zugreifen können, egal, ob sie sich physisch auf einem lokalen File-Server, einem Storage-System im Rechenzentrum oder in der Cloud befinden. Das ist nicht trivial. Große Organisationen können Milliarden Objekte in Dutzenden unterschiedlicher Systeme weltweit speichern. Jedes dieser Objekte mit einer einmaligen Kennung zu versehen und diese zu verfolgen verschlingt umfangreiche Ressourcen.

Storage-Systeme kombinieren Block- und File-Funktionen schon seit Jahren. Ursprünglich brauchte Objekt-Storage Soft- oder Hardware-Gateways, um den Zugriff auf proprietäres Cloud-basiertes Objekt-Storage auf Cloud-Services wie Amazon S3 und Microsoft Azure zu eröffnen. Seit diese Services auf Protokolle wie S3 und OpenStack standardisiert wurden, werden Objekt-Storage-Services von diversen Cloud-Providern und als Funktion von On-Premises-Storage-Systemen für das Rechenzentrum angeboten.

Objekt-Storage ist virtualisiert. Dieselbe Datei kann also auf beliebig vielen lokalen oder Cloud-Systemen gespeichert werden. Alles hängt davon ab, wann das File zuletzt abgefragt wurde und welche Priorität beziehungsweise welche Regeln ihm vom Administrator zugewiesen wurden. Öffnet ein Anwender ein solches File, wird es normalerweise zurück auf das lokale Storage geschoben, weil dort die beste Leistung zu erwarten ist, wenn es modifiziert und gespeichert wird. Nach einer definierten Inaktivitätsperiode kann es wieder auf günstiges Cloud-Storage verlegt oder vielleicht bei einem mehrschichtigen Speichersystem von heißes auf warmes, dann auf kaltes und schließlich auf Cloud-Storage.

Die IT kann das Objekt-Storage auch so konfigurieren, dass sie Objekte über mehrere Storage-Silos verteilt – zum Beispiel auf zwei oder mehr geografische Regionen. So bleiben die Dateien verfügbar, wenn eine Lokation offline ist oder wegen Überlastung langsamer reagiert. Das Objekt-Storage-System verfolgt alle Änderungen und stellt sicher, dass Kopien synchronisiert werden.

Ein Objekt-Storage-Gateway entspricht einem Software-definierten WAN (SD-WAN), weil es auf Software basiert und keine spezielle Hardware benötigt. Ein Objekt-Storage-Gateway kann auf einem PC oder Server laufen. Wer Objekt-Storage in ein bestehendes SAN oder NAS integrieren möchte, muss die Architektur des Systems nicht ändern, sondern dem Virtualisierungs-System nur neue Software hinzufügen.

Die Integration von Objekt-Storage

Es gibt Storage-Systeme für größere Unternehmen, die SAN, NAS und Objekt-Storage kombinieren. Zu deren Herstellern gehören Dell EMC, Hewlett Packard Enterprise (HPE), Hitachi Vantara, IBM und NetApp. Weil ein Objekt-Storage-Gateway nur aus Software besteht, können die einmal entwickelten Objektfunktionen nahezu jedem Produkt aus dem Portfolio eines Storage-Anbieters hinzugefügt werden.

Einige Hersteller bauen ein Cloud-Gateway – ein Objekt-Gateway – in ihr Storage ein. Dann bietet eine einzige Box Block-, File- und Objekt-Storage. Andere verwenden getrennte Geräte, die mit ihrem Storage-Controller integriert sind. Ein typisches Einstiegssystem besteht aus einem Rack mit zwei Controllern, Storage-Knoten, Disk und Vernetzungshardware. Da macht es nicht viel aus, ob ein zusätzliches Gerät mit zwei Höheneinheiten Objekt-Storage ermöglicht. Worauf es ankommt, ist der Integrationsgrad des Objekt-Storage-Systems mit dem Storage-Management-System. Er beeinflusst auch, ob Storage in der Cloud aus Sicht eines automatischen Tiering-Systems als zusätzliche Storage-Schicht behandelt wird und ob sich ein Cloud-Volume einfach für Replikation, Deduplizierung, Verschlüsselung und andere Funktionen, die auf lokalem Storage basieren, konfigurieren lässt.

Folgend beschreiben wir, wie die Produkte unterschiedlicher Hersteller mit dem Thema Integration zwischen Block-, File- und Objekt-Storage umgehen. Vollständigkeit hinsichtlich der besprochenen Produkte ist dabei nicht angestrebt.

Dell EMC

Dell EMC hat heute Produkte der aufgekauften beziehungsweise fusionierten Anbieter Dell, EMC, Compellent, Isilon und Data Domain im Angebot. Alle haben noch immer getrennte Entwicklungsteams. Also findet man auch bei jeder Marke andere Funktionen und Strategien für Objekt-Storage. Das trifft natürlich auch auf HPE und seine Plattformen 3Par und Nimble zu.

Zur Produktlinie EMC VMAX, kürzlich in PowerMax umbenannt, gehört auch das Integrationstool CloudEnabler. Es verbindet ein VMAX-Storage-System und ein CloudArray-Gateway mit dem internen Storage und vielfältigen Cloud-Storage-Anbietern. Cloud-Storage wird wie physisches Storage innerhalb des Storage-Gesamtsystems des Rechenzentrums dargestellt.

Nachdem ein Storage-System konfiguriert und Cloud-Volumes hinzugefügt wurden, kann es Daten vom Rechenzentrum in die Cloud und zurück sowie automatisch und regelbasiert zwischen Storage-Schichten migrieren. Nahezu jede Funktion, die man innerhalb des Rechenzentrums oder zwischen Rechenzentren verwenden kann, beispielsweise Datei- oder Volume-Migration, lässt sich auch zusammen mit der Cloud verwenden. Das bedeutet, dass Block-Storage-Volumes oder Dateien im Rechenzentrum als Objekt-Stores in die Cloud repliziert werden können und umgekehrt. Effektiv gibt es hier keine Grenze zwischen den drei StorageTypen.

Hitachi Vantara

Hitachi Content Platform kann mit diversen Objekt-Stores verbunden werden, sei dies nun Ceph auf Hardware im selben oder einem anderen Rechenzentrum, Amazon S3, Commvault oder andere Public- oder Private-Cloud-Anbieter. Alle Funktionen, die das Storage-System Hitachi Vantara zur Verfügung stellt, sind auch für die Cloud-Volumes verfügbar. Das gilt auch für die Synchronisierung zwischen mehreren Volumes auf der Objekt-, File-, Block- und Volume-Ebene, Auto-Tiering, Kompression und Verschlüsselung. Eine einheitliche Management-Schicht liegt über allen Storage-Schichten.

HPE 3Par und Nimble

HPE Cloud Volumes stehen auf mehreren HPE-Storage-Systemen zur Verfügung, auch auf Nimble. Die Software unterstützt mehrere Cloud-Services, darunter AWS S3 und Azure. Weil die Verbindungen durch HPE-Dienste implementiert werden, rechnet HPE zusätzliche monatliche Kosten zu denen des Cloud-Anbieter ab.

IBM

IBM hat sowohl proprietäres Cloud-Storage im Angebot – IBM Cloud, basierend auf der RESTful API – als auch Funktionen, die Storage an seine eigene und andere Clouds anbinden. Dadurch lassen sich Resilienz- und Verfügbarkeitsfunktionen von IBMs Block- und File-Storage-Systemen bei IBMs eigenem Cloud-Angebot oder Public-Cloud-Angeboten über das Rechenzentrum hinaus in die Cloud ausdehnen. IBMs Orchestrierungs-Service vereinfacht die Bereitstellung, Einrichtung, Wartung und Migration von Workloads und damit zusammenhängendem Storage, und zwar vom Rechenzentrum in die Cloud, zwischen zwei Clouds und von der Cloud zurück ins Rechenzentrum.

NetApp

NetApps Software StorageGrid Webscale bietet Integration zwischen NetApp-Storage beim Anwender und Cloud Storage wie S3. Daten auf kundenseitigem Block- und File-Storage können in die Cloud repliziert werden, was die Resilienz und Verfügbarkeit der anwenderseitigen Hardware im Rechenzentrum erhöht.

Wie bei den Systemen anderer Anbieter ist auch das StorageGRID-System ein separates Gerät, allerdings integriert in Netapps Gesamtökosystem. Es bietet dieselben Funktionen und Fähigkeiten wie die lokalen Storage-Produkte des Herstellers. Indem NetApp die mit dem Block- und File-Storage im Rechenzentrum gelieferten Services mittels seines Objekt-Storage-Gateway auf die Cloud ausdehnt, gewinnt das NetApp-System eine dritte Speicherschicht zusätzlich zum lokalen Storage, die Redundanz und Verfügbarkeit erhöht.

Fazit zu Block-, File- und Objekt-Storage

Die Grundlagen des integrierten Block-, File- und Objekt-Storages sind bei allen Produkten auf dem Markt ähnlich. Ob ein Objekt-Gateway in einen existierenden Storage Controller inregriert oder als separates Gerät hinzugefügt wird – das System übersetzt zwischen den drei Storage-Typen. Es erlaubt auch, dass Daten lokal auf Block-Storage oder File-Storage gehalten werden und in der Cloud als Objekt. Das sorgt für die Kosteneffizienz, Flexibilität, Redundanz, und Resilienz, die mit der Cloud möglich sind.

Die Eigenschaften der Produkte unterscheiden sich im Detail von Hersteller zu Hersteller. Differenzierungsmerkmale sind beispielsweise, ob sie synchrone oder asynchrone Replikation anbieten, wie viele geografische Standorte bei verteiltem Objekt-Storage möglich sind, welche Migrations-Tools für die Verschiebung von Daten zwischen Block- und File- und Objekt-Storage und zurück angeboten werden und wie die automatische Tiering-Software mit Deduplizierung umgeht. Die gute Nachricht ist, dass die meisten Hersteller heute Funktionen für Objekt-Storage anbieten, und dass diese mit ihren Block- und File-Systemen gut integrierbar sind.

Cloud-Kosten

Viele Cloud-Anbieter behaupten, dass es billiger ist, die eigenen Daten in ihrer Cloud zu speichern als im eigenen Rechenzentrum auf obsoleter Storage-Hardware. Zu den Kostenfaktoren von Storage im Unternehmensrechenzentrum gehören Energie, Kühlung, Flächenbedarf, Software-Updates, Support-Verträge, Ersatzteile und -systeme sowie Management-Kosten. Letztere umfassen den Zeitbedarf für die laufende Pflege und für Upgrades von Hard- und Software. Allerdings sind diese Kosten unter Umständen nicht relevant, wenn man Storage vor Ort mit Cloud-Storage vergleicht.

Ein amortisiertes Storage-System, besonders eins, das als Archiv und damit unterste Speicherschicht in einem Auto-Tiering-System verwendet wird, kann höhere Betriebskosten für Energie und Kühlung erzeugen als ein neues System, aber ob das unter dem Strich einen Effekt hat, hängt vielerorts von den lokalen Elektrizitätskosten ab. Es wird niemals den ROI beeinflussen, wenn man ein bestehendes Storage-System ersetzt, um Energie zu sparen. Die Stromkosten machen nämlich einen so kleinen Teil der Kosten eines neuen Arrays aus, dass es schlicht irrelevant ist. Anderenorts gibt es aber möglicherweise Begrenzungen der totalen verfügbaren elektrischen Leistung in Gebäuden, der Kühlleistung und der Größe von Rechenzentren. Zusammen mit den Strompreisen können sich dort solche Ersatzkäufe lohnen.

Durch die Integration von Block-, File- und Objekt-Storage mittels eines schon vorhandenen Controllers oder einer zusätzlichen Appliance, wie sie bei Dell, Hitachi Vantara, HPE oder NetApp erhältlich ist, gewinnen Storage-Administratoren Flexibilität, um ihr bestehendes Storage möglichst gut zu nutzen und sie mit dem Block-Storage zu integrieren. Das geschieht entweder mit einem bereits existierenden Storage Array im Rechenzentrum oder mit Cloud Storage von Anbietern wie Amazon oder Google. Wenn die Grenzen zwischen Block-, File- und Objekt-Storage wegfallen, können Storage-Administratoren auch das letzte Bit eines Block-basierten Storage Arrays nutzen und dann die Daten auf einen File-Storage-System migrieren, sobald das Block-basierte Array eines Tages deinstalliert wird. Dieselben Daten können sie auch nahtlos und einfach in die Cloud verlagern.

Dasselbe gilt für die Management-Kosten. Ein kleineres Unternehmen mit einem nicht überlasteten Storage-Administrator kann es sich besser leisten, etwas Zeit für die Storage-Administration einzuplanen als ein neues Array zu kaufen.

Folgen Sie SearchStorage.de auch auf Twitter, Google+, Xing und Facebook!