Gorodenkoff - stock.adobe.com

AWS re:Invent 2024: die wichtigsten Neuerungen im Überblick

Amazon Web Services (AWS) stellte im Dezember 2024 auf seiner Hausmesse re:Invent einige Neuheiten vor, unter anderem in den Bereichen Entwickler-Tools und maschinelles Lernen.

Amazon Web Services (AWS) nutzte die 13. Ausgabe seiner Hausmesse re:Invent im Dezember 2024, um eine Vielzahl an Neuerungen zu präsentieren, die von neuen KI-Services über leistungsstarke Hardware bis hin zu verbesserten Speicher- und Migrationsfunktionen reichen. Die wichtigsten Highlights der Veranstaltung werden in diesem Artikel zusammengefasst.

Erweiterungen für Amazon Bedrock: KI-Services und Datenautomatisierung

Amazon Bedrock, die Managed-Service-Plattform in der AWS-Cloud, die Unternehmen den Zugang zu vortrainierten Foundation-Modellen über eine standardisierte API-Schnittstelle ermöglicht, ohne dass diese eigene komplexe Infrastruktur aufbauen oder tiefergehende Machine-Learning-Expertise vorhalten müssen, wurde um mehrere Funktionen erweitert.

Besonders hervorzuheben ist der neue Amazon Bedrock Marketplace, der Kunden Zugang zu über 100 Foundation-Modellen zur Verfügung stellt, die für unterschiedliche Nutzungsszenarien wie die Generierung von Quellcode oder Videos optimiert sind. Zu diesen Modellen gehören unter anderem Luma Ray 2, das fortschrittliche Videogenerierung unterstützt, sowie poolside's malibu sowie point, die speziell für Codegenerierung und -dokumentation entwickelt wurden. AWS hat zudem mit den Amazon Nova-Modellen eigene KI-Modelle integriert, die Texte, Bilder und Videos verarbeiten und generieren können.

Die Einführung der neuen Funktionen Prompt Caching und Intelligent Prompt Routing erlaubt es, die Auswahl passender KI-Modelle zu automatisieren. Da teure Ressourcen damit nur dann genutzt werden, wenn sie gebraucht werden, führt dies nicht nur zu einer Verbesserung der Laufzeiten von Inferenzanfragen, sondern laut AWS auch zu Kosteneinsparungen von bis zu 30 Prozent.

Darüber hinaus erleichtert Bedrock nun durch die automatische Übersetzung von Anfragen in natürlicher Sprache in SQL-Queries den Zugriff auf strukturierte Datenquellen wie Data Lakes und Data Warehouses. Eine weitere wichtige Neuerung ist die Integration von GraphRAG, einer spezialisierten Form von Retrieval-Augmented Generation (RAG), die Wissensgraphen als primäre externe Quelle nutzt. Da in Wissensgraphen Daten als Knoten und Kanten gespeichert werden, können Abfragen wesentlich genauer und vernetzter beantwortet werden: Komplexe Beziehungen, zum Beispiel im Finanz- oder Gesundheitswesen, lassen sich so strukturiert analysieren, was tiefergehende Erkenntnisse in Echtzeit ermöglicht.

Die Funktion Amazon Bedrock Data Automation vereinfacht die Umwandlung unstrukturierter Daten in strukturierte Formate. Ohne manuelles Coding können Daten aus multimodalen Inhalten wie Text und Bild extrahiert und in bestehende Datenbestände integriert werden. Dies optimiert vor allem RAG-Workflows, bei denen Daten aus unterschiedlichen Quellen kombiniert werden, um kontextbezogene Antworten zu liefern.

Der Amazon Bedrock Marketplace ist ab sofort verfügbar, während sich Prompt Caching, Intelligent Prompt Routing, GraphRAG und Data Automation noch in der Preview-Phase befinden.

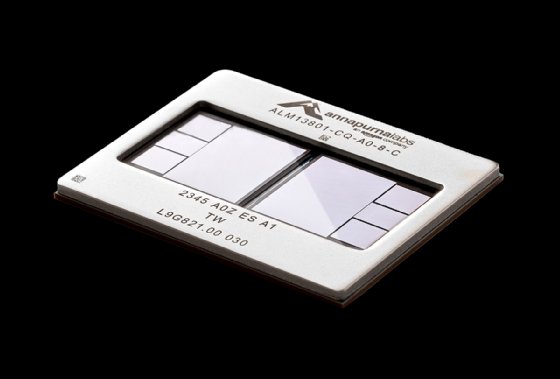

Hochleistungshardware: Trainium2, UltraServer und Project Rainier

Für alle, die ihre eigenen Modelle trainieren wollen, stellte AWS auch Fortschritte im Bereich der Hardware vor. Besonders im Fokus standen die neuen Trainium2-Chips, die in Elastic Compute Cloud (Amazon EC2) Trn2-Instanzen verfügbar sind und 20,8 Petaflops Rechenleistung bieten. Darüber hinaus ermöglicht ein UltraServer, der aus vier solcher Instanzen besteht, eine Skalierung auf bis zu 83,2 Petaflops.

Mit Project Rainier verfolgt AWS die Vision, Hunderte von UltraServern zu EC2 UltraClustern zu verbinden. Diese Cluster sollen es Kunden ermöglichen, KI-Modelle mit Billionen von Parametern effizient zu trainieren und in Echtzeit einzusetzen.

Ergänzend dazu kündigte AWS die neuen P6-Instanzen an, die auf den Blackwell-GPUs von Nvidia basieren. Diese Instanzen bieten eine bis zu 2,5-fach höhere Leistung als ihr Vorgänger und sind speziell für generative KI-Anwendungen optimiert.

Die Trn2- und P6-Instanzen sind ab sofort allgemein verfügbar, während sich die UltraServer noch in der Preview-Phase befinden. Die 3. Generation des Trainium-Chips wurde ebenfalls angekündigt. Dieser wird mit einem 3-Nanometer-Prozess gefertigt, soll energieeffizienter und leistungsstärker als sein Vorgänger sein, und wird 2025 erwartet.

Optimierungen für Amazon S3: Tables, Metadata und Storage Browser

Im Bereich Storage stellte AWS S3 Tables vor, die speziell für die Datenanalyse entwickelt wurden. Basierend auf dem offenen Tabellenformat Apache Iceberg bieten diese Buckets laut AWS eine bis zu dreimal schnellere Verarbeitung von Abfragen als herkömmliche Tabellen.

Mit S3 Metadata wird zudem die Verwaltung von Metadaten vereinfacht. Der Dienst erfasst system- und benutzerdefinierte Eigenschaften von hochgeladenen Objekten und speichert diese in einer abfragbaren Tabelle. Kunden können so gezielt nach Dateien mit bestimmten Attributen suchen und Änderungen in den Metadaten nachvollziehen. Die Integration mit Amazon Bedrock erlaubt es, generierte Inhalte wie Videos automatisch mit relevanten Metadaten zu verknüpfen.

Ein weiteres Highlight ist der neue S3 Storage Browser, eine Frontend-Komponente zur Verwaltung von Dateien in Webanwendungen. Nutzer können innerhalb ihrer Rechte auf S3-Dateien zugreifen, diese durchsuchen, kopieren und herunterladen.

Die S3 Tables und der S3 Storage Browser sind ab sofort allgemein verfügbar, während S3 Metadata noch in der Preview-Phase ist.

Nova: Multimodale KI-Modelle für Text, Bild und Video

Mit Nova präsentierte Amazon eine Familie multimodaler KI-Modelle, die in die Varianten Micro, Lite, Pro und Premier unterteilt sind. Die Modelle decken unterschiedliche Leistungs- und Kostenanforderungen ab und sind ausschließlich über Amazon Bedrock verfügbar. Nova Micro eignet sich für schnelle Textverarbeitung, womit sich beispielsweise Chatbots automatisieren lassen, Nova Premier ist hingegen für komplexe Aufgaben mit hoher Genauigkeit optimiert. Die Modelle sind auf Englisch spezialisiert, beherrschen laut Hersteller jedoch über 200 weitere Sprachen.

Die Nova Micro, Lite und Pro Modelle sind bereits allgemein verfügbar, während Nova Premier voraussichtlich im ersten Quartal 2025 verfügbar sein wird.

Im Bereich der Mediengenerierung bietet Nova mit Canvas einen Bildgenerator, der nachträgliche Bearbeitungen ermöglicht, und mit Reel einen Videogenerator, der kurze Clips von bis zu sechs Sekunden Länge erstellen kann. Nova bietet zudem Unterstützung für Retrieval-Augmented Generation (RAG), wodurch die Modelle kontextbezogene Antworten generieren können.

Amazon Q Developer: Transformation von Workloads

Mit der Erweiterung Amazon Q Developer: Transformieren möchte AWS seine Kunden bei der Modernisierung ihrer IT-Workloads unterstützen. Der Dienst deckt vier zentrale Bereiche ab: das Upgrade von Java-Applikationen, die Portierung von .NET-Anwendungen von Windows auf Linux, die Modernisierung von Mainframe-Software sowie die Migration von VMware-Workloads in native AWS-Dienste.

Die Unterstützung von Java-Upgrades liefert die Amazon Q Extension für gängige integrierte Entwicklungsumgebungen (IDE) wie Visual Studio, Visual Studio Code und die IDEs der JetBrains-Familie (zum Beispiel IntelliJ IDEA) bereits jetzt. Neu hinzugekommen ist die Integration in GitLab Duo.

Für Mainframe-Erneuerungs- und VMware Migrationsprojekte muss der Administrator die Amazon Q Webplattform verwenden. Am Beispiel einer VMware Migration ist der erste Schritt, Amazon Q Developer anzuweisen, ein VMware-Migrationsprojekt nach Amazon EC2 zu erstellen. Im Job Plan erscheinen dann vordefinierte Schritte zur Datenidentifikation (Data Discovery), Gruppierung von zu einer Applikation zugehörigen VMs, Netzwerkmigration sowie die Servermigration. Bei der Analyse der unter VMware betriebenen Data-Center-Umgebung kann AWS mit Datenexports von in dem Umfeld gängigen Tools wie Rvtools oder auf den hauseigenen AWS Application Discovery Service zurückgreifen, um weitere Informationen über Server und Netzwerke zu sammeln.

Nach dem Auswerten der gesammelten Daten schlägt Amazon Q Developer dann einen Projektplan vor, in dem es zusammengehörige Server bündelt und den Administratoren dazu passende Migrationswellen empfiehlt. Erscheinen diese sinnvoll, können Administratoren diese Daten speichern und als Auftrag in Amazon Q Developer hochladen, um die benötigten Netzwerke in einem AWS-Account anlegen zu lassen. Im Anschluss kann Amazon Q Developer die eigentliche Migration im Dienst AWS Application Migration Service starten – den Fortschritt einer Migration können Administratoren anschließend im Dashboard von Amazon Q Developer verfolgen.

Die neu vorgestellten Transformationsfunktionen stehen aktuell in einer Preview-Version für Kunden bereit, die den Dienst Amazon Q Developer Pro Tier abonniert haben.

Es bleibt abzuwarten, wie sich die auf der AWS re:Invent 2024 präsentierten Neuerungen in der Praxis bewähren. Fest steht jedoch, dass AWS mit verschiedenen Foundation-Modellen, automatisierter Datenverarbeitung und neuen Hardware-Angeboten wie den Trainium2-Chips ein breites Spektrum an Anwendungsfällen abdeckt. Auch die Vorstellung von Diensten zur Modernisierung und Migration bestehender Workloads unterstreicht das Bestreben, vorhandene IT-Strukturen leichter in die AWS-Cloud übertragbar zu machen.