Verantwortungsvolle KI

Was ist verantwortungsvolle KI?

Verantwortungsvolle KI ist ein Ansatz zur Entwicklung und Bereitstellung künstlicher Intelligenz (KI) aus ethischer und rechtlicher Sicht. Das Ziel verantwortungsvoller KI ist es, KI auf sichere, vertrauenswürdige und ethische Weise zu nutzen. Der verantwortungsvolle Einsatz von KI sollte die Transparenz und Fairness erhöhen und Probleme wie KI-Bias verringern.

Befürworter einer verantwortungsvollen künstlichen Intelligenz sind der Meinung, dass ein allgemein anerkanntes Governance Framework für KI-Best Practices es Organisationen erleichtert, sicherzustellen, dass ihre KI-Programmierung menschenzentriert, interpretierbar und erklärbar ist. Die Gewährleistung einer vertrauenswürdigen KI liegt jedoch bei den Datenwissenschaftlern und Softwareentwicklern, die die KI-Modelle einer Organisation schreiben und einsetzen. Das bedeutet, dass die erforderlichen Schritte zur Verhinderung von Diskriminierung und zur Gewährleistung von Transparenz von Unternehmen zu Unternehmen unterschiedlich sind.

Auch die Umsetzung ist von Unternehmen zu Unternehmen unterschiedlich. So können beispielsweise der Chief Analytics Officer oder andere dedizierte KI-Beauftragte und -Teams für die Entwicklung, Umsetzung und Überwachung des verantwortungsvollen KI-Frameworks der Organisation verantwortlich sein. Organisationen sollten auf ihrer Website eine Erklärung ihres KI-Frameworks haben, die dessen Verantwortlichkeit dokumentiert und sicherstellt, dass die KI-Nutzung der Organisation nicht diskriminierend ist.

Warum verantwortungsvolle KI wichtig ist

Verantwortungsvolle KI ist ein aufstrebender Bereich der KI-Governance. Der Begriff verantwortungsvoll ist ein Oberbegriff, der sowohl Ethik als auch KI-Demokratisierung umfasst.

Häufig führen die Datensätze, die zum Trainieren von Modellen des maschinellen Lernens (ML) verwendet werden, die in der KI zum Einsatz kommen, zu Verzerrungen (Bias). Verzerrungen gelangen auf eine von zwei Arten in diese Modelle: durch unvollständige oder fehlerhafte Daten oder durch die Voreingenommenheit derjenigen, die das ML-Modell trainieren. Wenn ein KI-Programm voreingenommen ist, kann es sich negativ auf Menschen auswirken oder ihnen schaden. Beispielsweise kann es ungerechtfertigterweise Anträge auf Finanzdarlehen ablehnen oder im Gesundheitswesen eine falsche Diagnose für einen Patienten stellen.

Da Softwareprogramme mit KI-Funktionen immer häufiger eingesetzt werden, ist es offensichtlich, dass es über die drei Gesetze der Robotik, die vom Science-Fiction-Autor Isaac Asimov aufgestellt wurden, hinaus Standards für KI geben muss.

Die Implementierung verantwortungsvoller KI kann dazu beitragen, Voreingenommenheit zu reduzieren, transparentere KI-Systeme zu schaffen und das Vertrauen der Benutzer in diese Systeme zu stärken.

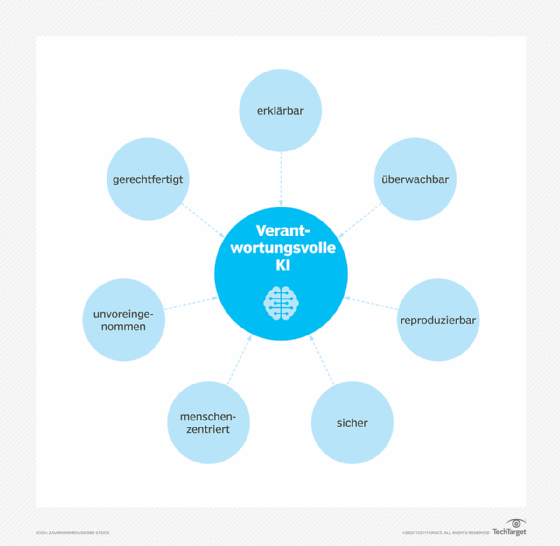

Was sind die Prinzipien verantwortungsvoller KI?

KI- und maschinelle Lernmodelle sollten einer Liste von Prinzipien folgen, die von Organisation zu Organisation unterschiedlich sein können.

Microsoft und Google beispielsweise folgen beide ihrer eigenen Liste von Grundsätzen. Darüber hinaus hat das National Institute of Standards and Technology (NIST) Version 1.0 (PDF) seines Frameworks für das Risikomanagement im Bereich der künstlichen Intelligenz veröffentlicht, das vielen der in den Listen von Microsoft und Google enthaltenen Grundsätzen folgt. Zu den sieben Grundsätzen des NIST gehören die folgenden:

- Gültig und zuverlässig. Verantwortungsvolle KI-Systeme sollten in der Lage sein, ihre Leistung unter verschiedenen und unerwarteten Umständen ohne Ausfall aufrechtzuerhalten.

- Sicher. Verantwortungsvolle KI muss menschliches Leben, Eigentum und die Umwelt schützen.

- Sicher und belastbar. Verantwortungsvolle KI-Systeme sollten sicher und belastbar gegenüber potenziellen Bedrohungen wie feindlichen Angriffen sein. Verantwortungsvolle KI-Systeme müssen so konzipiert sein, dass sie Angriffe vermeiden, davor schützen und darauf reagieren können, während sie sich gleichzeitig von ihnen erholen können.

- Verantwortlich und transparent. Durch mehr Transparenz soll Vertrauen in das KI-System aufgebaut werden, während gleichzeitig Probleme im Zusammenhang mit den Ergebnissen von KI-Modellen leichter behoben werden können. Dieses Prinzip erfordert, dass Entwickler die Verantwortung für ihre KI-Systeme übernehmen.

- Erklärbar und interpretierbar. Erklärbarkeit und Interpretierbarkeit sollen tiefgreifende Einblicke in die Funktionalität und Vertrauenswürdigkeit eines KI-Systems ermöglichen. Erklärbare KI erklärt den Benutzern beispielsweise, warum und wie das System zu seinem Ergebnis gelangt ist.

- Datenschutz. Das Datenschutzprinzip setzt Praktiken durch, die die Autonomie, Identität und Würde der Endnutzer schützen. Verantwortungsvolle KI-Systeme müssen unter Berücksichtigung von Werten wie Anonymität, Vertraulichkeit und Kontrolle entwickelt und eingesetzt werden.

- Fairness. Fairness konzentriert sich auf die Beseitigung von Voreingenommenheit und Diskriminierung durch KI. Sie versucht, Gleichheit und Gerechtigkeit zu gewährleisten, eine schwierige Aufgabe, da diese Werte je nach Organisation und Kultur unterschiedlich sind.

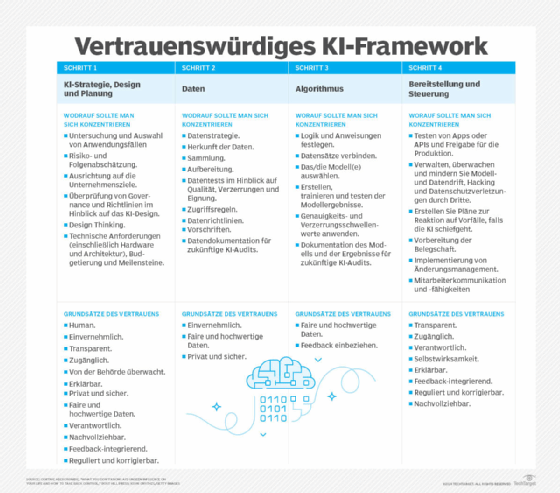

Wie gestaltet man verantwortungsvolle KI?

KI-Modelle sollten mit konkreten Zielen erstellt werden, die sich auf die Entwicklung eines Modells auf sichere, vertrauenswürdige und ethische Weise konzentrieren. Eine kontinuierliche Überprüfung ist unerlässlich, um sicherzustellen, dass eine Organisation sich für die Bereitstellung unvoreingenommener, vertrauenswürdiger KI-Technologie einsetzt. Zu diesem Zweck muss eine Organisation bei der Entwicklung und Implementierung eines KI-Systems einem Reifegradmodell folgen.

Auf einer grundlegenden Ebene basiert verantwortungsvolle KI auf Entwicklungsstandards, die sich auf die Prinzipien für verantwortungsvolles Design konzentrieren. Diese unternehmensweiten KI-Entwicklungsstandards sollten die folgenden Vorgaben enthalten:

- gemeinsame Code-Repositories

- genehmigte Modellarchitekturen

- genehmigte Variablen

- etablierte Methoden zur Überprüfung von Vorurteilen, um die Gültigkeit von Tests für KI-Systeme zu bestimmen

- Stabilitätsstandards für aktive Modelle des maschinellen Lernens, um sicherzustellen, dass die KI-Programmierung wie vorgesehen funktioniert

Verantwortungsvolle KI-Implementierung und Funktionsweise

Eine Organisation kann verantwortungsvolle KI implementieren und auf folgende Weise nachweisen, dass sie ein verantwortungsvolles KI-System geschaffen hat:

- Verwendung interpretierbarer Funktionen zur Erstellung von Daten, die Menschen verstehen können

- Dokumentieren Sie Design- und Entscheidungsprozesse, damit im Falle eines Fehlers dieser rückgängig gemacht werden kann, um festzustellen, was passiert ist.

- Schaffen Sie eine vielfältige Arbeitskultur und fördern Sie konstruktive Diskussionen, um Vorurteile abzubauen.

- Schaffen Sie einen strengen Entwicklungsprozess, der die Sichtbarkeit der latenten Merkmale jeder Anwendung schätzt.

- Eliminieren Sie Black-Box-Methoden zur Entwicklung von KI-Modellen. Verwenden Sie stattdessen White-Box- oder erklärbare KI-Methoden, die eine Erklärung für jede Entscheidung liefern, die die KI trifft.

Was sind die größten Herausforderungen bei der Umsetzung verantwortungsvoller KI?

Richtlinien und Frameworks für verantwortungsvolle KI sind nicht immer einfach umzusetzen, da der Prozess oft durch zentrale Herausforderungen und Bedenken verlangsamt wird. Zu diesen Herausforderungen gehören:

- Sicherheit und Datenschutz. Unternehmen, die Daten für das Training von KI-Modellen sammeln, benötigen möglicherweise vertrauliche Daten über Einzelpersonen. Richtlinien für verantwortungsvolle KI zielen darauf ab, den Datenschutz, die Datensicherheit und die Sicherheit zu gewährleisten, doch ist es oft schwierig, sensible Daten von öffentlichen Daten zu trennen.

- Datenverzerrung. Trainingsdaten sollten ordnungsgemäß beschafft und geprüft werden, um Verzerrungen zu vermeiden, aber Verzerrungen sind oft schwer zu erkennen. Es gibt keinen perfekten Ansatz; die Beseitigung von Verzerrungen in Datensätzen und Eingaben erfordert Zeit und Aufwand.

- Compliance. Da sich Gesetze und Vorschriften auf lokaler, föderaler, nationaler und internationaler Ebene ständig weiterentwickeln, müssen Unternehmen neue Regeln überwachen und sicherstellen, dass ihre KI-Richtlinien leicht zu aktualisieren sind.

- Training. Führungskräfte müssen wissen, wer an der Überwachung von KI-Systemen beteiligt ist, und sicherstellen, dass diese geschult sind. Neben den Technologieteams benötigen möglicherweise auch die Rechts-, Marketing-, Personal- und andere Abteilungen sowie andere Interessengruppen Schulungen.

Bewährte Verfahren für verantwortungsvolle KI-Grundsätze

Bei der Gestaltung verantwortungsvoller KI müssen Entwicklungs- und Bereitstellungsprozesse systematisch und wiederholbar sein. Zu den bewährten Verfahren gehören die folgenden:

- Implementierung bewährter Verfahren für maschinelles Lernen.

- Schaffen Sie eine vielfältige Kultur der Unterstützung. Dazu gehört die Bildung von Teams, die sich durch eine Vielfalt der Geschlechter und Ethnien auszeichnen und an der Entwicklung verantwortungsvoller KI-Standards arbeiten. Ermöglichen Sie es, frei über ethische Konzepte im Zusammenhang mit KI und Voreingenommenheit zu sprechen.

- Fördern Sie Transparenz, um ein erklärbares KI-Modell zu schaffen, damit alle von ihm getroffenen Entscheidungen sichtbar und bei Problemen leicht zu beheben sind.

- Die Arbeit so messbar wie möglich machen. Der Umgang mit Verantwortung ist subjektiv, daher sollten Sie sicherstellen, dass messbare Prozesse vorhanden sind, wie zum Beispiel Sichtbarkeit und Erklärbarkeit, und dass es überprüfbare technische und ethische Rahmenbedingungen gibt.

- Verwenden Sie verantwortungsvolle KI-Tools, um die Modelle zu überprüfen.

- Identifizieren Sie Kennzahlen für Schulungen und Überwachung, um Fehler, Fehlalarme und Verzerrungen auf ein Minimum zu reduzieren.

- Dokumentieren Sie bewährte Verfahren und vergleichen Sie sie mit einem oder mehreren bestehenden KI-Governance-Frameworks. Sobald diese Ansätze den Grundsätzen bestehender Frameworks entsprechen, kann diese Dokumentation als effektiver KI-Governance-Rahmen für eine Organisation dienen.

- Führen Sie Tests wie zum Beispiel Verzerrungstests und vorausschauende Wartung durch, um überprüfbare Ergebnisse zu erzielen und das Vertrauen der Endbenutzer zu stärken.

- Überwachung nach der Bereitstellung. Dadurch wird sichergestellt, dass das KI-Modell weiterhin verantwortungsbewusst und unvoreingenommen funktioniert.

- Seien Sie aufmerksam und lernen Sie aus dem Prozess. Eine Organisation erfährt bei der Umsetzung mehr über verantwortungsvolle KI, von Fairnesspraktiken bis hin zu technischen Referenzen und Materialien zur technischen Ethik.

Bewährte Verfahren für eine verantwortungsvolle KI-Governance

Aus der Perspektive der Aufsicht sollten Organisationen über eine KI-Governance verfügen, die für jedes von ihnen entwickelte oder implementierte KI-System wiederverwendbar ist. Governance-Richtlinien für verantwortungsvolle KI sollten die folgenden Best Practices enthalten:

- Transparenz. Organisationen sollten klar angeben, wie sie KI zur Entwicklung, Bereitstellung und Wartung von Algorithmen, Produkten und Dienstleistungen einsetzen.

- Rechenschaftspflicht. Es sollte eine Governance-Struktur vorhanden sein, die eine effektive Überwachung und Kontrolle ermöglicht.

- Ethische Datennutzung. KI-Teams müssen die Auswirkungen des Trainings eines KI-Modells auf sensible Daten verstehen und wissen, wie sie voreingenommene oder manipulierte Daten verhindern können. Eine Governance-Richtlinie sorgt dafür, dass diese Entwickler das Konzept der verantwortungsvollen KI stets im Auge behalten und Datenquellen genau untersuchen.

- Compliance. Eine Richtlinie muss Rechts- und Compliance-Teams anweisen, mit KI-Entwicklern zusammenzuarbeiten, um sicherzustellen, dass die Entwicklung mit den lokalen, staatlichen und internationalen Gesetzen und Vorschriften übereinstimmt.

- Schulung. Jeder Manager und Mitarbeiter, der an der Entwicklung, Bereitstellung und Nutzung von KI beteiligt ist, sollte eine Schulung über die Governance-Richtlinie und ihre Funktionsweise erhalten.

- Einbeziehung mehrerer Teams. Je nach den Bedürfnissen des Unternehmens können mehrere Teams an der Entwicklung, Implementierung und Wartung eines neuen KI-Produkts oder -Tools beteiligt sein. Wenn beispielsweise ein KI-Modell zur Verarbeitung persönlicher Gesundheitsdaten entwickelt wird, werden wahrscheinlich Teams von Gesundheitsexperten mit den Entwicklern zusammenarbeiten.

Beispiele für Unternehmen, die verantwortungsvolle KI einsetzen

Zu den Unternehmen, die verantwortungsvolle KI-Strategien und -Anwendungsfälle verfolgen, gehören Microsoft, FICO und IBM.

Microsoft

Microsoft hat mithilfe des AI, Ethics and Effects in Engineering and Research Committee sowie des Office of Responsible AI (ORA) ein KI-Governance-Framework geschaffen. Diese beiden Gruppen arbeiten innerhalb von Microsoft zusammen, um verantwortungsbewusste KI-Werte zu verbreiten und aufrechtzuerhalten.

ORA ist für die Festlegung unternehmensweiter Regeln für verantwortungsbewusste KI durch die Umsetzung von Governance und Public Policies verantwortlich. Microsoft hat mehrere Richtlinien, Checklisten und Vorlagen für verantwortungsbewusste KI implementiert, darunter die folgenden:

- Richtlinien für die Interaktion zwischen Mensch und KI

- Richtlinien für dialogorientierte KI

- Richtlinien für inklusives Design

- Checklisten für KI-Fairness

- Vorlagen für Datenblätter

- Leitfaden für KI-Sicherheitstechnik

FICO

Die US-Organisation für Kreditwürdigkeitsprüfungen FICO hat Richtlinien für eine verantwortungsvolle KI-Governance erstellt, um ihren Mitarbeitern und Kunden zu vermitteln, wie die vom Unternehmen verwendeten Machine-Learning-Modelle funktionieren und wo ihre Grenzen liegen. Die Datenwissenschaftler von FICO haben die Aufgabe, den gesamten Lebenszyklus ihrer ML-Modelle zu berücksichtigen. Sie testen ständig deren Wirksamkeit und Fairness. FICO hat folgende Methoden und Initiativen zur Erkennung von Voreingenommenheit entwickelt:

- Erstellung, Ausführung und Überwachung erklärbarer Modelle für KI.

- Verwendung der Blockchain als Governance-Tool zur Dokumentation der Funktionsweise einer KI-Lösung.

- Ein erklärbares KI-Toolkit mit Mitarbeitern und Kunden teilen.

- Umfassende Tests auf Voreingenommenheit durchführen.

IBM

IBM hat einen eigenen Ethikrat, der sich mit Fragen rund um künstliche Intelligenz befasst. Das IBM AI Ethics Board ist ein zentrales Gremium, das die Schaffung verantwortungsvoller und ethischer KI im gesamten Unternehmen unterstützt. Zu den von IBM verwendeten Richtlinien und Ressourcen gehören:

- KI-Vertrauen und Transparenz

- alltägliche ethische Überlegungen zur KI

- Open-Source-Community-Ressourcen

- Forschung zu vertrauenswürdiger KI

Die Rolle von Blockchain bei verantwortungsvoller KI

Blockchain ist eine beliebte Distributed-Ledger-Technologie, die zur Verfolgung von Transaktionsdaten in Kryptowährungen eingesetzt wird. Sie ist auch ein wertvolles Instrument zur Erstellung einer fälschungssicheren Aufzeichnung, die dokumentiert, warum ein ML-Modell eine bestimmte Vorhersage getroffen hat. Aus diesem Grund nutzen einige Unternehmen die Blockchain-Technologie, um ihre KI-Nutzung zu dokumentieren.

Mit der Blockchain-Technologie wird jeder Schritt im Entwicklungsprozess – einschließlich der Angabe, wer jede Entscheidung getroffen, getestet und genehmigt hat – in einem für Menschen lesbaren Format aufgezeichnet, das nicht verändert werden kann.

Verantwortungsvolle KI-Standardisierung

Führungskräfte großer Unternehmen wie IBM haben öffentlich KI-Vorschriften gefordert. In den USA gibt es bisher keine Bundesgesetze oder -standards, selbst angesichts des jüngsten Booms bei generativen KI-Modellen wie ChatGPT.

Der EU AI Act bietet jedoch ein Framework, um KI-Systeme mit hohem Risiko auszumerzen und sensible Daten vor dem Missbrauch durch solche Systeme zu schützen.

Im März 2024 ratifizierte das Europäische Parlament den EU AI Act. Er verfolgt einen risikobasierten Ansatz und unterteilt KI-Anwendungen in vier Kategorien: minimales Risiko, geringes Risiko, hohes Risiko und inakzeptables Risiko. KI-Systeme mit hohem und inakzeptablem Risiko müssen im Laufe der Zeit gemindert werden. Dieses Gesetz gilt sowohl für EU- als auch für Nicht-EU-Länder, die Daten von EU-Bürgern verarbeiten.

In den USA steht die Verabschiedung eines Bundesgesetzes zur Regelung der KI noch aus, und es gibt widersprüchliche Meinungen darüber, ob eine Regulierung der KI in Sicht ist. Sowohl das NIST als auch die Biden-Regierung haben jedoch umfassende Richtlinien für den Einsatz von KI veröffentlicht. Das NIST hat Artificial Intelligence Risk Management Framework herausgegeben. Die Biden-Regierung hat ebenfalls Entwürfe für eine AI Bill of Rights veröffentlicht.