Lineare Regression

Was ist lineare Regression?

Lineare Regression identifiziert die Beziehung zwischen dem Mittelwert einer Variable und den entsprechenden Werten einer oder mehrerer anderer Variablen. Dabei kann es sich um Analysen handeln, wie zum Beispiel die Schätzung von Umsätzen auf der Grundlage von Produktpreisen oder die Vorhersage von Ernteerträgen auf der Grundlage von Niederschlägen. Auf einer grundlegenden Ebene bedeutet der Begriff Regression die Rückkehr zu einem früheren oder weniger entwickelten Zustand.

Die lineare Regression beim maschinellen Lernen baut auf diesem grundlegenden Konzept auf, um die Beziehung zwischen Variablen mit verschiedenen Machine-Learning-Techniken zu modellieren und eine Regressionslinie zwischen Variablen wie der Umsatzrate und den Marketingausgaben zu erstellen. In der Praxis erweist sich maschinelles Lernen bei der Arbeit mit mehreren Variablen, der so genannten multivariaten Regression, als nützlicher, da die Beziehungen zwischen den Variablen komplexere Regressionskoeffizienten erfordern.

Die lineare Regression ist ein grundlegender Bestandteil des unüberwachten Lernens, da sie mit Daten arbeiten kann, die zuvor nicht gekennzeichnet wurden. Das macht sie nützlich, um etwas über die Eigenschaften eines Datensatzes zu erfahren und unterstützt dabei, bei der Entwicklung besserer Modelle für maschinelles Lernen verschiedene Modelle zu priorisieren. Im Kern kann die lineare Regression dabei helfen festzustellen, ob eine erklärende Variable bei der Vorhersage des Ergebnisses einer anderen wertvoll ist. Haben zum Beispiel die Werbeausgaben für das eine oder andere Medium einen bedeutenden Einfluss auf den Umsatz?

Im einfachsten Fall versucht lineare Regression, den Wert einer Variable, der so genannten abhängigen Variable, anhand einer anderen Variable, der so genannten unabhängigen Variable, vorherzusagen. Wenn Sie beispielsweise versuchen würden, die Verkaufsrate anhand der Werbeausgaben vorherzusagen, ist der Umsatz die abhängige Variable, während die Werbeausgaben die unabhängige Variable ist.

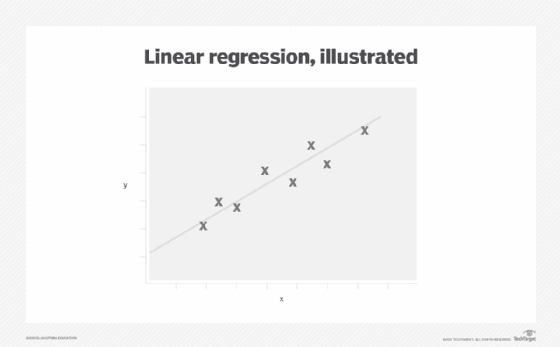

Die lineare Regression ist insofern linear, als sie die Entwicklung einer Funktion oder eines Modells anleitet, das eine gerade Linie an ein Diagramm der Daten anpasst. Diese Linie minimiert auch die Differenz zwischen einem vorhergesagten Wert für die abhängige Variable und der entsprechenden unabhängigen Variable.

Im Falle der Schätzung der Umsatzrate kann jeder Euro Umsatz innerhalb eines bestimmten Bereichs regelmäßig für jeden Euro, der für Werbung ausgegeben wird, ansteigen und sich dann verlangsamen, sobald der Anzeigenmarkt einen Sättigungspunkt erreicht. In diesen Fällen müssen komplexere Funktionen mit Unterstützung von Statistiken oder Machine-Learning-Techniken konstruiert werden, um die Daten an eine gerade Linie anzupassen.

Warum ist lineare Regression wichtig?

Lineare Regression ist aus den folgenden Gründen wichtig:

- Sie funktioniert mit nicht gekennzeichneten Daten.

- Sie ist relativ einfach und schnell.

- Sie kann als grundlegender Baustein in Wirtschaft und Wissenschaft eingesetzt werden.

- Sie unterstützt prädiktive Analysen.

- Sie unterstützt dabei, wichtige Beziehungen für die weitere Analyse oder Modellentwicklung zu trennen.

- Sie verbessert die Genauigkeit von Machine-Learning-Modellen für die Trendanalyse.

Arten der linearen Regression

Es gibt drei Haupttypen der linearen Regression:

Einfache lineare Regression

Bei der einfachen linearen Regression wird eine Funktion gefunden, die Datenpunkte auf eine gerade Linie in einem Diagramm zweier Variablen abbildet.

Multiple lineare Regression

Bei der multiplen linearen Regression wird eine Funktion gefunden, die Datenpunkte auf eine gerade Linie zwischen einer abhängigen Variable, wie zum Beispiel den Eisverkäufen, und einer Funktion von zwei oder mehr unabhängigen Variablen, wie zum Beispiel Temperatur und Werbeausgaben, abbildet.

Nichtlineare Regression

Bei der nichtlinearen Regression wird eine Funktion gefunden, die zwei oder mehr Variablen auf eine Kurve statt auf eine gerade Linie abbildet.

Beispiele für lineare Regression

Drei häufige Verwendungsmöglichkeiten der linearen Regression sind:

- Identifizierung des Ausmaßes der Auswirkung einer unabhängigen Variable, wie zum Beispiel der Temperatur, auf eine abhängige Variable, wie zum Beispiel den Umsatz von Speiseeis.

- Vorhersage der Auswirkungen von Veränderungen, die durch die unabhängige Variable hervorgerufen werden – zum Beispiel, wie viel mehr Eiscreme kann bei unterschiedlichen Werbemaßnahmen verkauft werden?

- Vorhersage von Trends und zukünftigen Werten – zum Beispiel wie viel Eis sollte gelagert werden, um die Nachfrage zu befriedigen, wenn vorhergesagt wird, dass die Temperatur 30 Grad Celsius erreichen wird?

Anwendungsfälle der linearen Regression

Typische Anwendungsfälle für lineare Regression in der Wirtschaft sind unter anderem:

- Elastizität der Preisgestaltung. Um wie viel wird der Umsatz sinken, wenn der Preis um einen bestimmten Betrag erhöht wird?

- Risikomanagement. Wie hoch ist die zu erwartende Haftung bei einer bestimmten Sturmstärke?

- Warentermingeschäfte. Wie ist die Beziehung zwischen Niederschlag und Ernteertrag?

- Aufdeckung von Betrug. Wie hoch ist die Wahrscheinlichkeit, dass eine Transaktion betrügerisch ist?

- Geschäftsanalyse. Um wie viel können die Umsätze bei verschiedenen Gewinnbeteiligungsanreizen steigen?

Vor- und Nachteile der linearen Regression

Zu den Vorteilen der linearen Regression gehören:

- Sie hilft bei der explorativen Datenanalyse.

- Sie kann Beziehungen zwischen Variablen aufzeigen.

- Sie ist relativ einfach zu implementieren.

Zu den Nachteilen der linearen Regression gehören:

- Sie funktioniert nicht gut, wenn die Daten nicht wirklich unabhängig sind.

- Die lineare Regression des maschinellen Lernens ist anfällig für eine Unteranpassung, die seltene Ereignisse nicht berücksichtigt.

- Ausreißer können die Genauigkeit von linearen Regressionsmodellen verzerren.

Wichtige Annahmen der linearen Regression

Die lineare Regression setzt voraus, dass der Datensatz folgende Eigenschaften aufweist:

- Die Daten müssen als kontinuierliche Reihe organisiert sein, zum Beispiel Zeit, Umsatz oder Werbeausgaben. Sie funktioniert nicht direkt mit Daten, die in Form von Kategorien wie Wochentagen oder Produkttypen vorliegen.

- Die Beobachtungen müssen unabhängig voneinander sein. So sind zum Beispiel Umsatz und Gewinn möglicherweise nicht unabhängig, wenn die Kosten der Waren oder andere Faktoren den Gewinn nicht separat beeinflussen.

- Die Daten müssen von Ausreißern bereinigt werden.

- Der Betrag, um den jeder Datenpunkt von der geraden Linie abweicht, muss bei Änderungen der unabhängigen Variable konsistent sein, was als Homoskedastizität bezeichnet wird.

Lineare Regression versus logistische Regression

Lineare Regression ist nur eine Klasse von Regressionstechniken zur Anpassung von Zahlen an ein Diagramm.

Die multivariate Regression passt die Daten möglicherweise an eine Kurve oder eine Ebene in einem mehrdimensionalen Diagramm an, das die Auswirkungen mehrerer Variablen darstellt.

Die logistische Regression sagt voraus, ob ein bestimmter Datenpunkt zu einer bestimmten Klasse gehört oder nicht, zum Beispiel Spam/Nicht-Spam für einen E-Mail-Filter oder Betrug/Nicht-Betrug für einen Kreditkartenautorisierer.