KI-Halluzination

Was sind KI-Halluzinationen?

Eine KI-Halluzination liegt vor, wenn ein großes Sprachmodell (Large Language Model, LLM), das Grundlage der künstlichen Intelligenz (KI) ist, falsche Informationen oder irreführende Ergebnisse erzeugt, was oft zu falschen menschlichen Entscheidungen führt.

Halluzinationen werden am häufigsten mit LLMs in Verbindung gebracht und führen zu einer fehlerhaften Textausgabe. Sie können jedoch auch in KI-generierten Videos, Bildern und Audiodateien auftreten. Ein anderer Begriff für eine KI-Halluzination ist Konfabulation.

KI-Halluzinationen beziehen sich auf die falschen, inkorrekten oder irreführenden Ergebnisse, die von LLMs oder Computer-Vision-Systemen generiert werden. Sie sind in der Regel das Ergebnis der Verwendung eines kleinen Datensatzes zum Trainieren des Modells, was zu unzureichenden Trainingsdaten oder inhärenten Verzerrungen in den Trainingsdaten führt.

Unabhängig von der zugrunde liegenden Ursache können Halluzinationen Abweichungen von externen Fakten, kontextbezogener Logik und in einigen Fällen von beidem sein. Sie können von geringfügigen Unstimmigkeiten bis hin zu vollständig erfundenen oder widersprüchlichen Informationen reichen.

LLMs sind KI-Modelle, die generative KI-Chatbots wie ChatGPT von OpenAI, Microsoft Copilot oder Google Gemini (ehemals Bard) antreiben, während sich Computer Vision auf KI-Technologie bezieht, die es Computern ermöglicht, den Inhalt visueller Eingaben wie Bilder und Videos zu verstehen und zu identifizieren.

LLMs verwenden Statistiken, um eine Sprache zu generieren, die im Kontext der Eingabe grammatikalisch und semantisch korrekt ist. Gut trainierte LLMs sind darauf ausgelegt, als Reaktion auf eine menschliche Eingabe einen flüssigen, kohärenten und kontextrelevanten Text auszugeben. Aus diesem Grund erscheinen KI-Halluzinationen oft plausibel, was bedeutet, dass Benutzer möglicherweise nicht erkennen, dass die Ausgabe falsch oder sogar unsinnig ist. Diese mangelnde Erkenntnis kann zu falschen Entscheidungen führen.

Warum kommt es zu KI-Halluzinationen?

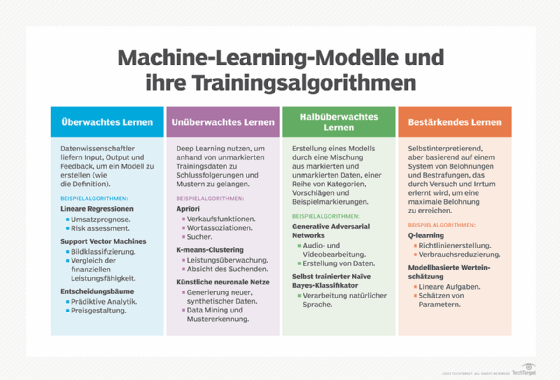

Alle KI-Modelle, einschließlich LLMs, werden zunächst anhand eines Datensatzes trainiert. Je mehr Trainingsdaten sie verarbeiten, desto besser lernen sie, Muster und Beziehungen innerhalb dieser Daten zu erkennen, was es ihnen dann ermöglicht, Vorhersagen zu treffen und als Reaktion auf die Eingabe eines Benutzers (ein sogenannter Prompt) eine Ausgabe zu erzeugen. Manchmal kann es jedoch vorkommen, dass das LLM falsche Muster lernt, was zu falschen Ergebnissen oder Halluzinationen führen kann.

Es gibt viele mögliche Gründe für Halluzinationen in LLMs, darunter die folgenden:

- Schlechte Datenqualität. Halluzinationen können auftreten, wenn die Daten, die zum Trainieren des LLM verwendet werden, schlecht, falsch oder unvollständig sind. LLM sind auf eine große Menge an Trainingsdaten angewiesen, um Ergebnisse zu erzielen, die für den Benutzer, der die Eingabeaufforderung bereitgestellt hat, relevant und genau sind. Diese Trainingsdaten können jedoch Rauschen, Fehler, Verzerrungen oder Inkonsistenzen enthalten, sodass das LLM falsche und in einigen Fällen völlig unsinnige Ergebnisse liefert.

- Generierungsmethode. Halluzinationen können auch durch die verwendeten Trainings- und Generierungsmethoden auftreten, selbst wenn der Datensatz selbst konsistent und zuverlässig ist und hochwertige Trainingsdaten enthält. Beispielsweise können die vorherigen Generationen des Modells eine Verzerrung erzeugen oder der Transformator kann eine falsche Dekodierung durchführen, was dazu führt, dass das System seine Antwort halluziniert. Modelle können auch eine Tendenz zu generischen oder spezifischen Wörtern aufweisen, was die von ihnen generierten Informationen beeinflussen oder sie dazu veranlassen kann, ihre Antwort zu erfinden.

- Eingabekontext. Wenn der vom menschlichen Benutzer bereitgestellte Prompt unklar, inkonsistent oder widersprüchlich ist, können Halluzinationen auftreten. Während die Qualität der verwendeten Trainingsdaten und Trainingsmethoden außerhalb der Kontrolle der Benutzer liegt, können sie die Eingaben, die sie dem KI-System zur Verfügung stellen, kontrollieren. Indem sie ihre Eingaben verfeinern und dem KI-System den richtigen Kontext zur Verfügung stellen, können sie es dazu bringen, bessere Ergebnisse zu erzielen.

Arten von KI-Halluzinationen

Es gibt verschiedene Arten von KI-Halluzinationen, darunter die folgenden:

- Widerspruch im Satz. Dies ist der Fall, wenn ein LLM einen Satz generiert, der einem vorherigen Satz widerspricht. Zum Beispiel:

- Prompt: Beschreibe eine Landschaft in Sätzen mit vier Wörtern.

- Ausgabe: Das Gras war grün. Die Berge waren blau. Der Fluss war lila. Das Gras war braun.

- Prompt-Widerspruch. Dies ist der Fall, wenn ein Satz dem Prompt widerspricht, der zu seiner Generierung verwendet wurde. Zum Beispiel:

- Prompt: Schreibe eine Geburtstagskarte für meine Nichte.

- Ausgabe: Alles Gute zum Geburtstag, Mama und Papa!

- Faktischer Widerspruch. Hierbei werden fiktive Informationen als Fakten dargestellt. Zum Beispiel:

- Prompt: Nenne drei Städte in den Vereinigten Staaten.

- Ausgabe: New York, London, Toronto.

- Irrelevante oder zufällige Halluzinationen. Hierbei werden zufällige Informationen mit wenig oder keinem Bezug zur Eingabe generiert.

- Prompt: Beschreibe mir London.

- Ausgabe: London ist eine Stadt in England. Katzen müssen mindestens einmal am Tag gefüttert werden.

Beispiele für KI-Halluzinationen

Ein berüchtigtes Beispiel für eine KI-Halluzination ereignete sich im Februar 2023, als Googles Chatbot Gemini eine falsche Behauptung über das James Webb Space Telescope (JWST) aufstellte. In einem Werbevideo wurde Gemini gefragt: Welche neuen Entdeckungen des James Webb Space Telescope kann ich meinem 9-jährigen Kind erzählen? Gemini antwortete, dass das JWST die allerersten Bilder eines Exoplaneten außerhalb des Sonnensystems der Erde gemacht habe. Diese Information war falsch, da die ersten Bilder eines Exoplaneten 2004 vom Very Large Telescope (VLT) der Europäischen Südsternwarte aufgenommen wurden und das JWST erst 2021 gestartet wurde. Bards Antwort klang plausibel und stimmte mit der vorgegebenen Antwort überein, wurde jedoch von der Nachrichtenagentur Reuters als falsch entlarvt.

Eine weitere KI-Halluzination ereignete sich Ende 2022, als Meta (ehemals Facebook) Galactica vorstellte, ein Open-Source-LLM, das mit Millionen von wissenschaftlichen Informationen aus Lehrbüchern, Artikeln, Enzyklopädien, Websites und sogar Vorlesungsmitschriften trainiert wurde. Galactica wurde für die Nutzung durch Wissenschaftler und Studenten entwickelt, von denen viele berichteten, dass das System ungenaue, verdächtige oder voreingenommene Ergebnisse generierte. Ein Professor an der New York University sagte, dass Galactica seine Arbeit nicht richtig zusammenfasste, während ein anderer Nutzer angab, dass das System Zitate und Forschungsergebnisse erfand, als er es aufforderte, eine Literaturrecherche zum Thema Verursacht HIV AIDS? durchzuführen.

Diese Probleme riefen viel Kritik hervor, wobei viele Benutzer den LLM von Galactica und seine Ergebnisse als verdächtig, unverantwortlich und sogar gefährlich einstuften. Dieses Problem kann schwerwiegende Folgen für KI-Benutzer haben, die nicht viel über ein Thema wissen und sich auf Galactica verlassen, um Hilfe zu erhalten. Nach dem Aufschrei nahm Meta die Galactica-Demo nur drei Tage nach dem Start vom Netz.

Wie Google Gemini und Meta Galactica ist auch ChatGPT seit seiner Veröffentlichung im November 2022 in zahlreiche Halluzinationskontroversen verwickelt. Im Juni 2023 reichte ein Radiomoderator in Georgia eine Verleumdungsklage gegen OpenAI ein und beschuldigte den Chatbot, böswillige und potenziell verleumderische Aussagen über ihn zu machen. Im Februar 2024 berichteten viele ChatGPT-Nutzer, dass der Chatbot dazu neigte, zwischen Sprachen zu wechseln oder in Schleifen stecken zu bleiben. Andere berichteten, dass er unverständliche Antworten generierte, die nichts mit dem Prompt des Benutzers zu tun hatten.

Im April 2024 reichten einige Datenschutzaktivisten eine Beschwerde gegen OpenAI ein, in der sie erklärten, dass der Chatbot regelmäßig Informationen über Personen halluziniere. Die Kläger warfen OpenAI außerdem vor, gegen die EU-Datenschutz-Grundverordnung (DSGVO) zu verstoßen. Einen Monat später veröffentlichte eine Reporterin der Technologie-Nachrichten-Website The Verge einen komischen Beitrag, in dem sie ausführlich beschrieb, wie ChatGPT ihr unmissverständlich mitteilte, dass sie einen Bart habe und eigentlich gar nicht für The Verge arbeite.

Seit diese Probleme erstmals gemeldet wurden, haben diese Unternehmen die Anwendungen entweder repariert oder arbeiten an einer Reparatur. Dennoch zeigen die Ereignisse deutlich eine wichtige Schwäche von KI-Tools: Sie können unerwünschte Ergebnisse erzeugen, die zu unerwünschten oder gefährlichen Folgen für die Benutzer führen können.

Warum sind KI-Halluzinationen ein Problem?

Ein unmittelbares Problem bei KI-Halluzinationen besteht darin, dass sie das Vertrauen der Benutzer erheblich untergraben. Wenn Benutzer beginnen, KI als echtes Werkzeug zu betrachten, entwickeln sie möglicherweise mehr Vertrauen in sie. Halluzinationen können dieses Vertrauen untergraben und Benutzer davon abhalten, das KI-System weiterhin zu nutzen.

Halluzinationen können auch zu generativem Anthropomorphismus führen, einem Phänomen, bei dem menschliche Benutzer wahrnehmen, dass ein KI-System menschenähnliche Eigenschaften hat. Dies kann passieren, wenn Benutzer glauben, dass die vom System generierten Ergebnisse real sind, selbst wenn es Bilder erzeugt, die mythische (nicht reale) Szenen darstellen, oder Texte, die der Logik widersprechen. Mit anderen Worten: Die Ergebnisse des Systems sind wie eine Fata Morgana, die die Wahrnehmung der Benutzer manipuliert und sie dazu bringt, an etwas zu glauben, das nicht wirklich real ist, und dann diese Überzeugung als Grundlage für ihre Entscheidungen zu verwenden.

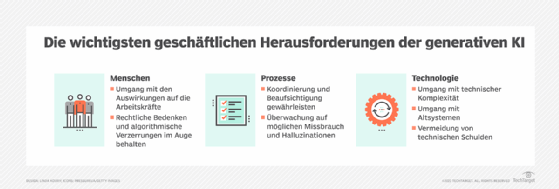

Die Fähigkeit fließender und plausibler Halluzinationen, Menschen zu täuschen, kann in vielen Situationen problematisch oder gefährlich sein, insbesondere wenn die Benutzer optimistisch und nicht skeptisch sind. Das KI-System könnte während Wahlen versehentlich Fehlinformationen verbreiten, was sich auf die Wahlergebnisse auswirken oder sogar zu sozialen Unruhen führen könnte. Halluzinationen könnten sogar von Cyberangreifern als Waffe eingesetzt werden, um schwerwiegende Cyberangriffe gegen Regierungen oder Organisationen durchzuführen.

Schließlich sind LLMs oft Black-Box-KI, was es schwierig – oft unmöglich – macht, festzustellen, warum das KI-System eine bestimmte Halluzination erzeugt hat. Es ist auch schwierig, LLMs zu reparieren, die Halluzinationen erzeugen, da ihr Training an einem bestimmten Punkt abbricht. In das Modell einzusteigen, um die Trainingsdaten zu ändern, kann viel Energie kosten. Außerdem ist die KI-Infrastruktur teuer, sodass es sehr kostspielig sein kann, die Ursache von Halluzinationen zu finden und Korrekturen vorzunehmen. Oft ist es Aufgabe des Benutzers – nicht des Eigentümers des LLM –, auf Halluzinationen zu achten.

Generative KI ist genau das – generativ. In gewisser Weise erfindet die generative KI alles neu.

Wie können KI-Halluzinationen erkannt werden?

Die grundlegendste Methode zur Erkennung einer KI-Halluzination besteht darin, die Ausgabe des Modells sorgfältig auf Fakten zu überprüfen. Dies kann jedoch für Benutzer, die mit unbekanntem, komplexem oder dichtem Material arbeiten, schwierig sein. Um das Problem zu entschärfen, können sie das Modell bitten, sich selbst zu bewerten und die Wahrscheinlichkeit zu ermitteln, dass eine Antwort korrekt ist, oder die Teile einer Antwort hervorheben, die möglicherweise falsch sind, und diese Informationen dann als Ausgangspunkt für die Faktenprüfung verwenden.

Benutzer können sich auch mit den Informationsquellen des Modells vertraut machen, um Faktenprüfungen durchzuführen. Wenn beispielsweise die Trainingsdaten eines Tools in einem bestimmten Jahr enden, sollte jede generierte Antwort, die auf detaillierten Kenntnissen nach diesem Zeitpunkt beruht, auf ihre Richtigkeit überprüft werden.

<iframe width="100%" height="315" src="https://www.youtube-nocookie.com/embed/sj5oS9KWiDQ?si=wlnObsbj5ar4ECRr" title="YouTube video player" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" referrerpolicy="strict-origin-when-cross-origin" allowfullscreen></iframe>

Wie verhindert man KI-Halluzinationen?

Es gibt eine Reihe von Möglichkeiten, wie KI-Benutzer das Auftreten von Halluzinationen in KI-Systemen vermeiden oder minimieren können:

- Verwenden Sie klare und spezifische Prompts. Klare, eindeutige Prompts und zusätzlicher Kontext können das Modell so steuern, dass es die beabsichtigte und korrekte Ausgabe liefert. Einige Beispiele sind unten aufgeführt:

- Verwendung eines Prompts, der die möglichen Ausgaben durch die Angabe spezifischer Zahlen einschränkt.

- Versorgung des Modells mit relevanten und zuverlässigen Datenquellen.

- Zuweisung einer bestimmten Rolle an das Modell, zum Beispiel: Sie sind Autor für eine Technologie-Website. Schreiben Sie einen Artikel über x.

- Filter- und Ranking-Strategien. LLMs haben oft Parameter, die Benutzer anpassen können. Ein Beispiel ist der Temperaturparameter, der die Zufälligkeit der Ausgabe steuert. Wenn die Temperatur höher eingestellt ist, sind die vom Sprachmodell erzeugten Ausgaben zufälliger. Top-K, das steuert, wie das Modell mit Wahrscheinlichkeiten umgeht, ist ein weiteres Beispiel für einen Parameter, der angepasst werden kann, um Halluzinationen zu minimieren.

- Multishot Prompting. Benutzer können mehrere Beispiele für das gewünschte Ausgabeformat bereitstellen, um dem Modell dabei zu helfen, Muster genau zu erkennen und genauere Ausgaben zu generieren.

Oft bleibt es dem Benutzer überlassen – nicht dem LLM-Besitzer oder -Entwickler –, während der LLM-Nutzung auf Halluzinationen zu achten und die LLM-Ausgabe mit einer angemessenen Portion Skepsis zu betrachten. Dennoch versuchen Forscher und LLM-Entwickler auch, Halluzinationen zu verstehen und zu mildern, indem sie hochwertige Trainingsdaten verwenden, vordefinierte Datenvorlagen nutzen und den Zweck, die Grenzen und die Reaktionsgrenzen des KI-Systems festlegen.

Einige Unternehmen wenden auch neue Ansätze an, um ihre LLMs zu trainieren. So gab OpenAI im Mai 2023 bekannt, dass es seine LLMs so trainiert hat, dass sie ihre mathematischen Problemlösungsfähigkeiten verbessern, indem die Modelle für jeden richtigen Schritt in der Argumentation zur richtigen Antwort belohnt werden, anstatt nur die richtige Schlussfolgerung zu belohnen. Dieser Ansatz wird als Prozessüberwachung bezeichnet und zielt darauf ab, dem Modell bei jedem einzelnen Schritt präzises Feedback zu geben, um es so zu manipulieren, dass es einer Gedankenkette folgt und somit bessere Ergebnisse und weniger Halluzinationen produziert.

Geschichte der KI-Halluzinationen

Forscher von Google DeepMind schlugen 2018 den Begriff IT-Halluzinationen vor. Sie beschrieben Halluzinationen als hochgradig pathologische Übersetzungen, die völlig losgelöst vom Ausgangsmaterial sind. Der Begriff wurde mit der Veröffentlichung von ChatGPT populärer und mit KI in Verbindung gebracht, wodurch LLMs zugänglicher wurden, aber auch die Tendenz von LLMs, falsche Ergebnisse zu generieren, hervorgehoben wurde.

Ein Bericht aus dem Jahr 2022 mit dem Titel Survey of Hallucination in Natural Language Generation beschreibt, wie Deep-Learning-Systeme dazu neigen, unbeabsichtigten Text zu halluzinieren, was die Leistung in realen Szenarien beeinträchtigt. Die Autoren des Papiers erwähnen, dass der Begriff Halluzination erstmals im Jahr 2000 in einem Papier mit dem Titel Proceedings: Fourth IEEE International Conference on Automatic Face and Gesture Recognition verwendet wurde, wo er in der Computer Vision eine positive Bedeutung hatte und nicht die negative, die wir heute kennen.