Hyper-Converged Infrastructure (HCI)

Hyper-Converged Infrastructure, HCI (zu Deutsch: Hyperkonvergente Infrastruktur) ist eine softwarezentrierte Architektur, die Rechen-, Speicher- und Virtualisierungsressourcen in einem einzigen System integriert, das in der Regel aus x86-Hardware besteht.

Moderne Unternehmen verlassen sich auf das Rechenzentrum, um die Rechen-, Speicher-, Netzwerk- und Verwaltungsressourcen bereitzustellen, die für das Hosten wichtiger Unternehmens-Workloads und Daten erforderlich sind. Doch Rechenzentren sind komplexe Installationen, in denen eine Vielzahl von Anbietern miteinander konkurrieren, um unzählige unterschiedliche Geräte, Systeme und Software zu liefern. Diese heterogene Mischung hat oft Schwierigkeiten, miteinander zu interagieren - und liefert ohne sorgfältige, zeitaufwändige Optimierungen selten Spitzenleistungen für das Unternehmen. Heutzutage haben IT-Teams einfach nicht mehr die Zeit, sich mit den Herausforderungen der Bereitstellung, Integration und Verwaltung von Rechenzentren auseinanderzusetzen, die durch herkömmliche heterogene Umgebungen entstehen.

Der Idee der Konvergenz entstand ursprünglich daraus, die Herausforderungen der Heterogenität zu bewältigen. Schon früh fasste ein alleinger Anbieter die Systeme und Software verschiedener Anbieter zu einem einzigen vorkonfigurierten und optimierten Satz von Geräten und Tools zusammen, der als Paket verkauft wurde. Dies wurde als konvergente Infrastruktur oder CI (Converged Infrastructure) bezeichnet. Später gingen die Konvergenzanbieter einen Schritt weiter und entwickelten und produzierten ihre eigene Produktlinie von vorkonfigurierten und hoch integrierten Rechen-, Speicher- und Netzwerkgeräten für das Rechenzentrum. Dies war ein evolutionärer Schritt, der heute als hyperkonvergente Infrastruktur (HCI) bezeichnet wird.

Konvergente und hyperkonvergente Infrastrukturen werden durch eine Kombination aus Virtualisierungstechnologie und einheitlicher Verwaltung möglich. Durch die Virtualisierung können Rechen-, Speicher- und Netzwerkressourcen als Ressourcenpools behandelt werden. Ein einheitliches Management ermöglicht es, all diese Ressourcen zu erkennen, in Pools zu organisieren, in Leistungsstufen zu unterteilen und dann nahtlos für Arbeitslasten bereitzustellen, unabhängig davon, wo sich diese Ressourcen physisch befinden. Die einheitliche Verwaltung stellt eine Weiterentwicklung gegenüber herkömmlichen heterogenen Rechenzentrumsumgebungen dar, die sich auf mehrere unterschiedliche Verwaltungs-Tools stützen konnten, mit denen oft nicht alle Ressourcen erkannt oder verwaltet wurden.

Heutzutage wird die Kombination aus virtualisierter Hardware und zugehörigen Verwaltungs-Tools oft als eigenständige Appliance behandelt, die als einzelnes, vollständiges Subsystem im Rechenzentrum betrieben oder mit anderen HCI-Appliances kombiniert werden kann, um eine hyperkonvergente Infrastruktur schnell und einfach zu erweitern.

Wie funktioniert eine hyperkonvergente Infrastruktur?

Allzu oft wurden vielschichtige Mischungen von Hardware verschiedener Anbieter mit unzureichender Netzwerkausrüstung kombiniert, die sich nicht mit einem einzigen Tool bereitstellen und verwalten ließen. Das Ergebnis ist fast immer ein Sammelsurium verschiedener Geräte und Software, das zu Verwirrung, Versäumnissen, unnötigen Problembehebungen und Zeitverschwendung seitens der IT-Administratoren führt.

Die hyperkonvergente Infrastruktur basiert auf den beiden Grundvoraussetzungen Integration und Management, die als Mittel zur Lösung von zwei der verwirrendsten Probleme herkömmlicher heterogener Rechenzentren entstanden sind: suboptimale Leistung und lückenhaftes - problematisches - Systemmanagement. Das Ziel von HCI ist es, virtualisierte, skalierbare Rechen-, Speicher- und Netzwerkressourcen bereitzustellen, die alle über eine einzige Plattform erkannt und verwaltet werden können.

Über diese grundlegende Prämisse hinaus gibt es jedoch zahlreiche Varianten und Optionen für hyperkonvergente Infrastrukturen. Es ist wichtig, die häufigsten Überlegungen zur HCI-Technologie zu verstehen.

Hardware- oder Software-Bereitstellung. Hyperkonvergente Infrastrukturen können durch Hardware oder Software implementiert werden.

- Hardware-Bereitstellung. Die HCI-Technologie ist als Hardwareplattform entstanden, die Rechen-, Speicher- und manchmal auch Netzwerkressourcen in einem dedizierten Gerät zusammenfasst, das oft als Appliance bezeichnet wird. Hardware-basierte HCI ermöglicht ein hohes Maß an Integration und Optimierung, was die Leistung in wichtigen Bereichen, wie der Datenübertragung zwischen Speicher und CPU, erheblich verbessern kann. Hardware-HCI kann sich als ideal erweisen, wenn eine hohe Leistung für Arbeitslasten - wie Echtzeit-Datenanalyseaufgaben - wichtig ist und wenn Hardware-Modularität und Skalierbarkeit für das Unternehmen von Bedeutung sind. Hardware-basierte HCI ist jedoch in der Regel herstellerspezifisch, was die Kosten in die Höhe treibt und ein gewisses Risiko der Herstellerbindung birgt. Mit Hardware-HCI kann ein Unternehmen bei Bedarf problemlos neue HCI-Appliances hinzufügen, ohne sich Gedanken über die Kompatibilität und den Support der Verwaltungssoftware machen zu müssen. Beispiele für hardwarebasierte HCI sind die VxRail-Systeme von Dell EMC, auf denen VMware-Virtualisierung läuft, und die SimpliVity-Plattform von Hewlett Packard Enterprise (HPE).

- Software-Bereitstellung. HCI kann auch als Softwareschicht implementiert werden, die dazu dient, vorhandene Hardwarekomponenten zu erkennen, zu virtualisieren und zu verwalten. Der Softwareansatz ermöglicht es einem Unternehmen, die Vorteile von HCI zu nutzen, ohne dass umfangreiche neue Hardware-Investitionen erforderlich sind. Der Nachteil dabei ist, dass vorhandene Hardwaregeräte - einschließlich Server und Speichersubsysteme - nicht von der engen Integration und den Optimierungen profitieren, die bei hardwarebasierter HCI zu finden sind. HCI-Software ist von VMware vSAN, Nutanix Acropolis, Microsofts Azure Stack - der lokalen Version von Azure - und sogar OpenStack erhältlich. Der Software-Ansatz kann auch architektonische Änderungen und neue Überwachungsanforderungen mit sich bringen, die die HCI-Softwareschicht möglicherweise nicht bietet. Daher kann softwarebasierte HCI für Unternehmen komplizierter zu implementieren und zu warten sein.

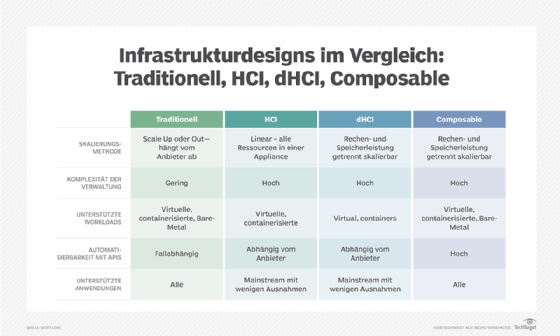

Integriert oder disaggregiert. Hyperkonvergente Infrastrukturen können in Bezug auf das Hardware-Design zwei verschiedene Ansätze verfolgen.

- Integrierte HCI. Der integrierte Ansatz ist der traditionellere, bei dem eine HCI-Appliance eine ausgewogene Mischung aus Rechenressourcen, einschließlich Prozessoren, Arbeitsspeicher und Speicher, enthält. Jede Appliance wird als Knoten bezeichnet, und eine HCI-Bereitstellung kann auf zahlreiche Knoten skaliert werden. Integrierte HCI-Hardware ist einfach zu verstehen und bietet eine hohe Leistung - alles befindet sich in einem Gehäuse. Aber Ressourcen sind endlich, und Workloads nutzen die Ressourcen normalerweise nicht gleichmäßig aus. Wenn einem Knoten eine Ressource ausgeht (zum Beispiel CPUs), muss ein Unternehmen einen völlig neuen Knoten hinzufügen, auch wenn die anderen Ressourcen des neuen Knotens (beispielsweise Arbeitsspeicher und Speicher) noch nicht genutzt oder benötigt werden. Dies birgt die Gefahr von Fehlinvestitionen.

- Disaggregierte HCI. Die hyperkonvergente Infrastruktur hat in letzter Zeit begonnen, eine disaggregierte Architektur einzuführen. Anstatt CPUs, Arbeitsspeicher und Speicher in einem Gerät zu vereinen, werden die verschiedenen Ressourcenkomponenten in verschiedenen Modulen bereitgestellt. Bei einer disaggregierten HCI-Hardwarebereitstellung würden also CPUs und Speicher in einer Compute-Box und Storage in einer separaten Storage-Box untergebracht. Alle verschiedenen Ressourcenmodule sind über ein Netzwerk miteinander verbunden. Obwohl es technisch möglich ist, CPUs und Speicher für eine stärkere Disaggregation zu trennen, ist es für die Leistung besser, CPUs und Speicher in einem Gerät zusammenzuhalten, da CPUs und Speicher in einer Rechenumgebung eng gekoppelt sind. Disaggregierte Ansätze versprechen zusätzliche Flexibilität und ermöglichen es dem Unternehmen, HCI-Investitionen auf die Ressourcen zu konzentrieren, die den größten Nutzen bringen. Mehrere HCI-Anbieter haben disaggregierte HCI-Angebote, darunter Datrium, NetApp und HPE.

Generelle Bereitstellung. Hyperkonvergente Infrastrukturen werden in der Regel als disruptive Technologie betrachtet, da sie in der Regel die vorhandene Rechenzentrums-Hardware verdrängen. Wann immer HCI im Rechenzentrum eingeführt wird, ist es wichtig, sich Gedanken darüber zu machen, wie diese Technologie implementiert oder betrieben werden soll. Grundsätzlich gibt es drei Möglichkeiten, ein herkömmliches heterogenes Rechenzentrum mit HCI zu ergänzen.

- Vollständiger Ersatz mittels HCI-Implementierung. Die erste Option ist ein vollständiger Ersatz der herkömmlichen Umgebung durch ein hyperkonvergentes Infrastrukturprodukt. In der Praxis ist dies wahrscheinlich die am wenigsten wünschenswerte Option, da sie die größtmögliche Verdrängung von Hardware mit sich bringt - und auch die höchsten potenziellen Kosten. Nur wenige Unternehmen haben das Kapital oder den technologischen Bedarf für ein solches Unterfangen. Es ist wahrscheinlicher, dass eine neue HCI-Implementierung für Projekte auf der grünen Wiese eingesetzt wird, zum Bespiel für den Bau eines zweiten Rechenzentrums (Backup oder Remote) oder für einen anderen Neubau oder gar einen Edge-Standort, bei dem eine Referenzarchitektur verwendet wird, bei der das Ausrüstungskapital in HCI investiert werden kann, ohne die vorhandene Hardware zu ersetzen.

- Side-by-Side-HCI-Bereitstellung. Der zweite - und weitaus interessantere - Ansatz ist ein Side-by-Side-Einsatz, bei dem eine HCI-Plattform im bestehenden Rechenzentrum zusammen mit einer herkömmlichen heterogenen Infrastruktur eingesetzt wird. Dieser Ansatz ermöglicht es Unternehmen, Workloads im Laufe der Zeit auf HCI zu migrieren und kann langfristig durchgeführt werden. Abgelöste Hardware kann wiederverwendet oder in kleineren, besser zu verwaltenden Teilen außer Betrieb genommen werden. Es ist wahrscheinlich, dass HCI langfristig mit traditionellen Infrastrukturen zusammenarbeiten wird und beide problemlos nebeneinander bestehen können.

- HCI-Bereitstellung pro Anwendung. Der dritte Ansatz bringt die hyperkonvergente Infrastruktur ebenfalls in die bestehende Rechenzentrumsumgebung ein. Anstatt jedoch bestehende Arbeitslasten auf die neue Infrastruktur zu migrieren, soll die HCI nur bestimmte neue Anwendungen oder Datenverarbeitungsinitiativen unterstützen, zum Beispiel eine neue virtuelle Desktop-Infrastruktur oder ein neues Big-Data-Verarbeitungs-Cluster. Frühere Arbeitslasten bleiben auf der bestehenden Infrastruktur.

Warum ist Hyperkonvergenz wichtig?

Heterogene Rechenzentren haben sich entwickelt, weil jedes Unternehmen Datenverarbeitungsprobleme hat, die gelöst werden müssen, aber die Antwort ist selten für jedes Unternehmen oder jedes Problem dieselbe. Das Versprechen der Heterogenität gibt einem Unternehmen die Freiheit, zwischen kostengünstigen und passenden Produkten zu wählen, während das Rechenzentrum weitgehend frei von Herstellerabhängigkeit bleibt.

Aber Heterogenität hat ihren Preis. Der Aufbau einer effektiven heterogenen Rechenzentrumsinfrastruktur erfordert Zeit und Aufwand. Hardware und Software müssen einzeln beschafft, integriert, konfiguriert, optimiert - wenn möglich - und dann mit Hilfe von Tools verwaltet werden, die oft nur für die Produkte eines bestimmten Anbieters verfügbar sind. Daher erfordert die Verwaltung einer vielfältigen Infrastruktur in der Regel Fachwissen über mehrere Tools, die die IT-Mitarbeiter beherrschen und pflegen müssen. Dies verursacht zusätzliche Zeit- und Integrationsprobleme, wenn die Infrastruktur geändert oder erweitert werden muss. Die traditionelle heterogene IT ist einfach nicht so flexibel.

Die Geschäftsabläufe ändern sich oft in einem sehr schnellen Tempo. Die IT muss in viel kürzerer Zeit auf die Anforderungen des Unternehmens reagieren, neue Ressourcen für neu entstehende Arbeitslasten auf Abruf bereitstellen und neue Ressourcen oft gerade noch rechtzeitig hinzufügen, um die Unternehmensanwendungen am Laufen und sicher zu halten, und gleichzeitig Fehler und Versäumnisse bei der Systemverwaltung vermeiden, die kritische Systeme angreifbar machen könnten. Und all dies muss mit immer kleiner werdenden IT-Budgets und -Personal bewältigt werden. Bei der hyperkonvergenten Infrastruktur geht es vor allem um schnelle Bereitstellung und Flexibilität.

HCI nutzt dieselben Vorteile, die homogene Rechenzentrumsumgebungen populär gemacht haben: Plattformen eines einzigen Anbieters, die Kompatibilität, Interoperabilität und konsistentes Management gewährleisten und gleichzeitig die Möglichkeit bieten, im Falle eines Fehlers auf einen einzigen Anbieter zurückgreifen zu können. HCI geht jedoch noch weiter und stellt Rechen-, Speicher- und Netzwerkressourcen bereit, die mithilfe von softwaredefinierten und Virtualisierungstechnologien organisiert werden. Die Ressourcen sind eng integriert und voroptimiert, und die Hardware und Software sind in praktischen Appliances - oder Knoten - zusammengefasst, die zu Beginn einzeln eingesetzt und dann schnell und einfach skaliert werden können, wenn die Ressourcenanforderungen steigen.

Kurz gesagt, HCI-Produkte sind im Grunde Rechenzentren in einer Box. Wenn ein Unternehmen mehr Rechenzentren benötigt, werden einfach weitere Boxen hinzugefügt. Aber die Attraktivität von HCI geht über das Rechenzentrum hinaus. Die kompakten, hochintegrierten Angebote sind einfach zu installieren und können per Fernzugriff verwaltet werden, und die HCI-Technologie ist für ROBO- (Remote Office/Branch Office) und Edge-Computing-Implementierungen wichtig geworden.

Nehmen wir als Beispiel eine typische Big-Data-Installation, bei der Petabytes an Daten von einer Vielzahl von IoT-Geräten ankommen. Anstatt sich auf ein Netzwerk zu verlassen, um die Rohdaten zur Verarbeitung an ein Rechenzentrum zu senden, können die Daten lokal am Edge erfasst und gespeichert werden - dort, wo die Daten ihren Ursprung haben -, und eine HCI-Bereitstellung kann problemlos am Edge installiert werden, um die Rohdaten per Fernzugriff zu verarbeiten und zu analysieren, wobei die Überlastung des Netzwerks vermieden wird, indem nur die Analyseresultate an das Hauptrechenzentrum gesendet wird.

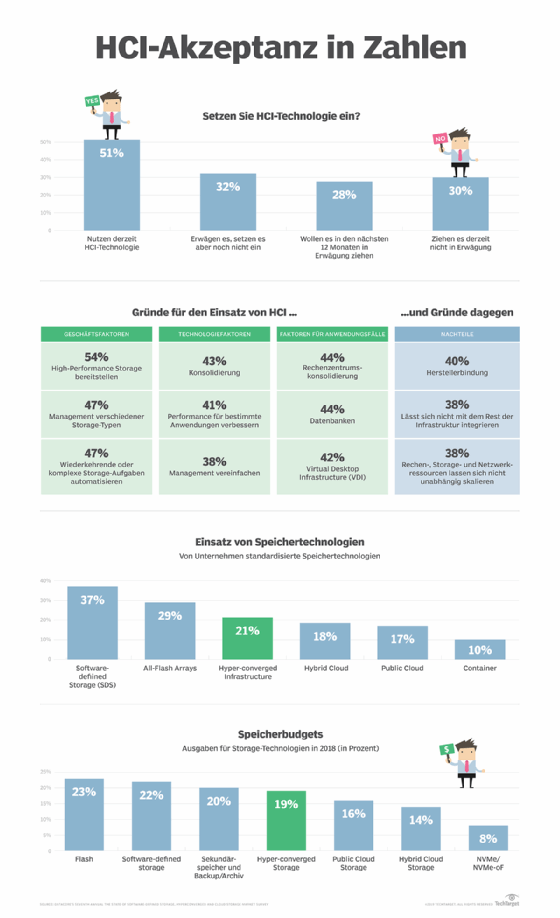

Warum Unternehmen auf Hyper-Konvergenz umsteigen

Im Jahr 2020 erzielte der Markt für hyperkonvergente Infrastrukturen einen Umsatz von etwa 2 Milliarden US-Dollar pro Quartal. Diese enormen Investitionen haben HCI von einer Nischen- oder SMB-Plattform zu einer brauchbaren Alternative auch für größere Unternehmen gemacht. Auch wenn HCI nicht für alle Workloads ideal ist, kann es doch eine größere Bandbreite von Anwendungen und Anwendungsfällen als je zuvor bewältigen.

HCI begann als Punktplattform - ein Mittel zur Vereinfachung und Beschleunigung kleiner IT-Implementierungen in ROBO sowie einer begrenzten Anzahl von Enterprise-Umgebungen, wie VDI. Schon früh nutzten große Unternehmen HCI, um geschäftsspezifische Ziele zu unterstützen, die von der Hauptproduktionsumgebung getrennt waren, die damit allein gelassen werden konnte, um die schweren Aufgaben zu bewältigen.

Heute profitieren HCI-Angebote von den radikalen Verbesserungen bei Prozessoren, Arbeitsspeicher und Speichergeräten sowie von den dramatischen Fortschritten bei softwaredefinierten Technologien, die die Art und Weise, wie Unternehmen Ressourcen und Workloads wahrnehmen und handhaben, neu definieren. Beispiele hierfür sind unter anderem:

- HCI-Unterstützung für Container-Cluster. Anbieter wie Dell EMC/VMware, Nutanix und Cisco bieten jetzt HCI-Konfigurationen an, die für Container-Software wie Kubernetes optimiert sind.

- Unterstützung für maschinelles Lernen und Deep-Learning-Algorithmen. Die Fähigkeit, ein riesiges Volumen an skalierbaren Containern zu unterstützen, macht HCI zu einer passenden Lösung für maschinelles Lernen und künstliche Intelligenz, die eine enorme Anzahl von Recheninstanzen erfordern.

- Das Aufkommen von Streaming Data Analytics. Streaming-Analytik ist ein Ausdruck von Big Data und ermöglicht es einem HCI-System, Daten und Metriken aus einer Vielzahl von Quellen in Echtzeit aufzunehmen, zu verarbeiten und auszuwerten. Solche Analysen können dazu genutzt werden, wertvolle Geschäftseinblicke zu gewinnen und mögliche Probleme oder Störungen vorherzusagen.

Die hyperkonvergente Infrastruktur hat das Edge Computing tiefgreifend beeinflusst. Die heutige Verbreitung von IoT-Geräten, Sensoren, entfernten Standorten und mobiler Erreichbarkeit verlangt von Unternehmen ein Umdenken bei der Erfassung, Speicherung und Verarbeitung enormer Datenmengen. In den meisten Fällen erfordert dies, dass das Unternehmen die Datenverarbeitung und -analyse aus dem zentralen Rechenzentrum auslagert und diese Ressourcen näher an die Datenquelle verlagert: zum Edge. Die Einfachheit und Vielseitigkeit von HCI-Angeboten macht die Remote-Bereitstellung und -Verwaltung wesentlich einfacher als bei herkömmlichen IT-Infrastrukturen.

Und schließlich eignet sich HCI aufgrund seiner Schnelligkeit und Flexibilität für eine schnelle Bereitstellung und sogar für eine schnelle Wiederverwendung. Das Auftreten der COVID-19-Pandemie hat dazu geführt, dass eine große Anzahl von Benutzern plötzlich von zu Hause arbeitet. Dies hat dazu geführt, dass Unternehmen plötzlich zusätzliche Ressourcen und Infrastrukturen bereitstellen mussten, um die geschäftlichen Datenverarbeitungsanforderungen von Benutzern, die jetzt von zu Hause arbeiten, zu erfüllen. HCI-Systeme haben bei solchen schnellen Infrastrukturanpassungen eine große Rolle gespielt.

Hyperkonvergente Infrastruktur vs. konvergente Infrastruktur

Die heutigen hyperkonvergenten Infrastrukturtechnologien sind nicht über Nacht entstanden. Die verfügbaren HCI-Produkte sind das Ergebnis einer jahrzehntelangen Entwicklung von Rechenzentren und Anwendungsfällen. Um die Entwicklung zu verstehen, ist es wichtig, mit den traditionellen Rechenzentrumsansätzen zu beginnen, bei denen Rechen-, Speicher- und Netzwerkgeräte einzeln ausgewählt, bereitgestellt und in der Regel auch verwaltet wurden. Dieser Ansatz hat sich bewährt, erforderte jedoch eine sorgfältige Integration, um sicherzustellen, dass alle Geräte zusammenarbeiten und eine angemessene Leistung erbringen - eine Optimierung war, wenn überhaupt, nur begrenzt möglich.

Als sich das Geschäftstempo beschleunigte, erkannten die Unternehmen die Vorteile von Integration und Optimierung bei der Bereitstellung und Leistung. Wenn es möglich wäre, die Herausforderungen der Integration, Konfiguration und Optimierung neuer Geräte zu umgehen, könnten Implementierungen schneller und mit weniger Problemen durchgeführt werden.

So entstand der Begriff der Konvergenz, der es den Anbietern ermöglichte, Server-, Speicher- und Netzwerkkomponenten zu entwickeln, die bereits vorkonfektioniert und vorintegriert waren und deren Zusammenspiel bereits validiert war. Obwohl es sich bei der konvergenten Infrastruktur im Grunde um ein Paket von Geräten verschiedener Anbieter handelte, war die zeitaufwändige Integrations- und Optimierungsarbeit bereits erledigt. In den meisten Fällen war auch eine Softwareschicht enthalten, mit der die konvergenten Infrastrukturprodukte gemeinsam verwaltet werden konnten, so dass das KI-Paket im Grunde aus einem Guss war.

Schließlich erkannten die Anbieter, dass Konvergenz ein noch höheres Maß an Integration und Leistung bieten konnte, indem sie auf die Produkte mehrerer Anbieter verzichteten und stattdessen einen Ansatz verfolgten, der Rechen-, Speicher- und Netzwerkkomponenten in einem einzigen Produkt zusammenfasste. Dieses Konzept wurde als Hyperkonvergenz bezeichnet und führte zum Trend der hyperkonvergenten Infrastruktur.

HCI-Produkte zeichnen sich häufig durch eine modulare Architektur aus, die es ermöglicht, Rechen-, Speicher- und Netzwerkkomponenten als Module zu bauen, die in einem speziellen Rack installiert werden. Der physische Blade-Formfaktor erwies sich als äußerst beliebt für HCI-Module und -Racks, da er eine schnelle Installation und Hot-Swap-Funktionen für Module ermöglicht. Dem Blade-Rack konnten weitere Rechen-, Speicher- und Netzwerk-Blades hinzugefügt werden. Wenn das Rack voll war, konnte ein neues Rack installiert werden, um weitere Module aufzunehmen - eine weitere Skalierung der Bereitstellung. Was die Software betrifft, so ist die HCI-Umgebung vollständig virtualisiert und umfasst einheitliche Management-Tools für die Konfiguration, das Pooling, die Bereitstellung und die Fehlerbehebung von HCI-Ressourcen.

HCI 1.0 vs. HCI 2.0

Die hyperkonvergente Infrastruktur entwickelt sich ständig weiter und bringt neue Funktionen und Möglichkeiten auf den Markt, während gleichzeitig daran gearbeitet wird, vermeintliche Einschränkungen zu überwinden und potenzielle Anwendungsfälle zu erweitern. Heute gibt es keine allgemein akzeptierte Terminologie, um die Entwicklung von HCI zu definieren, aber die Technologie wird umgangssprachlich als HCI 1.0 und HCI 2.0 bezeichnet. Der Hauptunterschied zwischen diesen Bezeichnungen besteht in der Verwendung der Disaggregation.

Die ursprüngliche Prämisse von HCI bestand darin, eng integrierte und optimierte Sets von virtualisierten CPUs, Arbeitsspeicher, Storage und Netzwerkverbindungen in vorgefertigten Knoten bereitzustellen. Wenn mehr Ressourcen benötigt werden, ist es ein Leichtes, einfach weitere Knoten hinzuzufügen. Eine einheitliche Verwaltungssoftware erkennt, bündelt, konfiguriert, stellt bereit und verwaltet alle virtualisierten Ressourcen. Der Punkt ist, dass hyperkonvergente Infrastrukturen auf der Nutzung von Aggregation beruhen, das heißt, alles wird in einer Box untergebracht, die einfach und schnell bereitgestellt werden kann. Diese zugrunde liegende Nutzung der Aggregation machte die HCI 1.0-Produkte so attraktiv für die schnelle Bereitstellung in ROBO- und Edge-Anwendungsfällen.

Der Hauptkritikpunkt an HCI 1.0-Produkten ist die Auslastung der Ressourcen und das Potenzial für Ressourcenverschwendung. Ein typisches HCI-Produkt bietet eine begrenzte und feste Menge an CPU, Arbeitsspeicher und Speicher. Der Anteil dieser Ressourcen spiegelt im Allgemeinen eher traditionelle, ausgewogene Arbeitslasten wider. Workloads, die ungleichmäßige oder unverhältnismäßige Anforderungen an die Ressourcen stellen, können jedoch dazu führen, dass einige Ressourcen schnell erschöpft sind und das Unternehmen gezwungen ist, kostspieligere Knoten hinzuzufügen, um die Ressourcenknappheit zu decken, während die verbleibenden Ressourcen nicht voll ausgelastet sind.

Disaggregation wird zunehmend als potenzielle Antwort auf das Problem der HCI-Ressourcenverschwendung gesehen. Die Einführung einer disaggregierten hyperkonvergenten Infrastruktur - dHCI oder HCI 2.0 - trennt im Wesentlichen die Rechenressourcen vom Speicher. Bei HCI 2.0 befinden sich CPU und Arbeitsspeicher in einem Gerät und der Speicher in einem anderen Gerät, und beide Geräte können bei Bedarf separat hinzugefügt werden. Mit diesem Ansatz können Unternehmen ihre HCI-Investitionen gezielt einsetzen, um weniger traditionelle Workloads zu unterstützen, die möglicherweise spezifischere Ressourcenanforderungen stellen. Nimble Storage dHCI, NetApp HCI und Datrium DVX sind Beispiele für HCI 2.0.

Die Entwicklung von HCI ist jedoch nicht bei der Disaggregation stehen geblieben, und die HCI-Branche beginnt, das Konzept der Composable Infrastructure zu übernehmen. Theoretisch werden bei einer Composable Infrastructure alle Ressourcen in unabhängig voneinander skalierbare Komponenten aufgeteilt, die je nach Bedarf hinzugefügt und über eine spezielle Netzwerkstruktur miteinander verbunden werden können, die eine schnelle Kommunikation mit geringer Latenz zwischen den Komponenten unterstützt. Gleichzeitig sorgt eine einheitliche Verwaltungssoftware für die Erkennung, Zusammenführung, Konfiguration, Bereitstellung und Verwaltung aller verfügbaren Ressourcen.

Heute ist die Composable Infrastructure noch weit von einem solchen Idealszenario entfernt, aber die Anbieter beginnen, HCI-Geräte mit größerer Vielseitigkeit bei der Hardwareauswahl und -bereitstellung zu liefern, zum Beispiel mit der Möglichkeit, andere, nicht vom Hersteller stammende Speicher hinzuzufügen. Der Schlüssel zum Erfolg einer Composable Infrastruktur ist eine Verwaltungssoftware, die sich auf Ressourcenerkennung, Pooling, Tiering - die Organisation von Ressourcen auf der Grundlage ihres relativen Leistungsniveaus - und die fast vollständige Abhängigkeit von softwaredefinierten Verhaltensweisen zur Bereitstellung von Ressourcen konzentrieren muss.

Hyperkonvergente Infrastruktur und die Cloud

Es ist leicht, HCI und Cloud-Technologie zu verwechseln. Beide basieren auf Virtualisierung und einer ausgereiften Software-Verwaltungsebene, die eine Vielzahl von Hardwareressourcen definieren, organisieren, bereitstellen und verwalten kann, auf denen Unternehmens-Workloads arbeiten können. Obwohl HCI und Cloud gut zusammenarbeiten können, sind sie nicht dasselbe, und es gibt subtile, aber wichtige Unterschiede zu beachten.

HCI ist im Grunde ein zentralisierter, softwaregesteuerter Ansatz für die Bereitstellung und Nutzung einer Rechenzentrumsinfrastruktur. Die zugrunde liegende Hardware ist klar definiert, und die Menge der Hardwareressourcen ist endlich. Die Virtualisierung abstrahiert die Ressourcen, während die Software die Art und Weise der Bereitstellung von Ressourcen für Arbeitslasten organisiert und definiert.

Eine Cloud soll Computing als Dienstprogramm bereitstellen, indem sie riesige Mengen virtualisierter Ressourcen umhüllt, die die Benutzer mit Hilfe von Software-Tools nach Belieben bereitstellen und freigeben können. Die Cloud bietet nicht nur ein riesiges Reservoir an Ressourcen, sondern auch eine Vielzahl vordefinierter Dienste wie Load Balancing, Datenbanken und Überwachungs-Tools, die der Benutzer nach Belieben implementieren kann.

Der Unterschied zwischen HCI und Cloud ist im Wesentlichen der Unterschied zwischen Hardware und Software. HCI ist lediglich eine Implementierung von Hardware, die in einem Rechenzentrum eingesetzt werden kann. Bei einer Cloud handelt es sich um die Software und die dazugehörigen Dienste - den Cloud-Stack -, die auf der verfügbaren Hardware ausgeführt werden. Daher kann eine HCI-Implementierung zur Unterstützung einer Cloud verwendet werden, typischerweise einer privaten Cloud oder einer privaten Cloud, die als Teil einer hybriden Cloud integriert ist und die digitale Transformation unterstützt. Umgekehrt wird ein Cloud-Software-Stack auf einer HCI-Bereitstellung im Rechenzentrum ausgeführt.

Azure Stack HCI ist beispielsweise eine Version von Microsoft Azure Public Cloud Stack, die auf lokaler HCI-Hardware ausgeführt werden kann. In ähnlicher Weise ist VCF on VxRail von Dell ein Beispiel für ein HCI-Angebot, das eine Software-Suite umfasst, mit der die HCI-Plattform als private Cloud betrieben werden kann - und die private Cloud in öffentliche Cloud-Umgebungen, wie VMWare on AWS, integriert werden kann.

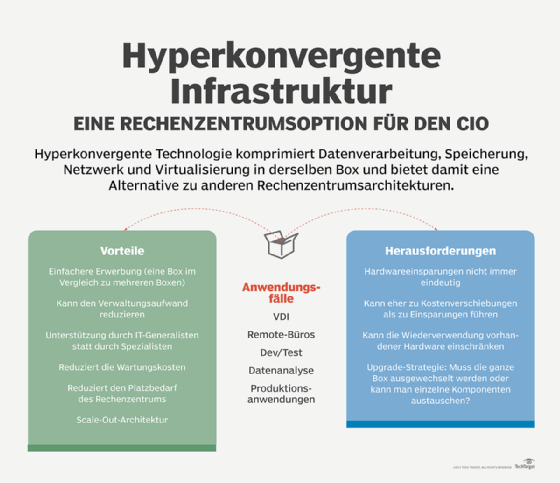

Vor- und Nachteile einer HCI

Eine hyperkonvergente Infrastruktur ist nicht für jedes IT-Projekt oder jeden Einsatz geeignet. Unternehmen müssen sich die Zeit nehmen, die Technologie zu bewerten, Proof-of-Concept-Tests durchzuführen und die damit verbundenen Kompromisse sorgfältig abzuwägen, bevor sie sich für HCI entscheiden.

Der Hauptvorteil von HCI ist die Einfachheit, und diese Einfachheit drückt sich auf verschiedene Weise aus. Zum Beispiel vereinfacht die modulare Natur eines HCI-Angebots die Bereitstellung. Die Installationszeit wird erheblich verkürzt, und auch die Zeit, die für die Konfiguration des installierten Systems und die Bereitstellung von Ressourcen für Workloads benötigt wird, ist potenziell kürzer als bei herkömmlichen Hardware-Implementierungen. Wenn zusätzliche Ressourcen benötigt werden, kann einfach ein weiterer HCI-Knoten installiert werden, und HCI-Anbieter offerieren oft mehrere verschiedene Knotentypen, beispielsweise Knoten mit zusätzlichem Speicher oder zusätzlicher Rechenleistung, um unterschiedlichen Workload-Anforderungen gerecht zu werden. Typische Integrationsprobleme und Optimierungsherausforderungen werden erheblich reduziert, da das HCI-System von vornherein auf Interoperabilität und Optimierung ausgelegt ist.

Die Einfachheit zeigt sich auch in einem schnelleren und effizienteren HCI-Management. Die Verwendung einer einheitlichen Managementplattform stellt sicher, dass alle HCI-Ressourcen erkannt, zusammengeführt und ordnungsgemäß konfiguriert werden - unter Einhaltung der vom Unternehmen bevorzugten Richtlinien für Sicherheit und Geschäftsprozesse - sowie effizient bereitgestellt werden, wobei alle Ressourcen sichtbar sind und überwacht werden. HCI-Systeme eignen sich gut für die Automatisierung von Bereitstellung und Wartung. Dies ist ein Grund dafür, dass HCI bei Private Clouds, VDI und anderen Arten von IT-Projekten, die von der Automatisierung profitieren, sehr beliebt geworden ist. Dies ist effektiver als bei heterogenen Umgebungen, die unter Umständen mehrere Verwaltungs-Tools erfordern und bei denen versehentlich Ressourcen übersehen werden können, wenn sie nicht richtig erkannt werden.

Letztendlich sind die HCI-Bereitstellung und die Zeit bis zur Produktionsreife einfacher und schneller als bei herkömmlichen heterogenen Bereitstellungen, so dass HCI auch von kleineren Unternehmen mit weniger IT-Personal und weniger technischen Kenntnissen bereitgestellt und unterstützt werden kann. Diese Einfachheit wirkt sich auch auf den laufenden Service und Support aus. Da HCI von einem einzigen Anbieter stammt, ist auch der Support Teil des Pakets, so dass ein einziger Anruf beim technischen Support zu konkreten Lösungen für dringende Probleme führen sollte, ohne dass ein anderer Anbieter dafür verantwortlich gemacht werden kann. Dies kommt auch kleineren IT-Teams und weniger qualifizierten IT-Mitarbeitern zugute. Die von HCI versprochene Einfachheit und Bequemlichkeit kann die Kosten für die Bereitstellung und den Betrieb einer HCI insgesamt senken.

HCI birgt jedoch auch einige potenzielle Nachteile, die sorgfältig abgewogen werden sollten. Die Skalierbarkeit geht zum Beispiel mit der Bindung an einen bestimmten Anbieter einher. Es ist einfach, einen weiteren Knoten hinzuzufügen, aber nur, wenn der neue Knoten vom selben Anbieter stammt. Es gibt keine offenen Standards für die physische oder logische Interoperabilität zwischen Knoten verschiedener HCI-Systeme oder -Anbieter. Herkömmliche HCI-Systeme (HCI 1.0) fassen außerdem CPU, Arbeitsspeicher und Speicher auf demselben Knoten zusammen, so dass der Kauf und die Erweiterung einer Ressource fast immer auch den Kauf die Erweiterung aller Ressourcen bedeutet, selbst wenn andere Ressourcen derzeit nicht benötigt werden, was eine Verschwendung von Ressourcen und Kapitalinvestitionen bedeuten kann. Der Vorstoß in Richtung Disaggregation - HCI 2.0 oder dHCI - verspricht, diese Verschwendung zu verringern.

HCI kann Probleme mit der Leistungsdichte mit sich bringen. Wenn riesige Mengen an Hardware auf relativ engem Raum untergebracht werden, kann dies zu Problemen mit den Stromverteilungssystemen und zum Einsatz einer punktuellen Kühlung in Rechenzentren führen. Das bedeutet, dass die HCI-Installation einfach ist, wenn die Anforderungen an die Stromversorgung und Kühlung erfüllt werden.

Der Umfang von HCI ist immer noch gering. Obwohl dies für viele Workloads kein Problem darstellt, sind größere Implementierungen mit vielen Compute-Servern und Dutzenden von Terabytes an Speicher möglicherweise besser mit separaten Compute- und Storage-Subsystemen bedient. Dieser traditionelle Ansatz ähnelt eher einer Disaggregation und ermöglicht es, anspruchsvolle Subsysteme separat zu skalieren und zu optimieren. Große Mengen an Server- oder Speicherkäufen können auch von Skaleneffekten profitieren, die HCI-Produkte nicht bieten können.

Einige High-End-Funktionen von HCI - wie Hochverfügbarkeit - sind möglicherweise nicht ohne zusätzliche Anschaffungen verfügbar. Ein HCI-Knoten ist beispielsweise nur dann wirklich redundant, wenn es mindestens einen zweiten HCI-Knoten gibt, auf dem parallele Arbeitslasten neben dem ersten ausgeführt werden. Dies stellt eine zusätzliche Investition dar, die das Unternehmen möglicherweise nicht tätigen kann, zumindest nicht zu Beginn.

Einer der wiederkehrenden Nachteile sind die HCI-Kosten. HCI-Produkte sind herstellerabhängig und haben in der Regel einen hohen Preis, da es keine einheitliche Interoperabilität zwischen den Angeboten der Hersteller gibt. Aggregierte Knoten können unerwünschte Kapitalkosten für Ressourcen verursachen, die möglicherweise nicht alle benötigt werden. Die Kosten für Softwarelizenzen und Wartungsverträge können die wiederkehrenden HCI-Kosten in die Höhe treiben. Außerdem können die Kosten je nach Knotentyp schwanken. So bieten HCI-Anbieter in der Regel mehrere verschiedene Knotenoptionen an, die unterschiedliche Kombinationen von CPU, Speicher, Storage und Netzwerkkonnektivität bieten, um den verschiedenen Workload-Anforderungen gerecht zu werden. Die Auswahl von Knoten mit High-End-CPUs, nichtflüchtigem Speicher, 10-Gigabit-Ethernet und anderen Optionen kann den Preis für eine HCI-Bereitstellung in die Höhe treiben.

HCI-Verwaltung und -Implementierung

Obwohl HCI dem Unternehmen eine ganze Reihe von Vorteilen bringt, gibt es auch zahlreiche Überlegungen zur Verwaltung und Implementierung, die sorgfältig bewertet und verstanden werden müssen, bevor eine HCI-Investition überhaupt getätigt wird.

Ein wichtiger Punkt ist die Ausfallsicherheit. HCI vereinfacht die Bereitstellung und den Betrieb, aber hinter der Einfachheit, die die Benutzer sehen, verbirgt sich eine enorme Komplexität. Fehler, Störungen und Ausfälle können zu einer Bedrohung für wichtige Geschäftsdaten werden. Und obwohl HCI-Angebote Resilienz unterstützen können, ist diese Funktion niemals automatisch, und sie kann ein detailliertes Verständnis der inneren Funktionsweise des HCI-Systems erfordern, wie zum Bespiel Schreibbestätigung, RAID-Levels oder andere Speichertechniken, die für die Resilienz verwendet werden.

Um zu verstehen, wie ein HCI-Angebot tatsächlich mit der Datenausfallsicherheit umgeht, müssen IT-Führungskräfte das Angebot bewerten und berücksichtigen, wie das System mit Knoten- oder Hardwareausfällen umgeht, wie die Standardoperationen der Datenausfallsicherheitsoperationen aussehen, wie sich die Verwendung von Ausfallsicherheitsoptionen auf die Workload-Performance auswirkt und welche Overhead-Ressourcenkapazität zur Bereitstellung der Ausfallsicherheit verwendet wird.

Bei der Verwaltung von HCI-Systemen können Benutzer oft von Verwaltungs-Tools von Drittanbietern profitieren, wie der Unterstützung von DataOn HCI-Systemen für Windows Admin Center. Durch die Offenlegung von APIs können Tools und Services von Drittanbietern mit HCI verbunden werden, um eine breitere Palette von Services oder Integrationen anzubieten.

HCI-Bereitstellungen und -Verwaltung profitieren auch von einem klaren Anwendungsfall. Daher ist es wichtig, alle spezifischen oder maßgeschneiderten Rollen zu verstehen, die ein HCI-System in der Umgebung spielt, und diese Rollen entsprechend zu verwalten. Beispielsweise wird eine HCI-Bereitstellung, die für Backup und Disaster Recoveryvorgesehen ist, wahrscheinlich anders verwaltet und unterstützt als eine HCI-Bereitstellung, die für alltägliche Produktions-Workloads verwendet wird.

Nutzen Sie die Vorteile einer automatischen Richtlinienverwaltung und/oder -durchsetzung, die das HCI-System bietet. Neue softwaredefinierte Tools wie Nutanix Flow können ein Netzwerk- und Richtlinienmanagement ermöglichen, das die Bereitstellung beschleunigt und gleichzeitig Best Practices für das Unternehmen durchsetzt, beispielsweise die Anpassung von Konfigurationseinstellungen und die Implementierung von Anwendungssicherheit. Diese Funktionen sind häufig in der Lage, Berichte und Warnungen bei Abweichungen von den Richtlinien zu erstellen, so dass Unternehmen eine sorgfältige Kontrolle über die Ressourcennutzung und die Konfigurationen behalten können.

Und schließlich sollten Sie bei der Auswahl der Management-Tools Vorsicht walten lassen. Die zu HCI-Systemen gehörenden Tools sind in der Regel proprietär und können nicht ohne weiteres - wenn überhaupt - mit anderen Servern, Speicher- und Netzwerkelementen im gesamten Rechenzentrum zusammenarbeiten. Unternehmen, die breitere Umgebungen überwachen und verwalten müssen, ohne die Silos, die mit mehreren Management-Tools einhergehen, könnten von der Übernahme von Tools von Drittanbietern profitieren, wie Zenoss, Uila, EG Innovations EG Enterprise und ManageEngine OpManager.