Edge-Rechenzentrum

Edge-Rechenzentren sind kleine Data Center, die sich am Edge (Rand) eines Netzwerks befinden. Sie nutzen die gleichen Geräte wie herkömmliche Rechenzentren, haben jedoch einen kleineren Footprint und befinden sich näher an den Endbenutzern und Geräten. Edge-Rechenzentren können IoT-Geräten im Cache gespeicherte Inhalte und Cloud-Computing-Ressourcen zur Verfügung stellen. Das Konzept funktioniert auf der Basis von Edge Computing, eine verteilte Architektur, in der Client-Daten so nah wie möglich an der Ursprungsquelle verarbeitet werden. Da die kleineren Rechenzentren in der Nähe der Endbenutzer positioniert sind, werden sie dazu verwendet, schnelle Dienste mit minimaler Latenzzeit bereitzustellen.

In einer Edge-Computing-Architektur können zeitkritische Daten am Ursprungsort von einem Zwischenserver verarbeitet werden, der sich in unmittelbarer geographischer Nähe zum Client befindet. Dabei geht es darum, Inhalte so schnell wie möglich an ein Endgerät zu liefern. Daten, die weniger zeitkritisch sind, können zur historischen Analyse, für Big-Data-Analysen und zum langfristigen Speichern an ein größeres Datenzentrum gesendet werden. Edge-Rechenzentren arbeiten nach dem gleichen Konzept, nur dass es hier nicht nur einen Zwischenserver in unmittelbarer geografischer Nähe zum Client gibt, sondern ein kleines Rechenzentrum. Auch wenn das Konzept nicht unbedingt neu ist, ist der Begriff Edge-Rechenzentrum relativ rezent.

Der Hauptvorteil eines Edge-Rechenzentrums ist die schnelle Bereitstellung von Diensten mit minimaler Latenzzeit dank des Einsatzes von Edge-Caching. Die Latenz kann für Organisationen, die mit dem Internet der Dinge (Internet of Things, IoT), Big Data, Cloud- und Streaming-Diensten arbeiten müssen, ein großes Problem darstellen.

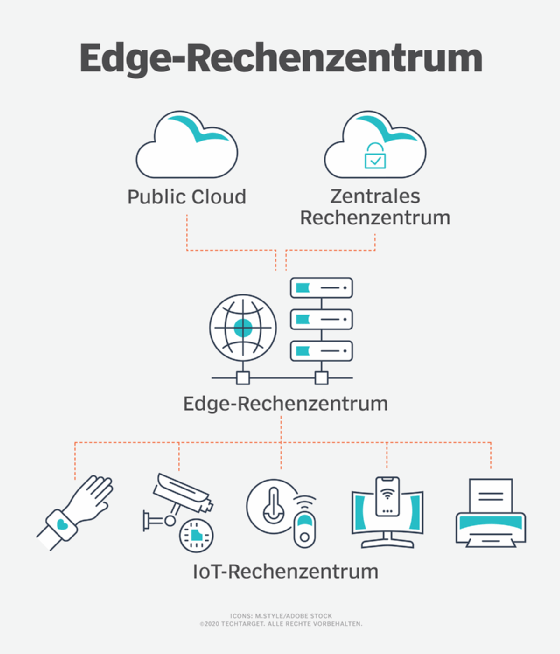

Üblicherweise werden Edge-Rechenzentren mit einem größeren, zentralen Data Center oder mehreren anderen Edge-Rechenzentren verbunden. Die Daten werden so nah wie möglich am Endbenutzer verarbeitet, während weniger integrale oder zeitkritische Daten zur Verarbeitung an ein zentrales Rechenzentrum gesendet werden können. Auf diese Weise kann ein Unternehmen die Latenzzeit reduzieren.

Anwendungsfälle für 5G- und andere Edge-Rechenzentren

Edge-Rechenzentren können von Organisationen genutzt werden, die unter anderem in folgenden Bereichen arbeiten:

- 5G. Ein dezentrales Netzwerk aus Edge-Rechenzentren kann dazu beitragen, niedrige Latenzzeiten für 5G in Anwendungsfällen mit hoher Gerätedichte zu bieten.

- Telekommunikationsunternehmen. Mit Edge-Rechenzentren an Mobilfunkantennen können Telekommunikationsunternehmen durch die Verbindung von Mobiltelefonen und drahtlosen Sensoren eine größere Nähe zu den Endbenutzern erreichen.

- IoT. Edge-Rechenzentren können Daten aus IoT-Geräten verarbeiten. Das gilt besonders dann, wenn die Informationen zu zeitkritisch sind, um an einen zentralen Server gesendet zu werden.

- Gesundheitswesen. Einige medizinische Geräte benötigen Netzwerkkonsistenz und eine extrem niedrige Latenzzeit. Edge-Rechenzentren können diese Ansprüche erfüllen.

- Autonome Fahrzeuge. Edge-Rechenzentren können zum Erfassen, Verarbeiten und gemeinsamen Nutzen von Daten zwischen Fahrzeugen und anderen Netzwerken eingesetzt werden. Auch hier sind die geringen Latenzen von Vorteil. Ein Netzwerk von Edge-Datenzentren kann Daten für Automobilhersteller und Notfalldienste sammeln.

- Industrie 4.0. Edge-Rechenzentren können Predictive Maintenance (Vorausschauende Wartung) und vorausschauendes Qualitätsmanagement unterstützen. Sie können die Effizienz der in der Lagerverwaltung durch Robotik verbessern.

Merkmale von Edge-Rechenzentren

Die meisten Edge-Computer weisen ähnliche Schlüsselmerkmale auf, darunter

- Standort. Edge-Rechenzentren stehen im Allgemeinen in der Nähe der Endgeräte, mit denen sie vernetzt sind.

- Größe. Edge-Rechenzentren haben eine viel kleinere Grundfläche, aber die gleichen Komponenten wie ein herkömmliches Rechenzentrum.

- Art der Daten. Edge-Rechenzentren beherbergen in der Regel geschäftskritische Daten, die eine geringe Latenzzeit erfordern.

- Bereitstellung. Ein Edge-Rechenzentrum kann sich in einem Netzwerk aus anderen Edge-Rechenzentren befinden oder mit einem größeren, zentralen Rechenzentrum verbunden sein.

Einige Edge-Rechenzentren verwenden auch Mikro-Rechenzentren (Micro Data Center, MDC). Ein Mikro-Rechenzentrum ist ein relativ kleines, modulares System, das ein größeres System ergänzt oder die Ansprüche kleinerer Unternehmen erfüllt. Ein Mikro-Rechenzentrum enthält meist weniger als zehn Server und weniger als 100 virtuelle Maschinen (VMs) in einem einzigen 19-Zoll-Kasten. MDCs verfügen über integrierte Sicherheits- und Kühlsysteme sowie Hochwasser- und Brandschutz.

Ihr großer Vorteil für Edge-Rechenzentren ist die Skalierbarkeit. Zum Beispiel kann ein Mobilfunk- oder Radiosandort mit solchen modularen Mikro-Rechenzentren ausgestattet sein. Sie sind jedoch nicht mit Edge-Rechenzentren synonym, sondern eher eine Komponente derselben.

Wie funktionieren Edge-Rechenzentren?

Kurz gesagt arbeiten Edge-Datenzentren als Verbindung zwischen zwei Netzwerken. Das Edge-Rechenzentrum befindet sich an einem Internetknoten näher an dem Rechner, der eine Anfrage stellt. Der Internetknoten ist ein physischer Ort, an dem mehrere Netzwerkbetreiber und Dienstanbieter eine Verbindung herstellen. Dies ermöglicht einen schnellen Verkehrsfluss zwischen den Netzwerken. Das Edge-Rechenzentrum kann zum Beispiel aus einem Mikro-Rechenzentrum bestehen. Durch die Möglichkeit, Verarbeitungsanforderungen wie JavaScript-Dateien oder HTML näher an den anfordernden Rechner zu verlagern, verringert sich der Zeitaufwand für die Rücklieferung dieser Daten.

Auch wenn ein Edge-Rechenzentrum allein mehrere Dienste bereitstellen kann, steht es in der Regel in einer Rückverbindung zu einem größeren Rechenzentrum. Dieses Rechenzentrum kann mehr Cloud-Ressourcen und zentralisierte Datenverarbeitung bereitstellen. Es kann auch zentral die Verbindung mit mehreren Edge-Rechenzentren steuern.

Edge-Rechenzentren lassen sich oft aus der Ferne verwalten, was beispielsweise für Telekommunikationsunternehmen interessant ist, die Edge-Rechenzentren an ihren Mobilfunktürmen betreiben.

Arten von Edge-Rechenzentren

Es gibt zwei Haupttypen von Edge-Rechenzentren. Zum einen wäre da ein kleines Data Center, das von einem Service- oder Colocation Provider für die Versorgung sekundärer Standorte genutzt wird, und zweitens, wie bereits dargelegt, ein modularisierter Standort in der Nähe des Edges des eigenen Hauptnetzwerks einer Organisation. In vielen Unternehmen, die an mehreren Standorten tätig sind, benötigt jeder Standort Zugang zu den zentralen Unternehmensdaten und -systemen. Edge-Datenzentren, die auf modularisierten Systemen basieren, sind hier nützlich. Ein großes Rechenzentrum kann auch aus einer Reihe kleinerer Module aufgebaut werden.

Edge-Computing-Standorte können in netzwerkbasierte Standorte oder establishment-basierte Standorte unterteilt werden. Netzwerkbasierte Standorte haben in der Regel eine mehrschichtige Architektur, die speziell auf die Unterstützung von Edge-Rechenzentren ausgelegt ist. Dieser Ansatz wird wegen seiner hohen Verfügbarkeit und Ausfallsicherheit bevorzugt.

Establishment-basierte Edge-Rechenzentren können abgestufte Architekturen verwenden, jedoch nur für Konfigurationen außerhalb des Standorts. Diese werden in der Regel für private Netzwerke betrieben. Sie können den Transportbedarf zwischen Zugangs- und Aggregationsstandorten orchestrieren und Daten für die Verarbeitung sammeln – getrennt von Kerndatenverarbeitung und -Speicherung.

Auswirkungen auf bestehende Rechenzentrumsmodelle

Mit der aktuellen und zukünftigen Erweiterung von 5G werden Edge-Rechenzentren immer populärer und weiter verbreitet. Das bedeutet aber nicht das Ende für bestehende Rechenzentrumsmodelle. Da Edge-Rechenzentren auf größere Rechenzentren angewiesen sind, sollte bei einer Zunahme von Edge-Rechenzentren auch die Nutzung größerer Rechenzentren zunehmen. Und mit der Zunahme von Edge-IoT-Geräten wird die zu verarbeitende Datenmenge ohnehin traditionelle Rechenzentren erfordern.

Edge versus Fog

Fog Computing und Edge Computing ähneln sich stark in Konzept und Verwendung. Fog Computing ist ein Begriff, der 2014 von Cisco geschaffen wurde, um eine dezentralisierte Computerinfrastruktur zu beschreiben. Der Begriff ist auch ebenfalls eng mit dem Internet der Dinge verbunden. Der Hauptunterschied zwischen Edge Computing und Fog Computing besteht darin, dass Fog Computing spezifisch einen Knoten zwischen der Cloud und Edge-Geräten beschreibt. Das bedeutet, dass Fog Computing die Daten innerhalb eines IoT-Gateways, das sich innerhalb des LAN befindet, verarbeitet, anstatt sie so nah wie möglich an den Edge-Geräten zu platzieren. Mit Fog Computing können Unternehmen die LAN-Hardware physisch weiter von den Endbenutzergeräten entfernt platzieren. Sowohl Edge Computing als auch Fog Computing ähneln sich insofern, als sie beide die Datenverarbeitung weg von zentralisierten Datenzentren und stattdessen näher an die Endbenutzergeräte verlagern – aber Edge Computing findet typischerweise in größerer physischer Nähe statt.