Deepfake

Was ist ein Deepfake?

Bei einem Deepfake (oder auch Deep Fake) werden mit Hilfe von künstlicher Intelligenz Bilder, Audio- oder Videofälschungen erzeugt, die täuschend echte Inhalte vorgaukeln. Deepfake AI ist eine Art von künstlicher Intelligenz, die zur Erstellung überzeugender Bilder, Audio- und Videofälschungen verwendet wird. Der Begriff beschreibt sowohl die Technologie als auch die daraus resultierenden gefälschten Inhalte und ist ein Kofferwort aus Deep Learning und Fake.

Deepfakes wandeln oft bestehende Quellinhalte um, indem sie eine Person durch eine andere ersetzen. Sie schaffen auch völlig neue Inhalte, in denen jemand dargestellt wird, der etwas tut oder sagt, was er nicht getan oder gesagt hat. Die größte Gefahr, die von Deepfakes ausgeht, ist ihre Fähigkeit, falsche Informationen zu verbreiten, die scheinbar aus vertrauenswürdigen Quellen stammen. Im Jahr 2022 wurde beispielsweise ein Deepfake-Video veröffentlicht, in dem der ukrainische Präsident Selenskyj seine Truppen zur Kapitulation auffordert.

Es gibt auch Bedenken geäußert, dass sie sich in Wahlen und Wahlpropaganda einmischen könnten. Deepfakes stellen zwar eine ernsthafte Bedrohung dar, haben aber auch legitime Verwendungszwecke, wie zum Beispiel Audio- und Unterhaltungsanwendungen für Videospiele und Anwendungen für den Kundensupport und die Anrufbeantwortung, wie zum Beispiel Anrufweiterleitung und Empfangsdienste.

Wie funktionieren Deepfakes?

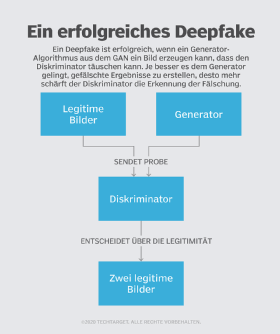

Bei der Erzeugung von Deepfake-Inhalten kommen zwei konkurrierende KI-Algorithmen (künstliche Intelligenz) und Deep Learning zum Einsatz. Der eine Algorithmus wird als Generator bezeichnet, der zweite als Diskriminator. Der Generator erstellt einen Trainingsdatensatz auf der Grundlage der gewünschten Ausgabe und erzeugt so den ersten gefälschten digitalen Inhalt, während der Diskriminator analysiert, wie realistisch oder gefälscht die erste Version des Inhalts ist. Dieser Prozess wird wiederholt, so dass der Generator immer besser realistische Inhalte erstellen kann und der Diskriminator immer besser in der Lage ist, Fehler zu erkennen, die der Generator korrigieren muss.

Durch die Kombination von Generator- und Diskriminator-Algorithmus entsteht ein Generative Adversarial Network (GAN). Ein GAN nutzt Deep Learning, um Muster in echten Bildern zu erkennen, und verwendet diese Muster dann, um die Fälschungen zu erstellen. Bei der Erstellung eines gefälschten Fotos betrachtet ein GAN-System Fotos des Ziels aus einer Reihe von Winkeln, um alle Details und Perspektiven zu erfassen. Bei der Erstellung eines gefälschten Videos betrachtet das GAN das Video aus verschiedenen Blickwinkeln und analysiert außerdem Verhaltens-, Bewegungs- und Sprachmuster. Diese Informationen werden dann mehrmals durch den Diskriminator laufen gelassen, um den Realismus des endgültigen Bildes oder Videos abzustimmen.

Deepfake-Videos werden auf eine von zwei Arten erstellt. Sie können eine originale Videoquelle der Zielperson verwenden, in der die Person dazu gebracht wird, Dinge zu sagen und zu tun, die sie nie getan hat; oder sie können das Gesicht der Person in einem Video einer anderen Person austauschen, was auch als Face Swap bekannt ist.

Im Folgenden werden einige spezifische Ansätze zur Erstellung von Deepfakes beschrieben:

- Deepfakes von Quellvideos. Bei der Arbeit mit einem Quellvideo analysiert ein auf einem neuronalen Netzwerk basierender Deepfake-Autoencoder den Inhalt, um relevante Attribute des Ziels zu verstehen, wie beispielsweise Gesichtsausdrücke und Körpersprache. Anschließend werden diese Merkmale auf das Video übertragen. Dieser Autoencoder umfasst einen Encoder, der die relevanten Attribute kodiert, und einen Decoder, der diese Attribute auf das Zielvideo überträgt.

- Audio-Deepfakes. Bei Audio-Deepfakes klont ein GAN die Stimme einer Person, erstellt ein Modell auf der Grundlage der Stimmmuster und verwendet dieses Modell, um die Stimme so zu verändern, dass sie alles sagt, was der Ersteller will. Diese Technik wird häufig von Videospielentwicklern eingesetzt.

- Lippensynchronisation. Lippensynchronisation ist eine weitere gängige Technik, die bei Deepfakes eingesetzt wird. Dabei ordnet der Deepfake dem Video eine Sprachaufnahme zu, so dass es so aussieht, als würde die Person im Video die Worte in der Aufnahme sprechen. Wenn die Audioaufnahme selbst ein Deepfake ist, wird durch das Video eine zusätzliche Täuschungsebene geschaffen. Diese Technik wird durch rekurrente neuronale Netze unterstützt.

Für die Erstellung von Deepfakes erforderliche Technologie

Die Entwicklung von Deepfakes wird immer einfacher, akkurater und verbreiteter, da die folgenden Technologien entwickelt und verbessert werden:

- Die GAN-Technologie für neuronale Netze wird bei der Entwicklung aller Deepfake-Inhalte eingesetzt, wobei Generator- und Diskriminator-Algorithmen verwendet werden.

- Convolutional Neural Networks (CNN), also in etwa faltende neuronale Netze, analysieren Muster in visuellen Daten. CNNs werden zur Gesichtserkennung und Bewegungsverfolgung eingesetzt.

- Bei Autoencodern handelt es sich um eine neuronale Netzwerktechnologie, die die relevanten Attribute eines Zielobjekts, wie zum Beispiel Gesichtsausdrücke und Körperbewegungen, identifiziert und diese Attribute dann auf das Quellvideo überträgt.

- Natural Language Processing (NLP), die Verarbeitung natürlicher Sprache, wird zur Erstellung von Deepfake-Audio verwendet. NLP-Algorithmen analysieren die Attribute der Sprache einer Zielperson und erzeugen dann anhand dieser Attribute Originaltext.

- High-Performance Computing ist eine Art des Computing, die die für Deepfakes erforderliche Rechenleistung in erheblichem Umfang bereitstellt.

Wie werden Deepfakes üblicherweise verwendet?

Deepfakes kommen in mannigfaltiger Weise zum Einsatz. Zu den wichtigsten Verwendungszwecken gehören die folgenden:

- Kunst. Deepfakes werden verwendet, um aus den vorhandenen Werken von Künstlern neue Musik zu erzeugen.

- Erpressung und Rufschädigung. Dies ist zum Beispiel der Fall, wenn eine Zielperson in einer illegalen, unangemessenen oder anderweitig kompromittierenden Situation gezeigt wird, wie zum Beispiel beim Lügen in der Öffentlichkeit, bei eindeutigen sexuellen Handlungen oder beim Drogenkonsum. Diese Videos werden verwendet, um ein Opfer zu erpressen, den Ruf einer Person zu ruinieren, sich zu rächen oder sie einfach nur im Internet zu schikanieren. Die häufigste Form der Erpressung oder Rache ist der nicht einvernehmliche Deepfake-Porno, auch bekannt als Racheporno.

- Unterhaltung. Hollywood-Filme und Videospiele klonen und manipulieren die Stimmen von Schauspielern für bestimmte Szenen. Unterhaltungsmedien verwenden dies, wenn eine Szene schwer zu drehen ist, in der Postproduktion, wenn ein Schauspieler nicht mehr am Set ist, um seine Stimme aufzunehmen, oder um dem Schauspieler und dem Produktionsteam Zeit zu sparen. Deepfakes werden auch für Satire und Parodien verwendet, bei denen das Publikum weiß, dass das Video nicht echt ist, sich aber an der humorvollen Situation erfreut, die das Deepfake erzeugt. Ein Beispiel ist das Deepfake von Dwayne „The Rock“ Johnson als Dora the Explorer aus dem Jahr 2023.

- Betrug. Deepfakes werden verwendet, um sich als eine Person auszugeben, um persönlich identifizierbare Informationen (PII) wie Bankkonto- und Kreditkartennummern zu erhalten. Dies kann manchmal auch bedeuten, dass sich Führungskräfte von Unternehmen oder andere Mitarbeiter mit Zugangsdaten zu sensiblen Informationen ausgeben, was eine große Gefahr für die Cybersicherheit darstellt.

- Fehlinformationen und politische Manipulation. Gefälschte Videos von Politikern oder vertrauenswürdigen Quellen werden verwendet, um die öffentliche Meinung zu beeinflussen und, wie im Fall des gefälschten ukrainischen Präsidenten Selenskyj, Verwirrung in der Kriegsführung zu stiften. Dies wird manchmal auch als Verbreitung von Fake News bezeichnet.

Deepfakes und die Rechtslage

Grundsätzlich muss ein Deepfake nicht gegen geltendes Recht verstoßen, kann es jedoch sehr schnell, je nach Art und Einsatzzweck. Dann können unterschiedlichste Rechte betroffen sein, wie etwa Persönlichkeitsrechte, Urheberrecht, Datenschutz und vieles mehr. Die rechtliche Einordnung wird sich vermutlich mit der sich verändernden Sachlage anpassen.

Methoden zur Erkennung von Deepfakes

Es gibt mehrere bewährte Verfahren zur Erkennung von Deepfake-Angriffen. Im Folgenden finden Sie Anhaltspunkte für mögliche Deepfake-Inhalte:

- Ungewöhnliche oder ungünstige Gesichtspositionen.

- Unnatürliche Gesichts- und Körperbewegungen.

- Unnatürliche Farbgebung.

- Videos, die beim Vergrößern oder Verkleinern seltsam aussehen.

- Inkonsistenter Ton.

- Menschen, die nicht blinzeln.

Bei Deepfakes in Textform gibt es einige Indikatoren:

- Rechtschreibfehler.

- Sätze, die nicht flüssig sind.

- Verdächtige E-Mail-Adressen.

- Formulierungen, die nicht mit dem vermeintlichen Absender zusammenpassen.

- Aus dem Zusammenhang gerissene Nachrichten, die für eine Diskussion, ein Ereignis oder ein Problem nicht relevant sind.

Die KI überwindet jedoch nach und nach einige dieser Indikatoren, beispielsweise mit Tools, die natürliches Blinzeln unterstützen.

Die Geschichte der Deepfake-Technologie

Die Technologie der künstlichen Intelligenz für Deepfakes ist relativ neu und hat ihren Ursprung in der Manipulation von Fotos mit Bildbearbeitungsprogrammen. Mitte der 2010er Jahre haben erschwingliche Rechenleistung, große Datensätze, KI und maschinelles Lernen dazu geführt, dass die Deep-Learning-Algorithmen immer ausgefeilter wurden.

Im Jahr 2014 wurde GAN, die Technologie, die den Deepfakes zugrunde liegt, von dem Forscher Ian Goodfellow von der Universität Montreal entwickelt. Im Jahr 2017 begann ein anonymer Reddit-Nutzer namens „deepfakes“, Deepfake-Videos von Prominenten sowie ein GAN-Tool zu veröffentlichen, mit dem Nutzer Gesichter in Videos austauschen konnten. Diese Videos gingen im Internet und in den sozialen Medien viral.

Die plötzliche Popularität von gefälschten Inhalten veranlasste Technologieunternehmen wie Facebook, Google und Microsoft, in die Entwicklung von Tools zur Erkennung von Fälschungen zu investieren. Trotz der Bemühungen von Technologieunternehmen und Regierungen, Deepfakes zu bekämpfen und die Herausforderung der Deepfake-Erkennung anzunehmen, entwickelt sich die Technologie weiter und erzeugt immer überzeugendere Deepfake-Bilder und -Videos.