DataOps

DataOps ist ein agiler Ansatz für den Entwurf, die Implementierung und die Wartung einer verteilten Datenarchitektur, die eine breite Palette von Open-Source-Tools und -Frameworks in der Produktion unterstützt. Das Ziel von DataOps ist es, aus Big Data einen geschäftlichen Nutzen zu ziehen.

Inspiriert von der DevOps-Bewegung zielt die DataOps-Strategie darauf ab, die Produktion von Anwendungen zu beschleunigen, die auf Big-Data-Verarbeitungs-Frameworks laufen. DataOps versucht auch, die Silos zwischen IT-Betrieb, Datenmanagement und Softwareentwicklungsteams zu überwinden, indem es die Interessenvertreter der Geschäftsbereiche ermutigt, mit Dateningenieuren, Datenwissenschaftlern und Analytikern zusammenzuarbeiten. Ziel ist es, sicherzustellen, dass die Daten des Unternehmens auf möglichst flexible und effektive Weise genutzt werden können, um positive und zuverlässige Geschäftsergebnisse zu erzielen.

Da DataOps so viele Elemente des Datenlebenszyklus umfasst, erstreckt es sich über eine Reihe von IT-Disziplinen, einschließlich Datenentwicklung, Datentransformation, Datenextraktion, Datenqualität, Data Governance, Datenzugriffskontrolle, Kapazitätsplanung für das Datenzentrum und den Systembetrieb. DataOps-Teams werden häufig vom Chief Data Scientist oder Chief Analytics Officer eines Unternehmens geleitet und von Dateningenieuren, Datenanalysten, Datenverwaltern und anderen Personen mit Datenverantwortung unterstützt.

Wie bei DevOps gibt es keine DataOps-spezifischen Software-Tools, sondern nur Frameworks und verwandte Tool-Sets, die einen DataOps-Ansatz für die Zusammenarbeit und erhöhte Agilität unterstützen. Zu diesen Tools gehören ETL/ELT-Tools, Tools zur Datenkuratierung und -katalogisierung, Protokollanalysatoren und Systemmonitore. Software, die Microservices-Architekturen unterstützt, sowie Open-Source-Software, mit der Anwendungen strukturierte und unstrukturierte Daten mischen können, werden ebenfalls mit der DataOps-Bewegung in Verbindung gebracht. Diese Software kann MapReduce, HDFS, Kafka, Hive und Spark umfassen.

Wie DataOps funktioniert

Das Ziel von DataOps ist die Kombination von DevOps- und Agile-Methoden, um Daten im Einklang mit den Geschäftszielen zu verwalten. Wenn das Ziel beispielsweise darin besteht, die Lead-Conversion-Rate zu erhöhen, würde DataOps die Daten so positionieren, dass sie bessere Empfehlungen für Marketingprodukte geben und somit mehr Leads konvertieren. Agile-Prozesse werden für die Datenverwaltung und die Entwicklung von Analysen verwendet, während DevOps-Prozesse zur Optimierung von Code, Produkterstellung und Bereitstellung eingesetzt werden.

Die Erstellung von neuem Code ist nur ein Teil von DataOps. Die Rationalisierung und Verbesserung von Data Warehouse ist ebenso wichtig. Ähnlich wie bei der schlanken Produktion (Lean Manufacturing) wird bei DataOps die statistische Prozesskontrolle (SPC) eingesetzt, um die Datenanalyse-Pipeline konsistent zu überwachen und zu verifizieren. SPC stellt sicher, dass die Statistiken innerhalb der zulässigen Bereiche bleiben, steigert die Effizienz der Datenverarbeitung und erhöht die Datenqualität. Wenn eine Anomalie oder ein Fehler auftritt, hilft SPC, die Datenanalysten sofort zu alarmieren, damit sie reagieren können.

Wie man DataOps implementiert

Es wird davon ausgegangen, dass das Datenvolumen weiterhin exponentiell ansteigen wird, so dass die Implementierung einer DataOps-Strategie von entscheidender Bedeutung ist. Der erste Schritt zu DataOps besteht darin, die Rohdaten zu bereinigen und eine Infrastruktur zu entwickeln, die die Daten zur Nutzung bereitstellt, in der Regel in einem Self-Service-Modell. Sobald die Daten zugänglich sind, sollten Software, Plattformen und Tools entwickelt oder eingesetzt werden, die Daten orchestrieren und in bestehende Systeme integrieren. Diese Komponenten werden dann kontinuierlich neue Daten verarbeiten, die Leistung überwachen und Erkenntnisse in Echtzeit liefern.

Zu den bewährten Praktiken bei der Umsetzung einer DataOps-Strategie gehören die folgenden:

- Festlegen von Fortschritts-Benchmarks und Leistungsmessungen in jeder Phase des Datenlebenszyklus.

- Definieren Sie frühzeitig semantische Regeln für Daten und Metadaten.

- Feedback-Schleifen zur Validierung der Daten einbauen.

- Nutzen Sie Data-Science-Tools und Business-Intelligence-Datenplattformen, um den Prozess so weit wie möglich zu automatisieren.

- Optimieren Sie Prozesse für den Umgang mit Engpässen und Datensilos, was in der Regel eine Art von Softwareautomatisierung umfasst.

- Entwerfen Sie die Lösung entsprechend des erwarteten Wachstums, der geplanten Entwicklungen und der benötigten Skalierbarkeit.

- Verwenden Sie Einwegumgebungen, die die reale Produktionsumgebung für Experimente imitieren.

- Stellen Sie ein DataOps-Team mit einer Vielzahl von technischen Fähigkeiten und Hintergründen zusammen.

- Behandeln Sie DataOps wie eine schlanke Produktion, indem Sie sich auf kontinuierliche Verbesserungen der Effizienz konzentrieren.

Vorteile von DataOps

Der Übergang zu einer DataOps-Strategie kann einem Unternehmen die folgenden Vorteile bringen:

- Bereitstellung zuverlässigerer Echtzeit-Dateneinblicke.

- Reduziert die Zykluszeit von Data-Science-Anwendungen.

- Ermöglicht eine bessere Kommunikation und Zusammenarbeit zwischen Teams und Teammitgliedern.

- Erhöht die Transparenz durch die Verwendung von Datenanalysen zur Vorhersage aller möglichen Szenarien.

- Ermöglicht die Reproduzierbarkeit von Prozessen und die Wiederverwendung von Code, wann immer dies möglich ist.

- Gewährleistet eine bessere Datenqualität.

- Schafft einen einheitliche, interoperable Daten-Hub.

Was ein DataOps-Framework beinhaltet

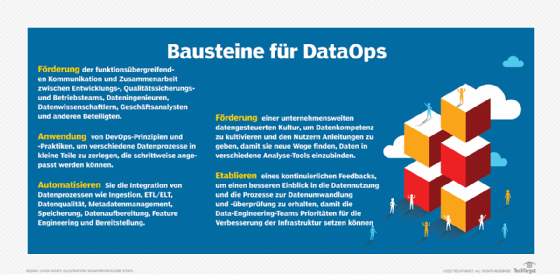

Ein DataOps-Framework muss mehrere Schlüsselelemente und Praktiken harmonisieren und verbessern.

Funktionsübergreifende Kommunikation. DataOps beginnt mit demselben Kernparadigma für agile Entwicklungspraktiken, die eine verbesserte Zusammenarbeit zwischen Geschäfts-, Entwicklungs-, Qualitätssicherungs- und Betriebsteams unterstützen, und erweitert diese Zusammenarbeit auf Dateningenieure, Datenwissenschaftler und Geschäftsanalysten.

Agile Denkweise. Es ist wichtig, Wege zu finden, um verschiedene Datenprozesse in kleine Teile zu zerlegen, die inkrementell angepasst werden können - analog zu kontinuierlicher Entwicklung und kontinuierlichen Integrations-Pipelines.

Integrierte Daten-Pipeline. Unternehmen müssen die üblichen Übergaben zwischen Datenprozessen wie Ingestion, ETL/ELT, Datenqualität, Metadatenmanagement, Speicherung, Datenaufbereitung, Feature Engineering und Bereitstellung automatisieren.

Datengesteuerte Kultur. Unternehmen sollten ein langfristiges und fortlaufendes Programm zur Förderung der Datenkompetenz im gesamten Unternehmen einführen und die Datennutzer anleiten, die neue Wege finden, Daten in verschiedene Analyse-Tools einzubinden.

Kontinuierliches Feedback. Verschiedene Teams müssen auch einen Prozess entwickeln, um Erkenntnisse für die Umwandlung und Prüfung von Daten zu sammeln, damit die Data-Engineering-Teams Prioritäten für Infrastrukturverbesserungen setzen können.

DataOps-Tools und -Anbieter

DataOps-Tools decken viele Funktionen ab, die für das Aufnehmen, Umwandeln, Bereinigen, Orchestrieren und Laden von Daten erforderlich sind. In einigen Fällen wurden diese Tools entwickelt, um die anderen Tools des Anbieters zu ergänzen. In anderen Fällen konzentrieren sich die Anbieter auf spezifische DataOps-Workflows. Zu den beliebten DataOps-Tools gehören die folgenden:

- Ascend.io hilft bei der Aufnahme, Umwandlung und Orchestrierung von Datenentwicklungs- und Analyse-Workloads.

- AtIan bietet Kollaborations- und Orchestrierungsfunktionen zur Automatisierung von DataOps-Workloads.

- Die Plattform von Composable Analytics umfasst Tools für die Erstellung kompatibler Daten-Pipelines.

- Die Plattform von DataKitchen bietet DataOps-Beobachtbarkeit und Automatisierungssoftware.

- Die Plattform von Delphix maskiert und sichert Daten durch Datenvirtualisierung.

- Die Plattform von Devo automatisiert Data Onboarding und Governance.

- Informatica hat seine Datenkatalog-Tools erweitert, um DataOps-Funktionen zu unterstützen.

- Die Software von Infoworks hilft bei der Migration von Daten, Metadaten und Workloads in die Cloud.

- Kinaesis-Tools analysieren, optimieren und steuern die Dateninfrastruktur.

- Landoop/Lenses hilft beim Aufbau von Daten-Pipelines auf Kubernetes.

- Nexla-Software bietet Datenautomatisierung zur Erstellung und Verwaltung von Datenprodukten.

- Die Plattform von Okera hilft bei der Bereitstellung, Sicherung und Verwaltung sensibler Daten in großem Umfang.

- Die Integrationsplattform von Qlik-Attunity ergänzt die Visualisierungs- und Analyse-Tools von Qlik.

- Die Plattform von Qubole zentralisiert DataOps auf einem sicheren Data Lake für maschinelles Lernen, KI und Analysen.

- Software AG StreamSets hilft bei der Erstellung und Verwaltung von Daten-Pipelines in Cloud-basierten Umgebungen.

- Tamr hat seine Datenkatalog-Tools erweitert, um Daten-Workflows zu rationalisieren.

DataOps-Trends

Mehrere Trends bestimmen die Zukunft von DataOps, darunter Integration, Erweiterung und Beobachtbarkeit.

Verstärkte Integration mit anderen Datendisziplinen. DataOps wird zunehmend mit verwandten Datenverwaltungspraktiken interagieren und diese unterstützen müssen. Gartner hat MLOps, ModelOps und PlatformOps als komplementäre Ansätze zur Verwaltung bestimmter Arten der Datennutzung identifiziert. MLOps ist auf die Entwicklung und Versionierung von maschinellem Lernen ausgerichtet, während ModelOps sich auf Modell-Engineering, Training, Experimentieren und Überwachung konzentriert. Gartner charakterisiert PlatformOps als eine umfassende KI-Orchestrationsplattform, die DataOps, MLOps, ModelOps und DevOps umfasst.

Erweitertes DataOps. KI beginnt, die Dateninfrastruktur selbst zu verwalten und zu orchestrieren. Datenkataloge entwickeln sich zu erweiterten Datenkatalogen und Analysen zu erweiterten, mit KI durchdrungenen Analysen. Ähnliche Techniken werden nach und nach auch auf alle anderen Aspekte der DataOps-Pipeline angewendet.

Beobachtbarkeit von Daten (Data Observability). Die DevOps-Community nutzt seit Jahren in großem Umfang Tools für das Application Performance Management, die durch eine Observability-Infrastruktur unterstützt werden, um Probleme mit Anwendungen zu erkennen und zu priorisieren. Anbieter wie Acceldata, Monte Carlo, Precisely, Soda und Unravel entwickeln vergleichbare Tools zur Datenbeobachtung, die sich auf die Dateninfrastruktur selbst konzentrieren. DataOps-Tools werden zunehmend Datenbeobachtungs-Feeds nutzen, um DataOps-Pipelines durch Entwicklung, Integration, Partnerschaften und Übernahmen zu optimieren.