Data Center (Rechenzentrum)

Was ist ein Data Center (Rechenzentrum)?

Ein Rechenzentrum ist eine Einrichtung, die aus vernetzten Computern, Storage und Recheninfrastruktur besteht und von Unternehmen zum Sammeln, Verarbeiten, Speichern und Verbreiten großer Datenmengen genutzt wird. Ein Unternehmen ist in der Regel stark auf die in einem Rechenzentrum enthaltenen Anwendungen, Dienste und Daten angewiesen, sodass es für den täglichen Betrieb von entscheidender Bedeutung ist. Zu den Hauptkomponenten eines Rechenzentrums gehören in der Regel Router, Firewalls, Switches, Storage und Application Delivery Controller.

In der Vergangenheit waren Rechenzentren stark kontrollierte physische Umgebungen. Die Infrastrukturen haben sich jedoch von physischen Servern zu virtualisierten Umgebungen entwickelt, was die Bereitstellung von Anwendungen und Workloads in verschiedenen Multi-Cloud-Umgebungen erleichtert.

Rechenzentren können eine Vielzahl von Workloads unterstützen, von traditionellen Unternehmensanwendungen bis hin zu Cloud-nativen Diensten. Diese Unternehmensrechenzentren verfügen zunehmend über Einrichtungen zur Sicherung und zum Schutz von Cloud Computing und internen Ressourcen vor Ort. Sie sind darauf ausgelegt, den wachsenden Anforderungen von Unternehmen an Rechenressourcen gerecht zu werden und gleichzeitig die Energieeffizienz zu optimieren und die Betriebskosten zu senken.

Da Unternehmen zunehmend auf Cloud Computing und Multi-Cloud-Umgebungen setzen, passen sich auch herkömmliche Rechenzentren an diese Anforderungen an, damit sie diese Service lokal anbieten können. Dadurch verschwimmen die Grenzen zwischen Unternehmensrechenzentren und denen der Cloud-Anbieter.

Wie funktionieren Rechenzentren?

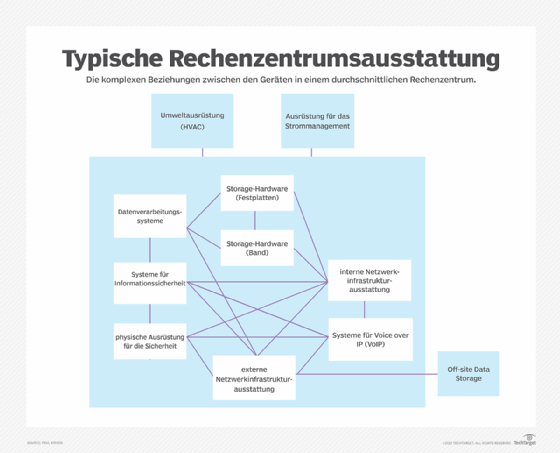

Eine Rechenzentrumsanlage, die es einem Unternehmen ermöglicht, seine Ressourcen und Infrastruktur für die Datenverarbeitung, -Storage und -kommunikation zu bündeln, umfasst Folgendes:

- Systeme zum Speichern, Teilen, Abrufen und Verarbeiten von Daten im gesamten Unternehmen

- physische Infrastruktur zur Unterstützung der Datenverarbeitung und Datenkommunikation

- Versorgungseinrichtungen wie Kühlung, Strom, Netzwerksicherheitszugang und unterbrechungsfreie Stromversorgungen (USVs)

- physische Sicherheitsmechanismen wie Überwachung des gesamten Gebäudes, Sicherheitspersonal, Metalldetektoren und biometrische Systeme

Durch die Zusammenführung all dieser Ressourcen in einem Rechenzentrum kann das Unternehmen Folgendes erreichen:

- Schutz proprietärer Systeme und Daten

- Zentralisierung von IT- und Datenverarbeitungsmitarbeitern, Auftragnehmern und Lieferanten

- Anwendung von Informationssicherheitskontrollen auf proprietäre Systeme und Daten

- Realisierung von Skaleneffekten durch die Konsolidierung sensibler Systeme an einem Ort

Warum sind Rechenzentren wichtig?

Rechenzentren bilden die Grundlage nahezu aller Rechen-, Speicher-, Netzwerk- und Geschäftsanwendungen in Unternehmen. Da das Geschäft moderner Unternehmen zunehmend von IT-Systemen abhängt, kommt dem Rechenzentrum eine zentrale Rolle für den Geschäftsbetrieb zu.

Rechenzentren sind aus den folgenden Gründen von entscheidender Bedeutung:

- Informations- und Storage-Verarbeitung: Rechenzentren sind im Wesentlichen riesige Computer, die große Mengen an Informationen speichern und verarbeiten, was sie für Technologieunternehmen und Firmen, die auf digitale Daten angewiesen sind, unverzichtbar macht.

- Unterstützung für den IT-Betrieb: Rechenzentren unterstützen den IT-Betrieb und kritische Anwendungen und stellen die Infrastruktur für Rechen-, Storage- und Netzwerkanforderungen bereit. Sie können sich im Besitz von Organisationen befinden und von diesen betrieben werden, von Drittanbietern oder Public-Cloud-Provider verwaltet werden oder gemietete Räume innerhalb von Colocation-Einrichtungen sein.

- Unterstützung für Cloud-Technologie: Mit der zunehmenden Abhängigkeit von Cloud-Technologie sind Cloud-Rechenzentren immer beliebter geworden. Technologieunternehmen, die sich auf Cloud Computing spezialisiert haben, betreiben in der Regel Cloud-Rechenzentren, was die Bedeutung von RZs für Betriebs- und Geschäftsproesse unterstreicht

- Nähe und Konnektivität: Rechenzentren befinden sich idealerweise in Gebieten, die nur minimal anfällig für Naturkatastrophen sind, und in der Nähe von stabilen und zuverlässigen Stromquellen. Je näher ein Rechenzentrum an einem Unternehmen liegt, desto geringer sind in der Regel die Latenzzeiten bei der Datenübertragung.

- Datenmanagement und Sicherheit: Rechenzentren beherbergen zentrale Unternehmens- und Benutzerdaten sowie geschäftskritische Anwendungen. Da ihre Sicherheit und Zuverlässigkeit für Unternehmen von entscheidender Bedeutung sind, verfügen sie über hohe Sicherheitsstandards und modernste Technologien. Zudem ermöglichen sie Skalierbarkeitund Effizienz, um wachsenden Anforderungen gerecht zu werden.

- Geschäftliche Agilität und Resilienz: Mit der zunehmenden Digitalisierung sind Daten zu einem der wichtigsten Vermögenswerte in der digitalen Wirtschaft geworden. Ihre sichere Verwaltung und die Einhaltung von Compliance-Anforderungen sind daher unerlässlich. Rechenzentren können mit der richtigen Konfiguration und Ausstattung diese Aufgaben übernehmen und so wesentlich zur Anpassungsfähigkeit und Resilienz von Unternehmen beitragen.

Was sind die Kernkomponenten von Rechenzentren?

Die Elemente eines Rechenzentrums lassen sich im Allgemeinen in die folgenden Hauptkategorien unterteilen:

- Einrichtung: Dazu gehört der physische Standort mit Sicherheitszugangskontrollen und einer ausreichenden Fläche, um die Infrastruktur und Ausrüstung des Rechenzentrums unterzubringen.

- Netzwerkausrüstung: Diese Ausrüstung unterstützt die Speicherung und Verarbeitung von Anwendungen und Daten, indem sie Aufgaben wie Switching, Routing, Load Balancing und Analysen übernimmt.

- Unternehmens-Storage: Ein effizientes Rechenzentrum beherbergt die Datensysteme eines Unternehmens in einer gut geschützten physischen und Storage-Infrastruktur zusammen mit Servern, Speichersubsystemen, Netzwerk-Switches, Routern, Firewalls, Verkabelung und physischen Racks.

- Support-Infrastruktur: Diese Geräte bieten die höchstmögliche Nachhaltigkeit in Bezug auf die Betriebszeit. Zu den Komponenten der Support-Infrastruktur gehören:

- Stromverteilungs- und Zusatzstrom-Subsysteme

- elektrische Schaltanlagen

- USVs

- Notstromaggregate

- Belüftungs- und Kühlsysteme für Rechenzentren, wie In-Row-Kühlkonfigurationen und Computerraumklimageräte

- angemessene Bereitstellung für die Konnektivität von Netzbetreibern

- Betriebspersonal: Diese Mitarbeiter sind für die Wartung und Überwachung der IT- und Infrastrukturausrüstung rund um die Uhr zuständig.

Welche Arten von Rechenzentren gibt es?

Je nach Eigentumsverhältnissen und genauen Anforderungen eines Unternehmens können Größe, Form, Standort und Kapazität eines Rechenzentrums variieren.

Zu den gängigen Arten von Rechenzentren gehören die folgenden:

- Unternehmensrechenzentren: Diese Rechenzentren werden von Organisationen für ihre internen Endnutzer gebaut und betrieben. Sie unterstützen den IT-Betrieb und kritische Anwendungen einer einzelnen Organisation und können sich sowohl auf dem Firmengelände als auch außerhalb befinden.

- Managed-Services-Rechenzentren: Diese Data Center werden von Dritten betrieben und bieten alle Aspekte an Storage- und Computing-Diensten. Unternehmen mieten die Infrastruktur und Dienste, anstatt sie zu kaufen.

- Cloud-basierte Rechenzentren: Diese externen verteilten Rechenzentren werden von Drittanbietern oder Public-Cloud-Anbietern wie Amazon Web Services, Google oder Microsoft verwaltet. Basierend auf einem Infrastructure-as-a-Service-Modell ermöglicht die gemietete Infrastruktur den Kunden, innerhalb weniger Minuten ein virtuelles Rechenzentrum bereitzustellen.

- Colocation-Rechenzentren: Unternehmen mieten hier Stellflächen innerhalb von Einrichtungen, die im Eigentum von Drittanbietern stehen. Das Unternehmen bringt seine eigene Hardware ein, während der Colocation-Betreiber die Infrastruktur – einschließlich Stromversorgung, Kühlung, Netzwerkanbindung und physischer Sicherheit – bereitstellt und verwaltet. Colocation ist insbesondere für Unternehmen attraktiv, die von professioneller Rechenzentrumsinfrastruktur profitieren möchten, ohne die hohen Investitions- und Betriebskosten eines eigenen Rechenzentrums tragen zu müssen.

- Edge-Rechenzentren: Dies sind kleinere Einrichtungen, die das Latenzproblem lösen, indem sie geografisch näher am Rand des Netzwerks und der Datenquellen liegen. Edge-Rechenzentren verbessern auch die Anwendungsleistung und das Kundenerlebnis, insbesondere bei datenintensiven Echtzeitaufgaben wie Big-Data-Analysen, künstlicher Intelligenz und Content-Bereitstellung.

- Hyperscale-Rechenzentren: Diese hochskalierbaren Infrastrukturen werden typischerweise von Anbietern wie Amazon, Microsoft oder Google betrieben. Sie sind auf maximale Effizienz ausgelegt, zeichnen sich durch hohe Hardwaredichte, standardisierte Architektur sowie optimierte Kühl- und Verwaltungsprozesse aus und ermöglichen so eine kosteneffiziente Skalierung.

- Mikro-Rechenzentren: Mikro-Rechenzentren sind kompakt gestaltete Data Center, die mit Edge-Computing in Verbindung stehen. Obwohl sie kleiner sind, bieten Mikro-Rechenzentren vergleichbare Funktionen. Sie vereinfachen die Einrichtung von Edge Computing durch schnelle Bereitstellung und benötigen weniger Platz und Strom. Ein standardmäßiger Mikro-Rechenzentrumscontainer oder -schrank beherbergt in der Regel weniger als zehn Server und und eine begrenzte Anzahl an virtuelle Maschinen.

Was sind die Standards eines Rechenzentrums?

Kleine Unternehmen können erfolgreich mit mehreren Servern und Storage-Arrays arbeiten, die in einem Schrank oder einem kleinen Raum vernetzt sind, während große Rechenzentren einen riesigen Lagerraum mit Rechenzentrumsausrüstung und -infrastruktur füllen können. In anderen Fällen können Rechenzentren in mobilen Installationen wie Versandcontainern, auch bekannt als Data Centers in a box, zusammengebaut werden, die je nach Bedarf bewegt und eingesetzt werden können.

Rechenzentren können jedoch durch verschiedene Stufen der Zuverlässigkeit oder Ausfallsicherheit definiert werden, die manchmal als Rechenzentrumsstufen (Data Center Tiers) bezeichnet werden. Im Jahr 2005 veröffentlichten das American National Standards Institute und die Telecommunications Industry Association die Norm ANSI/TIA-942, Telecommunications Infrastructure Standard for Data Centers (Telekommunikationsinfrastrukturstandard für Rechenzentren).

Seit Mai 2024 liegt mit ANSI/TIA-942-C eine neue Version des internationalen Standards für Rechenzentrumsinfrastruktur vor, die Vorgaben zu Telekommunikation, Stromversorgung, Mechanik, Sicherheit, Brand- und Gebäudeinfrastruktur umfassen. Unternehmen, die TIA-konform bauen oder zertifizieren lassen, können ihre Systeme nach objektiven Kriterien bewerten lassen.

Das Uptime Institute führte die Tier-Klassifizierung (Tier I-IV) ein, die jedoch ergänzend auch von ANSI/TIA-942 genutzt wird. Die Stufen lassen sich anhand der verfügbaren Ressourcen, der Kapazitäten des Rechenzentrums oder der Verfügbarkeitsgarantien unterscheiden. Das Uptime Institute definiert die Stufen von Rechenzentren wie folgt:

- Tier I: Dies sind die grundlegendsten Arten von Rechenzentren, die über eine USV verfügen. Tier-I-Rechenzentren bieten keine redundanten Systeme, sollten jedoch eine Verfügbarkeit von mindestens 99,671 Prozent garantieren.

- Tier II: Diese Data Center verfügen über redundante Systeme, Stromversorgung und Kühlung und garantieren eine Verfügbarkeit von mindestens 99,741 Prozent. Bei einem Tier-II-Rechenzentrum ist mit einer jährlichen Ausfallzeit von 22 Stunden zu rechnen.

- Tier III: Diese Rechenzentren bieten teilweise Fehlertoleranz, 72 Stunden Ausfallschutz, vollständige Redundanz und eine Verfügbarkeitsgarantie von 99,982 Prozent. Das entspricht etwa einem jährlichen Ausfall von einer Stunde und 35 Minuten.

- Tier IV: Diese Rechenzentren garantieren eine Verfügbarkeit von 99,995 Prozent – oder nicht mehr als 26,3 Minuten Ausfallzeit pro Jahr – sowie vollständige Fehlertoleranz, Systemredundanz und 96 Stunden Ausfallschutz.

Über die grundlegenden Aspekte wie Kosten und Größe der Einrichtung hinaus werden Standorte anhand einer Vielzahl von Kriterien ausgewählt, darunter geografische Lage, seismische und meteorologische Stabilität, Anbindung an Straßen und Flughäfen, Verfügbarkeit von Energie und Telekommunikation und sogar das vorherrschende politische Umfeld.

Sobald ein Standort gesichert ist, kann die Architektur des Rechenzentrums unter Berücksichtigung der mechanischen und elektrischen Infrastruktur sowie der Zusammensetzung und Anordnung der IT-Ausrüstung entworfen werden. All diese Aspekte richten sich nach den Verfügbarkeits- und Effizienzzielen der gewünschten Rechenzentrumsstufe.

Wie werden Rechenzentren verwaltet?

Die Verwaltung von Rechenzentren umfasst Folgendes:

- Facility Management: Die Verwaltung der physischen Rechenzentrumsanlage kann Aufgaben im Zusammenhang mit den Immobilien der Anlage, den Versorgungsleistungen, der Zugangskontrolle und dem Personal umfassen.

- Bestands- oder Asset-Management: Zu den Rechenzentrumsanlagen gehören Hardware-Assets sowie die Verwaltung von Softwarelizenzen und Releases.

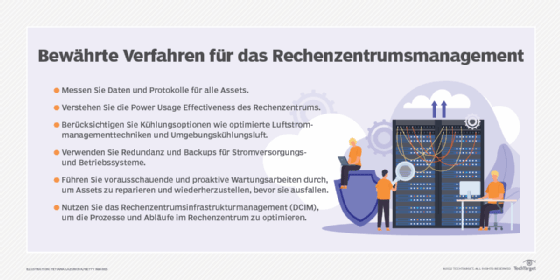

- Data Center Infrastructure Management: DCIM liegt an der Schnittstelle zwischen IT- und Facility-Management und wird in der Regel durch die Überwachung der Leistung des Rechenzentrums durchgeführt, um die Nutzung von Energie, Geräten und Fläche zu optimieren.

- Technischer Support: Das Data Center bietet technische Dienstleistungen für das Unternehmen und muss daher auch technischen Support für die Endnutzer im Unternehmen bereitstellen.

- Betrieb: Das Rechenzentrumsmanagement umfasst die täglichen Prozesse und Dienstleistungen, die vom Rechenzentrum bereitgestellt werden.

- Infrastrukturmanagement und -überwachung: Rechenzentren verwenden Überwachungs-Tools, mit denen IT-Administratoren aus der Ferne die Einrichtung und die Geräte überwachen, die Leistung messen, Fehler erkennen und Korrekturmaßnahmen ergreifen können, ohne jemals physisch den Raum des Rechenzentrums betreten zu müssen.

- Energieverbrauch und Effizienz: Ein einfaches Rechenzentrum benötigt möglicherweise weniger Energie, aber Unternehmensrechenzentren können mehr als 100 Megawatt benötigen. Heute nehmen grüne Rechenzentren, die durch die Verwendung emissionsarmer Baumaterialien, Katalysatoren und alternativer Energietechnologien auf minimale Umweltbelastung ausgelegt sind, einen wachsenden Stellenwert ein. So werden nicht nur laufende Betriebskosten durch PUE-Optimierung gesenkt, sondern auch gesetzliche Vorgaben erfüllt.

- Sicherheit und Schutz von Rechenzentren: Bei der Gestaltung von Data Center müssen auch solide Sicherheits- und Schutzmaßnahmen berücksichtigt werden, darunter die Anordnung von Türen und Zugangsfluren, um den Transport großer IT-Geräte und den Zugang für Mitarbeiter zu ermöglichen. Brandbekämpfung ist ein weiterer wichtiger Sicherheitsbereich, und der umfangreiche Einsatz von hochenergetischen elektrischen und elektronischen Geräten schließt den Einsatz herkömmlicher Sprinkleranlagen aus. Stattdessen setzt man auf gasbasierte Brandlöschanlagen (beispielsweise mit Inertgasen wie Stickstoff, Argon, Kohlendioxid oder mit chemischen Löschmitteln wie FM-200, Novec 1230).

Was ist die Konsolidierung von Rechenzentren?

Die Konsolidierung von Rechenzentren ist der Prozess der Verkleinerung oder Zusammenlegung vieler Server, Storage, Netzwerksysteme oder sogar Standorte zu einem effizienteren Systemkomplex. Häufig tritt Konsolidierung auch im Zuge von Fusionen und Übernahmen auf, wenn mehrere bestehende Rechenzentren in eine einheitliche Infrastruktur integriert werden. Ein weiterer Grund wäre etwa die Zusammenfassung bestehender, älterer RZs, um so Ressourcen zu bündeln und die Effizienz zu steigern.

Die Konsolidierung von Rechenzentren hat viele Vorteile, darunter die folgenden:

- geringere Latenz: Unternehmen nutzen möglicherweise zwei oder mehr Rechenzentrumsanlagen an mehreren Standorten, um eine höhere Ausfallsicherheit und eine bessere Anwendungsleistung zu erzielen. Dadurch wird die Latenz verringert, da die Workloads näher an den Benutzern angesiedelt sind.

- Kostenreduzierung: Ein Unternehmen mit mehreren Rechenzentren könnte sich für eine Konsolidierung der Rechenzentren entscheiden und so die Anzahl der Standorte reduzieren, um die Kosten für den IT-Betrieb zu minimieren. Durch die Reduzierung der Betriebskosten mehrerer Rechenzentren und der Energiekosten können Unternehmen erhebliche Kosteneinsparungen erzielen.

- verbesserte Effizienz: Die Konsolidierung von Rechenzentren kann den Betrieb rationalisieren, die Infrastruktur vereinfachen und es den IT-Mitarbeitern erleichtern, die Infrastruktur des Unternehmens zu kontrollieren, zu optimieren und zu verwalten.

- Optimierung der IT-Governance und Compliance: Die Konsolidierung von Rechenzentren erleichtert die Einhaltung gesetzlicher Vorschriften. Mit weniger zu betreibenden Rechenzentren können Unternehmen gesetzliche Anforderungen, Datenschutzstandards und bewährte Verfahren der Branche leichter einhalten und so Compliance-Risiken und potenzielle Strafen reduzieren.

- verbesserte Business Continuity und Disaster Recovery (BC/DR): Die Zentralisierung der Daten- und Backup-Infrastruktur verbessert die BC/DR-Fähigkeiten. Unternehmen können gründlichere Backup- und Replikationsstrategien anwenden, die Datenverfügbarkeit über geografisch verteilte Standorte hinweg sicherstellen und RTO und RPO reduzieren.

- Vorteile für die Umwelt: Durch die geringere Anzahl von Rechenzentren reduziert die Konsolidierung den Energieverbrauch und den CO2-Fußabdruck. Außerdem optimiert sie die Servereffizienz durch Virtualisierung, minimiert Elektronikschrott und verlängert die Lebensdauer der Hardware. Dies spielt eine entscheidende Rolle in den Nachhaltigkeitsstrategien von Unternehmen und steht im Einklang mit den globalen Bemühungen zur Bekämpfung des Klimawandels.

- erhöhte Sicherheit: Die Konsolidierung reduziert die Angriffsfläche und ermöglicht einen effektiveren Einsatz von Sicherheitsmaßnahmen, was die allgemeine Sicherheitslage eines Unternehmens stärkt.

Was sind die Unterschiede von Rechenzentren, Cloud und Serverfarmen?

Wie und wo Daten gespeichert werden, spielt eine entscheidende Rolle für den Gesamterfolg eines Unternehmens. Unternehmens-IT hat sich im Laufe der Zeit von lokalen Serverfarmen und klassischen Rechenzentren hin zu hybriden und Cloud-basierten Infrastrukturen verschoben.

Die wichtigsten Unterschiede zwischen Unternehmensrechenzentren, Cloud-Dienstleistern und Serverfarmen sind folgende:

- Unternehmensrechenzentren sind lokale, am eigenen Standort betriebene RZs und für geschäftskritische Unternehmen konzipiert. Ausgelegt sind sie auf Verfügbarkeit und Skalierbarkeit. Sie bieten alles, was für einen reibungslosen Geschäftsbetrieb erforderlich ist, einschließlich physischer Computerausrüstung und Storage-Ressourcen sowie DR und Backup.

- Cloud-Anbieter ermöglichen es Benutzern, Zugriff auf die Ressourcen des Cloud-Dienstleisters zu erwerben, ohne eine eigene Infrastruktur aufbauen oder kaufen zu müssen. Kunden können ihre virtualisierten oder nicht virtualisierten Ressourcen verwalten, ohne direkten physischen Zugriff auf die Einrichtungen des Cloud-Anbieters zu haben. Der Hauptunterschied zwischen einem Cloud-Rechenzentrum und einem typischen Unternehmensrechenzentrum ist die Größe. Da Cloud-Rechenzentren viele verschiedene Organisationen bedienen, können sie sehr groß sein.

- Serverfarmen sind einfache Rechenzentren. Viele miteinander verbundene Server befinden sich in derselben Einrichtung, um eine zentralisierte Steuerung und einen einfachen Zugriff zu ermöglichen. Trotz der zunehmenden Beliebtheit von Cloud Computing bevorzugen viele Unternehmen nach wie vor Serverfarmen, da diese Kosteneinsparungen, Sicherheit und Leistungsoptimierung bieten. Tatsächlich nutzen auch Cloud-Anbieter Serverfarmen in ihren Rechenzentren.

Die Grenzen zwischen diesen Plattformen verschwimmen durch das Wachstum der Hybrid Cloud noch weiter. Da Unternehmen zunehmend auf Public-Cloud-Anbieter angewiesen sind, müssen sie die Konnektivität zwischen ihren eigenen Rechenzentren und ihren Cloud-Anbietern integrieren.

Entwicklung von Rechenzentren

Rechenzentren haben im Laufe der Jahre eine bedeutende Entwicklung durchlaufen und sich an technologische Fortschritte und veränderte Geschäftsanforderungen angepasst:

- 1940er Jahre: Die Ursprünge der ersten Rechenzentren lassen sich bis zu den frühen Computersystemen wie dem Electronic Numerical Integrator and Computer (ENIAC) zurückverfolgen. Diese Maschinen, die vom Militär genutzt wurden, waren komplex in der Wartung und Bedienung. Sie erforderten spezielle Computerräume mit Gestellen, Kabelkanälen, Kühlmechanismen und Zugangsbeschränkungen, um alle Geräte unterzubringen und die erforderlichen Sicherheitsmaßnahmen zu gewährleisten.

- 1960er Jahre: Die Entwicklung des Mainframe-Computers durch IBM führte zur Einrichtung spezieller Mainframe-Räume in großen Unternehmen und Behörden, von denen einige eigene freistehende Gebäude benötigten, was die Geburtsstunde der ersten Rechenzentren markierte.

- 1990er Jahre: Der Begriff Rechenzentrum kam erstmals zum Einsatz, als der IT-Betrieb zu expandieren begann und kostengünstige Netzwerkgeräte verfügbar wurden. Es wurde möglich, alle erforderlichen Server eines Unternehmens in einem Raum innerhalb des Unternehmens unterzubringen. Diese speziellen Computerräume wurden innerhalb der Organisationen als Rechenzentren bezeichnet, und der Begriff setzte sich durch. Zur Zeit der Dotcom-Blase Ende der 1990er Jahre erforderten die Notwendigkeit einer hohen Internetgeschwindigkeit und eine ständige Internetpräsenz für Unternehmen größere Einrichtungen, um die große Menge an benötigten Netzwerkgeräten unterzubringen. Zu diesem Zeitpunkt wurden Rechenzentren populär und begannen, den oben beschriebenen zu ähneln.

- 2000-2025: Aktuelle Rechenzentren spiegeln einen Wandel hin zu mehr Effizienz, Flexibilität und Integration mit Cloud-Ressourcen wider, um den sich wandelnden Anforderungen moderner Computing- und Storage-Bedürfnisse gerecht zu werden. Künstliche Intelligenz führt zu einem massiven Ausbau von Rechenzentren, da KI-Modelle enorme Rechenleistung und Speicherressourcen erfordern. Dies steigert den Energie- und Kühlungsbedarf erheblich und beschleunigt den Trend zu Hyperscale- und Edge-Rechenzentren. Gleichzeitig treibt KI die Automatisierung im Betrieb voran, indem sie für optimiertes Energiemanagement, vorausschauende Wartung und effizientere Ressourcennutzung sorgt.

Rechenzentren auf einen Blick

Ein Rechenzentrum ist eine zentrale Einrichtung zur Speicherung, Verarbeitung und Bereitstellung großer Datenmengen. Es umfasst Server, Storage, Netzwerk, Kühlung, Sicherheit und Energieversorgung. Rechenzentren entwickeln sich von physischen hin zu virtualisierten und Multi-Cloud-Umgebungen, oft ergänzt durch Edge- und Hyperscale-Strukturen. Sie sind für IT-Betrieb, Cloud-Dienste und geschäftskritische Anwendungen unverzichtbar. Wichtige Faktoren sind Sicherheit, Energieeffizienz, Skalierbarkeit und hohe Verfügbarkeit.