Big Data Analytics

Big Data Analytics ist der Prozess der Untersuchung großer Datenmengen, um Informationen – wie versteckte Muster, Korrelationen, Markttrends und Kundenpräferenzen – aufzudecken, die Unternehmen dabei helfen können, fundierte Geschäftsentscheidungen zu treffen.

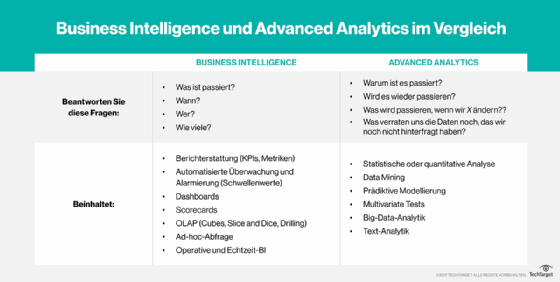

Auf breiter Ebene bieten Datenanalysetechnologien und -techniken Unternehmen eine Möglichkeit, Datensätze zu analysieren und neue Informationen zu sammeln. Business-Intelligence-Abfragen (BI) beantworten grundlegende Fragen zu Geschäftsabläufen und -leistung.

Big Data Analytics ist eine Form von Advanced Analytics, die komplexe Anwendungen mit Elementen wie Predictive Modeling, statistischen Algorithmen und Was-wäre-wenn-Analysen umfasst, die von Analysesystemen unterstützt werden.

Wie funktioniert Big Data Analytics?

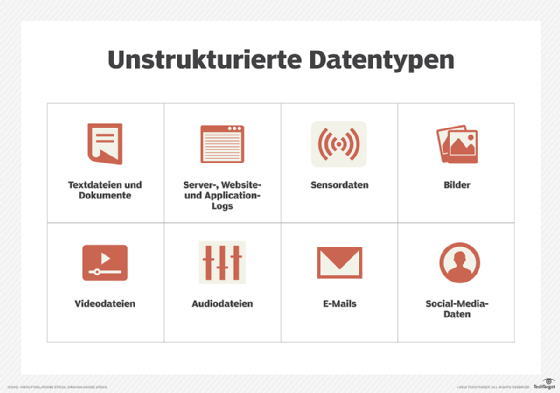

Datenanalysten, Datenwissenschaftler, prädiktive Modellierer, Statistiker und andere Analytiker sammeln, verarbeiten, bereinigen und analysieren wachsende Mengen an strukturierten Transaktionsdaten sowie andere Formen von Daten, die von herkömmlichen BI- und Analyseprogrammen nicht verwendet werden.

Hier ist ein Überblick über die vier Schritte des Datenaufbereitungsprozesses:

- Datenprofis sammeln Daten aus einer Vielzahl von unterschiedlichen Quellen. Oft handelt es sich um eine Mischung aus halbstrukturierten und unstrukturierten Daten. Während jedes Unternehmen unterschiedliche Datenströme verwendet, gehören zu den gängigen Quellen:

- Internet-Clickstream-Daten;

- Webserver-Protokolle;

- Cloud-Anwendungen;

- Mobile Apps;

- Social-Media-Inhalte;

- Text aus Kunden-E-Mails und Umfrageantworten;

- Aufzeichnungen von Mobiltelefonen; und

- Maschinendaten, die von Sensoren erfasst werden, die mit dem Internet der Dinge (Internet of Things, IoT) verbunden sind.

- Daten werden verarbeitet. Nachdem die Daten gesammelt und in einem Data Warehouse oder Data Lake gespeichert wurden, müssen Datenexperten die Daten für analytische Abfragen richtig organisieren, konfigurieren und partitionieren. Eine gründliche Datenverarbeitung sorgt für eine höhere Leistung bei analytischen Abfragen.

- Daten werden bereinigt. Datenexperten bereinigen die Daten mit Unterstützung von Skripting Tools oder Unternehmenssoftware. Sie suchen nach Fehlern oder Inkonsistenzen, wie zum Beispiel Duplikaten oder Formatierungsfehlern, und organisieren und bereinigen die Daten.

- Daten werden analysiert. Die gesammelten, verarbeiteten und bereinigten Daten werden mit Analysesoftware ausgewertet. Dazu gehören:

- Data Mining, das Datensätze auf der Suche nach Mustern und Beziehungen durchforstet;

- Predictive Analytics, das Modelle zur Vorhersage von Kundenverhalten und anderen zukünftigen Entwicklungen erstellt;

- Machine Learning, bei denen Algorithmen zur Analyse großer Datensätze eingesetzt werden;

- Deep Learning, ein fortgeschrittener Ableger des maschinellen Lernens;

- Software für Text Mining und statistische Analysen;

- Künstliche Intelligenz (KI);

- Mainstream-Software für Business Intelligence; und

- Werkzeuge zur Datenvisualisierung

Wichtige Big-Data-Analytics-Technologien

Zur Unterstützung von Big-Data-Analyseprozessen werden viele verschiedene Arten von Tools und Technologien verwendet. Zu den gängigen Technologien und Tools, die zur Unterstützung von Big-Data-Analyseprozessen verwendet werden, gehören:

- Hadoop, ein Open-Source-Framework für die Speicherung und Verarbeitung großer Datenmengen. Hadoop kann große Mengen an strukturierten und unstrukturierten Daten verarbeiten.

- Predictive-Analytics-Hardware und -Software, die große Mengen komplexer Daten verarbeiten und mit maschinellem Lernen und statistischen Algorithmen Vorhersagen über zukünftige Ereignisse treffen. Unternehmen nutzen Predictive Analytics Tools für Betrugserkennung, Marketing, Risikobewertung und den Betrieb.

- Stream Analytics Tools, die zum Filtern, Aggregieren und Analysieren von Big Data verwendet werden, die in vielen verschiedenen Formaten oder Plattformen gespeichert sein können.

- Distributed-Storage-Daten, die repliziert werden, in der Regel auf einer nicht-relationalen Datenbank. Dies kann als Maßnahme gegen Ausfälle unabhängiger Knoten, verlorene oder beschädigte Big Data oder zur Bereitstellung eines Zugriffs mit niedriger Latenz dienen.

- NoSQL-Datenbanken, bei denen es sich um nicht-relationale Datenmanagementsysteme handelt, die bei der Arbeit mit großen Mengen verteilter Daten nützlich sind. Sie benötigen kein festes Schema, was sie ideal für Rohdaten und unstrukturierte Daten macht.

- Data Lakes sind große Speicher-Repositorys, die Rohdaten im nativen Format enthalten, bis sie benötigt werden. Data Lakes verwenden eine flache Architektur.

- Data Warehouses sind Repositorys, die große Datenmengen aus verschiedenen Quellen sammeln und speichern. Data Warehouses speichern Daten typischerweise in vordefinierten Schemata.

- Knowledge Discovery/Big Data Mining Tools, mit denen Unternehmen große Mengen an strukturierten und unstrukturierten Big Data auswerten können.

- In-Memory Data Fabric, die große Datenmengen über die Systemspeicherressourcen verteilt. Dadurch wird eine geringe Latenzzeit für den Datenzugriff und die Datenverarbeitung erreicht.

- Datenvirtualisierung, die einen Datenzugriff ohne technische Einschränkungen ermöglicht.

- Datenintegrationssoftware, die es ermöglicht, Big Data über verschiedene Plattformen hinweg zu rationalisieren, einschließlich Apache Hadoop, MongoDB und Amazon EMR.

- Datenqualitätssoftware, die große Datensätze bereinigt und anreichert.

- Datenvorverarbeitungssoftware, die die Daten für die weitere Analyse vorbereitet. Daten werden formatiert und unstrukturierte Daten werden bereinigt.

- Spark, ein Open Source Cluster Computing Framework, das für die Batch- und Stream-Datenverarbeitung verwendet wird.

Big-Data-Analytics-Anwendungen umfassen häufig Daten aus internen Systemen und externen Quellen, wie zum Beispiel Wetterdaten oder demografische Daten über Verbraucher, die von externen Informationsdienstleistern zusammengestellt wurden. Darüber hinaus werden in Big-Data-Umgebungen immer häufiger Streaming-Analyseanwendungen eingesetzt, da die Benutzer Echtzeitanalysen für Daten durchführen möchten, die über Stream-Processing-Engines wie Spark, Flink und Storm in Hadoop-Systeme eingespeist werden.

Frühe Big-Data-Systeme wurden meist vor Ort eingesetzt, insbesondere in großen Organisationen, die große Datenmengen sammelten, organisierten und analysierten. Aber Anbieter von Cloud-Plattformen, wie Amazon Web Services (AWS) und Microsoft, haben es einfacher gemacht, Hadoop-Cluster in der Cloud einzurichten und zu verwalten. Das gilt auch für Hadoop-Anbieter wie Cloudera-Hortonworks, die die Verteilung des Big-Data-Frameworks auf AWS und Microsoft Azure unterstützen. Anwender können nun Cluster in der Cloud aufsetzen, sie so lange betreiben, wie sie sie benötigen, und sie dann mit nutzungsbasierten Preisen, die keine laufenden Softwarelizenzen erfordern, offline nehmen.

Big Data Analytics wird auch in Supply Chain Analytics immer nützlicher. Supply Chain Analytics nutzt Big Data und quantitative Methoden, um Entscheidungsprozesse in der gesamten Lieferkette zu verbessern. Insbesondere erweitert Supply Chain Analytics die Datensätze für erweiterte Analysen, die über die traditionellen internen Daten hinausgehen, die in Systemen für Enterprise Resource Planning (ERP) und Supply Chain Management (SCM) zu finden sind. Außerdem implementiert Supply Chain Analytics hocheffektive statistische Methoden auf neue und bestehende Datenquellen.

Big-Data-Analytics-Anwendungen und Beispiele

Hier sind einige Beispiele, wie Big Data Analytics Unternehmen helfen:

- Kundenakquise und -bindung. Verbraucherdaten können die Marketingbemühungen von Unternehmen unterstützen, die auf Trends reagieren, um die Kundenzufriedenheit zu erhöhen. Zum Beispiel können Personalisierungs-Engines für Amazon, Netflix und Spotify verbesserte Kundenerlebnisse bieten und Kundenbindung schaffen.

- Gezielte Werbung. Personalisierungsdaten aus Quellen wie früheren Käufen, Interaktionsmustern und die Verlaufshistorie von Produktseiten können dabei helfen, überzeugende zielgerichtete Werbekampagnen für Benutzer auf individueller Ebene und in größerem Umfang zu erstellen.

- Produktentwicklung. Big-Data-Analysen können Erkenntnisse über die Lebensfähigkeit von Produkten, Entwicklungsentscheidungen und Fortschrittsmessungen liefern und Verbesserungen in eine Richtung lenken, die zu den Kunden eines Unternehmens passt.

- Preisoptimierung. Einzelhändler können sich für Preismodelle entscheiden, die Daten aus einer Vielzahl von Datenquellen nutzen und modellieren, um den Umsatz zu maximieren.

- Lieferketten- und Channel-Analysen. Predictive-Analytics-Modelle können bei präventivem Nachschub, B2B-Lieferantennetzwerken, Bestandsmanagement, Routenoptimierungen und der Benachrichtigung über mögliche Lieferverzögerungen helfen.

- Risikomanagement. Big-Data-Analysen können aus Datenmustern neue Risiken für effektive Risikomanagementstrategien identifizieren.

- Verbesserte Entscheidungsfindung. Einblicke, die Geschäftsanwender aus relevanten Daten gewinnen, können Unternehmen helfen, schnellere und bessere Entscheidungen zu treffen.

Vorteile von Big Data Analytics

Zu den Vorteilen der Verwendung von Big Data Analytics gehören:

- Schnelle Analyse großer Datenmengen aus unterschiedlichen Quellen, in vielen verschiedenen Formaten und Typen.

- Schnelles Treffen von besser informierten Entscheidungen für eine effektive Strategie, was der Lieferkette, dem Betrieb und anderen Bereichen der strategischen Entscheidungsfindung zugute kommen und diese verbessern kann.

- Kosteneinsparungen, die sich aus neuen Effizienzen und Optimierungen von Geschäftsprozessen ergeben.

- Ein besseres Verständnis der Kundenbedürfnisse, des Kundenverhaltens und der Kundenstimmung, was zu besseren Marketingeinsichten führen kann, sowie Informationen für die Produktentwicklung liefert.

- Verbesserte Risikomanagementstrategien, die sich auf große Datenmengen stützen.

Herausforderungen bei Big Data Analytics

Trotz der Vorteile, die der Einsatz von Big Data Analytics mit sich bringt, ist seine Nutzung auch mit Herausforderungen verbunden:

- Die Zugänglichkeit der Daten. Mit größeren Datenmengen wird die Speicherung und Verarbeitung komplizierter. Big Data sollte ordnungsgemäß gespeichert und gepflegt werden, damit sie auch von weniger erfahrenen Datenwissenschaftlern und Analysten genutzt werden können.

- Pflege der Datenqualität. Bei großen Datenmengen, die aus einer Vielzahl von Quellen und in unterschiedlichen Formaten eingehen, erfordert das Datenqualitätsmanagement für Big Data einen erheblichen Zeit-, Arbeits- und Ressourcenaufwand, um sie ordnungsgemäß zu pflegen.

- Datensicherheit. Die Komplexität von Big-Data-Systemen stellt besondere Herausforderungen an die Security. Der richtige Umgang mit Sicherheitsbedenken innerhalb eines solch komplizierten Big-Data-Ökosystems kann ein komplexes Unterfangen sein.

- Die Auswahl der richtigen Tools. Die Auswahl aus dem riesigen Angebot an Big-Data-Analyse-Tools und -Plattformen auf dem Markt kann verwirrend sein, sodass Unternehmen wissen müssen, wie sie das beste Tool auswählen, das zu den Anforderungen der Benutzer und der Infrastruktur passt.

Angesichts eines potenziellen Mangels an internen Analysefähigkeiten und der hohen Kosten für die Einstellung erfahrener Datenwissenschaftler und Ingenieure fällt es einigen Unternehmen schwer, die Lücken zu schließen.

Geschichte von Big Data Analytics

Der Begriff Big Data wurde zum ersten Mal Mitte der 1990er Jahre verwendet, um auf die zunehmenden Datenmengen hinzuweisen. Im Jahr 2001 erweiterte Doug Laney, damals Analyst beim Beratungsunternehmen Meta Group Inc. die Definition von Big Data. Diese Erweiterung beschrieb:

- Das zunehmende Volumen (Volume) der Daten, die von Organisationen gespeichert und genutzt werden;

- die Vielfalt der Daten (Variety), die von Unternehmen erzeugt werden, und

- die Geschwindigkeit (Velocity), mit der diese Daten erstellt und aktualisiert werden.

Diese drei Faktoren wurden als die 3 Vs von Big Data bekannt. Gartner hat dieses Konzept nach der Übernahme der Meta Group und der Einstellung von Laney im Jahr 2005 popularisiert.

Eine weitere wichtige Entwicklung in der Geschichte von Big Data war die Einführung des verteilten Verarbeitungs-Frameworks Hadoop. Hadoop wurde 2006 als Open-Source-Projekt von Apache ins Leben gerufen. Damit wurde der Grundstein für eine Cluster-Plattform gelegt, die auf Standard-Hardware aufbaut und auf der Big-Data-Anwendungen ausgeführt werden können. Das Hadoop-Framework wird häufig für die Verwaltung von Big Data verwendet.

Im Jahr 2011 begann Big Data Analytics zusammen mit Hadoop und verschiedenen verwandten Big-Data-Technologien einen festen Platz in Unternehmen und in der Öffentlichkeit einzunehmen.

Anfangs, als das Hadoop-Ökosystem Gestalt annahm und zu reifen begann, wurden Big-Data-Anwendungen vor allem von großen Internet- und E-Commerce-Unternehmen wie Yahoo, Google und Facebook sowie von Analyse- und Marketingdienstleistern genutzt.

In jüngster Zeit hat eine breitere Palette von Anwendern Big-Data-Analysen als Schlüsseltechnologie für die digitale Transformation angenommen. Zu den Anwendern gehören Einzelhändler, Finanzdienstleister, Versicherer, Gesundheitsorganisationen, Hersteller, Energieunternehmen und andere Unternehmen.