Erweiterte Realität (Augmented Reality, AR)

Was ist erweiterte Realität (Augmented Reality, AR)?

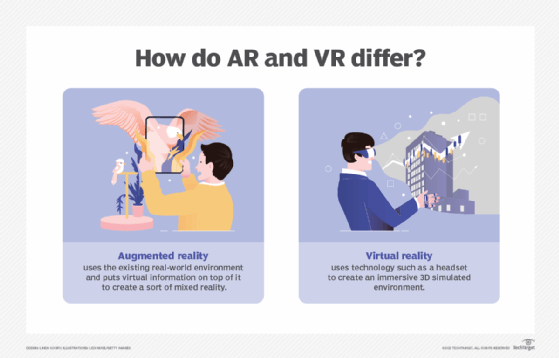

Erweiterte Realität (Augmented Reality, AR) ist die Integration digitaler Informationen in die Umgebung des Benutzers in Echtzeit. Im Gegensatz zur virtuellen Realität (Virtual Reality, VR), bei der eine künstliche Umgebung geschaffen wird, erleben AR-Benutzer eine reale Umgebung, die mit generierten Wahrnehmungsinformationen überlagert wird.

Erweiterte Realität hat eine Vielzahl von Einsatzmöglichkeiten, von der Unterstützung bei der Entscheidungsfindung bis hin zur Unterhaltung. AR wird eingesetzt, um entweder natürliche Umgebungen visuell zu verändern oder um den Nutzern zusätzliche Informationen zu liefern. Der Hauptvorteil erweiterter Realität besteht darin, dass es gelingt, digitale und dreidimensionale (3D) Komponenten mit der individuellen Wahrnehmung der realen Welt zu verbinden.

Erweiterte Realität liefert dem Nutzer visuelle Elemente, Ton und andere sensorische Informationen über ein Gerät wie ein Smartphone, eine Brille oder ein Headset. Diese Informationen werden auf dem Gerät eingeblendet, um ein verwobenes und immersives Erlebnis zu schaffen, bei dem digitale Informationen die Wahrnehmung der physischen Welt durch den Nutzer verändern. Die überlagerten Informationen können zu einer Umgebung hinzugefügt werden oder einen Teil der natürlichen Umgebung verdecken.

Thomas Caudell, Mitarbeiter von Boeing Computer Services, Research and Technology, prägte 1990 den Begriff Augmented Reality (erweiterte Realität), um die Funktionsweise von am Kopf getragenen Displays zu beschreiben, die Elektriker beim Zusammenbau komplizierter Kabelbäume verwenden. Eine der ersten kommerziellen Anwendungen der Augmented-Reality-Technologie war die gelbe First-Down-Markierung, die seit 1998 bei im Fernsehen übertragenen Football-Spielen zu sehen ist.

Heute sind Smartphone-Spiele, Mixed-Reality-Headsets und Heads-up-Displays (HUDs) in Autoscheiben die bekanntesten AR-Produkte für Verbraucher. Aber die AR-Technologie wird auch in vielen anderen Branchen eingesetzt, zum Beispiel im Gesundheitswesen, in der öffentlichen Sicherheit, in der Gas- und Ölindustrie, im Tourismus und im Marketing.

Wie funktioniert erweiterte Realität?

Erweiterte Realität kann in verschiedenen Formaten bereitgestellt werden, zum Beispiel in Smartphones, Brillen und Headsets. AR-Kontaktlinsen befinden sich ebenfalls in der Entwicklung. Die Technologie erfordert Hardwarekomponenten wie einen Prozessor, Sensoren, ein Display und Eingabegeräte. Mobilgeräte wie Smartphones und Tablets haben diese Hardware bereits an Bord, wodurch AR für den normalen Benutzer leichter zugänglich wird. Mobilgeräte enthalten in der Regel Sensoren wie Kameras, Beschleunigungsmesser, GPS-Instrumente (Global Positioning System) und Festkörperkompasse. Bei AR-Anwendungen auf Smartphones wird beispielsweise GPS verwendet, um den Standort des Benutzers zu bestimmen, und der Kompass dient zur Ermittlung der Geräteausrichtung.

Anspruchsvolle AR-Programme, wie sie beispielsweise vom Militär für die Ausbildung eingesetzt werden, können auch maschinelles Sehen, Objekterkennung und Gestenerkennung umfassen. AR kann sehr rechenintensiv sein, so dass die Datenverarbeitung auf ein anderes Gerät verlagert werden kann, wenn es einem Gerät an Rechenleistung fehlt.

Augmented-Reality-Anwendungen arbeiten entweder mit markerbasierten oder markerlosen Methoden. Markerbasierte AR-Anwendungen werden in speziellen 3D-Programmen geschrieben, die es den Entwicklern ermöglichen, Animationen oder kontextbezogene digitale Informationen im Computerprogramm mit einem Augmented-Reality-Marker in der realen Welt zu verbinden. Wenn die AR-Anwendung oder das Browser-Plugin eines Computergeräts digitale Informationen von einem bekannten Marker empfängt, beginnt es, den Code des Markers auszuführen und das richtige Bild oder die richtigen Bilder einzublenden.

Markerlose AR ist komplexer. Das AR-Gerät konzentriert sich nicht auf einen bestimmten Punkt, sondern muss die Objekte erkennen, wenn sie im Blickfeld erscheinen. Diese Art erweiterter Realität erfordert einen Erkennungsalgorithmus, der Objekte in der Nähe erkennt und bestimmt, um welche es sich handelt. Anschließend kann das Gerät mithilfe der eingebauten Sensoren Bilder in der Umgebung des Benutzers einblenden.

Unterschiede zwischen erweiterter Realität und virtueller Realität

Virtuelle Realität (VR) ist eine virtuelle Umgebung, die mit Hilfe von Software geschaffen und dem Benutzer so präsentiert wird, dass sein Gehirn die Überzeugung lange genug aussetzt, um eine virtuelle Welt als reale Umgebung zu akzeptieren. Die virtuelle Realität wird in erster Linie über ein Headset mit Anzeige und Ton erlebt.

Der größte Unterschied zwischen AR und VR besteht darin, dass Augmented Reality die bestehende reale Umgebung nutzt und virtuelle Informationen darüber legt, während VR die Nutzer vollständig in eine virtuell gerenderte Umgebung eintauchen lässt.

Auch die Geräte, mit denen dies erreicht wird, sind unterschiedlich. Bei VR werden VR-Headsets verwendet, die auf den Kopf des Nutzers aufgesetzt werden und ihm simulierte audiovisuelle Informationen präsentieren. AR-Geräte sind weniger restriktiv und umfassen normalerweise Geräte wie Telefone, Brillen, Projektionen und HUDs.

Bei VR befinden sich die Menschen in einer 3D-Umgebung, in der sie sich bewegen und mit der generierten Umgebung interagieren können. Bei AR hingegen bleiben die Benutzer in der realen Umgebung, indem sie virtuelle Daten als visuelle Ebene in die Umgebung einblenden. Während VR einen Benutzer in eine simulierte Umgebung versetzt, kann VR beispielsweise einen Webbrowser vor dem Benutzer in seinem Wohnzimmer einblenden. Für Spatial-Computing-Headsets wie Apple Vision Pro oder Meta Quest 3, bei denen das Gerät die natürliche Sicht des Benutzers blockiert, wird eine Technik namens Passthrough verwendet. Dabei spiegelt das Headset das, was die nach vorne gerichteten Kameras des Geräts sehen, auf dem Display des Headsets wider.

Obwohl der Begriff Mixed Reality (gemischte Realität) mit AR verwechselt werden kann, bezieht er sich auf eine virtuelle Anzeige über einer realen Umgebung, mit der die Benutzer interagieren können. So kann Apple Vision Pro beispielsweise eine virtuelle Tastatur projizieren, die der Träger zum Tippen verwenden kann. Der Hauptunterschied zwischen Mixed Reality und Augmented Reality besteht in der Fähigkeit des Benutzers, mit der digitalen Anzeige zu interagieren.

Wichtige Anwendungsfälle für erweiterte Realität

Erweiterte Realität kann unter anderem in den folgenden Bereichen eingesetzt werden:

- Einzelhandel. Verbraucher können die Online-App eines Geschäfts nutzen, um vor dem Kauf zu sehen, wie Produkte, zum Beispiel Möbel, in ihrem eigenen Zuhause aussehen würden.

- Unterhaltung und Spiele. Erweiterte Realität kann verwendet werden, um ein Videospiel in der realen Welt zu überlagern oder es Nutzern zu ermöglichen, ihre Gesichter auf unterschiedliche und kreative Weise in sozialen Medien zu animieren.

- Navigation. Ein Nutzer kann eine Route zu seinem Ziel über eine Live-Ansicht einer Straße einblenden. AR für die Navigation kann auch Informationen über lokale Geschäfte in der unmittelbaren Umgebung des Nutzers anzeigen.

- Tools und Messungen. Mobilgeräte können AR nutzen, um verschiedene 3D-Punkte in der Umgebung des Nutzers zu messen.

- Kunst und Architektur. AR kann Künstlern helfen, ein Projekt zu visualisieren oder daran zu arbeiten.

- Militär. Daten können auf der Windschutzscheibe eines Fahrzeugs angezeigt werden, um Richtungen, Entfernungen, Wetter- und Straßenbedingungen zu bestimmen.

- Archäologie. AR unterstützt die archäologische Forschung, indem es Archäologen hilft, Stätten zu rekonstruieren. 3D-Modelle helfen Museumsbesuchern und zukünftigen Archäologen, eine Ausgrabungsstätte so zu erleben, als wären sie selbst vor Ort.

Beispiele für erweiterte Realität

Beispiele für Technologien mit erweiterter Realität sind:

- Apple Maßband-App. Die App Maßband auf Apple iOS funktioniert wie ein Maßband, mit dem Nutzer zwei oder mehr Punkte in ihrer Umgebung auswählen und die Entfernung zwischen ihnen messen können.

- Snapchat. Snapchat kann einen Filter oder eine Maske über das Video oder Bild des Nutzers legen.

- Pokemon Go. Pokemon Go ist ein beliebtes mobiles AR-Spiel, das die GPS-Sensoren des Spielers nutzt, um zu erkennen, wo Pokemon-Kreaturen in der Umgebung des Nutzers auftauchen, die dieser fangen kann.

- Google Glass. Google Glass war der erste kommerzielle Versuch von Google, ein brillenbasiertes AR-System zu entwickeln. Dieser kleine tragbare Computer, der 2023 eingestellt wurde, ermöglichte es den Benutzern, freihändig zu arbeiten. Unternehmen wie DHL und DB Schenker setzten Google Glass und Software von Drittanbietern ein, um die Mitarbeiter in der globalen Lieferkettenlogistik und im individuellen Versand zu unterstützen.

- Tactical Augmented Reality (TAR) der US-Armee. Die US-Armee verwendet AR in einem Okular namens TAR. TAR wird am Helm des Soldaten befestigt und hilft bei der Lokalisierung der Position eines anderen Soldaten.

- Apple Vision Pro. Apple Vision Pro ist ein Spatial-Computing-Gerät, das AR-, VR- und Mixed-Reality-Funktionen bietet. Es bildet die Umgebung des Benutzers live ab und bietet Passthrough und die Möglichkeit, Projektionen wie Webbrowser-Fenster an bestimmten Stellen in der Umgebung des Benutzers zu platzieren. Die Benutzer können das Gerät mit Gesten steuern.

- Meta Quest 3. Meta Quest 3 ist ein Mixed-Reality-Headset, das viele ähnliche Funktionen wie Apple Vision Pro bietet, einschließlich Passthrough und Produktivitätsfunktionen. Benutzer steuern dieses Headset mit Gesten oder Controllern.

Die Zukunft der AR-Technologie

Die AR-Technologie wächst stetig, da die Popularität und der Bekanntheitsgrad von Apps und Spielen wie Pokemon Go oder AR-Apps in Einzelhandelsgeschäften zunimmt.

Apple entwickelt und aktualisiert sein Open-Source-Toolset für die Entwicklung mobiler Augmented-Reality-Anwendungen, ARKit, ständig weiter. Unternehmen wie Target und Ikea nutzen ARKit in ihren AR-Shopping-Apps für iPhone und iPad. ARKit 6 ermöglicht beispielsweise das Rendern von AR in 4K mit hohem Dynamikumfang und verbessert die Bild- und Videoaufnahme. Es bietet auch eine Depth-API, die Tiefeninformationen pro Pixel verwendet, um der Kamera eines Geräts zu unterstützen, die Größe und Form eines Objekts zu verstehen. Es umfasst eine Szenengeometrie, die eine topologische Karte eines Raums zusammen mit anderen Funktionen erstellt.

ARCore, die Plattform von Google für die Erstellung von AR-Erlebnissen auf Android und iOS, wird ständig weiterentwickelt und verbessert. So verwendet ARCore beispielsweise eine Geodaten-API, die Daten aus Google Earth 3D-Modellen und Street View-Bilddaten von Google Maps bezieht. Ähnlich wie die Depth-API von ARKit hat ARCore seine Depth-API verbessert und für eine Tiefenerfassung mit größerer Reichweite optimiert.

Verbesserte AR-, VR- und Mixed-Reality-Headsets werden ebenfalls veröffentlicht. Meta hat zum Beispiel sein Quest 2-Headset mit dem Meta Quest 3 verbessert, das im Oktober 2023 veröffentlicht wurde. Dieses neue Headset ist schlanker, leichter und ergonomischer als das Quest 2.

Im Februar 2024 brachte Apple das Apple Vision Pro heraus und sorgte damit für mehr Wettbewerb auf dem Markt für AR- und VR-Headsets. Vision Pro richtet sich an Early Adopters und Entwickler und ist wesentlich teurer als Quest 3. Meta Platforms zielt mit einem Preis von 499 US-Dollar auf ein breiteres Publikum ab, während Apple die Vision Pro für 3.499 US-Dollar verkauft. Es ist davon auszugehen, dass Apple in Zukunft eine Variante seines Headsets zu einem günstigeren Preis anbieten wird. Entwickler von Apple Vision Pro werden mit dem visionOS Software Development Kit arbeiten müssen. Sie können jedoch weiterhin bekannte Apple-Tools wie ARKit, SwiftUI oder RealityKit verwenden, um Apps zu entwickeln.

Weitere mögliche zukünftige Fortschritte für AR sind unter anderem:

- Leistungsfähigere und leichtere Geräte.

- Der Einsatz von künstlicher Intelligenz zum Scannen von Gesichtern und Räumen, zur Objekterkennung und -beschriftung sowie zur Texterkennung.

- Der Ausbau von 5G-Netzen, die die Unterstützung von Cloud-basierten AR-Erlebnissen erleichtern könnten, indem sie AR-Anwendungen mit höheren Datengeschwindigkeiten und geringeren Latenzzeiten versorgen.