Amazon SageMaker

Mit Amazons SageMaker lassen sich Machine-Learning-Modelle (ML) für Predictive Analytics und andere Analysen in der Public Cloud von Amazon Web Services (AWS) entwickeln, trainieren und bereitstellen.

Machine Learning bietet verschiedene Vorteile für Unternehmen, zum Beispiel Advanced Analytics für Kundendaten oder das Erkennen von Sicherheitsbedrohungen im Backend-Bereich. Für viele IT-Experten ist es jedoch schwierig, diese Modelle ohne entsprechende Fachkenntnisse zu entwickeln.

Amazon SageMaker zielt deshalb darauf ab, diese Herausforderung zu bewältigen. Es stellt integrierte und allgemein gebräuchliche Machine-Learning-Algorithmen bereit. Zusammen mit anderen Tools vereinfachen und beschleunigen sie diese Arbeiten.

Wie funktioniert Amazon SageMaker?

Amazon SageMaker unterstützt Jupyter-Notebooks, welche Open-Source-Webanwendungen sind, die Entwicklern helfen, Live-Code zu teilen. Für SageMaker-Anwender enthalten diese Notebooks Treiber, Pakete und Bibliotheken für gängige Deep-Learning-Plattformen und Frameworks.

Ein Entwickler kann ein vorkonfiguriertes Notebook starten, das AWS für eine Vielzahl von Anwendungen und Anwendungsfällen liefert, und es dann an den Datensatz und das Schema anpassen, das der Entwickler trainieren möchte.

Entwickler können außerdem benutzerdefinierte Algorithmen verwenden, die in einem der unterstützten Machine Learning Frameworks oder jedem Code geschrieben wurden, der als Docker-Container-Image verpackt wurde. SageMaker kann Daten aus dem Amazon Simple Storage Service (S3) beziehen, und es gibt keine praktische Begrenzung der Größe des Datensatzes.

SageMaker-Konsole

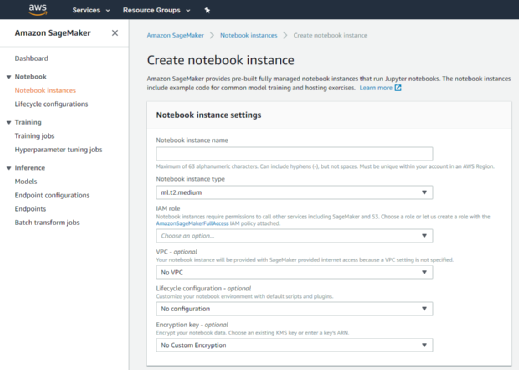

Zu Beginn meldet sich ein Entwickler bei der SageMaker-Konsole an und startet eine Notebook-Instanz. SageMaker bietet eine Vielzahl von integrierten Algorithmen, wie lineare Regression und Bildklassifizierung. Der Entwickler kann aber auch seinen eigenen Algorithmus importieren.

Sobald der Entwickler bereit ist, das Modell zu trainieren, gibt er oder sie den Ort der Daten innerhalb von S3 an und wählt den bevorzugten Instanztyp. Damit wird der Trainingsprozess eingeleitet. SageMaker verwendet dann die automatische Modelloptimierung, um den Parametersatz zu finden, der auch als Hyperparameter bezeichnet wird und der den Algorithmus am besten optimiert.

Wenn das Modell zum Deployment bereit ist, übernimmt der Service diesen Teil automatisch. Er skaliert die Cloud-Infrastruktur entsprechend den Anforderungen. Dabei werden eine Reihe unterschiedlicher Instanztypen von SageMaker verwendet, von denen mehrere mit GPU-Beschleunigern für Machine Learning Workloads optimiert sind.

Das Deployment wird von SageMaker über mehrere Verfügbarkeitszonen verteilt. Hinzu kommen Statusprüfungen, Sicherheits-Patches, eine automatische Skalierung und das Einrichten von sicheren HTTPS-Verbindung mit einer App. Ein Entwickler kann Alerts über Änderungen bei der Performance über Amazon CloudWatch Metrics verfolgen und auslösen.

SageMaker Security und Preis

Optional kann Amazon SageMaker die Modelle sowohl im Transfer als auch im Ruhezustand über den AWS Key Management Service verschlüsseln. API-Anfragen an den Service werden über eine sichere Socket-Layer-Verbindung ausgeführt. Darüber hinaus speichert SageMaker den Code in Volumes ab, die durch definierte Sicherheitsgruppen geschützt sind und ebenfalls eine Verschlüsselung bieten.

AWS berechnet für jeden SageMaker-Benutzer die Rechen-, Speicher- und Datenverarbeitungsressourcen, die zum Erstellen, Trainieren, Durchführen und Protokollieren von Machine-Learning-Modellen und den Vorhersagen verwendet werden. Hinzu kommen die S3-Gebühren für die zum Training und für die laufenden Vorhersagen benötigten Daten.