Ética da inteligência artificial

A ética na inteligência artificial (IA) é um sistema de princípios e técnicas morais destinados a orientar o desenvolvimento e o uso responsável da tecnologia de inteligência artificial. À medida que a IA se tornou parte integrante dos produtos e serviços, as organizações também estão a começar a desenvolver códigos de ética para a IA.

Um código de ética de IA, também chamado de plataforma de valor de IA, é uma declaração política que define formalmente o papel da inteligência artificial no que se refere ao desenvolvimento e ao bem-estar dos seres humanos. O objetivo de um código de ética de IA é fornecer orientação às partes interessadas quando confrontadas com uma decisão ética relativa ao uso de inteligência artificial.

Isaac Asimov, um escritor de ficção científica, previu os perigos potenciais dos agentes autónomos de IA em 1942, muito antes do desenvolvimento de sistemas de IA. Ele criou as Três Leis da Robótica como forma de limitar esses riscos. No código de ética de Asimov, a primeira lei proíbe os robôs de prejudicar ativamente os seres humanos ou de permitir que lhes sejam causados danos, recusando-se a agir. A segunda lei ordena que os robôs obedeçam aos humanos, a menos que as ordens não estejam de acordo com a primeira lei. A terceira lei ordena que os robôs se protejam na medida em que isso esteja de acordo com as duas primeiras leis.

Atualmente, os perigos potenciais dos sistemas de IA incluem substituição de empregos de IA, alucinações de IA, deepfakes e preconceitos de IA. Estas questões podem ser responsáveis pela demissão de pessoas, por informações enganosas, por falsas imitações de imagens ou vozes de outras pessoas ou por decisões tendenciosas que podem afetar negativamente vidas humanas.

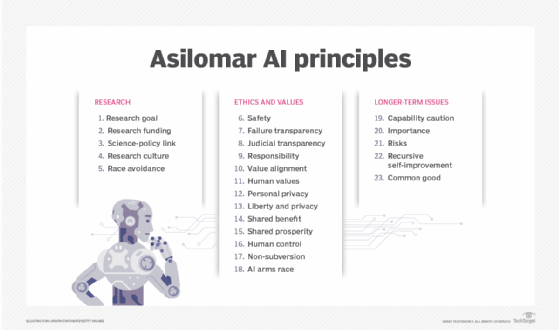

O rápido avanço da IA nos últimos 10 anos levou grupos de especialistas a desenvolverem salvaguardas para proteger os seres humanos dos riscos colocados pela IA. Um desses grupos é o Future of Life Institute, uma organização sem fins lucrativos fundada pelo cosmólogo do Massachusetts Institute of Technology Max Tegmark, pelo cofundador do Skype, Jaan Tallinn, e pela cientista pesquisadora do Google DeepMind, Victoria Krakovna. O instituto trabalhou com pesquisadores e desenvolvedores de IA, bem como acadêmicos de diversas disciplinas, para criar as 23 diretrizes agora conhecidas como Princípios de IA Asilomar.

Kelly Combs, diretora consultiva de serviços de risco de tecnologia emergente da KPMG EUA, disse que ao desenvolver um código de ética de IA, “é imperativo incluir diretrizes claras sobre como a tecnologia será implementada e monitorada continuamente”. Estas políticas devem exigir medidas que evitem distorções não intencionais nos algoritmos de aprendizagem automática (ML), detetem continuamente distorções nos dados e algoritmos e rastreiem a proveniência dos dados e a identidade daqueles que treinam os algoritmos.

Princípios de ética da IA

Não existe um conjunto de princípios éticos de IA definidos que possam ser seguidos na implementação de um sistema de IA. Alguns princípios, por exemplo, seguem o exemplo do Relatório Belmont, um documento de 1979 criado pela Comissão Nacional para a Proteção de Seres Humanos de Pesquisa Biomédica e Comportamental. Referia-se aos seguintes três princípios orientadores para o tratamento ético dos seres humanos:

- Respeito pelas pessoas. Reconhece a autonomia dos indivíduos e está relacionada com a ideia de consentimento informado.

- Caridade. Está relacionado à ideia de não fazer mal.

- Justiça. Este princípio centra-se na justiça e na igualdade.

Embora o Relatório Belmont tenha sido originalmente desenvolvido em relação à investigação humana, foi recentemente aplicado por investigadores académicos e institutos políticos ao desenvolvimento da IA. O primeiro ponto diz respeito ao consentimento e à transparência em relação aos direitos individuais na interação com sistemas de IA. O segundo ponto diz respeito a garantir que os sistemas de IA não causam danos, como amplificar preconceitos. E o terceiro ponto diz respeito à forma como o acesso à IA é distribuído de forma equitativa.

Outras ideias comuns quando se trata de princípios éticos de IA incluem o seguinte:

- Transparência e responsabilidade.

- Desenvolvimento e uso centrados no ser humano.

- Segurança.

- Sustentabilidade e impacto.

Por que a ética da IA é importante?

IA é uma tecnologia projetada por humanos para replicar, aumentar ou substituir a inteligência humana. Essas ferramentas geralmente dependem de grandes volumes de vários tipos de dados para desenvolver insights. Projetos mal concebidos que dependem de dados defeituosos, inadequados ou tendenciosos podem ter consequências indesejadas e potencialmente prejudiciais. Além disso, o rápido avanço dos sistemas algorítmicos significa que, em alguns casos, não é claro como a IA chegou às suas conclusões, pelo que os humanos dependem essencialmente de sistemas que não conseguem explicar para tomar decisões que podem afetar a sociedade.

Um quadro ético de IA é importante porque destaca os riscos e benefícios das ferramentas de IA e estabelece diretrizes para a sua utilização responsável. Para criar um sistema de princípios morais e técnicas para a utilização responsável da IA, a indústria e as partes interessadas devem examinar questões sociais importantes e, em última análise, a questão do que nos torna humanos.

Quais são os desafios éticos da IA?

As empresas enfrentam os seguintes desafios éticos na utilização de tecnologias de IA:

- Explicabilidade. Quando os sistemas de IA falham, as equipes devem ser capazes de rastrear uma cadeia complexa de sistemas algorítmicos e processos de dados para descobrir o porquê. As organizações que utilizam IA devem ser capazes de explicar os dados de origem, os dados resultantes, o que os seus algoritmos fazem e por que o fazem. “A IA precisa ter um alto grau de rastreabilidade para garantir que, se ocorrerem danos, sua causa possa ser rastreada”, disse Adam Wisniewski, CTO e cofundador da AI Clearing.

- Responsabilidade. A sociedade ainda está a decidir quem é responsável quando as decisões tomadas pelos sistemas de IA têm consequências catastróficas, como perda de capital, saúde ou vidas. O processo de abordagem da responsabilização pelas consequências das decisões baseadas na IA deve envolver uma variedade de partes interessadas, incluindo advogados, reguladores, criadores de IA, órgãos de ética e cidadãos. Um desafio é encontrar o equilíbrio certo nos casos em que um sistema de IA pode ser mais seguro do que a actividade humana que está a duplicar, mas ainda causa problemas, como a ponderação dos méritos dos sistemas de condução autónoma que causam mortes, mas muito menos do que pessoas.

- Imparcialidade. Para conjuntos de dados que contêm informações de identificação pessoal, é extremamente importante garantir que não haja preconceitos em termos de raça, género ou etnia.

- Ética. Os algoritmos de IA podem ser usados para fins diferentes daqueles para os quais foram criados. Por exemplo, as pessoas poderiam usar a tecnologia para falsificar outras pessoas ou manipulá-las espalhando informações erradas. Wisniewski disse que estes cenários devem ser analisados na fase de concepção para minimizar os riscos e introduzir medidas de segurança para reduzir os efeitos adversos em tais casos.

- Privacidade. Como a IA requer enormes quantidades de dados para treinar adequadamente, algumas empresas estão usando dados públicos, como dados de fóruns da web ou postagens em mídias sociais, para treinamento. Outras empresas como Facebook, Google e Adobe também incluíram em suas políticas a possibilidade de utilização de dados de usuários para treinar seus modelos de IA, o que tem causado polêmicas em relação à proteção dos dados dos usuários.

- Deslocamento de empregos. Em vez de utilizar a IA para facilitar o trabalho humano, algumas organizações podem optar por utilizar ferramentas de IA para substituir completamente os empregos humanos. Esta prática gerou controvérsia, pois afeta diretamente aqueles que substitui e os sistemas de IA continuam propensos a alucinações e outras imperfeições.

- Ambiental. Os modelos de IA requerem muita energia para treinar e operar, deixando uma grande pegada de carbono. Se a electricidade que utilizam for gerada principalmente a partir de carvão ou de combustíveis fósseis, causam ainda mais poluição.

A divulgação pública e a rápida adoção de aplicações generativas de IA, como ChatGPT e Dall-E, que treinam com dados existentes para gerar novos conteúdos, amplificam questões éticas relacionadas com a IA, introduzindo riscos relacionados com desinformação, plágio, violação de direitos de autor e conteúdos prejudiciais.

Quais são os benefícios da IA ética?

A rápida aceleração na adoção da IA nas empresas coincidiu com —e, em muitos casos, ajudou a impulsionar— duas tendências importantes: o aumento da centralização no cliente e o aumento do ativismo social.

“As empresas são recompensadas não apenas por oferecerem produtos e serviços personalizados, mas também por defenderem os valores dos clientes e fazerem o bem à sociedade em que operam”, disse Sudhir Jha, CEO da Brighterion e vice-presidente executivo da Mastercard.

A IA desempenha um papel importante na forma como os consumidores interagem e percebem uma marca. O uso responsável é necessário para garantir um impacto positivo. Além dos consumidores, os funcionários querem se sentir bem com as empresas em que trabalham. “A IA responsável pode contribuir muito para reter talentos e garantir a execução tranquila das operações de uma empresa”, disse Jha.

O que é um código de ética para IA?

Uma abordagem proativa para garantir a IA ética requer abordar as três áreas principais a seguir, de acordo com Jason Shepherd, CEO da Atym:

- Políticas. Isto inclui o desenvolvimento da estrutura certa para impulsionar a padronização e estabelecer regulamentos. Documentos como os Princípios de IA de Asilomar podem ser úteis para iniciar a conversa. Agências governamentais nos Estados Unidos, na Europa e em outros lugares lançaram esforços para garantir a IA ética, e há uma série de padrões, ferramentas e técnicas de organismos de investigação, fornecedores e instituições académicas disponíveis para ajudar as organizações a conceberem políticas de IA. Consulte a seção “Recursos para o desenvolvimento de IA ética” abaixo. As políticas éticas de IA devem abordar a forma de abordar questões jurídicas quando algo corre mal. As empresas devem considerar a incorporação de políticas de IA nos seus próprios códigos de conduta. Mas a eficácia depende do cumprimento das regras pelos funcionários, o que pode nem sempre ser realista quando estão em jogo dinheiro ou prestígio.

- Educação. Executivos, cientistas de dados, funcionários da linha de frente e consumidores devem compreender as políticas, as principais considerações e os potenciais efeitos negativos da IA antiética e dos dados falsos. Uma grande preocupação é o compromisso entre a facilidade de utilização em torno da partilha de dados e a automatização da IA e as potenciais repercussões negativas da partilha excessiva ou da automatização adversa. “Em última análise, a vontade dos consumidores de assumir proativamente o controlo dos seus dados e prestar atenção às potenciais ameaças possibilitadas pela IA é uma equação complexa baseada numa combinação de gratificação instantânea, valor, perceção e risco”, disse Shepherd.

- Tecnologia. Os executivos também precisam de conceber sistemas de IA para detetar automaticamente dados falsos e comportamentos antiéticos. Isso requer não apenas olhar para a IA da própria empresa, mas também investigar fornecedores e parceiros quanto ao uso malicioso de IA. Os exemplos incluem a implantação de vídeos e textos deepfake para enfraquecer um concorrente ou o uso de IA para lançar ataques cibernéticos sofisticados. Isto se tornará um problema mais sério à medida que as ferramentas de IA se tornarem comoditizadas. Para combater este potencial efeito de bola de neve, as organizações devem investir em medidas defensivas enraizadas numa infraestrutura de IA aberta, transparente e confiável. Shepherd acredita que isso levará à adoção de confiança que fornece uma abordagem em nível de sistema para automatizar a garantia de privacidade, garantir a confiabilidade dos dados e detectar o uso antiético de IA.

Exemplos de códigos éticos de IA

Um código de ética de IA pode explicar os princípios e fornecer a motivação que impulsiona o comportamento apropriado. Por exemplo, o código de ética de IA da Mastercard está resumido abaixo:

- Um sistema ético de IA deve ser inclusivo, explicável, de natureza positiva e usar os dados de forma responsável.

- Um sistema de IA inclusivo é imparcial. Os modelos de IA exigem treinamento com conjuntos de dados grandes e diversos para ajudar a mitigar preconceitos. Também requer atenção e ajuste constantes para alterar quaisquer atributos problemáticos aprendidos no processo de formação.

- Um sistema de IA explicável deve ser gerível para garantir que as empresas possam implementá-lo de forma ética. Os sistemas devem ser transparentes e explicáveis.

- Um sistema de IA deve ter e manter um propósito positivo. Em muitos casos, isto poderia ser feito para ajudar os seres humanos no seu trabalho, por exemplo. Os sistemas de IA devem ser implementados de forma a não poderem ser utilizados para fins negativos.

- Os sistemas éticos de IA também devem respeitar os direitos de privacidade dos dados. Embora os sistemas de IA muitas vezes exijam enormes quantidades de dados para serem treinados, as empresas não devem sacrificar os direitos de privacidade de dados dos seus utilizadores ou de terceiros para o conseguir.

Empresas como Mastercard, Salesforce e Lenovo comprometeram-se a assinar um código de conduta voluntário de IA, o que significa que estão comprometidas com o desenvolvimento e gestão responsável de sistemas generativos de IA. O código baseia-se no desenvolvimento de um código de ética canadense sobre IA generativa, bem como nas contribuições coletadas de diversas partes interessadas.

O Google também tem seus próprios princípios orientadores de IA, que enfatizam a responsabilidade da IA, os benefícios potenciais, a justiça, a privacidade, a segurança e os valores sociais e outros valores humanos.

Recursos para desenvolver IA ética

Abaixo está uma amostra do número crescente de organizações, formuladores de políticas e padrões regulatórios focados no desenvolvimento de práticas éticas de IA:

- Instituto AI Now. O instituto se concentra nas implicações sociais da IA e na pesquisa de políticas para uma IA responsável. As áreas de pesquisa incluem responsabilidade algorítmica, questões antitruste, biometria, direitos de dados dos trabalhadores, modelos de IA em larga escala e privacidade. O relatório "AI Now 2023 Landscape: Confronting Tech Power" fornece uma análise aprofundada de muitas questões éticas que podem ser úteis no desenvolvimento de políticas éticas de IA.

- Centro Berkman Klein para Internet e Sociedade da Universidade de Harvard. O centro promove pesquisas sobre as grandes questões relacionadas à ética e governança da IA. A investigação apoiada pelo centro abordou temas como a qualidade da informação, algoritmos na justiça criminal, o desenvolvimento de quadros de governação da IA e responsabilidade algorítmica.

- Comité Técnico Misto CEN-CENELEC 21 sobre Inteligência Artificial. JTC 21 é uma iniciativa contínua da União Europeia (UE) para desenvolver vários padrões de IA responsáveis. O grupo desenvolve normas para o mercado europeu e fornece informações sobre legislação, políticas e valores da UE. Especifica também requisitos técnicos para caracterizar a transparência, robustez e precisão dos sistemas de IA.

- Manual do Instituto de Tecnologia, Ética e Cultura. O Manual ITEC é um esforço colaborativo entre o Centro Markkula de Ética Aplicada da Universidade de Santa Clara e o Vaticano para desenvolver um roteiro prático e incremental para a ética tecnológica. O Manual ITEC inclui um modelo de maturidade de cinco fases com passos específicos e mensuráveis que as empresas podem tomar em cada nível de maturidade. Também promove uma abordagem operacional para implementar a ética como uma prática contínua, semelhante ao DevSecOps para a ética. A ideia central é reunir equipes jurídicas, técnicas e de negócios durante os estágios iniciais da IA ética para erradicar bugs em um momento em que é muito mais barato corrigi-los do que após uma implementação responsável de IA.

- Orientação de TI e IA sobre gerenciamento de riscos ISO/IEC 23894:2023. A Organização Internacional de Normalização e a Comissão Eletrotécnica Internacional descrevem como uma organização pode gerir riscos especificamente relacionados com a IA. As orientações podem ajudar a normalizar a linguagem técnica que caracteriza os princípios subjacentes e a forma como estes se aplicam ao desenvolvimento, fornecimento ou oferta de sistemas de IA. Abrange também políticas, procedimentos e práticas para avaliar, tratar, monitorar, revisar e registrar riscos. É altamente técnico e voltado para engenheiros, e não para especialistas em negócios.

- Estrutura de gerenciamento de risco de IA do NIST. Esta orientação do Instituto Nacional de Padrões e Tecnologia para agências governamentais e o setor privado concentra-se na gestão de novos riscos de IA e na promoção de uma IA responsável. Abhishek Gupta, fundador e investigador principal do Montreal AI Ethics Institute, destacou a profundidade da estrutura do NIST, especialmente a sua especificidade na implementação de controles e políticas para melhor governar os sistemas de IA em diferentes contextos organizacionais.

- Nvidia NeMo Guardrails. Este kit de ferramentas fornece uma interface flexível para definir diretrizes comportamentais específicas que os bots devem seguir. Suporta a linguagem de modelagem Colang. Um cientista-chefe de dados disse que sua empresa usa o kit de ferramentas de código aberto para evitar que um chatbot de suporte no site de um advogado forneça respostas que possam ser interpretadas como aconselhamento jurídico.

- Instituto Stanford de Inteligência Artificial Centrada no Ser Humano. A missão do Instituto é fornecer pesquisas contínuas e orientação sobre as melhores práticas para IA centrada no ser humano. Uma das primeiras iniciativas em colaboração com a Stanford Medicine é “Responsible AI for Safe and Equitable Health”, que aborda questões éticas e de segurança relacionadas à IA na saúde e na medicina.

- "Rumo a metas unificadas para uma IA autorreflexiva." Este artigo, escrito por Matthias Samwald, Robert Praas e Konstantin Hebenstreit, adota uma abordagem socrática para identificar suposições, contradições e erros subjacentes através do diálogo e do questionamento sobre a veracidade, transparência, solidez e alinhamento de princípios éticos. Um objetivo é desenvolver metassistemas de IA nos quais dois ou mais modelos de componentes de IA complementam, criticam e melhoram o desempenho um do outro.

- “Recomendações do Presidio sobre IA Gerativa Responsável” do Fórum Econômico Mundial. Estas 30 recomendações orientadas para a ação ajudam a abordar as complexidades da IA e a aproveitar o seu potencial de forma ética. Este whitepaper também inclui seções sobre o desenvolvimento responsável e publicação de IA generativa, inovação aberta, colaboração internacional e progresso social.

Essas organizações oferecem uma variedade de recursos que servem como uma base sólida para o desenvolvimento de práticas éticas de IA. Usá-los como uma estrutura pode ajudar a orientar as organizações para garantir que desenvolvam e usem a IA de forma ética.

O futuro da IA ética

Alguns argumentam que um código de ética da IA pode rapidamente tornar-se desatualizado e que é necessária uma abordagem mais proativa para se adaptar a um campo em rápida evolução. Arijit Sengupta, fundador e CEO da Aible, uma plataforma de desenvolvimento de IA, disse: “O problema fundamental com um código de ética de IA é que ele é reativo, não proativo. eliminá-los, como se isso fosse possível.

Uma abordagem reativa pode ter dificuldade em lidar com os preconceitos incorporados nos dados. Por exemplo, se as mulheres não receberam empréstimos à taxa adequada ao longo do tempo, isso reflecte-se nos dados de múltiplas maneiras. “Se você remover as variáveis relacionadas ao gênero, a IA simplesmente detectará outras variáveis que servem como um indicador de gênero”, disse Sengupta.

Sengupta acredita que o futuro da IA ética deve falar sobre a definição de justiça e normas sociais. Por exemplo, num banco que concede empréstimos, as equipas de gestão e de IA teriam de decidir se pretendem ter como objetivo uma contrapartida igual, como empréstimos processados a uma taxa igual para todas as raças; resultados proporcionais, onde a taxa de sucesso para cada corrida é relativamente igual; ou impacto igual, o que garante que uma quantidade proporcional de empréstimos vá para cada corrida. O foco deveria estar num princípio orientador e não em algo a ser evitado, argumentou Sengupta.

A maioria das pessoas concorda que é mais fácil e eficaz ensinar às crianças quais devem ser os seus princípios orientadores, em vez de listar todas as decisões possíveis que podem enfrentar e dizer-lhes o que fazer e o que não fazer. “Essa é a abordagem que estamos adotando com a ética da IA”, disse Sengupta. "Estamos dizendo a uma criança tudo o que ela pode e não pode fazer, em vez de fornecer-lhe princípios orientadores e depois permitir que ela descubra por si mesma."

Por enquanto, os humanos desenvolvem regras e tecnologias que promovem uma IA responsável. Shepherd disse que isto inclui produtos e ofertas de programação que protegem os interesses humanos e não são tendenciosos contra certos grupos, como minorias, pessoas com necessidades especiais e os pobres. Esta última é especialmente preocupante, uma vez que a IA tem o potencial de estimular guerras sociais e económicas massivas, aprofundando o fosso entre aqueles que podem pagar pela tecnologia, incluindo o melhoramento humano, e aqueles que não podem.

A sociedade também precisa preparar-se urgentemente para o uso antiético da IA por atores mal-intencionados. Os sistemas de IA atuais variam de mecanismos de regras sofisticados a modelos de aprendizado de máquina que automatizam tarefas simples, até sistemas de IA generativos que imitam a inteligência humana. “Pode levar décadas até que comecem a surgir IAs mais sencientes que possam automatizar seu próprio comportamento antiético em uma escala que os humanos não conseguiriam acompanhar”, disse Shepherd. Mas, dada a rápida evolução da IA, agora é o momento de desenvolver barreiras de proteção para evitar este cenário.

No futuro, as ações judiciais poderão aumentar, como a movida pelo The New York Times contra a OpenAI e a Microsoft sobre o uso de artigos do Times como dados de treinamento de IA. A OpenAI também tem estado envolvida em mais controvérsias que podem influenciar o futuro, como a sua consideração de avançar para um modelo de negócio com fins lucrativos. Elon Musk também anunciou um modelo de IA que gerou polêmica tanto pelas imagens que pode criar quanto pelo impacto ambiental e social do local físico onde está colocado.

O futuro da IA poderá continuar a ver este alargamento dos limites éticos por parte das empresas de IA, bem como uma rejeição de preocupações éticas, sociais e económicas e um apelo a implementações mais éticas por parte dos governos e dos cidadãos.